Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

8172 éléments (3906 non lus) dans 50 canaux

Dans la presse

(3740 non lus)

Dans la presse

(3740 non lus)

-

Cybergeo

(3675 non lus)

Cybergeo

(3675 non lus) -

Mappemonde

(60 non lus)

Mappemonde

(60 non lus) -

Dans les algorithmes

(5 non lus)

Dans les algorithmes

(5 non lus)

Du côté des éditeurs

(28 non lus)

Du côté des éditeurs

(28 non lus)

-

Toute l’actualité des Geoservices de l'IGN

(17 non lus)

Toute l’actualité des Geoservices de l'IGN

(17 non lus) -

arcOpole - Actualités du Programme

arcOpole - Actualités du Programme

-

arcOrama

(11 non lus)

arcOrama

(11 non lus) -

Neogeo

Neogeo

Toile géomatique francophone

(110 non lus)

Toile géomatique francophone

(110 non lus)

-

Géoblogs (GeoRezo.net) (5 non lus)

-

UrbaLine (le blog d'Aline sur l'urba, la géomatique, et l'habitat)

UrbaLine (le blog d'Aline sur l'urba, la géomatique, et l'habitat)

-

Séries temporelles (CESBIO)

(2 non lus)

Séries temporelles (CESBIO)

(2 non lus) -

Datafoncier, données pour les territoires (Cerema)

Datafoncier, données pour les territoires (Cerema)

-

Cartes et figures du monde

Cartes et figures du monde

-

SIGEA: actualités des SIG pour l'enseignement agricole

SIGEA: actualités des SIG pour l'enseignement agricole

-

Data and GIS tips

Data and GIS tips

-

ReLucBlog

ReLucBlog

-

L'Atelier de Cartographie

L'Atelier de Cartographie

-

My Geomatic

-

archeomatic (le blog d'un archéologue à l’INRAP)

archeomatic (le blog d'un archéologue à l’INRAP)

-

Cartographies numériques

Cartographies numériques

-

Carnet (neo)cartographique

Carnet (neo)cartographique

-

GEOMATIQUE

GEOMATIQUE

-

Évènements – Afigéo

(12 non lus)

Évènements – Afigéo

(12 non lus) -

Afigéo

(12 non lus)

Afigéo

(12 non lus) -

Geotribu

(50 non lus)

Geotribu

(50 non lus) -

Conseil national de l'information géolocalisée

(9 non lus)

Conseil national de l'information géolocalisée

(9 non lus) -

Icem7

Icem7

-

Makina Corpus (1 non lus)

-

Oslandia

(1 non lus)

Oslandia

(1 non lus) -

CartONG

(2 non lus)

CartONG

(2 non lus) -

GEOMATICK

(6 non lus)

GEOMATICK

(6 non lus) -

Geomatys

(3 non lus)

Geomatys

(3 non lus) -

Les Cafés Géo

(1 non lus)

Les Cafés Géo

(1 non lus) -

L'Agenda du Libre

(3 non lus)

L'Agenda du Libre

(3 non lus) -

Conseil national de l'information géolocalisée - Actualités

(3 non lus)

Conseil national de l'information géolocalisée - Actualités

(3 non lus)

Géomatique anglophone

(16 non lus)

Géomatique anglophone

(16 non lus)

Séries temporelles (CESBIO) (2 non lus)

-

2:49

2:49 Dates de fauche en France

sur Séries temporelles (CESBIO)

En 2024, des collègues du Cesbio ont publié un article* sur la cartographie de la date de fauche en France en 2022 à partir des données satellitaires Sentinel-2. Leur magnifique figure 10 a attiré mon attention. La version à haute résolution fournie avec l’article (2861 × 2911 pixels) correspond à une image dont les pixels font […]

-

1:42

1:42 Évolution du jour de déneigement dans les Alpes françaises et les Pyrénées

sur Séries temporelles (CESBIO)

Les socio-écosystèmes des Alpes et des Pyrénées dépendent étroitement des fluctuations annuelles du manteau neigeux. En particulier, le moment de l’année où la neige disparait détermine le début de la saison de croissance de la végétation de montagne et donc la période des estives. Le changement climatique est en train de bouleverser ce rythme saisonnier. […]

-

15:57

15:57 BIOMASS, the third launched satellite mission designed at CESBIO !

sur Séries temporelles (CESBIO)

After SMOS in 2009, and VENµS in 2017, the CESBIO laboratory is very proud to see its third proposed mission, Biomass, reach orbit. As always, it has been a long journey from the idea, at the beginning of the century, to the selection in 2013 as the seventh Earth Explorer Mission by ESA, to the […]

-

0:47

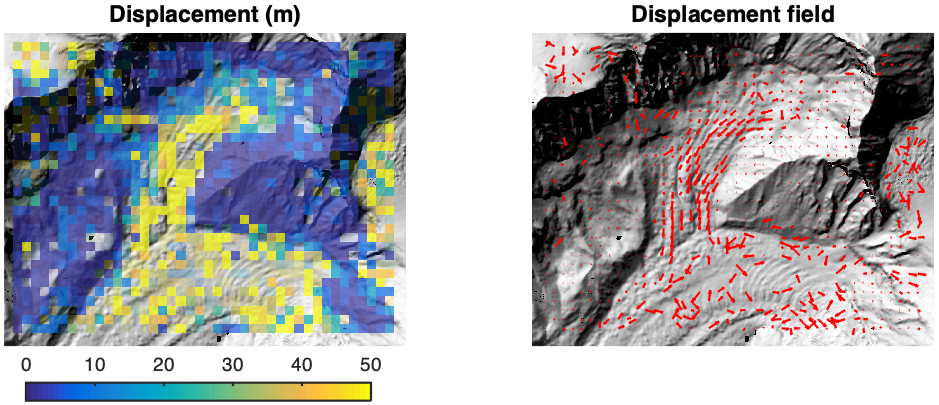

0:47 Sentinel-2 reveals the surface deformation after the 2025 Myanmar earthquake

sur Séries temporelles (CESBIO)Sentinel-2 reveals the surface deformation after the 2025 Myanmar earthquake -

10:38

10:38 Satellite Stereoscopy for Water Resource Monitoring?

sur Séries temporelles (CESBIO)

=> In arid or semi-arid regions, where irrigation is widespread, monitoring agricultural water resources is essential to anticipate shortages. These resources may come from large dams, small reservoirs, or groundwater aquifers. This is the case in the state of Telangana, in South India, where numerous large dams (shown in cyan blue in the figure below) […]

-

16:16

16:16 La stéréoscopie par satellite pour le suivi des ressources en eau ?

sur Séries temporelles (CESBIO)

=> Dans les régions arides ou semi-arides, où l’irrigation est généralisée, le suivi de la ressource en eau agricole est primordial pour anticiper les pénuries. Cette ressource peut-être l’eau de grands barrages, de petits réservoirs ou provenant de l’aquifère. C’est le cas de l’état du Télangana, en Inde du Sud, où de nombreux grands barrages […]

-

16:54

16:54 Evolution de l’altitude de la ligne de neige au cours des 40 dernières années dans le bassin versant du Vénéon (Oisans)

sur Séries temporelles (CESBIO)

Pour contribuer à caractériser les conditions hydrométéorologiques lors de la crue torrentielle qui a frappé la Bérarde en juin, j’ai analysé une nouvelle série de cartes d’enneigement qui couvre la période 1984-2024 [1]. Grâce à la profondeur temporelle de cette série, on constate que l’altitude de la ligne de neige dans le bassin versant du […]

-

10:54

10:54 Biophysical parameter retrieval from Sentinel-2 images using physics-driven deep learning for PROSAIL inversion

sur Séries temporelles (CESBIO)

The results presented here are based on published work: Y. Zérah, S. Valero, and J. Inglada. « Physics-constrained deep learning for biophysical parameter retrieval from sentinel-2 images: Inversion of the prosail model« , in Remote Sensing of Environment, doi: 10.1016/j.rse.2024.114309. This work is part of the PhD of Yoël Zérah, supervised by Jordi Inglada and Silvia Valero. […] -

13:50

13:50 Is Antarctica greening?

sur Séries temporelles (CESBIO)In a recent study, Roland and Bartlett et al. (2024) showed that the Antarctic Peninsula is « greening », i.e. the area covered by vegetation is growing. This article published in Nature Geoscience was featured in many media outlets. The authors drew this conclusion from the analysis of 35 years of Landsat images. More specifically, they computed a composite image of the maximum NDVI observed in March of every year since 1986. They used this annual time series to study the evolution of the area exceeding an NDVI threshold of 0.2. I was skeptical about the results because we showed recently that greening trends derived from annual maximum NDVI can be overestimated because the number of available Landsat observations increases over time (Bayle et al. 2024).

In temperate and sub-polar regions, the NDVI time series at a Landsat pixel is expected to look like this if there is a « greening ».

Such time series can be easily generated in Google Earth Engine from images acquired by Landsat 5, 7 and 8. A single line of code creates a global collection of Landsat images spanning the past 40 years!

var Landsat = ee.ImageCollection('LANDSAT/LC08/C02/T2_TOA').merge(ee.ImageCollection('LANDSAT/LE07/C02/T2_TOA')).merge(ee.ImageCollection('LANDSAT/LT05/C02/T2_TOA'))However, the effective revisit frequency of Landsat has substantially increased over this period, which means that more clear-sky observations are generally available in the end of the study period. As a result, it is more likely to observe an NDVI value that is close to the actual maximum in the end of the study period. This statistical artefact can lead to the false conclusion that a pixel is « greening ». It can also lead to overestimate the actual NDVI increase in greening areas. For example, Bayle et al. (2024) showed that up to 50% of the greening trend in high-elevation alpine grasslands computed by Rumpf et al. (2022) can be explained by this effect.

It is possible to check if the magnitude of the greening was also overestimated in this Antarctic Peninsula study, because the authors have shared their code. I could reproduce their calculations using the mean instead of the maximum to create the annual composite from March NDVI images. Unlike the maximum, the sample mean is an unbiased estimator of the actual mean of the data. Therefore, it should not lead to a systematic under- or overestimation of the mean NDVI depending on the number of samples.

The average number of observations and the areal extent of « green » areas over the Antarctic peninsula in March from Landsat (blue curve in the bottom panel reproduces Fig. 2 in Sustained greening of the Antarctic Peninsula observed from satellites)

The average number of observations and the areal extent of « green » areas over the Antarctic peninsula in March from Landsat (blue curve in the bottom panel reproduces Fig. 2 in Sustained greening of the Antarctic Peninsula observed from satellites)

I found that their results are robust and mostly insensitive to the changes in revisit. The main conclusion of the paper, « a clear but nonlinear trend towards a greater area of vegetation cover » remains unquestionable. The Mann-Kendall tests yield similar results with both approaches (mean vs. max.). The main differences are related to the area changes by period (cf. supplement Tab. 5.1 in R24). The change from 1986 to 2021 is 2.30 km² per decade using the mean NDVI whereas it is 3.13 km² per decade using the max NDVI (the value quoted the paper is 3.17 km² per decade*). The low impact of the revisit in this case is probably due to the fact that the authors restricted their analysis to a very short period of time (1 month), therefore on average there is only one available observation to create the annual NDVI composite even in the end of the study period. The magnitude of the area change might be somewhat overestimated but it is difficult to give a more accurate estimate given the available data.

Area change in km2/decade

method maxNDVI meanNDVI 1986-2021 3.13 2.30 1986-2004 2.77 2.32 2004-2016 2.94 3.61 2016-2021 4.91 -0.93 More details about my analysis and how to reproduce it in this repository: [https:]] .

* I could not find the exact same values as the authors in most of the cases, a possible explanation is given by the authors « Due to changes applied to imagery in the compilation of LANDSAT collection 2, this code cannot gaurantee exact reproduction of identical results to the paper, though the overall trends observed are highly comparable. »

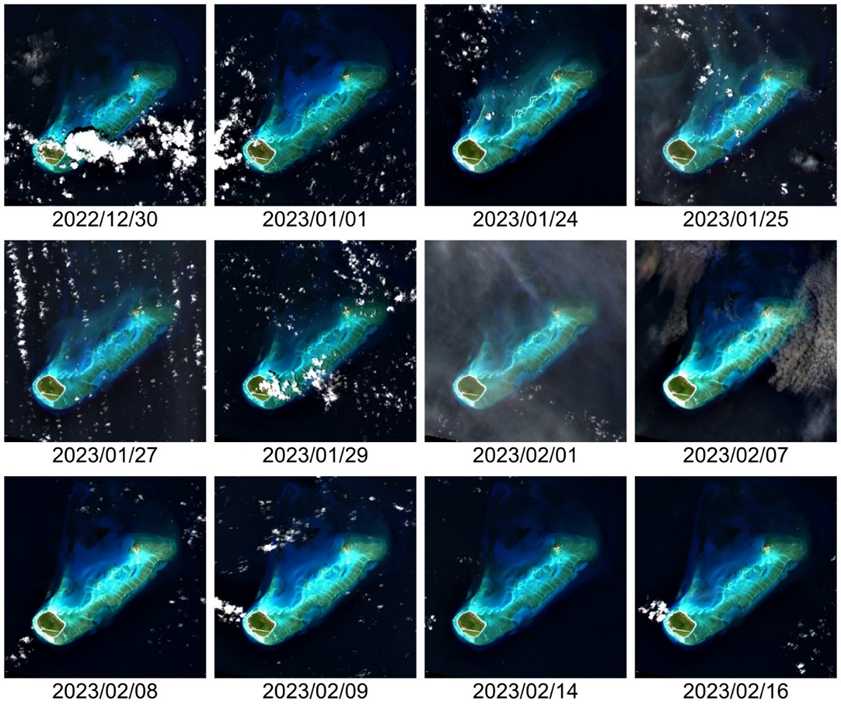

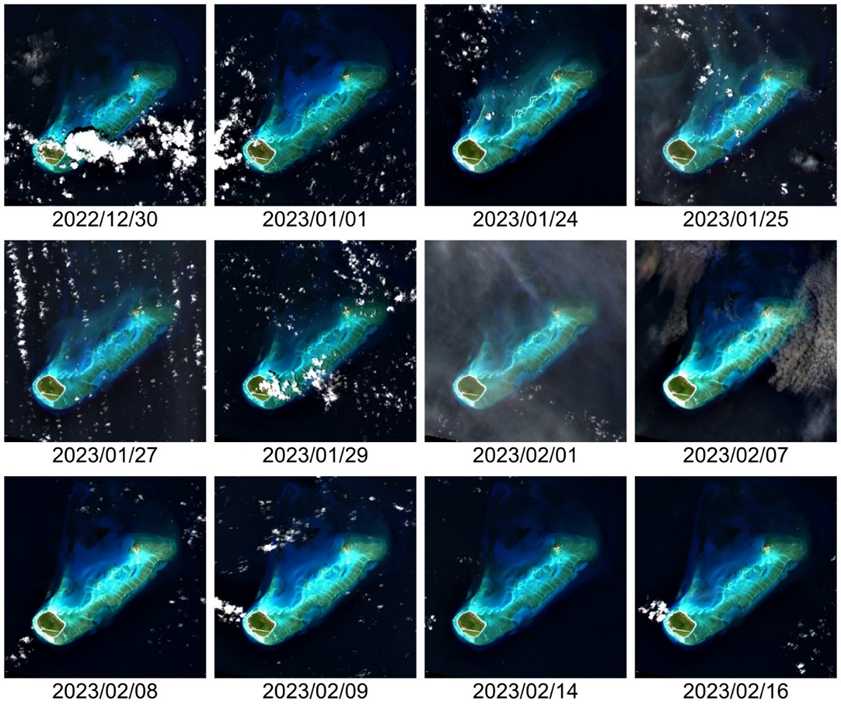

Deception Island, Antarctica in February 2018

Deception Island, Antarctica in February 2018

References

Roland, T. P., Bartlett, O. T., Charman, D. J., Anderson, K., Hodgson, D. A., Amesbury, M. J., Maclean, I., Fretwell, P. T., & Fleming, A. (2024). Sustained greening of the Antarctic Peninsula observed from satellites. Nature Geoscience, 1–6. [https:]] Rumpf, S. B., Gravey, M., Brönnimann, O., Luoto, M., Cianfrani, C., Mariethoz, G., & Guisan, A. (2022). From white to green: Snow cover loss and increased vegetation productivity in the European Alps. Science, 376(6597), 1119–1122. [https:]] Bayle, A., Gascoin, S., Berner, L. T., & Choler, P. (2024). Landsat-based greening trends in alpine ecosystems are inflated by multidecadal increases in summer observations. In Ecography. [https:]] -

13:50

13:50 Is Antarctica greening?

sur Séries temporelles (CESBIO)

In a recent study, Roland and Bartlett et al. (2024) showed that the Antarctic Peninsula is « greening », i.e. the area covered by vegetation is growing. This article published in Nature Geoscience was featured in many media outlets. The authors drew this conclusion from the analysis of 35 years of Landsat images. More specifically, they computed […]

-

14:25

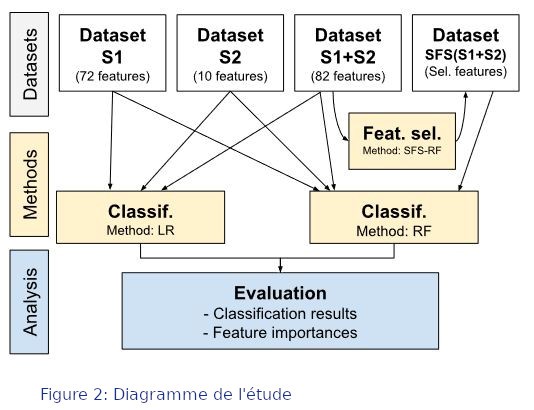

14:25 Nouvel article : peu d’apport des images Sentinel-1 pour le suivi du dépérissement des chênes et châtaigniers

sur Séries temporelles (CESBIO)

Dans le cadre du projet SuFoSat mené au CESBIO, une collaboration entre trois laboratoires (CESBIO, Dynafor et P2PE) a permis d’évaluer l’apport des images Sentinel-1 pour la détection précoce du dépérissement sur deux essences de feuillus : les chênes et les châtaigniers sur une vaste zone (12 tuiles Sentinel-2, voir Figure 1). Des classifications ont été […]

-

20:32

20:32 Petition results (to keep S2A operational after S2C’s launch)

sur Séries temporelles (CESBIO)Last week, I issued a petition to keep S2A operational, this post will give you some results. i will keep updating this post regularly, so please go-on signing the petition or forwarding it to your colleagues. Although I have not been trained as a lobbyist, and I have some regrets on how i did it, the petition and our communication has had a very large success. I guess the wood was very dry, and the fire spread very fast when I lighted the match.

The campaign started with a blog post which explained why it is important to keep S2A operational, after S2C starts its operational duty. The blog post was relayed on LinkedIn and a petition. site was created. The tool I used, based on the « pytition » open source software, which works perfectly, is very simple and straightforward to set-up, but does not allow to collect the affiliations of the persons who sign (which is a pity). I thought I would collect the affiliations from the email address, but hundreds of signatories have signed with a gmail address or with various email service providers.

Anyway, here are several statistics I gathered on these posts and on the petition on September 9th :

Publication Statistics Blog 1080 visits LinkedIn 71 000 impressions, 940 likes, 180 republications Petition 1570 confirmed, 1924 total (confirmed+unconfirmed) I would like to thank everyone who signed, liked, forwarded, republished, retweeted, retooted (on Mastodon) ! I would have never dreamed to get 1500 signatures in one week only, I increased the goal progressively from 500 to 1500 ! I think our colleagues at ESA and EU should be proud of this achievement, which shows the importance and success to this great Copernicus mission not only in Europe, but also on all continents, in academy, research, companies, agencies, regions, governments, and even NGO.

Regarding the petition, there are several caveats to be mentioned before analyzing the results :

- Signing the petition is an individual decision, it does not mean that the organism/company for which the signatory works agrees with the signature, but it should be the general case. I will preserve the identity of the signatories, and only send the petition file to ESA and the EU, and quote the affiliations.

- Even if they signed with gmail, I recognized a few of the petitioner names, and I know the company for which they work. Of course, I will not reveal their names here, but I hope you will trust me on this conversion.

- To sign a petition requires a two step process. First fill the form with a email address, and then confirm the email address after receiving an email. It turns out 1250 persons confirmed their email address, and 250 did not. My statistics are based on the total number. I swear I did not add anyone myself. The files sent to ESA and EU will mention if the email was confirmed or not.

- My network is mainly among space agencies, and then in academy. This is largely visible in the table below. However, many persons form private companies signed, including a few CEO.

- The duty of confidentiality applied among space agencies reduced the number of petitioners, but I have had feedback on the interest from many colleagues at CNES, ESA, EU. In fact, everyone I talked to would like to maintain S2A, but I know no one in charge of the funding decisions…

- It is interesting to note the presence of companies which produce earth observing satellites, but are very keen on using Sentinel-2 data as reference, thanks to the excellent quality of its data.

- The numbers between parentheses are the numbers of petitioners per affiliation, when there is more than one.

Domain Affiliations Research/ Academy AT: BOKU Vienna (3), Salzburg (4)

AU: New south Wales

BR: Sao Polo, IPAM (Amazonia), Rio de Janeiro, Ceara, Viçosa, Mato grosso,

BE: CRA -Wallonie (3), UC Louvain (7), Leuven, Bruxelles, Namur

CA: Ottawa, Carleton, Alberta, Laval, Rimouski (Quebec), Sherbrooke, Victoria

CL: Univ Chile (2)

CH: Agroscope, Zurich, Bern, Geneva, Lausanne, Zurich : Ethz (2), Uzh(2), SwissTopo (3)

CN: Chinese Academy of Science (3), Wuhan(3), Nanjing (6), Univ of Geosciences

CZ: Prague (Charles University)

DE: Fraunhofer institute Bonn, Thunen institute, Jena(2), Trier, Hamburg, Kiel (4), potsdam, Humbold Berlin (5), Osnabrueck(2), Tuebingen

DK : LBST(2)

EE: Tartu(2)

ES: CSIC (8), Cantabria (6), Granada (4), Malaga, Valencia, Salamanca

FI: Aalto (4)

FR ; INRAE (16), IRD(14), CNRS (3), CIRAD, CEREMA, CEA, IGN (3), ONERA(3), OFB, Bordeaux, Toulouse (13) UT3, Toulouse INP (3), Ecole Normale Supérieure (2), ENSAE, Lyon, Paris Saclay (5), Paris, Strasbourg (6), IMEV Villefranche (8), Supagro (2), Montpellier, Nantes, Littoral, Orleans, Marne-la-vallée, Grenoble, Réunion(3),

GR: Athens (4), Macedonia

KE; NDMA : (Drought Mapping Agency)

KR: Busan

IE: Cork

IL: Technion (4), Volcani Agri(3) Haifa(12) et jérusalem (9),

IN; IITD (2)

IT; CNR (10), Pavia, Torinio, Bologna, Napoli, Milano, Politecnico Milano, Calabria, Messina, Viterbe Tuscia (3), Venezzia,

JP: Hokudai

LE: Beyrouth,

MA: Marrakech, El jadida

NL: Wageningen (6)

PT: Lisboa (6), Evora

SG: Singapour (4)

SI: Ljubiana

SE: Lund

TU: Tunis,

TR: Istanbul (3), Bursa

UK: NPL (8) Plymouth, London, Leicester, Liverpool, Surrey, Stirling, Bath, Cambridge (8), leeds

US; MIT(3), Wisconsin(4), Michigan, Colorado, Cornell, Oregon, Oklahoma, Connecticut (2), South Florida (5)

Maryland (6), Texas, Columbia,Providence(2), Harvard, Stanford (2) Boston (13), Kansas, Delaware, California, New York (2), Washington (3)Agencies CNES (11), DLR (14), NASA(4), ESA (4), INPE (14), USGS(3), NOAA(2), VITO(15), EU (6), SATCEN (3), Eumetsat,, FAO(3), UN Companies - Satellite : Planet, Airbus (9); TAS, ConstellR, Aerospacelab (4), Earthdaily, Satellite-Vu, Spacetech-i (STI)

- Software, engineering : CS, GMV, Google, CLS, ACRI-ARGANS-ARCTUS (6), Magellium (5), CGI, SISTEMA, Brockmann (4), CAP GEMINI, TRACASA(6), cloudferro(2)

- Remote sensing Services : EOX, Kayrros (10), Hiperplan (4), Bluecham, Terranis, MEEO (3), Gamma.earth, Orbital-eos (3), Planetek, Orbital-Eye , Kermap (6), Netcarbon(4), MEOSS, I-SEA (4), Kanop (5), latitudo40 (4), mantle-labs (6), Mapsat (3) , WaterInsight (NL), remote-sensing-solutions (3), Satelligence(8), mundialis(2), DHI group(3)

- Agriculture : Arvalis, Cargill, E-leaf

- Insurance : AXA

Government/Local communities Hauts de France Région, Basque region, Canadian government, Andalucia, Umwelt Bundesamt NGO WWF (3) -

20:32

20:32 Petition results (to keep S2A operational after S2C launch)

sur Séries temporelles (CESBIO)

Last week, I issued a petition to keep S2A operational, this post will give you some results. i will keep updating this post regularly, so please go-on signing the petition or forwarding it to your colleagues. Although I have not been trained as a lobbyist, and I have some regrets on how i did it, […]

-

17:01

17:01 Let’s ask Copernicus to keep S2A operational after S2C launch

sur Séries temporelles (CESBIO) The launch of Sentinel-2C (S2C) is scheduled on the 4th of September 2024, next week ! After 3 months of commissioning phase, S2C will replace S2A, to fulfill the Sentinel-2 mission together with S2B. S2B will later be replaced by S2D. The current plans are to keep S2A as a redundant satellite, in case something happens to one of the two other satellites. It seems likely that S2A will stop acquiring images once S2C is operational.

The launch of Sentinel-2C (S2C) is scheduled on the 4th of September 2024, next week ! After 3 months of commissioning phase, S2C will replace S2A, to fulfill the Sentinel-2 mission together with S2B. S2B will later be replaced by S2D. The current plans are to keep S2A as a redundant satellite, in case something happens to one of the two other satellites. It seems likely that S2A will stop acquiring images once S2C is operational.I guess the decision not to keep S2A operational would be for cost reasons. The operation costs are high : although I have no information, I guess these costs are on the order of magnitude of one or two dozens of millions per year. My reference is the SPOT4 (Take5) experiment which cost ~1 M€ for a few months with a limited amount of data. In the case of S2, the data volumes to download, process and distribute are huge, and ESA would also need to monitor data quality, have a tighter orbit and attitude control… Anyway, the cost of operating a satellite is much lower than the cost of the satellite itself (Sentinel-2B’s price was a few hundreds of M€).

I am very proud Europe was able to build the Sentinel-2 mission with a revisit of 5 days and funding of 20 years of operations, including two replacement satellites. But we could do even better for a limited cost. I write this letter to try to convince scientific, public and private users that 5 days revisit is not enough. We should therefore try to set-up a campaign to ask ESA/UE to reconsider the decision to end S2A imaging operations when S2C is operational. Help, feedback and ideas are welcome !

A petition is available here.

Revisit needs Correlation of start of season determination as a function of the cloud free observation frequency in Germany. « 2018 was a hot and dry year with exceptionally low precipitation and cloud cover ». From Kowalski et al, 2020 : [https:]]

Correlation of start of season determination as a function of the cloud free observation frequency in Germany. « 2018 was a hot and dry year with exceptionally low precipitation and cloud cover ». From Kowalski et al, 2020 : [https:]]

As an example, here are the cloud free revisit needs expressed by the vegetation monitoring community.

- Land cover classification : a clear observation per month

- Biomass/Yield estimation : a clear observation per fortnight

- Phenology (start and end of season, flowering…) : a clear observation per week

Waters, especially coastal waters, tend to change even quicker, with the additional drawback to be affected by the reflection of the sun on water, on one third to one half of the acquisitions.

Very recently, several papers have studied the biases due to the insufficient and irregular observations from space optical missions. Bayle et al, 2024 show that part of the observed greening of mountains observed on the Landsat time series acquires during decades is in fact due to the increase of the revisit frequency, which is still not always sufficient to capture the short-lived peak of greenness in alpine ecosystems. Langhorst et al, 2024 show that the loss of observations due to clouds leads to miss important hydrological events that bias statistics.

5 days revisit is not enoughThe global average cloud cover is 70%, with of course large variations across seasons and location. It means that on average, for a given pixel, two observations out of three are cloudy. But if you need to observe a large area simultaneously cloud free, it is even more difficult. I don’t have statistics on that, but roughly only 10% of Sentinel-2 products on 100×100 km² are fully cloud free.

Due to the fact that the great majority of images have clouds, our users have asked for cloud free periodic syntheses. At the THEIA land data center, we produce every month surface reflectances syntheses (named « Level3A » products). Our WASP processor computes a weighted average of all the cloud free surface reflectances found during 46 days (from 23 days before to 23 days after the synthesis date). When no cloud free data is available, we raise a flag, and provide one of the cloudy reflectance values acquired during the period. These regions appear in white (but don’t confuse them with snow in mountains).

Since these syntheses use 46 days, and not 30 days, they do not meet any of the needs explained above. The 46 days duration was tuned to have less than 10% of pixels always cloudy on average per synthesis. Here are some examples.

South-Western EUOver western Europe, the top left image shows a summer drought period, with a reduced amount of always cloudy pixels. However, some are visible in the East of Belgium/Netherlands. The images in winter have large region with no cloud free data, and even in April 2023, there is a remaining cloudy region in the east of France. You might have noticed that the remaining regions often have a trapezoidal shape. It is explained by the fact that Sentinel-2 swaths overlap, and it is of course more likely to miss cloud free pixels where we have two observations every 5 daysinstead of one. More examples are available at THEIA : [maps.theia-land.fr]

Germany: July 2022 (Drought in Europe) December 2022

January 2022 (a dry January ) April 2023

South-Western Europe is blessed by a nice weather (when it’s not too hot), but Germany has a lot of clouds. Our colleagues form DLR also process Level3A syntheses with our tools. Here are some examples. You may also see by yourselves at this address : [https:]

NorwayApril 2023 November 2023

Norway cartographic agency (Kartverket) also uses our softwares MAJA and WASP to produce countrywide syntheses, but they had to change the parameters to obtain a correct result. Summer syntheses are produced each year, but they often need a manual post-processing to enhance the results where some clouds are remaining. This is despite the orbits fully overlap in Norway.

Consequences

[https:]The main consequence of persistent cloudiness on S2 images is that our observations are quite far from the expressed needs, except in the sunniest countries. As a result, studies and retrievals are not as accurate as they could be, biases and noise appear. In my sense, the main issue is the fact that persistent clouds on images introduce a random unreliability, that prevents to provide an operational service.

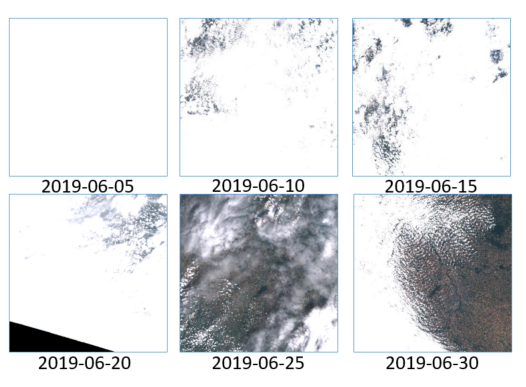

S2 quicklook thumbnails in June 2019 on Toulouse tile (31TCJ)

S2 quicklook thumbnails in June 2019 on Toulouse tile (31TCJ)

One of the most acute cases in my memory happened in June 2019. The region near Toulouse suffered a long and early heat wave, but clouds were present every 5 days in the morning, when S2A or S2B were acquiring data. During a heat wave,it is very hard to explain local customers that the product didn’t work because of clouds.

As a result, insufficient revisit hampers the development of services based on optical images.

There are some ways around, using Landsat 8 and 9 (but resolution is 30m), Sentinel-1 (but SAR provides a completely different information), Planet (but only 4 bands, very expensive if you need to work at country scale, and not the same quality). Moreover, Planet uses Sentinel-2 a lot to improve its products. A better availability of S2 data would also improve the data quality of Planet data and the soon to be launched Earth Daily constellation.

Dear EU, please keep S2A operational !That’s why it would be a pity not to go on using S2A after S2C commissioning phase. With three satellites, S2A passing for instance two days after S2B, we could produce cloud free syntheses every 20 days, based on 30 days of data only. We would be closer to the needs, and would reduce a lot the unreliability of S2 services.

Of course, it means an increase of data volume and processing costs, but it is only a few % every year of the cost of one satellite. If it is really too much, let’s do it over Europe only, as S2 is funded by Europe. Maybe EU fears that if we ask for it, users of the other Sentinel missions will also ask for it. But S1 does not have clouds (and S1B has been lost) and S3 has a daily overpass already. Therefore, there are good reasons to operate a third satellite in the case of S2 only.

If you agree or disagree with me, or if you have more arguments to provide, please add a comment to this page !

PetitionI am not sure it is the best way to have influence on Copernicus, but I have set up a petition on an ethical web service provider, feel free to sign here : [https:]]

References :- Bayle, A., Gascoin, S., Berner, L.T. and Choler, P. (2024), Landsat-based greening trends in alpine ecosystems are inflated by multidecadal increases in summer observations. Ecography e07394. [https:]]

- Langhorst, T., Andreadis, K. M., & Allen, G. H. (2024). Global cloud biases in optical satellite remote sensing of rivers. Geophysical Research Letters, 51, e2024GL110085. [https:]]

-

17:01

17:01 Copernicus should keep S2A operational after S2C launch

sur Séries temporelles (CESBIO)

The launch of Sentinel-2C (S2C) is scheduled on the 4th of September 2024, next week ! After 3 months of commissioning phase, S2C will replace S2A, to fulfill the Sentinel-2 mission together with S2B. S2B will later be replaced by S2D. The current plans are to keep S2A as a redundant satellite, in case something […]

-

20:55

20:55 Premiers MNT LidarHD

sur Séries temporelles (CESBIO)Pièce jointe: [télécharger]

L’IGN communique actuellement sur la mise à disposition des premiers MNT dérivés des nuages de points LiDAR HD.

[Thread LiDAR HD

] Vous les attendiez

] Vous les attendiez  Les premiers modèles numériques #LiDARHD sont maintenant disponibles et accessibles à tous en #opendata

Les premiers modèles numériques #LiDARHD sont maintenant disponibles et accessibles à tous en #opendata

La Charente-Maritime (bloc FK), le Nord (KA) et le Pas-de-Calais (JA) sont les premiers… pic.twitter.com/1UFOZabImE

La Charente-Maritime (bloc FK), le Nord (KA) et le Pas-de-Calais (JA) sont les premiers… pic.twitter.com/1UFOZabImE— IGN France (@IGNFrance) July 10, 2024

A mon avis, cet exemple est mal choisi puisqu’un MNT de la citadelle de Gravelines de qualité équivalente était déjà disponible dans le RGE ALTI® 1m en libre accès depuis le 1er janvier 2021. Sur ce secteur les métadonnées du RGE ALTI® indiquent que la source est un LiDAR de densité d’acquisition à 1 points au m². On pouvait donc déjà voir ces fortifications dans mon interface de visualisation du RGEALTI.

Comparaison des MNT RGE ALTI® 1m et LiDAR HD sur le fort de Gravelines

Comparaison des MNT RGE ALTI® 1m et LiDAR HD sur le fort de Gravelines

En effet, le RGE ALTI® est un composite de plusieurs sources de données… La qualité du produit final est très variable ! En l’occurrence Gravelines était déjà couvert en lidar comme le reste du littoral.

Sources du RGE ALTI® (oui sans la légende) : corrélation (en général), lidar (littoral, rivières et villes) ou radar (montagnes). Pour en savoir plus consulter l’annexe B de ce document [https:]]

Sources du RGE ALTI® (oui sans la légende) : corrélation (en général), lidar (littoral, rivières et villes) ou radar (montagnes). Pour en savoir plus consulter l’annexe B de ce document [https:]]

Pour le littoral, le nouveau MNT LiDAR HD présente un intérêt plus marquant là où la surface terrestre a changé récemment. On peut ainsi comparer les MNT RGE ALTI® et LiDAR HD pour observer l’évolution des dunes de la Slack près de Wimereux. Malheureusement je ne connais pas les dates d’acquisition de ces deux produits.

document.createElement('video'); [https:]]Mais le véritable intérêt du MNT LiDAR HD se situe plutôt dans les zones où la source des données pour construire le RGE ALTI® n’était pas du lidar. Par exemple dans le département du Pas-de-Calais se trouve la plus grande carrière de France, les Carrières du Boulonnais.

Comparaison des MNT RGE ALTI® 1m et LiDAR HD sur les Carrières du Boulonnais

Comparaison des MNT RGE ALTI® 1m et LiDAR HD sur les Carrières du Boulonnais

Vivement la mise à disposition des autres régions de France !

Photo en-tête : Zoom sur la partie centrale de la carrière de Ferques (Pas de Calais) par Pierre Thomas. Source : Planet Terre [https:]]

-

20:55

20:55 Premiers MNT LiDAR HD

sur Séries temporelles (CESBIO)Pièce jointe: [télécharger]

L’IGN communique actuellement sur la mise à disposition des premiers MNT dérivés des nuages de points LiDAR HD. A mon avis, cet exemple est mal choisi puisqu’un MNT de la citadelle de Gravelines de qualité équivalente était déjà disponible dans le RGE ALTI® 1m en libre accès depuis le 1er janvier 2021. Sur ce secteur […]

-

4:27

4:27 Crue du Vénéon : que nous apprennent les images satellites ?

sur Séries temporelles (CESBIO)Pièce jointe: [télécharger]

Le 21 juin 2024, la crue torrentielle du Vénéon et de son affluent le torrent des Étançons a dévasté le hameau de la Bérarde dans le massif des Écrins. Cette crue a résulté des fortes pluies et de la fonte de la neige, et a peut-être été aggravée par la vidange d’un petit lac supra-glaciaire.

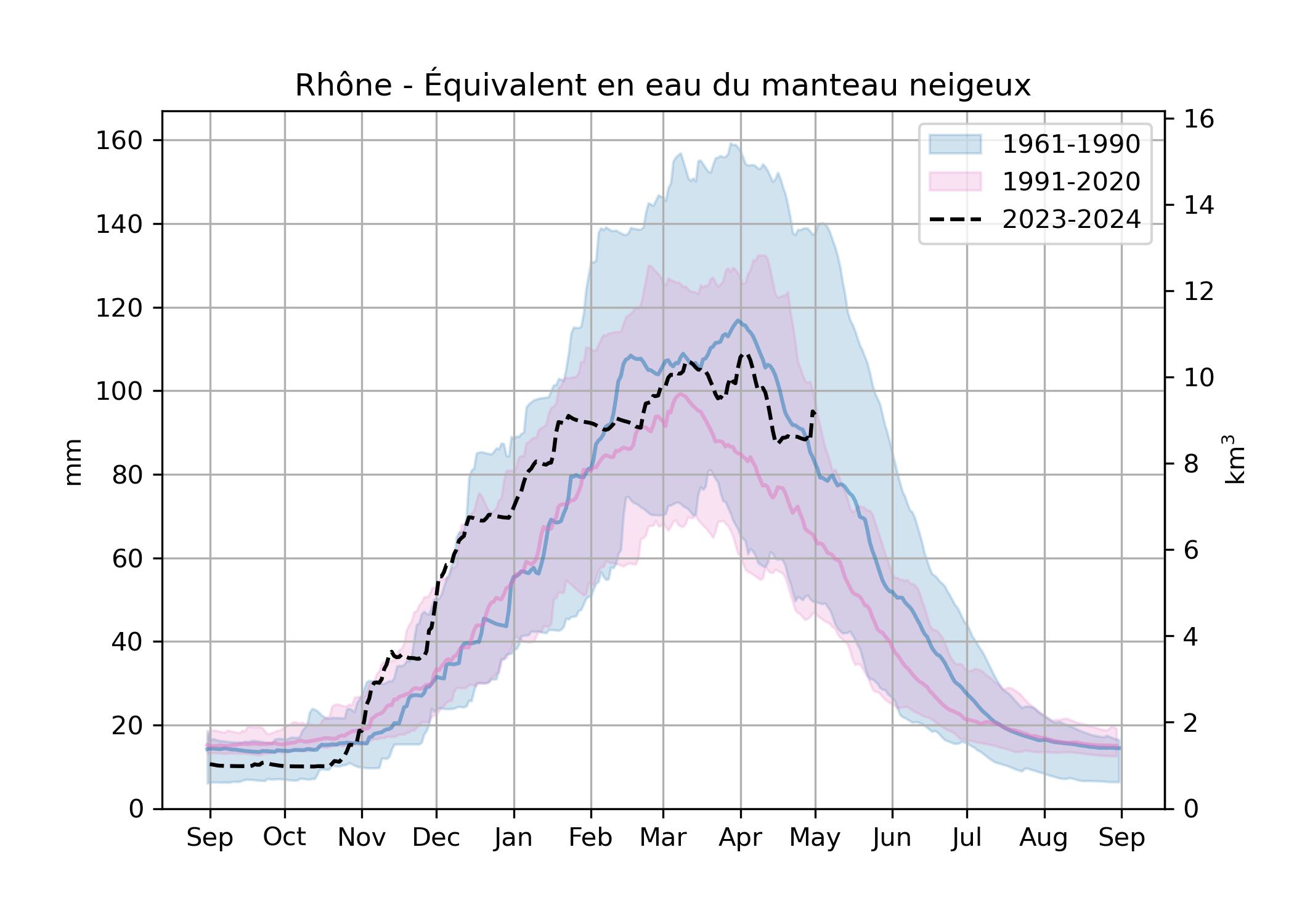

L’année en cours est particulièrement excédentaire en neige dans les Alpes, en particulier à haute altitude. Le stock de neige dans le bassin du Rhône au printemps 2024 est bien supérieur à la normale des trente dernière années mais proche de celle des années 1961-1990. Or une telle crue ne s’est pas produite depuis la moitié du 20e siècle au moins à la Bérarde. Que s’est-il passé ?

Le secteur est bien instrumenté avec une station hydrométrique sur le Vénéon à 3 km en aval de la Bérarde (1581 m) et une station météorologique située à 6 km de route près du bourg de Saint-Christophe-en-Oisans (1564 m).

Séries horaires de précipitations et de débit entre le 19 juin 00h et le 21 juin 18h TU.

Séries horaires de précipitations et de débit entre le 19 juin 00h et le 21 juin 18h TU.

Le cumul de précipitation mesuré entre le 19 et le 21 juin est considérable, précisément 100 mm en 34 heures. J’ai calculé le bassin versant du Vénéon à cette station hydrométrique Saint-Christophe-en-Oisans à partir du modèle numérique de terrain RGE ALTI® 5m fourni par l’IGN. Sa superficie est de 104 km², le volume d’eau reçu pendant ces 34 heures est donc 10 millions de mètres cube, soit 84 m³/s. On constate que le débit de crue s’approchait de 80 m³/s avant que l’enregistrement ne cesse. Il est probable que ces 100 mm de pluie intense expliquent l’essentiel de la crue. Malheureusement la série de débit est interrompue et à ce jour il est impossible de fermer le bilan hydrologique. Peut-on en savoir plus sur la contribution du manteau neigeux à partir des images satellitaires ?

Bassin versant du Vénéon à la station hydrométrique de St-Christophe-en-Oisans (marqueur rouge) et la station météorologique associée (marqueur bleu).

Bassin versant du Vénéon à la station hydrométrique de St-Christophe-en-Oisans (marqueur rouge) et la station météorologique associée (marqueur bleu).

Ce bassin draine des zones de haute montagne dont l’antécime de la Barre des Ecrins qui culmine à plus de 4000 m d’altitude. Les fluctuations diurnes de débit indiquent que la fonte des neiges avait commencé à alimenter le Vénéon depuis le début du mois de juin (la taux de fonte est en grande partie contrôlé par l’énergie solaire donc il suit le rythme des journées).

Série journalière des précipitations et série horaire du débit du Vénéon à St-Christophe-en-Oisans. La série de débit est interrompue à partir du 21 juin sans doute à cause des dégâts causés par la crue.

Série journalière des précipitations et série horaire du débit du Vénéon à St-Christophe-en-Oisans. La série de débit est interrompue à partir du 21 juin sans doute à cause des dégâts causés par la crue.

Les images Sentinel-2 avant et après la crue montrent que le manteau neigeux a bien réduit entre les deux dates car sa limite basse remonte en altitude. Un autre détail intéressant est le changement de couleur : les zones enneigées blanches de haute altitude ont disparu, ce qui suggère que la fonte a eu lieu jusqu’aux plus hauts sommets du bassin versant. En effet, les poussières sahariennes ont été déposées à la fin du mois de mars 2024.

[https:]]On peut analyser l’évolution de l’enneigement à partir des cartes de neige Theia ou Copernicus. Voici par exemple celle du 2 juillet 2024.

Une façon de résumer l’enneigement et de s’affranchir des nuages est de calculer la « ligne de neige », c’est-à-dire l’altitude qui délimite en moyenne la partie basse de l’enneigement. Pour la calculer j’utilise l’algorithme de Kraj?í et al. (2014) qui minimise la somme de la surface enneigée sous la ligne de neige et de la surface non-enneigée au dessus de la ligne de neige. Dans cet exemple on obtient 2740 m.

Les cartes de neige sont disponibles depuis 2015 (Landsat 8, Sentinel-2). La série complète sur le bassin versant du Vénéon à St Christophe permet de voir la remontée de la ligne de neige entre avril (01/04 = jour 91) et août (01/08 = jour 213).

L’année 2024 se distingue par une limite d’enneigement plus basse que les huit années précédentes.

Si on superpose cette ligne de neige avec l’isotherme 0°C donnée par ERA5 on constate que l’intégralité du bassin versant était sous l’iso 0°C quelques jours avant la crue, ce qui suggère (1) qu’il a plu à très haute altitude (2) qu’il y a eu un apport de fonte, d’autant que le manteau neigeux avait déjà été bien réchauffé au début du mois de juin.

Des images satellites à très haute résolution (Pléiades Neo) ont été acquises dans le cadre de la CIEST2. Ces images permettent de voir les traces des pluies abondantes sur la neige lessivée et des avalanches de neige humide autour du glacier de Bonne Pierre.

Image satellite du manteau neigeux sur le glacier de Bonne Pierre (Pléiades Neo 04 juillet 2024, composition colorée)

Image satellite du manteau neigeux sur le glacier de Bonne Pierre (Pléiades Neo 04 juillet 2024, composition colorée)

Image satellite du manteau neigeux sur le glacier de Bonne Pierre (Pléiades Neo 04 juillet 2024, panchromatique)

Image satellite du manteau neigeux sur le glacier de Bonne Pierre (Pléiades Neo 04 juillet 2024, panchromatique)

En conclusion, les données disponibles montrent cette crue est une crue de pluie sur neige (Rain-On-Snow). On trouve tous les ingrédients favorables à ce type de crue :

- une pluie intense ;

- un manteau neigeux particulièrement étendu avec une ligne de neige basse pour la saison ;

- un manteau neigeux déjà en régime de fonte ou proche (isothermal, ripe snowpack) ;

- un apport de chaleur pendant l’évènement, ici une atmosphère chaude et humide qui a dû émettre de forte quantités de rayonnement thermique.

Les taux de fonte peuvent dépasser 20 mm/jour dans les zones de montagne. Cet apport de fonte doit être pondéré par la fraction enneigée du bassin. Le 17 juin 60% de la surface du bassin était enneigée donc on peut estimer une contribution potentiellement de l’ordre de 15 mm/jour pendant la crue à comparer aux 100 mm de pluie mesurés à St-Christophe pendant l’épisode. Donc le manteau neigeux a pu augmenter significativement l’apport d’eau liquide dans ce bassin versant. Néanmoins, d’autres facteurs aggravants sont à considérer :

- une augmentation du taux de précipitation par effet orographique : les précipitations mesurés à St-Christophe à 1564 m sont probablement sous-estimées à l’échelle du bassin versant de la Bérarde qui s’étend jusqu’à 4086 m (Pic Lory) ;

- la saturation des sols et des nappes d’eau souterraines (y compris le thermokarst glaciaire) suite à un printemps bien arrosé et une fonte des neiges en cours depuis plusieurs semaines.

Ces évènements Rain-On-Snow sont bien étudiés aux USA où ils sont connus pour déclencher des crues dévastatrices (comme le débordement du lac Oroville en Californie). Plusieurs études montrent que le changement climatique augmente le risque de crue Rain-On-Snow en haute montagne [1, 2].

Les images Pléiades Neo étant des prises stéréo, elles devraient également permettre aux géomorphologues de calculer les volume de sédiments charriés lors de cette crue exceptionnelle.

Mise à jour 15/07/2024. Le SYMBHI nous apprend que « Le débit du Vénéon a atteint 200 m3/s (source EDF) à plan du Lac (St Christophe en Oisans) ». Cela ferait une lame d’eau horaire de 7 mm, ce qui reste compatible avec les mesures du pluviomètres de St Christophe (on observe 3h avec des taux supérieurs à 8 mm/h).

-

4:27

4:27 Crue du Vénéon : que nous apprennent les images satellites ?

sur Séries temporelles (CESBIO)Pièce jointe: [télécharger]

Le 21 juin 2024, la crue torrentielle du Vénéon et de son affluent le torrent des Étançons a dévasté le hameau de la Bérarde dans le massif des Écrins. Cette crue a résulté des fortes pluies et de la fonte de la neige, et a peut-être été aggravée par la vidange d’un petit lac supra-glaciaire. […]

-

11:52

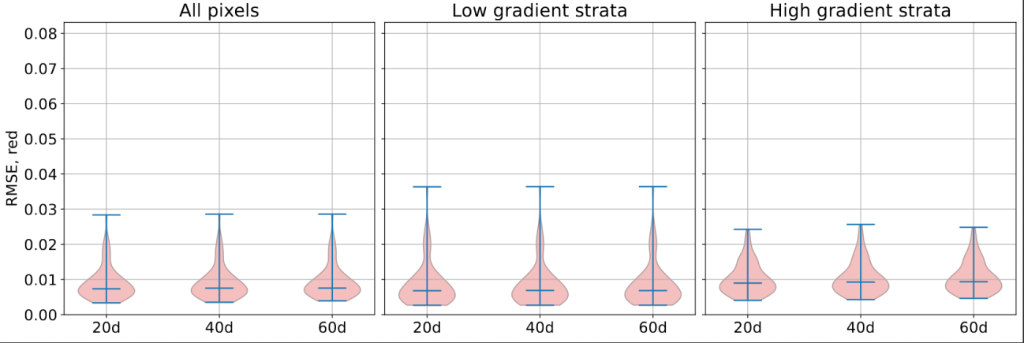

11:52 Fin de la phase d’acquisitions d’images de VENµS

sur Séries temporelles (CESBIO)C’est avec une certaine tristesse mais aussi beaucoup de fierté que je vous rappelle que la phase opérationnelle de VENµS se terminera fin juillet après 7 ans de bon travail. La phase d’acquisition actuelle (VM5) s’arrêtera le 12 juillet. Les semaines restantes seront consacrées à quelques expériences techniques (les acquisitions au-dessus d’Israël se poursuivront jusqu’à fin juillet), puis, nos collègues israéliens videront les réservoirs en abaissant l’orbite, « passiveront » le satellite, puis laisseront les hautes couches de l’atmosphère réduire sa vitesse et abaisser son altitude avant de brûler dans l’atmosphère dans quelques années.

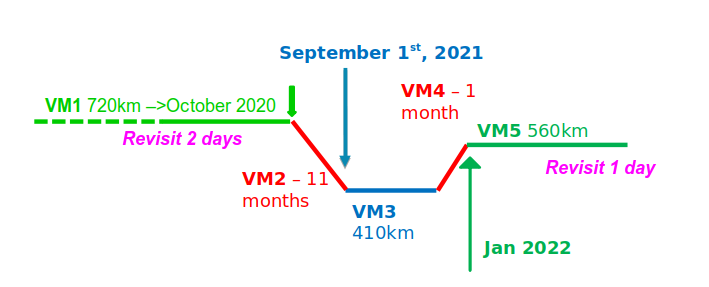

Les agences spatiales de France (CNES) et d’Israêl (ISA) ont lancé le micro-satellite VENµS en août 2017, et pour un micro-satellite, il a eu une vie assez particulière ! VENµS a d’abord été injecté en orbite à 720 km d’altitude. Il y est resté 3 ans (phase 1 de la mission VENµS, VM1), puis son orbite a été abaissée à 400 km (VM2), il y a été maintenu quelques mois (VM3), avant d’être remonté (VM4) à 560 km (VM5) où il est resté deux ans et demi.

VENµS avait en effet deux missions :

- tester un moteur à propulsion ionique et démontrer qu’il était capable de changer d’orbite et même de maintenir le satellite à 400 km d’altitude et de compenser le freinage atmosphérique dû aux couches les plus élevées de l’atmosphère terrestre

- prendre des images répétitives de sites sélectionnés à haute résolution (4 à 5 m), avec des revisites fréquentes (1 ou 2 jours), avec 12 bandes spectrales fines, et un instrument de haute qualité.

Les deux phases VM1 et VM5 ont été utilisées pour observer environ 100 sites (différents sites pour chaque phase), avec une revisite de deux jours pendant VM1, et d’un jour pour certains sites pendant VM5. Toutes les images ont été traitées au niveau 1C et au niveau 2A. En ce qui concerne VM5, un retraitement complet sera effectué fin 2024 afin d’avoir un jeu de données cohérent, avec les derniers paramètres de correction géométrique et radiométrique mis à jour, et les mêmes versions des chaines de traitement, pendant toute la durée de vie du VENµS. le même retraitement avait été effectué après la fin de VM1 en 2022.

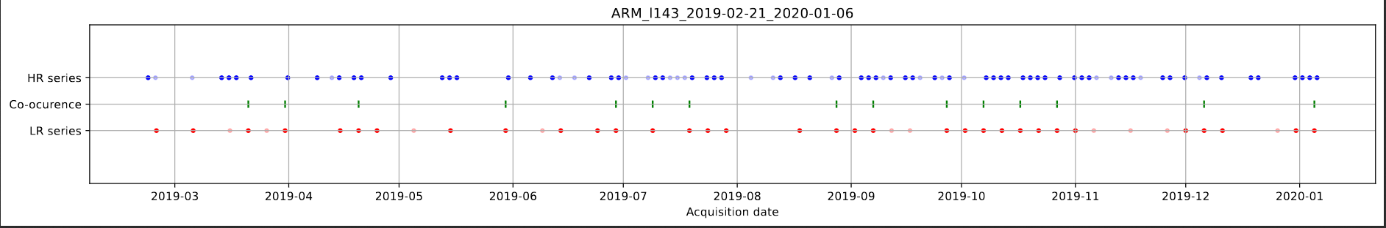

Tableau de bord actuel du site web de distribution du CNES, avec le nombre de produits disponibles. Seules les images avec une proportion suffisante de pixels sans nuages sont fournies, et les statistiques ne tiennent pas compte des produits sur Israël distribués par l’université Ben Gurion du Neguev.

Tableau de bord actuel du site web de distribution du CNES, avec le nombre de produits disponibles. Seules les images avec une proportion suffisante de pixels sans nuages sont fournies, et les statistiques ne tiennent pas compte des produits sur Israël distribués par l’université Ben Gurion du Neguev.

Bien que l’impact scientifique de VENµS n’ait pas été à la hauteur des espérances initiales en raison de son lancement tardif (VENµS devait démontrer la puissance des observations optiques multitemporelles, mais a finalement été lancé après Sentinel-2), il nous a néanmoins incités à préparer intensivement l’arrivée des observations de Sentinel-2. Le développement de nombreuses méthodes telles que celles des processeurs MAJA, WASP,et Iota2 ont été motivées par l’existence du projet VENµS.

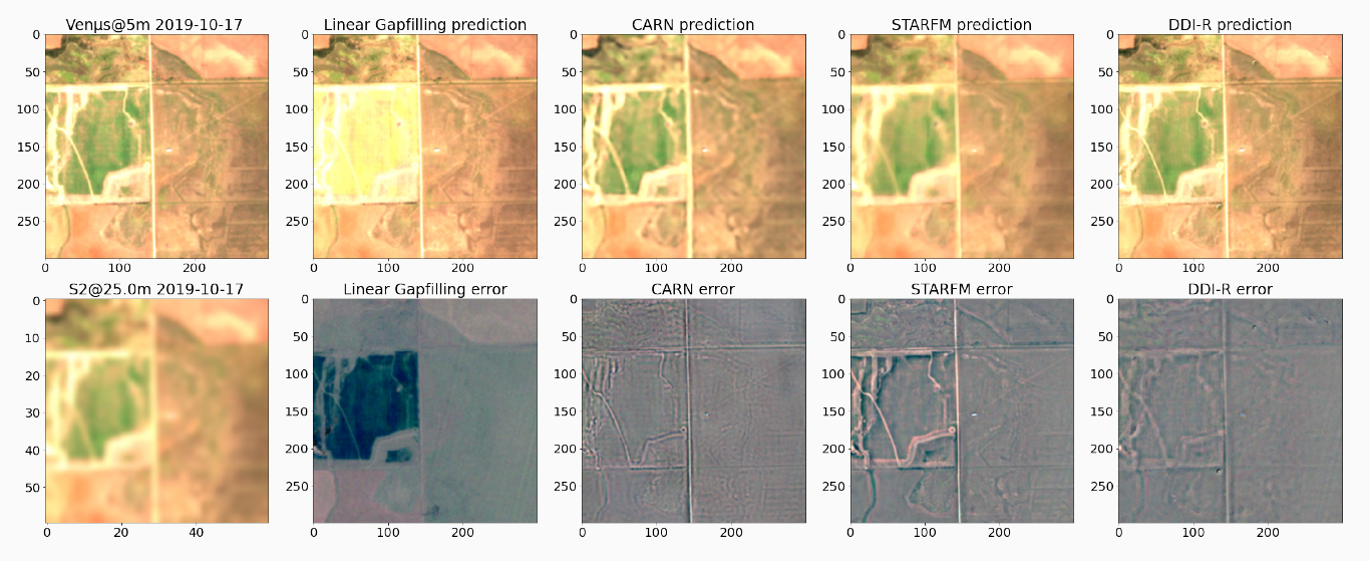

De plus, les données acquises par VENµS vont rester disponibles [https:] et nous espérons que sa combinaison unique de résolution (4m) et de revisite (1 jour) avec 12 bandes, sera encore utile pour plusieurs années à venir. Notre petit satellite est de plus en plus connu dans la communauté de l’apprentissage profond, puisqu’il a été utilisé pour construire le jeu de données Sen2VENµS afin d’apprendre à améliorer la résolution de Sentinel-2, ou pour tester les méthodes de fusion de données entre Sentinel-2 et VENµS.

Par ce billet, nous souhaitons remercier toutes les équipes en France et en Israël qui ont contribué à la décision, au financement, à la construction, à l’exploitation et au traitement des données de ce satellite. La liste des personnes ayant apporté une contribution significative serait trop longue (des centaines), et le risque d’oublier quelqu’un serait trop élevé, aussi nous ne citerons que Gerard Dedieu and Arnon Karnieli, les PI français et israélien initiaux (Arnon est toujours PI), qui ont consacré de nombreuses années de leur carrière à la réussite de ce petit satellite.

Rédigé par Olivier Hagolle (CNES/CESBIO) avec l’aide d’Arnon Karnieli (BGU)

PS : La fin du VM5 a été une période difficile avec un satellite vieillissant qui a largement dépassé sa durée de vie nominale de 3 ans avec un objectif fixé à 5 ans. Une proportion non négligeable des tentatives d’acquisition a échoué, et certains sites n’ont pas produit les séries temporelles attendues. Nous nous excusons si la collecte de données n’a pas été à la hauteur de vos attentes. Cependant, notre collection de données comprend plus de 82 000 produits, 56 000 pour VM1 et 26 000 pour VM5, ce qui nous permet de disposer de nombreuses et belles séries de produits prêts à l’emploi (Analysis Ready Data).

-

11:52

11:52 Fin de la phase d’acquisitions d’images de VENµS

sur Séries temporelles (CESBIO)

=> C’est avec une certaine tristesse mais aussi beaucoup de fierté que je vous rappelle que la phase opérationnelle de VENµS se terminera fin juillet après 7 ans de bon travail. La phase d’acquisition actuelle (VM5) s’arrêtera le 12 juillet. Les semaines restantes seront consacrées à quelques expériences techniques (les acquisitions au-dessus d’Israël se poursuivront […]

-

14:05

14:05 The end of VENµS imaging phase

sur Séries temporelles (CESBIO)It is with some sadness but also a lot of pride that I remind you that the VENµS operational phase will end at the end of July after 7 years of good work. The current acquisition phase (VM5) will stop on the 12th of July. The remaining weeks will be devoted to a few technical experiments (acquisitions over Israel will go on until end of July), and then, our Israeli colleagues will empty the tanks by lowering the orbit, passivate the satellite, and then let the higher layers of the atmosphere reduce its speed and lower its altitude before burning in the atmosphere in a few years.

The French and Israeli space agencies (CNES and ISA) launched the VENµS micro-satellite in August 2017, and for a micro-satellite, it has had quite a special life ! VENµS was first injected into orbit at 720 km altitude. It stayed there for 3 years (VENµS Mission 1 phase, VM1), then its orbit was lowered to 400 km (VM2), it was maintained there for a few months (VM3), before being raised again (VM4) to 560 km (VM5) where it stayed for two and a half years.

VENµS indeed had two missions :

- test a ionic propulsion engine and verify it was able to change orbits and even maintain the satellite at 400 km altitude with all the atmospheric drag due to the highest levels of the earth atmosphere

- take repetitive images of selected sites at a high resolution (4 to 5 m), frequent revisit (1 or 2 days), with 12 thin spectral bands, and a high-quality instrument

The two phases VM1 and VM5 were used to observe around 100 sites (different sites for each phase), with a revisit of two days during VM1, and one day for some sites during VM5. All the images have been processed to Level 1C and Level 2A. Regarding VM5, a full reprocessing will be done at the end of 2024 to have a consistent data set with the latest updated geometric and radiometric correction parameters, and the same updated versions of software during the whole life of VENµS. The same reprocessing had been done after the end of VM1 in 2022.

Current dashboard of CNES distribution website, with the number of available products. Only images with a sufficient proportion of cloud free pixels are produced, and the statistics do not account for the products over Israel distributed at BGU.

Current dashboard of CNES distribution website, with the number of available products. Only images with a sufficient proportion of cloud free pixels are produced, and the statistics do not account for the products over Israel distributed at BGU.

Although VENµS’ scientific impact was not as high as expected due to its late launch (VENµS was meant to demonstrate the power of multi-temporal optical observations, but was finally launched after Sentinel-2), it nevertheless incited us to prepare the arrival of Sentinel-2 observations intensively. The development of many methods such as those in MAJA, WASP, Iota2 or LIS processors were motivated by the existence of the VENµS project.

Moreover, the data acquired by VENµS are here to stay ( [https:]] ), and we hope its unique combination of resolution (4m) and revisit (1 day) with 12 bands, will still be useful for several years to come. Our little satellite is getting very well known in the deep learning community, as it has been used to build the Sen2VENµS data set for learning to improve the resolution of Sentinel-2, or to test data fusion methods between Sentinel-2 and VENµS.

With this post, we would like to thank all the teams in France and Israel who contributed to the decision, funding, building, exploitation and data processing of this satellite. The list of persons who brought a meaningful contribution would be too long (hundreds), and the risk of forgetting someone will to too high, so we will only cite Gerard Dedieu and Arnon Karnieli, the initial French and Israeli PIs (Arnon is still PI), who devoted many years of their career to the success of this little satellite.

Written by VENµS PI: Olivier Hagolle (CNES/CESBIO) with the help of Arnon Karnieli (BGU)

PS : The end of VM5 was a difficult period with an aging satellite that was well over its nominal life of 3 tears with a goal set to 5 years. A non-negligible proportion of the attempted acquisitions failed, and some sites did not yield the expected time series. We apologize if the data collection was not as good as your expectations. However, our data collection includes more than 82,000 products, 56,000 for VM1, and 26,000 for VM5, bringing much analysis-ready data

-

14:05

14:05 The end of VENµS imaging phase

sur Séries temporelles (CESBIO)

=> It is with some sadness but also a lot of pride that I remind you that the VENµS operational phase will end at the end of July after 7 years of good work. The current acquisition phase (VM5) will stop on the 12th of July. The remaining weeks will be devoted to a few […]

-

2:23

2:23 Evolution récente du manteau neigeux dans les Pyrénées Orientales

sur Séries temporelles (CESBIO)Après que j’ai publié l’état actuel du stock de neige dans les bassins du Rhône et de la Garonne, certains internautes m’ont suggéré de répéter l’analyse pour les fleuves côtiers des Pyrénées Orientales qui subissent une sécheresse depuis le printemps 2022. Voici le résultat pour la région formée par l’agrégation des bassins du Tech et de la Têt (total 2095 km2).

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt jusqu’au 1er mai 2024 (modèle SIM2, Météo-France)

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt jusqu’au 1er mai 2024 (modèle SIM2, Météo-France)

C’est la deuxième année consécutive de fort déficit en neige sur ces bassins.

Evolution de l’équivalent en eau du manteau neigeux au cours des deux dernières années hydrologiques dans les bassins du Tech et de la Têt.

L’année en cours — et donc la précédente — sont loin des normales de 1991-2020 et a fortiori de 1961-1990 sur ces bassins.

Evolution de l’équivalent en eau du manteau neigeux au cours des deux dernières années hydrologiques dans les bassins du Tech et de la Têt.

L’année en cours — et donc la précédente — sont loin des normales de 1991-2020 et a fortiori de 1961-1990 sur ces bassins.

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt. Les enveloppes correspondent aux percentiles 10-90 et les traits pleins à la médiane.

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt. Les enveloppes correspondent aux percentiles 10-90 et les traits pleins à la médiane.

L’enveloppe autour de la médiane est large car le climat méditerranéen est caractérisé par un forte variabilité naturelle. Néanmoins on voit aussi un signal clair vers une fonte plus précoce entre ces deux périodes (même graphe ci-dessous sans les enveloppes de percentiles).

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt (médianes de chaque période).

Evolution de l’équivalent en eau du manteau neigeux dans les bassins du Tech et de la Têt (médianes de chaque période).

Le graphe ci-dessus montre bien le concept « slower melt in a warmer world » : dans un climat plus chaud, la fonte démarre plus tôt au printemps à un moment où l’énergie solaire disponible pour la fonte est plus faible. Les taux de fonte sont donc plus faibles (le taux de fonte est donné par la pente de la courbe).

Je réalise ces analyses à partir des simulations du modèle opérationnel SIM2 désormais mises à disposition pour tous par Météo-France. Ce modèle est forcé par des données météorologiques in situ et donne de très bons résultats quand on le compare aux séries temporelles de surfaces enneigées obtenues par satellite sur les Pyrénées (voir ce post). Néanmoins, la résolution spatiale du modèle SIM2 est assez faible (8 km) ce qui peut causer des erreurs dans la modélisation de la neige à une échelle plus locale, même si le modèle utilise une paramétrisation sous-maille pour prendre en compte l’effet du relief au premier ordre. Il faudrait donc l’évaluer plus en détail sur les Pyrénées Orientales pour vérifier ces conclusions compte-tenu des enjeux importants associés au manteau neigeux dans cette région pour l’agriculture, l’hydroélectricité et les écosystèmes.

Photo : versant oriental du Massif du Canigou au printemps 2019 (Damusmedia, CC BY-SA 4.0, via Wikimedia Commons)

-

16:29

16:29 Sentinel-2 Enhance button: 5-meters resolution for 10 bands at your fingertips

sur Séries temporelles (CESBIO)Enhance button is a very common movies trope, where a character scrolls through some video footage or photos and asks a computer to enhance its resolution to an insane level of details, enabling solving crime mysteries and conspiracies of all sort with clues that were invisible in the original image. While this meme has been frequently parodied and mocked for defiling science, it did not stop researchers and engineers of our deep-learning era to harness the power of both GPUs and automatic differentiation into pushing foward performances of Single Image Super-Resolution (SISR), which is the scientific name of the Enhance button.

Of course, the remote sensing community wants its enhance button too! In the frame of the EVOLAND project, CESBIO has developed and released under Apache 2.0 sentinel2_superresolution, a tool that takes as input a L1C or L2A (Theia format) Sentinel-2 product and outputs 10 of the most useful bands (namely B2, B3, B4, B5, B6, B7, B8, B8A, B11, B12) at 5-meter resolution. It is very simple to use:

$ sentinel2_superesolution -v -i SENTINEL2A_20200808-105933-164_L2A_T31TCG_C_V2-2/ -o results/ -roi 300160.000 4590400.000 304000.000 4594240.000

Et voilà!

Red Edge band composition (B7, B6, B5) of a detail of Sentinel-2 image of 2020.08.08 of tile 31TCG,bicubic zoom (left) and 5-meters and output of sentinel2_superresolution (right).

Backstory

Red Edge band composition (B7, B6, B5) of a detail of Sentinel-2 image of 2020.08.08 of tile 31TCG,bicubic zoom (left) and 5-meters and output of sentinel2_superresolution (right).

Backstory

Here at CESBIO, we released in 2022 the Sen2Venµs dataset, tailored for the training of SISR models that bring common bands of Venµs and Sentinel-2 at 5-meter resolution, that we gathered during a phase-0 study for the Sentinel-HR mission (add link). In 2022, we then worked together with Thales and MEOSS in the frame of one year ITT project for ESA, starting to explore the possibilities of the Sen2Venµs dataset for the super-resolution of Sentinel-2 with good performances. In 2023, we then joined the consortium of the EVOLAND project, a HORIZON Europe project from the European Commission aiming at designing future and enhanced Copernicus products for 2030, based on new missions, new data and new algorithms. CESBIO is responsible for the improved resolution sub-task, aiming at providing methods to improve the spatial, temporal and spectral resolution of satellite data for downstream product prototypes.

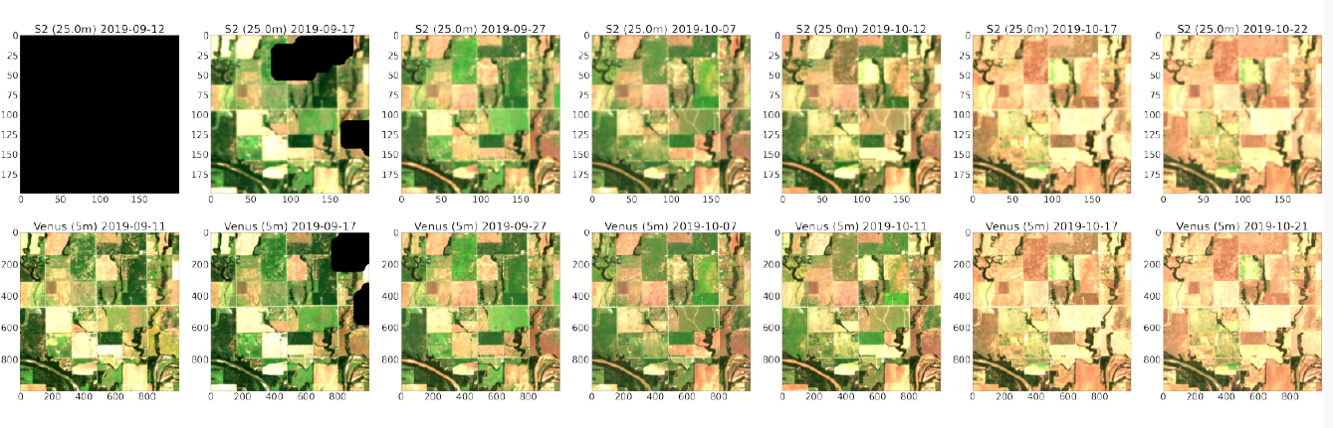

How it worksIf SISR is to be part of the processing of future Copernicus products, it will be applied to tenths of thousands of products, and therefore the computational cost should be as limited as possible. We therefore selected a lightweight and relatively shallow network known as Cascading Residual Network (CARN), and parameterized it with as few blocks as possible in order to reduce its processing cost (selected model only has 2.5M parameters).The network has been trained to jointly process all 10 bands at once, up-sampled at 10-meter resolution. Training is achieved by using the Sen2Venµs dataset complemented with B11 and B12 patches. In order to workaround the lack of 5-meter Venµs reference for B11 and B12, training makes use of two loss terms, one at full resolution for all bands except B11 and B12, and the other specifically targeted at B11 and B12 and operating at lower resolution through Wald protocol.

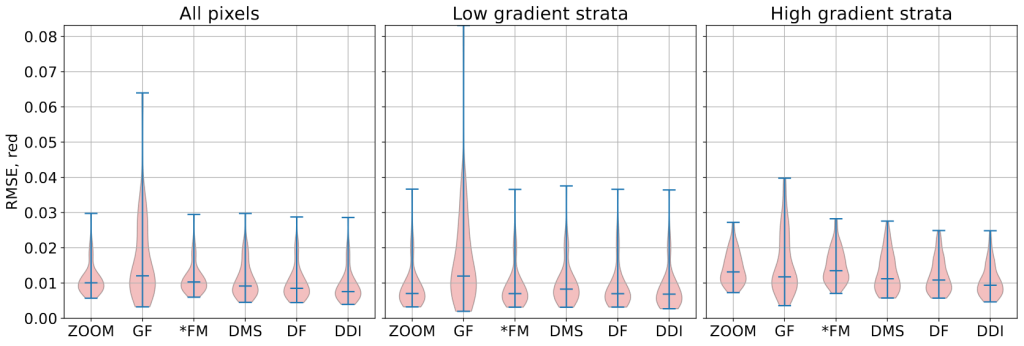

The network is pre-trained with simulated data (from Venµs reference patches) for 20 epochs. We found that this pre-training already gives consistent results with respect to pre-training on real data, as shown in the following figure.

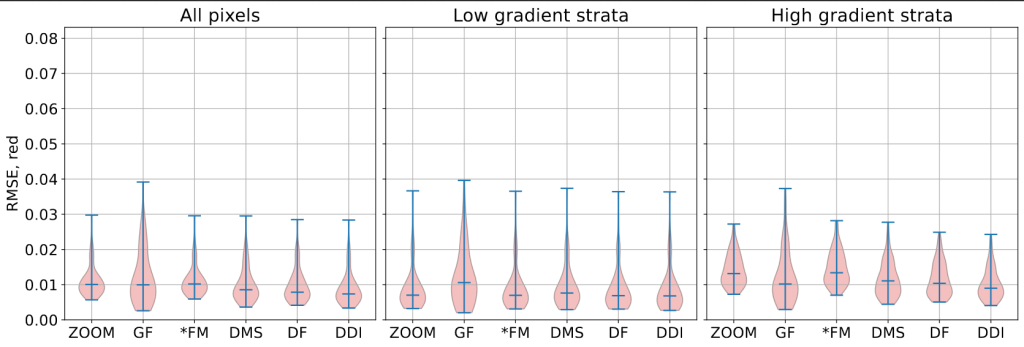

Comparison between different pre-training method. From left to right: bicubic up-sampling, L1 loss on real data, L1 loss on separated high and low spatial frequencies of real data, L1 loss on simulated data, and Venµs reference.

Comparison between different pre-training method. From left to right: bicubic up-sampling, L1 loss on real data, L1 loss on separated high and low spatial frequencies of real data, L1 loss on simulated data, and Venµs reference.

The best network from pre-training is then fine-tuned with adversarial (GAN) training for 10 additional epochs while monitoring the BRISQUE score on the validation set to select best model. This fine-tuning results in minor quality improvement, interestingly mostly benefiting the 20-meter bands, as shown in the following figure:

Comparison between pre-trained and fine-tuned models.

Performances assessment

Comparison between pre-trained and fine-tuned models.

Performances assessment

Assessing performances of SISR network trained with the Sen2Venµs dataset is a challenging task, as already identified in the earlier work with Thalès and MEOSS, because the dataset has a lot of residual geometric and radiometric discrepancies between both satellite images which impairs traditional IQ metrics such as PSNR and SSIM. We first measure the radiometric consistency of each band with respect to the input Sentinel-2 image, over our testing set. Here we can observe that all bands have a RMSE below 0.005 for the training on simulated data (red bars), whereas training with L1 loss on real data or even with the more advanced HR/LR loss incur radiometric distortion.

Radiometric consistency with respect to input Sentinel-2 images

Radiometric consistency with respect to input Sentinel-2 images

The next and more difficult question is how much high resolution details are actually injected by the algorithm. The first thing we can do is to measure the RMSE on high spatial frequency content of the signal. Since this measure will be very sensitive to geometric distortion, we do it on simulated data. This highlights a moderate improvement for 10-meter bands and a large improvement for 20-meter band, which is consistent with the visual assessment.

RMSE on high spatial frequencies measured on simulated data from the testing set.

RMSE on high spatial frequencies measured on simulated data from the testing set.

Finally we can have a look at what happens in Fourier domain. We can observe that the super-resolved image populates Fourier domain in twice the extent of the initial signal, which shows that super-resolution actually restores higher spatial frequencies with respect to bicubic up-sampling.

From left to right: FFT transform of bicubic-upsampled B7, super-resolved B7, and difference between both (red means higher FFT magnitude on super-resolved image).

Push the enhance button!

From left to right: FFT transform of bicubic-upsampled B7, super-resolved B7, and difference between both (red means higher FFT magnitude on super-resolved image).

Push the enhance button!

The sentinel2_superresolution can easily be installed with pip and should be straightforward to use. We have made the following estimates for processing time for a whole Sentinel-2 product, which is even achievable without a GPU !

CPU (1 core) CPU (8 cores) GPU (A100) L1C 6 hours 1 hour 6 minutes L2A 5 hours 50 minutes 5 minutes In the frame of EVOLAND, we are also working on getting the Sentinel-2 super-resolution algorithm running in OpenEO, and open source code for that should be released very soon. Stay tuned!

We are looking forward to see how this tool will be used by the downstream product prototypes of EVOLAND. Along with Thalès and MEOSS, we already demonstrated a clear interest for the Water Bodies Detection task, especially with the super-resolution of the SWIR bands (B11 and B12). We are also planning to integrate the tool as an on-demand processing in GEODES. Feedback is also welcome.

CreditsThis work was partly performed using HPC resources from GENCI-IDRIS (Grant 2023-AD010114835)

This work was partly performed using HPC resources from CNES.

-

18:39

18:39 Training deep neural networks for Satellite Image Time Series with no labeled data

sur Séries temporelles (CESBIO)The results presented in this blog are based on the published work : I.Dumeur, S.Valero, J.Inglada « Self-supervised spatio-temporal representation learning of Satellite Image Time Series » in IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, doi: 10.1109/JSTARS.2024.3358066.

In this paper, we describe a self-supervised learning method to train a deep neural network to extract meaningful spatio-temporal representation of Satellite Image Time Series (SITS). The code associated to this article is also available.This work is part of the PhD conducted by Iris Dumeur and supervised by Silvia Valero and Jordi Inglada. In the last few years, the CESBIO team has developed machine learning models which exploit Satellite Image Time Series (SITS). For instance, the blog « End-to-end learning for land cover classification using irregular and unaligned satellite image time series » presents a novel classification method based on Stochastic Variational Gaussian Processes.

Context and IntroductionWith the recent launch of numerous Earth observation satellites, such as Sentinel 2, a large amount of remote sensing data is available. For example, the Sentinel 2 mission acquires images with high spatial resolution (10 m), short temporal revisit (5 days), and wide coverage. These data can be exploited under the form of Satellite Image Time Series (SITS), which are 4-dimensional objects with temporal, spectral and spatial dimensions. In addition, SITS provide critical information for Earth monitoring tasks such as land use classification, agricultural management, climate change or disaster monitoring.

In addition, due to SITS specific acquisition conditions, SITS are irregular and have varying temporal sizes. Indeed, as detailed in this blog, the areas located on different orbital paths of the satellite have different acquisition dates and have a different revisit frequencies, causing respectively the unalignment and irregularity of SITS. Finally, Sentinel 2 SITS are affected by different meteorological conditions (clouds, haze, fog, or cloud shadow). Therefore, pixels within a SITS may be corrupted. Although validity masks are provided, incorrectly acquired pixels may be wrongly detected. In short, the development of models adapted to SITS requires to:- Utilize the 4D temporal, spectral, and spatial information

- Deal with SITS irregularity and unalignement

- Ignore wrongly detected cloudy pixels

Moreover, while Deep Learning (DL) approaches have shown great performances in remote sensing tasks, these models are data greedy. In addition, building large labeled datasets is costly. Therefore, the training of DL models on large geographic and temporal scales is constrained by the scarcity of labels. Moreover, self-supervised learning has achieved amazing performance in other domains, such as image processing or natural language processing. Self-supervised learning is a branch of unsupervised learning in which the model is trained on a task generated by the data. In other words, the labels needed to supervise the task are generated thanks to the data. For example, in natural language processing, as illustrated in the following image, one common self-supervised pre-training task consists in training the model to recover masked words.

Example of a Masked Language Model self-supervised training task (read upward)

Self-supervised learning can be used to pre-train a model on a large unlabeled dataset. Notably, during pre-training, the model learns representations of the input data, which are then used by a decoder to perform the self-supervised task. In a second phase, these latent representations can be used for various supervised tasks, denoted downstream tasks. In this case, as illustrated in the following image, a downstream classifier is trained on top of the latent representations generated by the pre-trained model.

Description of the link between self-supervised pre-training and supervised downstream task

When the self-supervised pre-training is successful:

- The pre-trained model provides latent representations that are relevant for a various set of downstream tasks

- If the downstream task lacks of labeled data to train a Deep Neural Network (DNN) from scratch, loading a pre-trained model is expected to improve the performance.

Considering all of the above, we propose a new method, named U-BARN (Unet-Bert spAtio-temporal Representation eNcoder).

We present two main contributions:- A new spatio-temporal architecture to exploit the spatial, spectral and temporal dimensions of SITS. This architecture is able to handle irregular and unaligned annual time series.

- A self-supervised pre-training strategy suitable for SITS

Then, the quality of the representations is assessed on two different downstream tasks: crop and land cover segmentation. Due to the specific pre-training strategy, cloud masks are not required for the downstream tasks.

Method U-BARN architectureAs described in the previous image, U-BARN is a spectro-spatio-temporal architecture that is composed of two successive blocks:

- Patch embedding : which is composed of a spatial-spectral encoder (a Unet) that processes independently each image of the SITS. No temporal features are extracted in this block.

- Temporal Transformer : which processes pixel-level time series of pseudo-spectral features. No further spatial features are extracted in this block.

The details of the U-BARN architecture are given in the full paper. We have used a Transformer to process the temporal dimension, as it enables to process irregular and unaligned time series while being highly parallelizable. Lastly, the latent representation provided U-BARN has the same temporal dimension as the input SITS.

Self-supervised pre-training strategyInspired by self-supervised learning techniques developed in natural language processing, we propose to train the model to reconstruct corrupted images from the time series. As shown in the next figure, during pre-training, a decoder is trained to rebuild corrupted inputs from the latent representation. The way images are corrupted is detailed on the full paper.

A reconstruction loss is solely computed on corrupted images. Additionally, to avoid training the model to reconstruct incorrect values, a validity mask is used in the loss. If the pixel has incorrect acquisition conditions, the pixel is not used in the loss. We want to emphasize that the validity mask is only used in the loss reconstruction. Therefore, the validity mask is not needed for the supervised downstream tasks. Lastly, an important pre-training parameter is the masking rate, i.e., the number of corrupted images in the time series. Increasing the number of corrupted image, complicate the pre-training task.

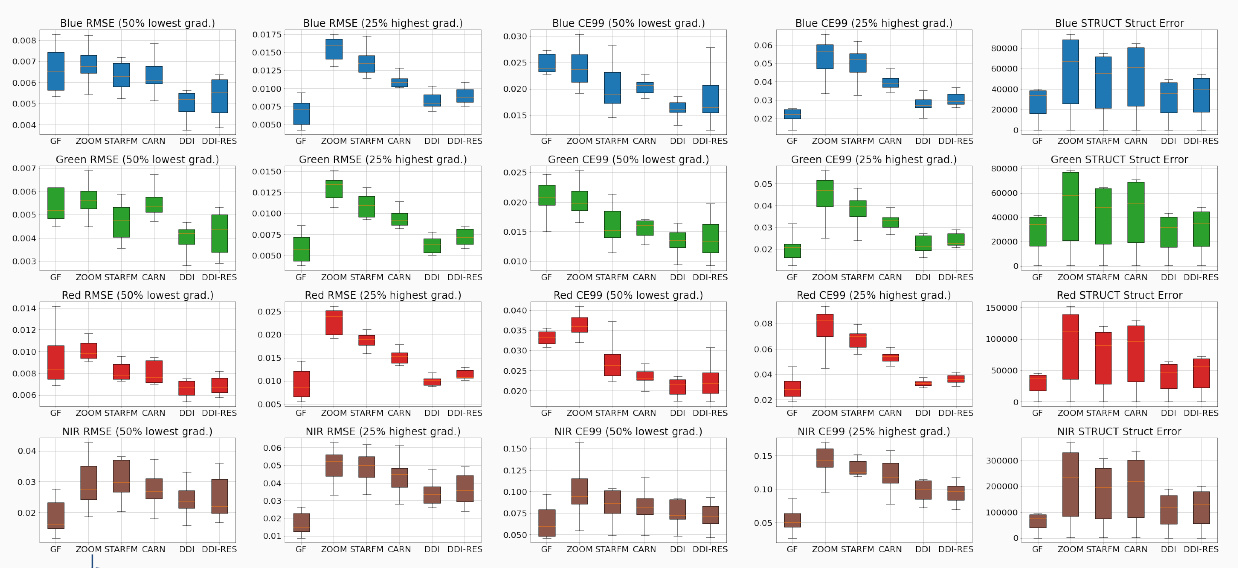

Experimental setup DatasetsThree Sentinel 2 L2A datasets constituted of annual SITS are used:

- A large scale unlabeled dataset to pre-train U-BARN with the previously defined self-supervised learning strategy. This dataset contains data from 2016 to 2019 over 14 S2 tiles in France. The constructed unlabeled dataset is shared on zenodo : 10.5281/zenodo.7891924.

- Two labeled datasets are used to assess the quality of the pre-training. We perform crop (PASTIS) and land cover (MultiSenGE) segmentation.

Description of the S2 data-sets used for pretext and downstream tasks. The unlabeled data-set for pre-training is composed of two disjoint data-sets: training (tiles in blue) and validation (tiles in red). S2 tiles in the labeled data-sets are shown in green and black respectively for PASTIS and MultiSenGE.

Description of the S2 data-sets used for pretext and downstream tasks. The unlabeled data-set for pre-training is composed of two disjoint data-sets: training (tiles in blue) and validation (tiles in red). S2 tiles in the labeled data-sets are shown in green and black respectively for PASTIS and MultiSenGE.

In all three datasets, the Sentinel 2 products are processed to L2A with MAJA. For these data-sets, only the four 10 m and the six 20 m resolution bands of S2 are used.

Experimental setupThe conducted experiments are summarized in the following illustration.

Illustration of the conducted experiments. The loop means that the SITS encoder weights are updated during the downstream task. The red crossed-out loop indicates that the weights are frozen during the downstream task.

Illustration of the conducted experiments. The loop means that the SITS encoder weights are updated during the downstream task. The red crossed-out loop indicates that the weights are frozen during the downstream task.

In the downstream tasks, the representations provided by U-BARN are fed to a shallow classifier to perform segmentation. The proposed shallow classifier architecture is able to process input with varying temporal sizes. We consider two possible ways to use the pre-trained U-BARN:

– Frozen U-BARN: U-BARNFR corresponds to the pre-trained U-BARN whose weights are frozen during the downstream tasks. In this configuration, the number of trainable parameters is greatly reduced during the downstream task.

– Fine-tuned U-BARN: U-BARNFT is the pre-trained U-BARN whose weights are the starting points for training the downstream tasks.

To evaluate the quality of the pre-training, we integrate two baselines:

– FC-SC: We feed the shallow classifier (SC) with features from a channel-wise fully connected (FC) layer. Although the FC layer is trained during the downstream task, if the U-BARN representations are meaningful, we expect U-BARNFR to outperform this configuration.

– U-BARNe2e: The fully supervised framework U-BARNe2e, where the model is trained from scratch on the downstream task (end-to-end (e2e)). When enough labelled data are provided, we expect U-BARNe2e to outperform U-BARNFR . The fully-supervised architecture is compared to another well known fully-supervised spectro-spatio-temporal architecture on SITS: U-TAE.

Results Results of the two downstream segmentation tasks

Segmentation tasks performances on PASTIS and MultiSenGE. The F1 score is averaged per class.Model Nber of trainable weights F1 PASTIS F1 MSENGE FC-SC 14547 0.509 0.323 U-BARN-FR 13843 0.618 0.356 U-BARN-FT 1122323 0.816 0.506 U-BARN-e2e 1122323 0.820 0.492 U-TAE 1086969 0.803 0.426

First, as expected, U-BARNFR outperforms FC-SC, showing that the features extracted by U-BARN are meaningful for both segmentation tasks. Second, we observe that in the MultiSenGE land cover segmentation task, the fine-tuned configuration (U-BARNFT) outperforms the fully-supervised one (U-BARNe2e). Nevertheless, when working on the full PASTIS labeled dataset, in contrast to MultiSENGE, we observe no gain from fine-tuning compared to the fully supervised framework on PASTIS. We assume that there may be enough labeled data for PASTIS task, to pre-train the model from scratch. Third, the results show that the newly proposed architecture is consistent with the existing baseline: the performance of the fully supervised U-BARN is slightly higher than that of U-TAE. Labeled data scarcity simulationWe have conducted a second experiment where the number of labeled data is greatly reduced on PASTIS. As expected, with a decrease in the number of labeled data, the models’ performances drop. Nevertheless, the drop in performance is different for the pre-trained architecture U-BARNFT, and the two fully-supervised architectures U-BARNe2eand U-TAE. Indeed, we observe that when the number of labeled data is small, fine-tuning greatly improves the performance. This experiment highlights the benefit of self-supervised pre-training in configuration when labeled data is lacking.

The F1 and mIoU as a function of the number of training data. NSITS is the number of SITS of PASTIS labelled dataset used to train the various configurations. The lower NSits, the less information provided to train the downstream task. When NSITS equals 150, this is approximately 13% of the labeled dataset. Supplementary results

Investigation of the masking rate influence, training and inference time as well as detailed segmentation performances are available in the full paper.

Conclusion and perspectivesWe have proposed a novel method for learning self-supervised representations of SITS. First, the proposed architecture’s performance is consistent with the U-TAE competitive architecture. Moreover, our results show that the pre-training strategy is efficient in extracting meaningful representations for crop as well as land cover segmentation tasks.

Nevertheless, the proposed method suffers from several limitations:

- The proposed architecture only processes annual SITS.

- The proposed architecture is less computationally efficient compared to the U-TAE, and further research should be done to reduce the number of operations in our architecture.

- The temporal dimension of the learned representation is the same as the input time series. In the case of irregularly sampled time series, the classifier in the downstream task must be able to handle this type of data.

Lastly, future work will focus on producing fixed-dimensional representations of irregular and unaligned SITS. Additionally, we intend to use other downstream tasks and integrate other modalities, such as Sentinel 1 SITS.

AcknowledgementsThis work is supported by the DeepChange project under the grant agreement ANR-DeepChange CE23. We would like to thank CNES for the provision of its high performance computing (HPC) infrastructure to run the experiments presented in this paper and the associated help.

-

12:12

12:12 How do we use Remote Sensing data at CESBIO ?

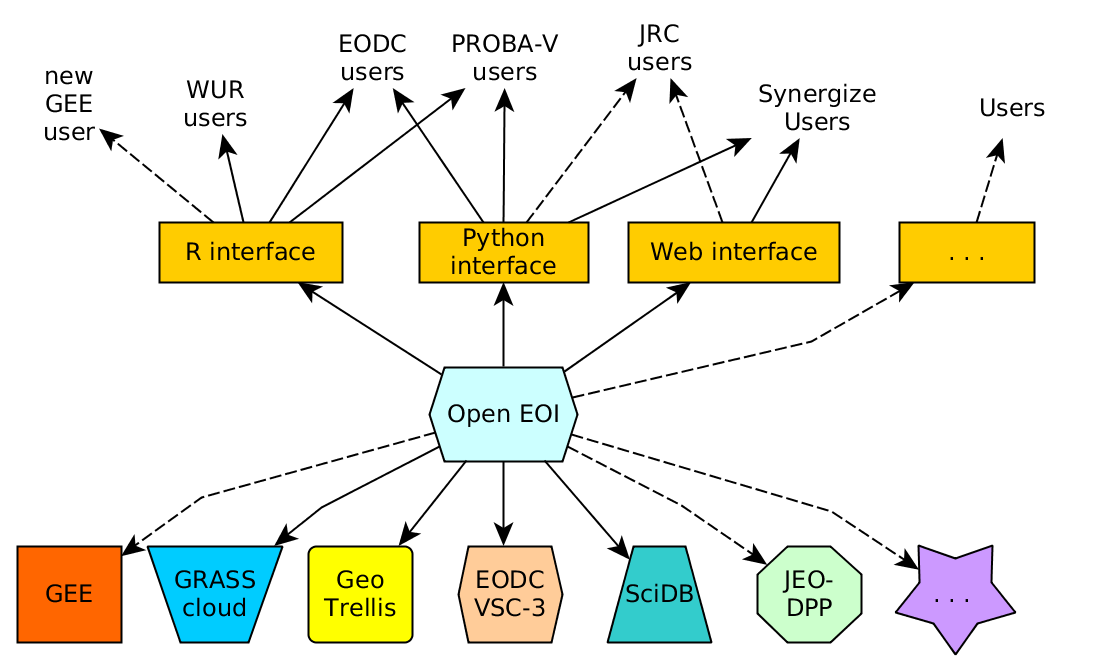

sur Séries temporelles (CESBIO)Several data access centres are being renovated at CNES, ESA, and their first versions often lack some of the features we need. Together with colleagues from CESBIO, we have made a presentation of the way we use remote sensing (RS) data: here is a text version of this presentation.

Of course, there are as many ways of using the data as there are users, but we can find some recurring patterns in all CESBIO users. What about you ? How do you use RS data? Please specify that in the article’s comments. There are certainly other modes of use than ours, just as effective.

What users are we ? CESBIO RS users in front of the lab