Un Planet est un site Web dynamique qui agrège le plus souvent sur une seule page, le contenu de notes, d'articles ou de billets publiés sur des blogs ou sites Web afin d'accentuer leur visibilité et de faire ressortir des contenus pertinents aux multiples formats (texte, audio, vidéo, Podcast). C'est un agrégateur de flux RSS. Il s'apparente à un portail web.

Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Dans la presse

Dans la presse

-

10:30

10:30 Philippe Valette, Albane Burens, Laurent Carozza, Cristian Micu (dir.), 2024, Géohistoire des zones humides. Trajectoires d’artificialisation et de conservation, Toulouse, Presses universitaires du Midi, 382 p.

sur Cybergeo -

10:30

10:30 Cartographier les pressions qui s’exercent sur la biodiversité : éléments de réflexion autour des pratiques utilisées

sur Cybergeo -

10:30

10:30 Exploring human appreciation and perception of spontaneous urban fauna in Paris, France

sur Cybergeo -

10:30

10:30 From "Bioeconomy Strategy" to the "Long-term Vision" of European Commission: which sustainability for rural areas?

sur Cybergeo -

10:30

10:30 Impact du numérique sur la relation entre les systèmes de gestion de crise et les citoyens, analyse empirique en Île-de-France et en Région de Bruxelles-Capitale

sur Cybergeo -

10:30

10:30 La fabrique publique/privée des données de planification urbaine en France : entre logique gestionnaire et approche territorialisée de la règle

sur Cybergeo -

10:30

10:30 Le territoire est toujours vivant. Une analyse transversale de la littérature sur un concept central de la géographie

sur Cybergeo -

10:30

10:30 Vers une transition des systèmes agricoles en France métropolitaine ? Une géographie contrastée et en mouvement (2010 et 2020)

sur Cybergeo -

10:30

10:30 Explorer la répartition spatiotemporelle des piqûres de tiques sur les humains en France : la température moyenne comme indicateur du risque acarologique

sur Cybergeo -

10:30

10:30 Bernard Lahire, 2023, Les structures fondamentales des sociétés humaines, Paris, La Découverte, Collection sciences sociales du vivant, 970 p.

sur Cybergeo

-

9:30

9:30 Appropriations de l’espace et répression du mouvement des Gilets jaunes à Caen

sur Mappemonde -

9:30

9:30 Les cartes dans l’analyse politique de l’espace : de l’outil à l’objet de recherche

sur Mappemonde -

9:30

9:30 Les stratégies cartographiques des membres de la plateforme Technopolice.fr

sur Mappemonde -

9:30

9:30 La végétalisation de Paris vue au travers d’une carte : une capitale verte ?

sur Mappemonde -

9:30

9:30 Géopolitique de l’intégration régionale gazière en Europe centrale et orientale : l’impact du Nord Stream 2

sur Mappemonde -

9:30

9:30 Les Petites Cartes du web

sur Mappemonde -

9:30

9:30 L’Amérique latine

sur Mappemonde -

9:30

9:30 Les cartes de l’action publique. Pouvoirs, territoires, résistances

sur Mappemonde -

9:30

9:30 Vulnérabilités à l’érosion littorale : cartographie de quatre cas antillais et métropolitains

sur Mappemonde -

9:30

9:30 La construction d’une exception territoriale : L’éducation à la nature par les classes de mer finistériennes

sur Mappemonde

-

10:30

10:30 Philippe Valette, Albane Burens, Laurent Carozza, Cristian Micu (dir.), 2024, Géohistoire des zones humides. Trajectoires d’artificialisation et de conservation, Toulouse, Presses universitaires du Midi, 382 p.

sur Cybergeo -

10:30

10:30 Cartographier les pressions qui s’exercent sur la biodiversité : éléments de réflexion autour des pratiques utilisées

sur Cybergeo -

10:30

10:30 Exploring human appreciation and perception of spontaneous urban fauna in Paris, France

sur Cybergeo -

10:30

10:30 From "Bioeconomy Strategy" to the "Long-term Vision" of European Commission: which sustainability for rural areas?

sur Cybergeo -

10:30

10:30 Impact du numérique sur la relation entre les systèmes de gestion de crise et les citoyens, analyse empirique en Île-de-France et en Région de Bruxelles-Capitale

sur Cybergeo -

10:30

10:30 La fabrique publique/privée des données de planification urbaine en France : entre logique gestionnaire et approche territorialisée de la règle

sur Cybergeo -

10:30

10:30 Le territoire est toujours vivant. Une analyse transversale de la littérature sur un concept central de la géographie

sur Cybergeo -

10:30

10:30 Vers une transition des systèmes agricoles en France métropolitaine ? Une géographie contrastée et en mouvement (2010 et 2020)

sur Cybergeo -

10:30

10:30 Explorer la répartition spatiotemporelle des piqûres de tiques sur les humains en France : la température moyenne comme indicateur du risque acarologique

sur Cybergeo -

10:30

10:30 Bernard Lahire, 2023, Les structures fondamentales des sociétés humaines, Paris, La Découverte, Collection sciences sociales du vivant, 970 p.

sur Cybergeo

-

9:30

9:30 L’Amérique latine

sur Mappemonde -

9:30

9:30 Les cartes de l’action publique. Pouvoirs, territoires, résistances

sur Mappemonde -

9:30

9:30 Vulnérabilités à l’érosion littorale : cartographie de quatre cas antillais et métropolitains

sur Mappemonde -

9:30

9:30 La construction d’une exception territoriale : L’éducation à la nature par les classes de mer finistériennes

sur Mappemonde -

9:30

9:30 Appropriations de l’espace et répression du mouvement des Gilets jaunes à Caen

sur Mappemonde -

9:30

9:30 Les cartes dans l’analyse politique de l’espace : de l’outil à l’objet de recherche

sur Mappemonde -

9:30

9:30 Les stratégies cartographiques des membres de la plateforme Technopolice.fr

sur Mappemonde -

9:30

9:30 La végétalisation de Paris vue au travers d’une carte : une capitale verte ?

sur Mappemonde -

9:30

9:30 Géopolitique de l’intégration régionale gazière en Europe centrale et orientale : l’impact du Nord Stream 2

sur Mappemonde -

9:30

9:30 Les Petites Cartes du web

sur Mappemonde

-

9:18

9:18 55 sites "clés en main"

sur SIGMAG & SIGTV.FR - Un autre regard sur la géomatique -

8:32

8:32 Épinglé

sur SIGMAG & SIGTV.FR - Un autre regard sur la géomatique

-

10:30

10:30 Cartographier les pressions qui s’exercent sur la biodiversité : éléments de réflexion autour des pratiques utilisées

sur Cybergeo -

10:30

10:30 Exploring human appreciation and perception of spontaneous urban fauna in Paris, France

sur Cybergeo -

10:30

10:30 From "Bioeconomy Strategy" to the "Long-term Vision" of European Commission: which sustainability for rural areas?

sur Cybergeo -

10:30

10:30 Impact du numérique sur la relation entre les systèmes de gestion de crise et les citoyens, analyse empirique en Île-de-France et en Région de Bruxelles-Capitale

sur Cybergeo -

10:30

10:30 La fabrique publique/privée des données de planification urbaine en France : entre logique gestionnaire et approche territorialisée de la règle

sur Cybergeo -

10:30

10:30 Le territoire est toujours vivant. Une analyse transversale de la littérature sur un concept central de la géographie

sur Cybergeo -

10:30

10:30 Vers une transition des systèmes agricoles en France métropolitaine ? Une géographie contrastée et en mouvement (2010 et 2020)

sur Cybergeo -

10:30

10:30 Explorer la répartition spatiotemporelle des piqûres de tiques sur les humains en France : la température moyenne comme indicateur du risque acarologique

sur Cybergeo -

10:30

10:30 Bernard Lahire, 2023, Les structures fondamentales des sociétés humaines, Paris, La Découverte, Collection sciences sociales du vivant, 970 p.

sur Cybergeo -

10:30

10:30 Improving the perfomance of commercial mapping on the web : proposals for the web site of the French Forest Authority

sur Cybergeo

-

9:30

9:30 L’Amérique latine

sur Mappemonde -

9:30

9:30 Les cartes de l’action publique. Pouvoirs, territoires, résistances

sur Mappemonde -

9:30

9:30 Vulnérabilités à l’érosion littorale : cartographie de quatre cas antillais et métropolitains

sur Mappemonde -

9:30

9:30 La construction d’une exception territoriale : L’éducation à la nature par les classes de mer finistériennes

sur Mappemonde -

9:30

9:30 Appropriations de l’espace et répression du mouvement des Gilets jaunes à Caen

sur Mappemonde -

9:30

9:30 Les cartes dans l’analyse politique de l’espace : de l’outil à l’objet de recherche

sur Mappemonde -

9:30

9:30 Les stratégies cartographiques des membres de la plateforme Technopolice.fr

sur Mappemonde -

9:30

9:30 La végétalisation de Paris vue au travers d’une carte : une capitale verte ?

sur Mappemonde -

9:30

9:30 Géopolitique de l’intégration régionale gazière en Europe centrale et orientale : l’impact du Nord Stream 2

sur Mappemonde -

9:30

9:30 Les Petites Cartes du web

sur Mappemonde

-

10:30

10:30 Cartographier les pressions qui s’exercent sur la biodiversité : éléments de réflexion autour des pratiques utilisées

sur Cybergeo -

10:30

10:30 Exploring human appreciation and perception of spontaneous urban fauna in Paris, France

sur Cybergeo -

10:30

10:30 From "Bioeconomy Strategy" to the "Long-term Vision" of European Commission: which sustainability for rural areas?

sur Cybergeo -

10:30

10:30 Impact du numérique sur la relation entre les systèmes de gestion de crise et les citoyens, analyse empirique en Île-de-France et en Région de Bruxelles-Capitale

sur Cybergeo -

10:30

10:30 La fabrique publique/privée des données de planification urbaine en France : entre logique gestionnaire et approche territorialisée de la règle

sur Cybergeo -

10:30

10:30 Le territoire est toujours vivant. Une analyse transversale de la littérature sur un concept central de la géographie

sur Cybergeo -

10:30

10:30 Vers une transition des systèmes agricoles en France métropolitaine ? Une géographie contrastée et en mouvement (2010 et 2020)

sur Cybergeo -

10:30

10:30 Explorer la répartition spatiotemporelle des piqûres de tiques sur les humains en France : la température moyenne comme indicateur du risque acarologique

sur Cybergeo -

10:30

10:30 Bernard Lahire, 2023, Les structures fondamentales des sociétés humaines, Paris, La Découverte, Collection sciences sociales du vivant, 970 p.

sur Cybergeo -

10:30

10:30 Improving the perfomance of commercial mapping on the web : proposals for the web site of the French Forest Authority

sur Cybergeo

-

9:30

9:30 Appropriations de l’espace et répression du mouvement des Gilets jaunes à Caen

sur Mappemonde -

9:30

9:30 Les cartes dans l’analyse politique de l’espace : de l’outil à l’objet de recherche

sur Mappemonde -

9:30

9:30 Les stratégies cartographiques des membres de la plateforme Technopolice.fr

sur Mappemonde -

9:30

9:30 La végétalisation de Paris vue au travers d’une carte : une capitale verte ?

sur Mappemonde -

9:30

9:30 Géopolitique de l’intégration régionale gazière en Europe centrale et orientale : l’impact du Nord Stream 2

sur Mappemonde -

9:30

9:30 Les Petites Cartes du web

sur Mappemonde -

9:30

9:30 L’Amérique latine

sur Mappemonde -

9:30

9:30 Les cartes de l’action publique. Pouvoirs, territoires, résistances

sur Mappemonde -

9:30

9:30 Vulnérabilités à l’érosion littorale : cartographie de quatre cas antillais et métropolitains

sur Mappemonde -

9:30

9:30 La construction d’une exception territoriale : L’éducation à la nature par les classes de mer finistériennes

sur Mappemonde

-

8:31

8:31 Tout à 15 minutes

sur SIGMAG & SIGTV.FR - Un autre regard sur la géomatique -

8:52

8:52 Nantes Métropole, un SIG responsable et encadré

sur SIGMAG & SIGTV.FR - Un autre regard sur la géomatique

-

10:30

10:30 Exploring human appreciation and perception of spontaneous urban fauna in Paris, France

sur Cybergeo -

10:30

10:30 From "Bioeconomy Strategy" to the "Long-term Vision" of European Commission: which sustainability for rural areas?

sur Cybergeo -

10:30

10:30 Impact du numérique sur la relation entre les systèmes de gestion de crise et les citoyens, analyse empirique en Île-de-France et en Région de Bruxelles-Capitale

sur Cybergeo -

10:30

10:30 La fabrique publique/privée des données de planification urbaine en France : entre logique gestionnaire et approche territorialisée de la règle

sur Cybergeo -

10:30

10:30 Le territoire est toujours vivant. Une analyse transversale de la littérature sur un concept central de la géographie

sur Cybergeo -

10:30

10:30 Vers une transition des systèmes agricoles en France métropolitaine ? Une géographie contrastée et en mouvement (2010 et 2020)

sur Cybergeo -

10:30

10:30 Explorer la répartition spatiotemporelle des piqûres de tiques sur les humains en France : la température moyenne comme indicateur du risque acarologique

sur Cybergeo -

10:30

10:30 Bernard Lahire, 2023, Les structures fondamentales des sociétés humaines, Paris, La Découverte, Collection sciences sociales du vivant, 970 p.

sur Cybergeo -

10:30

10:30 Improving the perfomance of commercial mapping on the web : proposals for the web site of the French Forest Authority

sur Cybergeo -

10:30

10:30 Le principe de solidarité dans les politiques françaises de l’eau : originalité, fonctionnement et fragilités

sur Cybergeo

-

9:30

9:30 Appropriations de l’espace et répression du mouvement des Gilets jaunes à Caen

sur Mappemonde -

9:30

9:30 Les cartes dans l’analyse politique de l’espace : de l’outil à l’objet de recherche

sur Mappemonde -

9:30

9:30 Les stratégies cartographiques des membres de la plateforme Technopolice.fr

sur Mappemonde -

9:30

9:30 La végétalisation de Paris vue au travers d’une carte : une capitale verte ?

sur Mappemonde

Des étudiants de la Licence Pro ATU Géomatique et E-gouvernance des territoires de Le Mans Université ont réalisés un prototype de plan interactif de leur campus, dans le cadre d’un projet tutoré. Ils ont été soutenus par l’équipe éducation d’Esri France afin de prouver l’utilité de l’usage de la cartographie pour la gestion du site. La suite du projet devrait être à présent organisée avec les services concernés (communication, DATI, DSI, équipe signalétique, etc.). La prochaine promotion pourrait construire sur des bases solides un plan opérationnel en 2025 en vue de sa publication. Ce cas d’usage semble retenir l’attention d’autres universités françaises. Ainsi, l’Université de Rennes a mené un projet similaire et l’Université de Grenoble Alpes a envoyé ses étudiants de Licence Pro sur le terrain pour collecter le mobilier urbain du campus de Saint Martin d’Hères.

Des étudiants de la Licence Pro ATU Géomatique et E-gouvernance des territoires de Le Mans Université ont réalisés un prototype de plan interactif de leur campus, dans le cadre d’un projet tutoré. Ils ont été soutenus par l’équipe éducation d’Esri France afin de prouver l’utilité de l’usage de la cartographie pour la gestion du site. La suite du projet devrait être à présent organisée avec les services concernés (communication, DATI, DSI, équipe signalétique, etc.). La prochaine promotion pourrait construire sur des bases solides un plan opérationnel en 2025 en vue de sa publication. Ce cas d’usage semble retenir l’attention d’autres universités françaises. Ainsi, l’Université de Rennes a mené un projet similaire et l’Université de Grenoble Alpes a envoyé ses étudiants de Licence Pro sur le terrain pour collecter le mobilier urbain du campus de Saint Martin d’Hères.  Ces sites sont destinés à la réindustrialisation du territoire d’ici à 2030 promis par le ministre délégué chargé de l’industrie et de l’énergie, Roland Lescure. Parmi eux, trente sont des friches issues de la dynamique de recyclage de foncier d’ores et déjà disponibles. Les autres le seront d’ici 2027. Ces zones devraient faire de 3 à 340 hectares pour attirer toute sorte d’investisseurs, de la PME industrielle à la gigafactory. L’objectif est d’engager leur montée en gamme en termes de procédures et de préaménagement avec comme critère l’attractivité économique du lieu, prenant en compte sa localisation, sa proximité avec les axes de transport, son accessibilité et la présence d’un bassin d’emploi. L’objectif reste d’aménager le territoire durablement et de limiter les incidences environnementales telles que l’artificialisation des sols, même si ce dispositif est destiné à être exclu du dispositif ZAN...

Ces sites sont destinés à la réindustrialisation du territoire d’ici à 2030 promis par le ministre délégué chargé de l’industrie et de l’énergie, Roland Lescure. Parmi eux, trente sont des friches issues de la dynamique de recyclage de foncier d’ores et déjà disponibles. Les autres le seront d’ici 2027. Ces zones devraient faire de 3 à 340 hectares pour attirer toute sorte d’investisseurs, de la PME industrielle à la gigafactory. L’objectif est d’engager leur montée en gamme en termes de procédures et de préaménagement avec comme critère l’attractivité économique du lieu, prenant en compte sa localisation, sa proximité avec les axes de transport, son accessibilité et la présence d’un bassin d’emploi. L’objectif reste d’aménager le territoire durablement et de limiter les incidences environnementales telles que l’artificialisation des sols, même si ce dispositif est destiné à être exclu du dispositif ZAN...  Depuis un peu plus d’un an, la Ville d’Épinal a déployé un outil collaboratif à destination des citoyens. Baptisé « Signalé », il s’agitd’un formulaire Survey123 destiné aux signalements sur l’espace public. Il permet aux habitants d’indiquer la présence de défauts sur les équipements comme un trou sur une route, un lampadaire en panne, un panneau de signalisation endommagé, etc. Le mobilier urbain, les espaces verts, les graffitis, l’eau et l’assainissement ou encore les toilettes publiques peuvent ainsi faire l’objet d’un signalement. La plate-forme vient en support aux agents de la ville pour les aider à intervenir plus rapidement sur ces anomalies. Il suffit de poster une description du problème et d’ajouter les coordonnées géographiques sur une carte. Il est aussi possible d’envoyer une photo. Le traitement de la demande peut ensuite être suivi par la personne qui l’a émis.

Depuis un peu plus d’un an, la Ville d’Épinal a déployé un outil collaboratif à destination des citoyens. Baptisé « Signalé », il s’agitd’un formulaire Survey123 destiné aux signalements sur l’espace public. Il permet aux habitants d’indiquer la présence de défauts sur les équipements comme un trou sur une route, un lampadaire en panne, un panneau de signalisation endommagé, etc. Le mobilier urbain, les espaces verts, les graffitis, l’eau et l’assainissement ou encore les toilettes publiques peuvent ainsi faire l’objet d’un signalement. La plate-forme vient en support aux agents de la ville pour les aider à intervenir plus rapidement sur ces anomalies. Il suffit de poster une description du problème et d’ajouter les coordonnées géographiques sur une carte. Il est aussi possible d’envoyer une photo. Le traitement de la demande peut ensuite être suivi par la personne qui l’a émis.  Durant l’été, le festival international Constellations révèle le territoire messin et le transforme en musée à ciel ouvert. Il s’appuie sur l’art numérique, lui faisant revêtir toutes ses formes et tous ses angles.

Durant l’été, le festival international Constellations révèle le territoire messin et le transforme en musée à ciel ouvert. Il s’appuie sur l’art numérique, lui faisant revêtir toutes ses formes et tous ses angles.

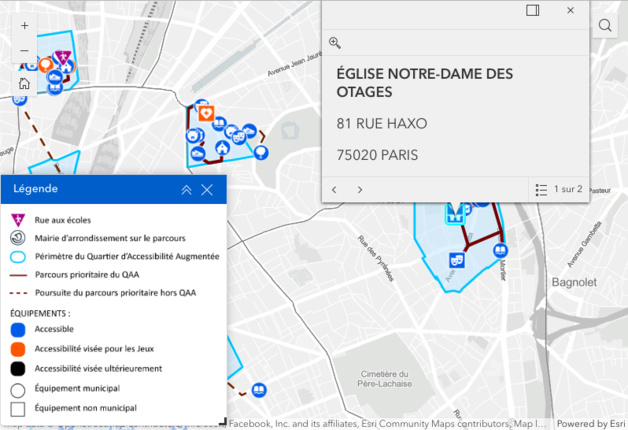

Le 20e arrondissement de la Ville de Paris a développé un « Quartier à accessibilité augmentée » (QAA), à Saint- Fargeau précisément. Un QAA est une zone prévue pour rendre accessibles à tous les services essentiels tels que l’hébergement, les sports, la santé, les commerces, les écoles ou la culture. L’idée est d’offrir des zones de déplacements adaptées à tout âge et toute situation dans lesquelles tous les services sont réunis dans un rayon de 15 minutes ; cela que les personnes soient équipées de poussettes, qu’elles soient à mobilité réduite ou en situation de handicap. Il s’agit d’une démarche déployée en vue des Jeux olympiques et paralympiques et au profit des citoyens sur le long terme. Ce type de quartier comprend des aménagements, comme le retrait des objets obsolètes et obstacles, réfection des passages piétons, abaissement des trottoirs. Il inclut aussi le déploiement de modules sonores pour les passages piétons, la création d’une centaine de stationnements PMR et l’adaptation de toutes les lignes de bus.

Le 20e arrondissement de la Ville de Paris a développé un « Quartier à accessibilité augmentée » (QAA), à Saint- Fargeau précisément. Un QAA est une zone prévue pour rendre accessibles à tous les services essentiels tels que l’hébergement, les sports, la santé, les commerces, les écoles ou la culture. L’idée est d’offrir des zones de déplacements adaptées à tout âge et toute situation dans lesquelles tous les services sont réunis dans un rayon de 15 minutes ; cela que les personnes soient équipées de poussettes, qu’elles soient à mobilité réduite ou en situation de handicap. Il s’agit d’une démarche déployée en vue des Jeux olympiques et paralympiques et au profit des citoyens sur le long terme. Ce type de quartier comprend des aménagements, comme le retrait des objets obsolètes et obstacles, réfection des passages piétons, abaissement des trottoirs. Il inclut aussi le déploiement de modules sonores pour les passages piétons, la création d’une centaine de stationnements PMR et l’adaptation de toutes les lignes de bus.  Capitale des Pays de la Loire, Nantes est le coeur de la 6e métropole de France, avec plus de 670.000 habitants. Avec sa qualité de vie, son dynamisme économique et son effervescence culturelle, la métropole nantaise accueille chaque année de nouveaux arrivants. Pour accompagner cette croissance et faire face à ses nombreux défis, la métropole mise sur le numérique, tout en adoptant une démarche résolument responsable. Cette politique est détaillée dans plusieurs documents-cadres et plans d ’action, dont une « charte métropolitaine de la donnée » rédigée en 2019. Elle fixe un cadre éthique pour protéger les citoyens, les agents de la collectivité et réguler l’utilisation des données sur le territoire. Ce cadre très structuré a permis de mettre en place un SIG particulièrement complet et intégré.

Capitale des Pays de la Loire, Nantes est le coeur de la 6e métropole de France, avec plus de 670.000 habitants. Avec sa qualité de vie, son dynamisme économique et son effervescence culturelle, la métropole nantaise accueille chaque année de nouveaux arrivants. Pour accompagner cette croissance et faire face à ses nombreux défis, la métropole mise sur le numérique, tout en adoptant une démarche résolument responsable. Cette politique est détaillée dans plusieurs documents-cadres et plans d ’action, dont une « charte métropolitaine de la donnée » rédigée en 2019. Elle fixe un cadre éthique pour protéger les citoyens, les agents de la collectivité et réguler l’utilisation des données sur le territoire. Ce cadre très structuré a permis de mettre en place un SIG particulièrement complet et intégré.