Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

5677 éléments (351 non lus) dans 55 canaux

Dans la presse

(88 non lus)

Dans la presse

(88 non lus)

Du côté des éditeurs

(17 non lus)

Du côté des éditeurs

(17 non lus)

Toile géomatique francophone

(246 non lus)

Toile géomatique francophone

(246 non lus)

Dans la presse (88 non lus)

Dans la presse (88 non lus)

-

sur L’IA est un outil de démoralisation des travailleurs

Publié: 8 April 2025, 7:00am CEST par Hubert Guillaud

« Le potentiel révolutionnaire de l’IA est d’aider les experts à appliquer leur expertise plus efficacement et plus rapidement. Mais pour que cela fonctionne, il faut des experts. Or, l’apprentissage est un processus de développement humain désordonné et non linéaire, qui résiste à l’efficacité. L’IA ne peut donc pas le remplacer », explique la sociologue Tressie McMillan Cottom dans une tribune au New York Times. « L’IA recherche des travailleurs qui prennent des décisions fondées sur leur expertise, sans institution qui crée et certifie cette expertise. Elle propose une expertise sans experts ». Pas sûr donc que cela fonctionne.

Mais, si ce fantasme – qui a traversé toutes les technologies éducatives depuis longtemps – fascine, c’est parce qu’il promet de contrôler l’apprentissage sans en payer le coût. Plus que de réduire les tâches fastidieuses, l’IA justifie les réductions d’effectifs « en demandant à ceux qui restent de faire plus avec moins ». La meilleure efficacité de l’IA, c’est de démoraliser les travailleurs, conclut la sociologue.

-

sur Digues et “nature”. Résultats d’une enquête sur la perception des digues et de leur évolution en France au XXIe siècle

Publié: 7 April 2025, 11:30am CEST par Lydie Goeldner-Gianella

Le paradigme classique de la gestion des digues est centré sur la défense contre les eaux. Souhaitant proposer une vision multifonctionnelle et durable de ces ouvrages, nous avons retenu sept tronçons de digues maritimes et fluviales en France. Nous présentons ici une enquête menée auprès de 828 riverains et usagers de digues pour analyser leur perception et représentations. Si la fonction défensive de ces ouvrages demeure bien connue, la perception des digues urbaines et rurales diverge en matière de connaissance des digues et de liens entre digues et nature. Les enquêtés mettent en avant la naturalité des digues – objet pourtant artificiel. Cinq scénarios d’évolution des digues à l’avenir ont été proposés aux enquêtés : renforcer les digues, les ouvrir/abaisser, les végétaliser davantage, les aménager davantage, ou ne rien y changer. Le scénario le plus souhaité est celui d’un maintien à l’identique et le moins refusé, celui de la végétalisation des digues ; le renforcement des di...

-

sur Postal horse relays and roads in France, from the 17th to the 19th centuries

Publié: 7 April 2025, 11:30am CEST par Nicolas Verdier

La base de données présentée ici résulte d’un travail collectif mené depuis une vingtaine d’années, réunissant géographes, géohistoriens et géomaticiens, autour d’un des premiers réseaux de transport rapide créé en France, celui de la poste à cheval. Les objectifs de recherche ont varié au cours des années, comme nous le montrons dans cet article, mais se sont constamment appuyés sur l’exploitation de la saisie du réseau à différentes dates dans un système d’information géographique (SIG). La base fournit les informations permettant la modélisation du réseau des routes de la poste à cheval et leur relais (où les montures étaient changées) sur ce SIG Historique, de 1632 à 1833, à sept dates. Quatre fichiers peuvent être téléchargés : la localisation et le nom des relais et des communes actuelles dans lesquels ils sont localisés en 1632, 1708, 1733, 1758, 1783, 1810 et 1833 (numérisés à partir d’une carte de 1632 et des Livres de Poste) ; les routes numérisées selon une distance à vol...

-

sur Crise des déchets et incinération sauvage à Sfax (Tunisie) : une campagne de mesures dédiée à l’évaluation de la pollution de l’air par les particules ?

Publié: 7 April 2025, 11:30am CEST par Hamdi Euchi

La défaillance de la politique de gestion des déchets à Sfax s’est traduite par la prolifération des décharges spontanées, principalement en 2021 et 2022. En dépit de son extrême nocivité sur la santé humaine, l’incinération des déchets à ciel ouvert est devenue une pratique illégale courante par une grande partie de la population, suite à l’échec de l’action publique. Cette pratique est à l’origine de la pollution aux particules. Cet article analyse la médiatisation de la crise de la gestion des déchets à Sfax, et étudie la variation spatio-temporelle de la pollution aux particules PM10 et PM2,5 dans l’agglomération de Sfax, à partir de campagnes de mesures semi-itinérantes dans une trentaine de décharges incinérées. Il est montré que l’incinération des déchets à ciel ouvert provoque de très fortes concentrations de pollution aux PM10 et PM2,5, dépassant de très loin les normes en vigueur de la protection de la santé humaine recommandées par la Tunisie et l’Organisation Mondiale de...

-

sur Nepthys Zwer, 2024, Pour un spatio-féminisme, De l'espace à la carte, Paris, La découverte, 216 p.

Publié: 7 April 2025, 11:30am CEST par Justine Collin

Avec pour ambition d’inscrire son ouvrage Pour un spatio-féminisme, De l'espace à la carte (2024) au sein de la quatrième vague féministe (Dagorn, 2011), Nepthys Zwer propose de déconstruire les discours spatiaux genrés. Richement illustré par les photographies et cartes de l’autrice ou des acteur.rice.s rencontré.e.s, l’ouvrage selon Zwer n’est pas à classer avec les manuels d’épistémologie et de concepts géographiques. Nourri par les théories féministes, il offre aux géographes spécialistes du genre un état des lieux autour des pratiques spatiales genrées, tandis que d’autres y trouveront une première entrée pour comprendre les racines des comportements sexués et des usages différenciés de l’espace.

À travers les ateliers animés par l’autrice et la méthode de la contre-cartographie ("contre-carte", Peluso, 1995), Zwer mobilise plusieurs cas d’études en milieu urbain, en France et à l’étranger. Le choix de cette méthode permet de rendre compte d’espaces et/ou de phénomènes absents d...

-

sur À la recherche de données : Nature et flux des informations au fondement des politiques de gestion du sanglier urbain. L’exemple bordelais

Publié: 7 April 2025, 11:30am CEST par Carole Marin

La nature en ville abrite une large biodiversité. Tandis que la présence de certaines espèces est bienvenue, d’autres s’y sont installées sans y avoir été invitées. C’est le cas du sanglier. Le défi de gestion posé par la grande faune urbaine est écologique, il est aussi culturel, politique et éthique. Cette étude, motivée par l'incertitude générale concernant les enjeux socio-écologiques de la coexistence avec le sanglier urbain et les solutions à y apporter, explore et analyse les informations qui fondent les politiques de gestion de l'espèce. La démarche s’appuie sur une enquête de terrain conduite dans la Métropole de Bordeaux, visant à suivre le cheminement de l’information dans le réseau des acteurs territoriaux. L’objectif de la démarche est double : i) recueillir et analyser les données existantes relatives au sanglier urbain, aux problèmes générées par la coexistence avec l’espèce en ville et aux dispositifs de gestion en place, et ii) modéliser les flux d’informations entr...

-

sur Enfrichement des côtes rocheuses : analyse de la dynamique du paysage et de la végétation

Publié: 7 April 2025, 10:30am CEST par Pierre Libaud

Cette étude porte sur deux secteurs littoraux enfrichés de la commune de Moëlan-sur-Mer soumis à un projet de remise en culture. Il s’agit ici d’interroger l’hétérogénéité paysagère et la diversité spécifique de ces espaces enfrichés. L’analyse des dynamiques d’ouverture et de fermeture du paysage depuis les années 1950 montre une pluralité de rythmes et de trajectoires selon les zones, l’action humaine et les contraintes écologiques. Les résultats font ressortir une diversité des formes végétales et des trajectoires, remettant en cause une uniformisation du paysage des friches littorales.

-

sur Geodatadays 2023

Publié: 7 April 2025, 10:30am CEST par Christine Plumejeaud-Perreau

Les GéoDataDays constituent un évènement national indépendant dédié à la géographie numérique en France. Ces rencontres annuelles sont organisées par l’AFIGÉO et DécryptaGéo depuis cinq ans, en partenariat avec une plateforme régionale d’information géographique et des collectivités territoriales. Au cœur de cet évènement, le Groupement de recherche CNRS MAGIS, consacré à la géomatique, co-organise depuis quatre ans un concours, les CHALLENGES GEODATA, qui vise à faire connaître et à récompenser les innovations du monde académique par un jury indépendant et multipartite (recherche, collectivités et services de l’État, industriels). Les domaines d’application sont très variés et touchent à la collecte, au traitement, à l’analyse et à la visualisation de données géographiques (ou géolocalisées). Les six critères retenus par le jury permettent de comparer et d’évaluer ces propositions souvent hétérogènes : originalité, public ciblé, potentiel de dissémination, qualité et justesse des m...

-

sur MapDraw. Un outil libre d’annotation de cartes en ligne

Publié: 7 April 2025, 10:30am CEST par Justin Berli

Les enquêtes et questionnaires reposent souvent sur l’utilisation de supports papier, et les cartes ne font pas exception. En effet, ces dernières permettent une grande flexibilité, notamment en termes d’annotations, de dessins, etc. Mais la conversion et l’exploitation des données ainsi récoltées dans un SIG peuvent s’avérer fastidieuses, et cela peut bien souvent limiter la quantité de données récoltée. Cet article présente un outil libre en ligne, MapDraw, permettant de prendre des notes sur une carte interactive et d’exporter ces données dans un format utilisable par un SIG.

-

sur HedgeTools : un outil d’analyse spatiale dédié à l’évaluation de la multifonctionnalité des haies

Publié: 7 April 2025, 10:30am CEST par Gabriel Marquès

Les haies jouent des rôles clés dans les paysages agricoles, mais leur caractérisation automatique par analyse spatiale est complexe. Dans cet article, nous décrivons les principales fonctionnalités d’un outil open source — HedgeTools — qui permet de calculer une diversité d’indicateurs contribuant à évaluer la multifonctionnalité des haies. Il permet de créer la géométrie des objets, de les redécouper en fonction de divers critères et d’extraire leurs caractéristiques à différents niveaux d’agrégation. HedgeTools vise à faciliter la gestion et la préservation des haies en permettant d’évaluer leur état et leurs fonctions dans les paysages, avec des perspectives d’amélioration et d’extension de ses fonctionnalités.

-

sur Visualisation de données issues des réseaux sociaux : une plateforme de type Business Intelligence

Publié: 7 April 2025, 10:30am CEST par Maxime Masson

TextBI est un tableau de bord interactif destiné à visualiser des indicateurs multidimensionnels sur de grandes quantités de données multilingues issues des réseaux sociaux. Il cible quatre dimensions principales d’analyse : spatiale, temporelle, thématique et personnelle, tout en intégrant des données contextuelles comme le sentiment et l’engagement. Offrant plusieurs modes de visualisation, cet outil s’insère dans un cadre plus large visant à guider les diverses étapes de traitement de données des réseaux sociaux. Bien qu’il soit riche en fonctionnalités, il est conçu pour être intuitif, même pour des utilisateurs non informaticiens. Son application a été testée dans le domaine du tourisme en utilisant des données de Twitter (aujourd’hui X), mais il a été conçu pour être générique et adaptable à de multiples domaines. Une vidéo de démonstration est accessible au lien suivant : [https:]]

-

sur Atlas du développement durable. Un monde en transition, Autrement, 2022

Publié: 7 April 2025, 10:30am CEST par Marie-Laure Trémélo

L’Atlas du développement durable, proposé par Yvette Veyret et Paul Arnould est paru aux éditions Autrement en mars 2022 ; il s’agit d’une 2e édition, mettant à jour partiellement la première, parue deux ans auparavant.

Les auteurs sont tous deux professeurs émérites, de l’université Paris-Nanterre pour Yvette Veyret et de l’École normale supérieure de Lyon pour Paul Arnould. Les représentations graphiques et cartographiques ont été réalisées par Claire Levasseur, géographe-cartographe indépendante.

Après une introduction qui définit le développement durable dans ses composantes écologique, économique et sociale et présente les nouveaux objectifs définis dans l’Agenda pour 2030 (adopté lors du sommet des Nations Unies de 2015), cet atlas est divisé en trois parties : en premier lieu, un bilan mondial, puis les réponses globales apportées pour assurer un développement durable à l’échelle du globe, enfin les solutions proposées à l’échelle nationale française. Chaque partie est composée...

-

sur La géographie des chefs étoilés : du rayonnement international a l’ancrage territorial

Publié: 7 April 2025, 10:30am CEST par Jean-Charles Édouard

Ce texte de rubrique se situe en complémentarité de l’article sur la géographie des restaurants étoilés et s’intéresse plus particulièrement aux hommes et aux femmes qui se cachent derrière les étoiles, et donc aux « grands chefs ». Pour des raisons liées aux informations dont on peut disposer sur les sites spécialisés ou dans la littérature, ainsi qu’au nombre bien trop important de chefs qui ont une ou deux étoiles, ce qui suit concerne principalement les chefs triplement étoilés, soit trente personnes en 2021.

À partir de l’analyse de leurs lieux d’exercice et/ou d’investissement actuels, on peut dessiner une « géographie » des chefs étoilés et les diviser en trois groupes : les internationaux, les régionaux et les locaux. De même, l’observation de leur plus ou moins grand investissement dans la vie socio-économique locale, ainsi que leurs circuits d’approvisionnement nous permettront d’approcher leur rôle dans les dynamiques de développement local.

En ce qui concerne l’analyse du ...

-

sur Mappa naturae, 2023

Publié: 7 April 2025, 10:30am CEST par Sylvain Guyot

Le collectif Stevenson, du nom de Robert Louis Stevenson, écrivain écossais et grand voyageur, connu dans le monde entier pour son roman L’Ile au trésor, publié en 1883, est composé de six auteurs spécialisés, peu ou prou, dans de multiples formes d’études des cartographies et de leurs usages à travers les époques : Jean-Marc Besse, philosophe et historien, Milena Charbit, architecte et artiste, Eugénie Denarnaud, paysagiste et plasticienne, Guillaume Monsaingeon, philosophe et historien, Hendrik Sturm, artiste marcheur (décédé le 15 août 2023), et Gilles A. Tiberghien, philosophe en esthétique. Ce collectif a déjà publié chez le même éditeur, en 2019 Mappa Insulae et, en 2021, Mappa Urbis. À l’image de leurs deux dernières parutions, Mappa Naturae se présente comme un recueil d’images cartographiques sélectionnées pour leur esthétique, leur ingéniosité ou, parfois, leur nouveauté. Le collectif ne donne pas d’informations synthétisées sur la provenance concrète des cartes. Les sourc...

-

sur Représenter la centralité marchande : la coloration marchande et ses usages

Publié: 7 April 2025, 10:30am CEST par Nicolas Lebrun

La centralité marchande est le potentiel marchand détenu par un lieu. Elle peut être générée par différents types de configurations spatiales (les modes de centralité). L’article propose de voir comment représenter graphiquement cette centralité, afin de bien appréhender ses dimensions qualitatives. Nous qualifions de coloration marchande la proportion entre les différents modes de centralité : l’outil graphique proposé repose sur la couleur, entendue comme élément facilitant de la compréhension des situations spatiales. L’utilisation d’un même procédé graphique permettra de mieux discerner potentiel marchand d’un espace et usages réels (les modes d’usages) de celui-ci. Cet outil devrait permettre une meilleure prise en compte de la diversité des situations marchandes dans la production des cadres de l’urbanisme commercial.

-

sur La géohistoire du royaume d’Abomey (1645-1894), dans le récit national et dans la formation territoriale du Bénin contemporain

Publié: 7 April 2025, 10:30am CEST par Jean Rieucau

La géohistoire du royaume d’Abomey, appuyé sur le groupe humain, la langue des Fon et sur la religion vaudou, couvre trois siècles et demi (1645 à 1894). Ce petit État-nation guerrier, esclavagiste, partenaire des négriers européens (Français, Portugais, Anglais, Danois), perd sa souveraineté à la fin du XIXe siècle, en intégrant la colonie française du Dahomey. Il abrite une des civilisations les plus brillantes de l’Afrique subsaharienne, qui fonde le soft power culturel (restitutions de l’art africain, mémoire de l’esclavage, constructions de musées, tourisme culturel), de l’actuelle République du Bénin.

-

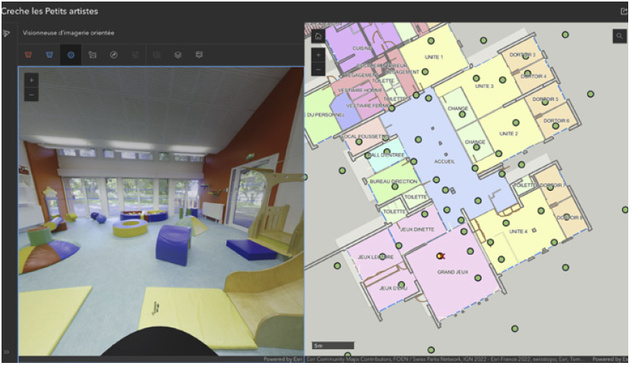

sur Grand Belfort immersif

Publié: 7 April 2025, 7:44am CEST par la rédaction SIGMAG & SIGTV.FR

Dans sa démarche de création d’un jumeau numérique du territoire, la Communauté d’agglomération du Grand Belfort (90) a acquis des données sur l’extérieur des bâtiments. Au-delà de cette vue, elle ambitionne également de capturer l’intérieur de certains établissements publics. Le premier bâtiment bénéficiant de cette couverture est le multiaccueil « Les petits artistes » dans le quartier des Glacis du château. À l’aide du BIM mêlé à l’imagerie orientée et ArcGIS Indoors, une vue immersive est proposée. Elle permet de visiter les lieux à distance. Dans ce cas, allier le BIM et les vues immersives contribue à l’attractivité de cet établissement. C’est un outil de communication destiné aux parents de la CA. La piscine de Belfort et le théâtre Grrranit disposent aussi de leur numérisation pour des usages plus orientés sur la maintenance, le suivi des réseaux ou des travaux.

Dans sa démarche de création d’un jumeau numérique du territoire, la Communauté d’agglomération du Grand Belfort (90) a acquis des données sur l’extérieur des bâtiments. Au-delà de cette vue, elle ambitionne également de capturer l’intérieur de certains établissements publics. Le premier bâtiment bénéficiant de cette couverture est le multiaccueil « Les petits artistes » dans le quartier des Glacis du château. À l’aide du BIM mêlé à l’imagerie orientée et ArcGIS Indoors, une vue immersive est proposée. Elle permet de visiter les lieux à distance. Dans ce cas, allier le BIM et les vues immersives contribue à l’attractivité de cet établissement. C’est un outil de communication destiné aux parents de la CA. La piscine de Belfort et le théâtre Grrranit disposent aussi de leur numérisation pour des usages plus orientés sur la maintenance, le suivi des réseaux ou des travaux.

+ d'infos :

an.fr

-

sur De la concentration à la fusion

Publié: 4 April 2025, 7:36am CEST par Hubert Guillaud

Les acteurs de l’IA générative intègrent de plus en plus les plateformes de contenus, à l’image de xAI de Musk qui vient de racheter X/Twitter, rappelle Ameneh Dehshiri pour Tech Policy Press. « Les entreprises technologiques ne se contentent plus de construire des modèles, elles acquièrent les infrastructures et les écosystèmes qui les alimentent ». Nous sommes désormais confrontés à des écosystèmes de plus en plus intégrés et concentrés…

-

sur Ecrire, c’est penser

Publié: 4 April 2025, 7:34am CEST par Hubert Guillaud

« L’écriture est l’activité la plus essentielle d’un scientifique, car sans écriture, il n’y a pas de réflexion ». Dennis Hazelett

-

sur Pour rendre la participation effective, il faut mesurer les changements qu’elle produit

Publié: 4 April 2025, 7:00am CEST par Hubert Guillaud

Pour TechPolicy Press, le consultant Jonathan van Geuns se moque de l’illusion de la participation dont s’est paré le Sommet pour l’action sur l’IA parisien. « La gouvernance de l’IA aujourd’hui n’est qu’une vaste mise en scène, un théâtre parisien où les acteurs – dirigeants d’entreprises, politiques et technocrates – déclament d’une voix posée leur discours sur la responsabilité, créant l’illusion d’une décision collective ». En réalité, les mécanismes de gouvernance restent imperméables aux voix qu’ils prétendent intégrer. Entreprises, ONG et gouvernements ont bien compris l’efficacité d’un engagement de façade. Les comités d’éthique sur l’IA, les tables rondes des parties prenantes, les forums publics ne sont pas les fondements d’une démocratie mais son simulacre. Simulacre d’inclusion où la contestation est réduite à son expression la plus polie. Ces dispositifs « créent l’illusion d’un contrôle démocratique tout en permettant à ceux qui les mettent en œuvre, de garder la mainmise sur les résultats ». Ce n’est pas de la gouvernance, seulement un décor.

Pour que les audits et les évaluations modifient réellement les rapports de force, ils doivent d’abord s’extraire du carcan d’opacité qui les enserre. « Actuellement, ces processus servent davantage à absorber qu’à transformer : ils recueillent les critiques, les diluent en rapports inoffensifs, puis les présentent comme preuve qu’une action a été menée. Ils fonctionnent comme des vitrines de l’engagement, invitant le public à admirer les mécanismes complexes de la gouvernance de l’IA tout en préservant les structures de pouvoir existantes de toute remise en cause ».

Les structures mise en place pour contester le pouvoir servent de rempart à la contestationLe problème n’est pas tant que la participation manque de force, mais que l’écosystème a été conçu pour la neutraliser, sollicitant des critiques tout en gardant le monopole de leur interprétation. « On finance des conseils consultatifs tout en se réservant le droit d’ignorer leurs recommandations. On réunit des comités d’éthique pour les dissoudre dès que ce qu’ils veulent examiner devient gênant. Ce n’est pas un échec de la participation, c’est son détournement. Les structures qui devraient être mises en place pour contester le pouvoir servent finalement de rempart contre sa contestation ».

Cette situation est d’autant plus problématique que nous manquons d’outils structurés pour évaluer si la participation à la gouvernance de l’IA est véritablement significative. On compte le nombre de « parties prenantes » consultées sans mesurer l’impact réel de leurs contributions. On comptabilise les forums organisés sans examiner s’ils ont abouti à des changements concrets. Cette focalisation sur la forme plutôt que sur le fond permet au « participation-washing » de prospérer. Un constat très proche de celui que dressaient Manon Loisel et Nicolas Rio dans leur livre, Pour en finir avec la démocratie participative (Textuel, 2024).

Changer les indicateurs de la participation : mesurer les changements qu’elle produit !Pour Jonathan van Geuns, la participation doit se doter d’un cadre plus rigoureux pour favoriser l’inclusivité, la redistribution du pouvoir, la construction de la confiance, l’impact et la pérennité. Les indicateurs doivent évoluer du procédural vers le structurel. La vraie question n’est pas de savoir si différentes parties prenantes ont été invitées à s’exprimer, « mais de savoir si leur participation a redistribué le pouvoir, modifié les processus décisionnels et engendré des changements concrets ! »

La participation ne peut se réduire à un exercice consultatif où les communautés concernées peuvent exprimer leurs inquiétudes sans avoir le pouvoir d’agir, comme nous le constations dans notre article sur l’absence de tournant participatif de l’IA. Pour van Geuns, « la participation doit être ancrée structurellement, non comme une fonction consultative mais comme une fonction souveraine », comme l’exprimait Thomas Perroud dans son livre, Services publics et communs (Le Bord de l’eau, 2023). Cela pourrait se traduire par des conseils de surveillance publique ayant un droit de veto sur les applications, des organismes de régulation où les représentants disposent d’un réel pouvoir décisionnel, et des mécanismes permettant aux groupes affectés de contester directement les décisions basées sur l’IA ou d’exiger le retrait des systèmes perpétuant des injustices.

« L’audit des systèmes d’IA ne suffit pas ; nous devons pouvoir les démanteler. Les cadres de supervision de l’IA doivent inclure des mécanismes de refus, pas uniquement de contrôle. Quand un audit révèle qu’un algorithme est structurellement discriminatoire, il doit avoir la force juridique de le désactiver. Quand un système nuit de façon disproportionnée aux travailleurs, locataires, réfugiés ou citoyens, ces communautés ne doivent pas seulement être consultées mais avoir le pouvoir d’en stopper le déploiement. La participation ne doit pas se contenter de documenter les préjudices ; elle doit les interrompre. »

En fait, estime le consultant, « la gouvernance de l’IA n’est plus simplement un terrain de contestation mais un exemple flagrant de capture par les entreprises. Les géants de la tech agissent comme des législateurs privés, élaborant les cadres éthiques qui régissent leur propre conduite. Ils prônent l’ouverture tout en protégeant jalousement leurs algorithmes, parlent d’équité tout en brevetant des biais, évoquent la sécurité tout en exportant des technologies de surveillance vers des régimes autoritaires. Dans ce contexte, tout cadre qui n’aborde pas le déséquilibre fondamental des pouvoirs dans le développement et le déploiement de l’IA n’est pas seulement inefficace ; il est complice ». Les audits et évaluations participatifs doivent donc être juridiquement contraignants et viser non seulement à diversifier les contributions mais à redistribuer le contrôle et rééquilibrer les pouvoirs.

« La gouvernance doit être continue, adaptative et structurellement résistante à l’inertie et au désintérêt, en garantissant que les communautés restent impliquées dans les décisions tout au long du cycle de vie d’un système d’IA. Cela implique également la mise en place de financements pérennes et de mandats légaux pour les structures participatives ».

« La crise de la gouvernance de l’IA ne se limite pas à des systèmes d’IA défectueux. Elle révèle la mainmise des entreprises sur les processus de gouvernance. L’enjeu n’est pas simplement d’accroître la participation, mais de s’assurer qu’elle conduise à une véritable redistribution du pouvoir. Sans cadres d’évaluation solides, mécanismes d’application clairs et remise en question fondamentale de ceux qui définissent les priorités de la gouvernance de l’IA, la participation restera une vitrine vide, conçue pour afficher une transparence et une responsabilité de façade tout en préservant les structures mêmes qui perpétuent les inégalités ».

-

sur La Californie contre la tarification algorithmique

Publié: 3 April 2025, 7:00am CEST par Hubert Guillaud

Les législateurs californiens viennent de proposer pas moins de 5 projets de loi contre la tarification algorithmique, … alors que celle-ci envahit tous les secteurs de l’économie numérique (voir notre dossier : Du marketing à l’économie numérique, une boucle de prédation), rapporte The Markup. Et ce alors que les témoignages sur les problèmes que posent la personnalisation des tarifs ne cessent de remonter, par exemple avec des tarifs de réservation d’hôtel qui augmentent selon le lieu d’où vous vous connectez, ou encore des tarifs pour des services de chauffeurs plus élevés pour certains clients que pour d’autres. C’est ce que montre la récente étude du chercheur Justin Kloczko pour Consumer Watchdog, une association de défense des consommateurs américains. Kloczko rappelle que si en magasin les prix étaient différents pour chacun, il y aurait des émeutes, or, sur Amazon, le prix moyen d’un produit change environ toutes les 10 minutes. Et le chercheur de défendre “un droit à des prix standardisés et des garanties contre la tarification de surveillance”. L’association de consommateurs estime que les entreprises devraient indiquer sur leurs sites si des informations personnelles sont utilisées pour déterminer les prix et lesquelles. Certaines données devraient être interdites d’utilisation, notamment la géolocalisation, l’historique d’achat et bien sûr les données personnelles…

Selon The Markup, les projets de loi sur l’IA proposés par les législateurs californiens se concentrent sur des questions de consommation courante et notamment les prix abusifs, estime Vinhcent Le qui a longtemps été à l’Agence de protection de la vie privée des consommateurs et qui vient de rejoindre l’ONG Tech Equity. Les projets de loi visent par exemple à interdire l’utilisation d’algorithmes personnalisant les prix en fonction de caractéristiques perçues ou de données personnelles ou de les utiliser pour fixer le montant des biens locatifs, ou encore des interdictions pour modifier les prix des produits en ligne par rapport à ceux vendus en magasin.

-

sur En thérapie… avec les chatbots

Publié: 2 April 2025, 7:00am CEST par Hubert Guillaud

Maytal Eyal est psychologue et écrivaine. Dans une tribune pour Time Magazine, elle constate que l’IA générative est en train de concurrencer son travail. De nombreuses personnes utilisent déjà les chatbots pour discuter de leurs problèmes et de leurs difficultés. Peut-être que l’IA peut contribuer à rendre la thérapie plus facilement accessible à tous, d’autant que les mauvais thérapeutes sont nombreux et que l’accès aux soins est difficile et coûteux, s’interroge-t-elle. Aux Etats-Unis, la moitié des adultes souffrant de problèmes de santé mentale ne reçoivent pas le traitement dont ils ont besoin.

En convainquant les gens que nos difficultés émotionnelles – de la tristesse au chagrin en passant par les conflits familiaux – nécessitaient une exploration professionnelle, Freud a contribué à déplacer la guérison émotionnelle de la sphère communautaire et spirituelle qui l’ont longtemps pris en charge, vers l’intimité du cabinet du thérapeute, rappelle-t-elle. “Ce qui était autrefois considéré comme des manquements moraux honteux est devenu un problème humain courant, qui pouvait être compris scientifiquement avec l’aide d’un professionnel. Mais il a également transformé la guérison en une entreprise plus solitaire, coupée des réseaux communautaires qui ont longtemps été au cœur du soutien humain”.

Dans un avenir proche, la thérapie par IA pourrait pousser le modèle individualisé de Freud à son extrême au risque que nos problèmes psychiques soient adressés sans plus aucun contact humain.

Des IA bien trop complaisantesA première vue, ce pourrait être une bonne chose. Ces thérapeutes seront moins cher et disponibles 24h/24. Les patients ressentiraient moins la peur du jugement avec des chatbots qu’avec des humains, moins de frictions donc.

Mais, c’est oublier que la friction est bien souvent au cœur de la thérapie : “C’est dans le malaise que le vrai travail commence”. Alors que les compagnons IA deviennent source de soutien émotionnel par défaut – pas seulement en tant que thérapeutes, mais aussi en tant qu’amis, confidents, complices ou partenaires amoureux, c’est-à-dire désormais ceux avec qui l’on discute et qui sont capables de répondre à nos discussions, qui nous donnent l’impression d’être au plus proche de nous et qui bien souvent nous font croire qu’ils nous connaissent mieux que quiconque – “nous risquons de devenir de plus en plus intolérants aux défis qui accompagnent les relations humaines”.

“Pourquoi lutter contre la disponibilité limitée d’un ami alors qu’une IA est toujours là ? Pourquoi gérer les critiques d’un partenaire alors qu’une IA a été formée pour offrir une validation parfaite ? Plus nous nous tournons vers ces êtres algorithmiques parfaitement à l’écoute et toujours disponibles, moins nous risquons d’avoir de la patience pour le désordre et la complexité des relations humaines réelles”.

Or, “les défis mêmes qui rendent les relations difficiles sont aussi ce qui leur donne du sens. C’est dans les moments d’inconfort, lorsque nous naviguons dans des malentendus ou que nous réparons les dégâts après un conflit, que l’intimité grandit. Ces expériences, que ce soit avec des thérapeutes, des amis ou des partenaires, nous apprennent à faire confiance et à nous connecter à un niveau plus profond. Si nous cessons de pratiquer ces compétences parce que l’IA offre une alternative plus fluide et plus pratique, nous risquons d’éroder notre capacité à nouer des relations significatives”.

“L’essor de la thérapie par l’IA ne se résume pas seulement au remplacement des thérapeutes. Il s’agit de quelque chose de bien plus vaste : la façon dont nous, en tant que société, choisissons d’interagir les uns avec les autres. Si nous adoptons l’IA sans friction au détriment de la complexité des relations humaines réelles, nous ne perdrons pas seulement le besoin de thérapeutes, nous perdrons la capacité de tolérer les erreurs et les faiblesses de nos semblables.” Le risque n’est pas que les thérapeutes deviennent obsolètes, le risque c’est que nous le devenions tous.

L’association des psychologues américains vient justement d’émettre une alerte à l’encontre des chatbots thérapeutes. Programmés pour renforcer, plutôt que de remettre en question la pensée des utilisateurs, ils pourraient inciter des personnes vulnérables à se faire du mal ou à en faire aux autres, rapporte le New York Times. Des adolescents ayant discuté avec des chatbots se présentant comme psychologues sur Character.ai se sont suicidés ou sont devenus violents. En fait, le problème de ces outils, c’est qu’ils œuvrent à nous complaire pour mieux nous manipuler. « Les robots ne remettent pas en question les croyances des utilisateurs même lorsqu’elles deviennent dangereuses pour eux ou pour leur proches, au contraire, ils les encouragent ». Si les entreprises ont introduit des alertes pour rappeler aux utilisateurs qu’ils n’interagissent pas avec de vrais psychologues, ces avertissements ne sont pas suffisants pour briser “l’illusion de la connexion humaine”. L’association a demandé à la Federal Trade Commission d’ouvrir une enquête sur ces chatbots. Du côté des entreprises d’IA, le discours consiste à dire que les outils vont s’améliorer et que compte tenu de la grave pénurie de prestataires de soins de santé mentale, il est nécessaire d’améliorer les outils plutôt que de les contenir. Mais cette réponse en forme de promesse ne dit rien ni des limites intrinsèques de ces machines, ni du contexte de leurs déploiement, ni de la manière dont on les conçoit.

Comme nous le disions, la qualité des systèmes et de leurs réponses ne suffit pas à les évaluer : “l’état du système de santé, ses défaillances, ses coûts, la disponibilité du personnel… sont autant de facteurs qui vont appuyer sur les choix à recourir et à déployer les outils, mêmes imparfaits”. Et les outils apportent avec eux leur monde, comme l’explique la chercheuse Livia Garofalo. Garofalo a publié une étude pour Data & Society sur la téléthérapie et les soins de santé mentale. Elle revient pour le magazine de l’Association psychanalytique américaine sur les enjeux des transformations du travail à distance qui s’est beaucoup développée depuis la pandémie. Outre les consultations sur Zoom ou Doxy.me, les plateformes comme BetterHelp ou Talkspace redéfinissent les soins de santé mentale à distance. Mais ces plateformes ne font pas que mettre en relation un patient et un thérapeute, elles gèrent aussi les planning, les paiements, les messages, les remboursements… Malgré leur commodité, pour les thérapeutes, ces espaces de travail ressemblent beaucoup à une ubérisation, comme la connaissent les infirmières. Car en fait, ce qui change, ce n’est pas la distance. La chercheuse Hannah Zeavin dans son livre, The Distance Cure (MIT Press, 2021) a d’ailleurs montré que depuis le début de la psychanalyse, des formes de thérapies à distance ont toujours existé, par exemple via l’imposante correspondance épistolaire de Freud avec ses patients. Ce qui change, c’est la prise de pouvoir des plateformes qui organisent la relation, imposent des tarifs et renforcent les inégalités d’accès au soin, en s’adressant d’abord aux thérapeutes débutants, aux femmes, aux professionnels de couleurs, c’est-à-dire aux thérapeutes dont la clientèle est plus difficile à construire. Enfin, là aussi, la plateformisation change la relation, notamment en rendant les professionnels disponibles en continu, interchangeables, et brouille les frontières cliniques et personnelles.

Pour des IA qui nous reconnectent avec des humains plutôt qu’elles ne nous en éloignentL’illusion qu’ils nous donnent en nous faisant croire qu’on parle à quelqu’un se révèle bien souvent un piège. C’est ce que l’on constate dans un tout autre domaine, celui de l’orientation scolaire. Aux Etats-Unis, raconte The Markup. “Plus les étudiants se tournent vers les chatbots, moins ils ont de chances de développer des relations réelles qui peuvent mener à des emplois et à la réussite.” Comme les conseillers d’orientation scolaires et conseillers pour l’emploi des jeunes sont très peu nombreux, un flot de chatbots d’orientation est venu combler ce déficit humain. Le problème, c’est qu’y avoir recours érode la création de liens sociaux qui aident bien plus les jeunes à trouver une orientation ou un emploi, estime une étude du Christensen Institute.

En août, dans son document détaillant les risques et problèmes de sécurité pour ChatGPT, OpenAI énumérait les problèmes sociétaux que posent ses modèles et pointait que les questions de l’anthropomorphisation et la dépendance émotionnelle étaient en tête de liste des préoccupations auxquelles l’entreprise souhaitait s’attaquer. L’anthorpormophisation, c’est-à-dire le fait que ces boîtes de dialogues nous parlent comme si elles étaient humaines, créent “à la fois une expérience produit convaincante et un potentiel de dépendance et de surdépendance”. En bref, à mesure que la technologie s’améliore, les risques psychosociaux s’aggravent, comme le souligne d’ailleurs l’étude que viennent de publier le MIT et OpenAI. Pour Julia Fisher, auteure de l’étude du Christensen Institute, il faut que ces robots soient conçus pour nous reconnecter aux humains plutôt que de nous en écarter, explique-t-elle dans une tribune pour The74, l’une des grandes associations éducatives américaines.

Elle pointe notamment que les fournisseurs de chatbots d’orientation commencent à prendre la question au sérieux et tentent d’esquisser des solutions pour y répondre. Par exemple en limitant le temps d’interaction ou en faisant que les robots conseillent à ceux qui y ont recours, fréquemment, de voir des amis. Un autre outil demande aux étudiants qui s’inscrivent d’indiquer 5 relations qui seront alertées des progrès des étudiants à l’université pour qu’ils reçoivent un soutien humain réel. Un autre propose de connecter les étudiants à des mentors humains. Un autre encore propose de s’entraîner à demander de l’aide à des humains. Autant d’exemples qui montrent que l’IA peut jouer un rôle pour renforcer les liens humains. “Cependant, les incitations à créer des outils d’IA centrés sur les relations sont faibles. Peu d’écoles demandent ces fonctionnalités sociales ou évaluent les outils pour leurs impacts sociaux”, rappelle Fisher. Ceux qui achètent ces technologies devraient exiger des systèmes qu’ils améliorent les relations humaines plutôt que de les remplacer.

Mais pour cela, encore faudrait-il que ses systèmes soient conçus pour être moins puissants que ses concepteurs ne le pensent. En nous répétant qu’ils ne s’amélioreront qu’avec plus de données, nous oublions de les concevoir pour qu’ils nous aident plutôt qu’ils ne fassent à notre place ou à la place d’autres humains. Il serait temps d’arrêter de croire en leur puissance et de mieux prendre en compte leurs défaillances et plus encore les nôtres. Par exemple, quand un élève leur demande de faire leur dissertation à leur place, ces systèmes seraient bien plus utiles s’ils les aidaient à la faire, à en comprendre les étapes et les raisons, et exigeaient d’eux le travail qu’on leur demande, en les guidant pour le réaliser, plutôt qu’en le faisant à leur place. Mais pour cela, peut-être faudrait-il parvenir à sortir de la course à la puissance… et parvenir à imaginer un autre rapport à ces outils en faisant de manière à ce qu’eux-mêmes, nous proposent un autre rapport à leur puissance.

-

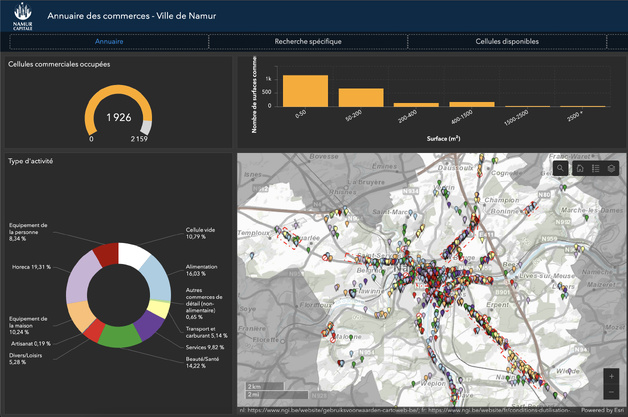

sur Tissu commercial

Publié: 31 March 2025, 7:30pm CEST par la rédaction SIGMAG & SIGTV.FR

La Ville de Namur a publié son nouvel annuaire cartographique et Open data des commerces namurois. Il rend disponibles à la consultation et au téléchargement les données de 2.000 établissements. Restaurants, boulangeries, coiffeurs, serruriers, fleuristes... Les onze typologies d’activité sont triées par catégorie, sous-activité et couleur. La recherche peut se faire par rue et par localité. De nombreux graphiques et filtres par quartier, type d’activité et superficie aident à comprendre et analyser la dynamique commerciale. Les surfaces sont classées en six fourchettes, de moins de 50 m2 à 2.500 m2 et plus. Elle propose aussi d’identifier un espace disponible optimal, via l’onglet « Cellule disponible », pour ouvrir son futur commerce. À ce jour, sur 2.159 emplacements commerciaux, 233 sont disponibles sur le marché. Chaque établissement dispose de sa fiche de contact avec des liens utiles.

La Ville de Namur a publié son nouvel annuaire cartographique et Open data des commerces namurois. Il rend disponibles à la consultation et au téléchargement les données de 2.000 établissements. Restaurants, boulangeries, coiffeurs, serruriers, fleuristes... Les onze typologies d’activité sont triées par catégorie, sous-activité et couleur. La recherche peut se faire par rue et par localité. De nombreux graphiques et filtres par quartier, type d’activité et superficie aident à comprendre et analyser la dynamique commerciale. Les surfaces sont classées en six fourchettes, de moins de 50 m2 à 2.500 m2 et plus. Elle propose aussi d’identifier un espace disponible optimal, via l’onglet « Cellule disponible », pour ouvrir son futur commerce. À ce jour, sur 2.159 emplacements commerciaux, 233 sont disponibles sur le marché. Chaque établissement dispose de sa fiche de contact avec des liens utiles.

+ d'infos :

sig.ville.namur.be

-

sur Digues et “nature”. Résultats d’une enquête sur la perception des digues et de leur évolution en France au XXIe siècle

Publié: 31 March 2025, 11:30am CEST par Lydie Goeldner-Gianella

Le paradigme classique de la gestion des digues est centré sur la défense contre les eaux. Souhaitant proposer une vision multifonctionnelle et durable de ces ouvrages, nous avons retenu sept tronçons de digues maritimes et fluviales en France. Nous présentons ici une enquête menée auprès de 828 riverains et usagers de digues pour analyser leur perception et représentations. Si la fonction défensive de ces ouvrages demeure bien connue, la perception des digues urbaines et rurales diverge en matière de connaissance des digues et de liens entre digues et nature. Les enquêtés mettent en avant la naturalité des digues – objet pourtant artificiel. Cinq scénarios d’évolution des digues à l’avenir ont été proposés aux enquêtés : renforcer les digues, les ouvrir/abaisser, les végétaliser davantage, les aménager davantage, ou ne rien y changer. Le scénario le plus souhaité est celui d’un maintien à l’identique et le moins refusé, celui de la végétalisation des digues ; le renforcement des di...

-

sur Postal horse relays and roads in France, from the 17th to the 19th centuries

Publié: 31 March 2025, 11:30am CEST par Nicolas Verdier

La base de données présentée ici résulte d’un travail collectif mené depuis une vingtaine d’années, réunissant géographes, géohistoriens et géomaticiens, autour d’un des premiers réseaux de transport rapide créé en France, celui de la poste à cheval. Les objectifs de recherche ont varié au cours des années, comme nous le montrons dans cet article, mais se sont constamment appuyés sur l’exploitation de la saisie du réseau à différentes dates dans un système d’information géographique (SIG). La base fournit les informations permettant la modélisation du réseau des routes de la poste à cheval et leur relais (où les montures étaient changées) sur ce SIG Historique, de 1632 à 1833, à sept dates. Quatre fichiers peuvent être téléchargés : la localisation et le nom des relais et des communes actuelles dans lesquels ils sont localisés en 1632, 1708, 1733, 1758, 1783, 1810 et 1833 (numérisés à partir d’une carte de 1632 et des Livres de Poste) ; les routes numérisées selon une distance à vol...

-

sur Crise des déchets et incinération sauvage à Sfax (Tunisie) : une campagne de mesures dédiée à l’évaluation de la pollution de l’air par les particules ?

Publié: 31 March 2025, 11:30am CEST par Hamdi Euchi

La défaillance de la politique de gestion des déchets à Sfax s’est traduite par la prolifération des décharges spontanées, principalement en 2021 et 2022. En dépit de son extrême nocivité sur la santé humaine, l’incinération des déchets à ciel ouvert est devenue une pratique illégale courante par une grande partie de la population, suite à l’échec de l’action publique. Cette pratique est à l’origine de la pollution aux particules. Cet article analyse la médiatisation de la crise de la gestion des déchets à Sfax, et étudie la variation spatio-temporelle de la pollution aux particules PM10 et PM2,5 dans l’agglomération de Sfax, à partir de campagnes de mesures semi-itinérantes dans une trentaine de décharges incinérées. Il est montré que l’incinération des déchets à ciel ouvert provoque de très fortes concentrations de pollution aux PM10 et PM2,5, dépassant de très loin les normes en vigueur de la protection de la santé humaine recommandées par la Tunisie et l’Organisation Mondiale de...

-

sur Nepthys Zwer, 2024, Pour un spatio-féminisme, De l'espace à la carte, Paris, La découverte, 216 p.

Publié: 31 March 2025, 11:30am CEST par Justine Collin

Avec pour ambition d’inscrire son ouvrage Pour un spatio-féminisme, De l'espace à la carte (2024) au sein de la quatrième vague féministe (Dagorn, 2011), Nepthys Zwer propose de déconstruire les discours spatiaux genrés. Richement illustré par les photographies et cartes de l’autrice ou des acteur.rice.s rencontré.e.s, l’ouvrage selon Zwer n’est pas à classer avec les manuels d’épistémologie et de concepts géographiques. Nourri par les théories féministes, il offre aux géographes spécialistes du genre un état des lieux autour des pratiques spatiales genrées, tandis que d’autres y trouveront une première entrée pour comprendre les racines des comportements sexués et des usages différenciés de l’espace.

À travers les ateliers animés par l’autrice et la méthode de la contre-cartographie ("contre-carte", Peluso, 1995), Zwer mobilise plusieurs cas d’études en milieu urbain, en France et à l’étranger. Le choix de cette méthode permet de rendre compte d’espaces et/ou de phénomènes absents d...

-

sur À la recherche de données : Nature et flux des informations au fondement des politiques de gestion du sanglier urbain. L’exemple bordelais

Publié: 31 March 2025, 11:30am CEST par Carole Marin

La nature en ville abrite une large biodiversité. Tandis que la présence de certaines espèces est bienvenue, d’autres s’y sont installées sans y avoir été invitées. C’est le cas du sanglier. Le défi de gestion posé par la grande faune urbaine est écologique, il est aussi culturel, politique et éthique. Cette étude, motivée par l'incertitude générale concernant les enjeux socio-écologiques de la coexistence avec le sanglier urbain et les solutions à y apporter, explore et analyse les informations qui fondent les politiques de gestion de l'espèce. La démarche s’appuie sur une enquête de terrain conduite dans la Métropole de Bordeaux, visant à suivre le cheminement de l’information dans le réseau des acteurs territoriaux. L’objectif de la démarche est double : i) recueillir et analyser les données existantes relatives au sanglier urbain, aux problèmes générées par la coexistence avec l’espèce en ville et aux dispositifs de gestion en place, et ii) modéliser les flux d’informations entr...

-

sur Enfrichement des côtes rocheuses : analyse de la dynamique du paysage et de la végétation

Publié: 31 March 2025, 10:30am CEST par Pierre Libaud

Cette étude porte sur deux secteurs littoraux enfrichés de la commune de Moëlan-sur-Mer soumis à un projet de remise en culture. Il s’agit ici d’interroger l’hétérogénéité paysagère et la diversité spécifique de ces espaces enfrichés. L’analyse des dynamiques d’ouverture et de fermeture du paysage depuis les années 1950 montre une pluralité de rythmes et de trajectoires selon les zones, l’action humaine et les contraintes écologiques. Les résultats font ressortir une diversité des formes végétales et des trajectoires, remettant en cause une uniformisation du paysage des friches littorales.

-

sur Geodatadays 2023

Publié: 31 March 2025, 10:30am CEST par Christine Plumejeaud-Perreau

Les GéoDataDays constituent un évènement national indépendant dédié à la géographie numérique en France. Ces rencontres annuelles sont organisées par l’AFIGÉO et DécryptaGéo depuis cinq ans, en partenariat avec une plateforme régionale d’information géographique et des collectivités territoriales. Au cœur de cet évènement, le Groupement de recherche CNRS MAGIS, consacré à la géomatique, co-organise depuis quatre ans un concours, les CHALLENGES GEODATA, qui vise à faire connaître et à récompenser les innovations du monde académique par un jury indépendant et multipartite (recherche, collectivités et services de l’État, industriels). Les domaines d’application sont très variés et touchent à la collecte, au traitement, à l’analyse et à la visualisation de données géographiques (ou géolocalisées). Les six critères retenus par le jury permettent de comparer et d’évaluer ces propositions souvent hétérogènes : originalité, public ciblé, potentiel de dissémination, qualité et justesse des m...

-

sur MapDraw. Un outil libre d’annotation de cartes en ligne

Publié: 31 March 2025, 10:30am CEST par Justin Berli

Les enquêtes et questionnaires reposent souvent sur l’utilisation de supports papier, et les cartes ne font pas exception. En effet, ces dernières permettent une grande flexibilité, notamment en termes d’annotations, de dessins, etc. Mais la conversion et l’exploitation des données ainsi récoltées dans un SIG peuvent s’avérer fastidieuses, et cela peut bien souvent limiter la quantité de données récoltée. Cet article présente un outil libre en ligne, MapDraw, permettant de prendre des notes sur une carte interactive et d’exporter ces données dans un format utilisable par un SIG.

-

sur HedgeTools : un outil d’analyse spatiale dédié à l’évaluation de la multifonctionnalité des haies

Publié: 31 March 2025, 10:30am CEST par Gabriel Marquès

Les haies jouent des rôles clés dans les paysages agricoles, mais leur caractérisation automatique par analyse spatiale est complexe. Dans cet article, nous décrivons les principales fonctionnalités d’un outil open source — HedgeTools — qui permet de calculer une diversité d’indicateurs contribuant à évaluer la multifonctionnalité des haies. Il permet de créer la géométrie des objets, de les redécouper en fonction de divers critères et d’extraire leurs caractéristiques à différents niveaux d’agrégation. HedgeTools vise à faciliter la gestion et la préservation des haies en permettant d’évaluer leur état et leurs fonctions dans les paysages, avec des perspectives d’amélioration et d’extension de ses fonctionnalités.

-

sur Visualisation de données issues des réseaux sociaux : une plateforme de type Business Intelligence

Publié: 31 March 2025, 10:30am CEST par Maxime Masson

TextBI est un tableau de bord interactif destiné à visualiser des indicateurs multidimensionnels sur de grandes quantités de données multilingues issues des réseaux sociaux. Il cible quatre dimensions principales d’analyse : spatiale, temporelle, thématique et personnelle, tout en intégrant des données contextuelles comme le sentiment et l’engagement. Offrant plusieurs modes de visualisation, cet outil s’insère dans un cadre plus large visant à guider les diverses étapes de traitement de données des réseaux sociaux. Bien qu’il soit riche en fonctionnalités, il est conçu pour être intuitif, même pour des utilisateurs non informaticiens. Son application a été testée dans le domaine du tourisme en utilisant des données de Twitter (aujourd’hui X), mais il a été conçu pour être générique et adaptable à de multiples domaines. Une vidéo de démonstration est accessible au lien suivant : [https:]]

-

sur Atlas du développement durable. Un monde en transition, Autrement, 2022

Publié: 31 March 2025, 10:30am CEST par Marie-Laure Trémélo

L’Atlas du développement durable, proposé par Yvette Veyret et Paul Arnould est paru aux éditions Autrement en mars 2022 ; il s’agit d’une 2e édition, mettant à jour partiellement la première, parue deux ans auparavant.

Les auteurs sont tous deux professeurs émérites, de l’université Paris-Nanterre pour Yvette Veyret et de l’École normale supérieure de Lyon pour Paul Arnould. Les représentations graphiques et cartographiques ont été réalisées par Claire Levasseur, géographe-cartographe indépendante.

Après une introduction qui définit le développement durable dans ses composantes écologique, économique et sociale et présente les nouveaux objectifs définis dans l’Agenda pour 2030 (adopté lors du sommet des Nations Unies de 2015), cet atlas est divisé en trois parties : en premier lieu, un bilan mondial, puis les réponses globales apportées pour assurer un développement durable à l’échelle du globe, enfin les solutions proposées à l’échelle nationale française. Chaque partie est composée...

-

sur La géographie des chefs étoilés : du rayonnement international a l’ancrage territorial

Publié: 31 March 2025, 10:30am CEST par Jean-Charles Édouard

Ce texte de rubrique se situe en complémentarité de l’article sur la géographie des restaurants étoilés et s’intéresse plus particulièrement aux hommes et aux femmes qui se cachent derrière les étoiles, et donc aux « grands chefs ». Pour des raisons liées aux informations dont on peut disposer sur les sites spécialisés ou dans la littérature, ainsi qu’au nombre bien trop important de chefs qui ont une ou deux étoiles, ce qui suit concerne principalement les chefs triplement étoilés, soit trente personnes en 2021.

À partir de l’analyse de leurs lieux d’exercice et/ou d’investissement actuels, on peut dessiner une « géographie » des chefs étoilés et les diviser en trois groupes : les internationaux, les régionaux et les locaux. De même, l’observation de leur plus ou moins grand investissement dans la vie socio-économique locale, ainsi que leurs circuits d’approvisionnement nous permettront d’approcher leur rôle dans les dynamiques de développement local.

En ce qui concerne l’analyse du ...

-

sur Mappa naturae, 2023

Publié: 31 March 2025, 10:30am CEST par Sylvain Guyot

Le collectif Stevenson, du nom de Robert Louis Stevenson, écrivain écossais et grand voyageur, connu dans le monde entier pour son roman L’Ile au trésor, publié en 1883, est composé de six auteurs spécialisés, peu ou prou, dans de multiples formes d’études des cartographies et de leurs usages à travers les époques : Jean-Marc Besse, philosophe et historien, Milena Charbit, architecte et artiste, Eugénie Denarnaud, paysagiste et plasticienne, Guillaume Monsaingeon, philosophe et historien, Hendrik Sturm, artiste marcheur (décédé le 15 août 2023), et Gilles A. Tiberghien, philosophe en esthétique. Ce collectif a déjà publié chez le même éditeur, en 2019 Mappa Insulae et, en 2021, Mappa Urbis. À l’image de leurs deux dernières parutions, Mappa Naturae se présente comme un recueil d’images cartographiques sélectionnées pour leur esthétique, leur ingéniosité ou, parfois, leur nouveauté. Le collectif ne donne pas d’informations synthétisées sur la provenance concrète des cartes. Les sourc...

-

sur Représenter la centralité marchande : la coloration marchande et ses usages

Publié: 31 March 2025, 10:30am CEST par Nicolas Lebrun

La centralité marchande est le potentiel marchand détenu par un lieu. Elle peut être générée par différents types de configurations spatiales (les modes de centralité). L’article propose de voir comment représenter graphiquement cette centralité, afin de bien appréhender ses dimensions qualitatives. Nous qualifions de coloration marchande la proportion entre les différents modes de centralité : l’outil graphique proposé repose sur la couleur, entendue comme élément facilitant de la compréhension des situations spatiales. L’utilisation d’un même procédé graphique permettra de mieux discerner potentiel marchand d’un espace et usages réels (les modes d’usages) de celui-ci. Cet outil devrait permettre une meilleure prise en compte de la diversité des situations marchandes dans la production des cadres de l’urbanisme commercial.

-

sur La géohistoire du royaume d’Abomey (1645-1894), dans le récit national et dans la formation territoriale du Bénin contemporain

Publié: 31 March 2025, 10:30am CEST par Jean Rieucau

La géohistoire du royaume d’Abomey, appuyé sur le groupe humain, la langue des Fon et sur la religion vaudou, couvre trois siècles et demi (1645 à 1894). Ce petit État-nation guerrier, esclavagiste, partenaire des négriers européens (Français, Portugais, Anglais, Danois), perd sa souveraineté à la fin du XIXe siècle, en intégrant la colonie française du Dahomey. Il abrite une des civilisations les plus brillantes de l’Afrique subsaharienne, qui fonde le soft power culturel (restitutions de l’art africain, mémoire de l’esclavage, constructions de musées, tourisme culturel), de l’actuelle République du Bénin.

-

sur L’IA raisonne-t-elle ?

Publié: 31 March 2025, 7:00am CEST par Hubert Guillaud

Melanie Mitchell est certainement la plus pédagogue des spécialistes de l’IA. Son livre, Intelligence artificielle, triomphes et déceptions (Dunod, 2021) est une excellente ressource pour comprendre l’histoire et le fonctionnement de l’IA, tout comme sa newsletter. Dans sa récente chronique pour le magazine, Science, elle revient sur la capacité de l’IA à “raisonner”. Pour cela, elle prend un petit exemple logique simple. “Julia a deux sœurs et un frère. Combien de sœurs son frère Martin a-t-il ?”. Le résoudre demande à chacun de nous quelques secondes d’attention. Mitchell a soumis cette énigme à plusieurs reprises à la version la plus récente de GPT-4 (4o), qui lui a donné la mauvaise réponse à chaque fois, affirmant que Martin avait deux sœurs. Pour remédier à ce type de problème, les grandes entreprises de l’IA développent de nouveaux systèmes qu’elles appellent les Grands modèles de raisonnement (Large reasoning models, LRM).

Quand on soumet cet exemple logique à un LRM, comme les modèles o1 et o3 d’OpenAI, Claude d’Anthropic, Gemini 2.0 Flash Thinking Experimental de Google et le modèle R1 de l’entreprise chinoise DeepSeek… ces modèles déploient une chaîne de pensée qui énoncent un processus de raisonnement apparemment plausible. o1 d’OpenAI décompose sa réponse : “1. Julia a deux sœurs. Cela signifie qu’il y a trois filles au total (Julia + deux autres). 2. Julia a également un frère, prénommé Martin. 3. Au total, il y a quatre frères et sœurs : trois filles et un garçon (Martin). 4. Du point de vue de Martin, ses sœurs sont toutes les trois des filles (Julia et ses deux sœurs). 5. Martin a donc trois sœurs.”… Ce qui ressemble beaucoup à un raisonnement humain que chacun d’entre nous pourrait tenir pour résoudre l’énigme. On comprend alors que ces modèles soient en train de devenir le corps de l’offre commerciale des entreprises d’IA… Reste à savoir si ces modèles “réfléchissent et raisonnent vraiment, ou s’ils font juste semblant” ?

Mitchell rappelle que les LRM sont construits sur des LLM. Les LLM sont pré-entraînés pour prédire une partie de mots (un token ou jeton) dans une séquence de texte. Pour devenir LRM, “le modèle est ensuite post-entraîné, c’est-à-dire entraîné davantage, mais avec un objectif différent : générer spécifiquement des chaînes de pensée, comme celle générée par o1 pour l’énigme des “sœurs”. Après cette formation spéciale, lorsqu’un problème lui est posé, le LRM ne génère pas de jetons un par un mais génère des chaînes entières”. Pour le dire autrement, les LRM effectuent beaucoup plus de calculs qu’un LLM pour générer une réponse. D’où le fait qu’on parle d’un progrès par force brute, par puissance de calcul, avec des systèmes capables de tester en parallèle des milliers de réponses pour les améliorer. “Ce calcul peut impliquer la génération de nombreuses chaînes de réponses possibles, l’utilisation d’un autre modèle d’IA pour évaluer chacune d’elles et renvoyer celle la mieux notée, ou une recherche plus sophistiquée parmi les possibilités, semblable à la recherche par anticipation que les programmes de jeu d’échecs ou de go effectuent pour déterminer le bon coup”. Quand on utilise un modèle de raisonnement, l’utilisateur ne voit que les résultats de calculs démultipliés. Ces modèles qui fonctionnent surtout selon la méthode d’apprentissage par renforcement non supervisé sont récompensés quand ils produisent les étapes de raisonnement dans un format lisible par un humain, lui permettant de délaisser les étapes qui ne fonctionnent pas, de celles qui fonctionnent.

Un débat important au sein de la communauté rappelle Mitchell consiste à savoir si les LRM raisonnent ou imitent le raisonnement. La philosophe Shannon Valor a qualifié les processus de chaîne de pensée des LRM de “sorte de méta-mimétisme”. Pour Mitchell, ces systèmes génèrent des traces de raisonnement apparemment plausibles qui imitent les séquences de “pensée à voix haute” humaines sur lesquelles ils ont été entraînés, mais ne permettent pas nécessairement une résolution de problèmes robuste et générale. Selon elle, c’est le terme de raisonnement qui nous induit en erreur. Si les performances de ces modèles sont impressionnantes, la robustesse globale de leurs performances reste largement non testée, notamment pour les tâches de raisonnement qui n’ont pas de réponses claires ou d’étapes de solution clairement définies, ce qui est le cas de nombreux problèmes du monde réel.

De nombreuses études ont montré que lorsque les LLM génèrent des explications sur leurs raisonnement, celles-ci ne sont pas toujours fidèles à ce que le modèle fait réellement. Le langage anthropomorphique (puisqu’on parle de “raisonnement”, de “pensées”…) utilisé induit les utilisateurs en erreur et peut les amener à accorder une confiance excessive dans les résultats. Les réponses de ces modèles ont surtout pour effet de renforcer la confiance des utilisateurs dans les réponses, constate OpenAI. Mais la question d’évaluer leur fiabilité et leur robustesse reste entière.

-

sur Apprêtez-vous à parler aux robots !

Publié: 28 March 2025, 7:00am CET par Hubert Guillaud

Google vient de lancer Gemini Robotics, une adaptation de son modèle d’IA générative à la robotique (vidéo promotionnelle), permettant de commander un bras robotique par la voix, via une invite naturelle, son IA décomposant la commande pour la rendre exécutable par le robot, rapporte la Technology Review. L’année dernière, la start-up de robotique Figure avait publié une vidéo dans laquelle des humains donnaient des instructions vocales à un robot humanoïde pour ranger la vaisselle. Covariant, une spinoff d’OpenAI rachetée par Amazon, avait également fait une démonstration d’un bras robotisé qui pouvait apprendre en montrant au robot les tâches à effectuer (voir l’article de la Tech Review). Agility Robotics propose également un robot humanoïde sur le modèle de Figure. Pour Google, l’enjeu est « d’ouvrir la voie à des robots bien plus utiles et nécessitant une formation moins poussée pour chaque tâche », explique un autre article. L’enjeu est bien sûr que ces modèles s’améliorent par l’entraînement de nombreux robots.

-

sur Doctorow : rendre l’interopérabilité contraignante

Publié: 27 March 2025, 7:00am CET par Hubert Guillaud

Voilà des années que Cory Doctorow traverse les enjeux des technologies. En France, il est surtout connu pour ses romans de science-fiction, dont quelques titres ont été traduits (Le grand abandon, Bragelonne, 2021 ; De beaux et grands lendemains, Goater, 2018, Little Brother, éditions 12-21, 2012 ; Dans la dèche au royaume enchanté, Folio, 2008). Cela explique que beaucoup connaissent moins le journaliste et militant prolixe, qui de Boing Boing (le blog qu’il a animé pendant 20 ans) à Pluralistic (le blog personnel qu’il anime depuis 5 ans), de Creative Commons à l’Electronic Frontier Foundation, dissémine ses prises de positions engagées et informées depuis toujours, quasiment quotidiennement et ce avec un ton mordant qui fait le sel de ses prises de paroles. Depuis des années, régulièrement, quelques-unes de ses prises de position parviennent jusqu’à nous, via quelques entretiens disséminés dans la presse française ou quelques traductions de certaines de ses tribunes. D’où l’importance du Rapt d’Internet (C&F éditions, 2025, traduction de The internet con, publié en 2023 chez Verso), qui donne enfin à lire un essai du grand activiste des libertés numériques.

On retrouve dans ce livre à la fois le ton volontaire et énergisant de Doctorow, mais aussi son côté brouillon, qui permet bien souvent de nous emmener plus loin que là où l’on s’attendait à aller. Dans son livre, Doctorow explique le fonctionnement des technologies comme nul autre, sans jamais se tromper de cible. Le défi auquel nous sommes confrontés n’est pas de nous débarrasser des technologies, mais bien de combattre la forme particulière qu’elles ont fini par prendre : leur concentration. Nous devons œuvrer à remettre la technologie au service de ceux qui l’utilisent, plaide-t-il depuis toujours. Pour cela, Doctorow s’en prend aux monopoles, au renforcement du droit d’auteur, au recul de la régulation… pour nous aider à trouver les leviers pour reprendre en main les moyens de production numérique.

En GuerreVoilà longtemps que Cory Doctorow est en guerre. Et le principal ennemi de Doctorow c’est la concentration. Doctorow est le pourfendeur des monopoles quels qu’ils soient et des abus de position dominantes. A l’heure où les marchés n’ont jamais autant été concentrés, le militant nous rappelle les outils que nous avons à notre disposition pour défaire cette concentration. “La réforme de la tech n’est pas un problème plus pressant qu’un autre. Mais si nous ne réformons pas la tech, nous pouvons abandonner l’idée de remporter d’autres combats”, prévient-il. Car la technologie est désormais devenue le bras armé de la concentration financière, le moyen de l’appliquer et de la renforcer. Le moyen de créer des marchés fermés, où les utilisateurs sont captifs et malheureux.

Pour résoudre le problème, Doctorow prône l’interopérabilité. Pour lui, l’interopérabilité n’est pas qu’un moyen pour disséminer les technologies, mais un levier pour réduire les monopoles. L’interopérabilité est le moyen “pour rendre les Big Tech plus petites”. Pour Doctorow, la technologie et notamment les technologies numériques, restent le meilleur moyen pour nous défendre, pour former et coordonner nos oppositions, nos revendications, nos luttes. “Si nous ne pouvons nous réapproprier les moyens de production du numérique, nous aurons perdu”.

Cory Doctorow est un militant aguerri. En historien des déploiements de la tech, son livre rappelle les combats technologiques que nous avons remportés et ceux que nous avons perdus, car ils permettent de comprendre la situation où nous sommes. Il nous rappelle comme nul autre, l’histoire du web avant le web et décrypte les manœuvres des grands acteurs du secteur pour nous enfermer dans leurs rets, qui ont toujours plus cherché à punir et retenir les utilisateurs dans leurs services qu’à leur fournir un service de qualité. Nous sommes coincés entre des “maniaques de la surveillance” et des “maniaques du contrôle”. “Toutes les mesures prises par les responsables politiques pour freiner les grandes entreprises technologiques n’ont fait que cimenter la domination d’une poignée d’entreprises véreuses”. La régulation a produit le contraire de ce qu’elle voulait accomplir. Elle a pavé le chemin des grandes entreprises technologiques, au détriment de la concurrence et de la liberté des usagers.

Police sans justiceEn revenant aux racines du déploiement des réseaux des années 90 et 2000, Doctorow nous montre que l’obsession au contrôle, à la surveillance et au profit, ont conduit les entreprises à ne jamais cesser d’œuvrer contre ce qui pouvait les gêner : l’interopérabilité. En imposant par exemple la notification et retrait pour modérer les infractions au copyright, les grandes entreprises se sont dotées d’une procédure qui leur permet tous les abus et face auxquelles les utilisateurs sont sans recours. En leur confiant la police des réseaux, nous avons oublié de confier la justice à quelqu’un. Dans les filtres automatiques des contenus pour le copyright, on retrouve les mêmes abus que dans tous les autres systèmes : des faux positifs en pagaille et des applications strictes au détriment des droits d’usage. En fait, les grandes entreprises de la tech, comme les titulaires des droits, tirent avantage des défaillances et des approximations de leurs outils de filtrage. Par exemple, rappelle Doctorow, il est devenu impossible pour les enseignants ou interprètes de musique classique de gagner leur vie en ligne, car leurs vidéos sont systématiquement bloquées ou leurs revenus publicitaires captés par les maisons de disques qui publient des interprétations de Bach, Beethoven ou Mozart. L’application automatisée de suppression des contenus terroristes conduit à la suppression automatisée des archives de violations des droits humains des ONG. Pour Doctorow, nous devons choisir : “Soit nous réduisons la taille des entreprises de la Tech, soit nous les rendons responsables des actions de leurs utilisateurs”. Cela fait trop longtemps que nous leur faisons confiance pour qu’elles s’améliorent, sans succès. Passons donc à un objectif qui aura plus d’effets : œuvrons à en réduire la taille !, recommande Doctorow.

L’interopérabilité d’abordPour y parvenir, l’interopérabilité est notre meilleur levier d’action. Que ce soit l’interopérabilité coopérative, celle qui permet de construire des normes qui régulent le monde moderne. Ou que ce soit l’interopérabilité adverse. Doctorow s’énerve légitimement contre toutes les entreprises qui tentent de protéger leurs modèles d’affaires par le blocage, à l’image des marchands d’imprimantes qui vous empêchent de mettre l’encre de votre choix dans vos machines ou des vendeurs d’objets qui introduisent des codes de verrouillages pour limiter la réparation ou l’usage (qu’on retrouve jusque chez les vendeurs de fauteuils roulants !). Ces verrous ont pourtant été renforcés par des lois qui punissent de prison et de lourdes amendes ceux qui voudraient les contourner. L’interopérabilité est désormais partout entravée, bien plus encore par le droit que par la technique.

Doctorow propose donc de faire machine avant. Nous devons imposer l’interopérabilité partout, ouvrir les infrastructures, imposer des protocoles et des normes. Cela suppose néanmoins de lutter contre les possibilités de triche dont disposent les Big Tech. Pour cela, il faut ouvrir le droit à la rétro-ingénierie, c’est-à-dire à l’interopérabilité adverse (ou compatibilité concurrentielle). Favoriser la “fédération” pour favoriser l’interconnexion, comme les services d’emails savent échanger des messages entre eux. Doctorow défend la modération communautaire et fédérée, selon les règles que chacun souhaite se donner. Pour lui, il nous faut également favoriser la concurrence et empêcher le rachat d’entreprises concurrentes, comme quand Facebook a racheté Instagram ou WhatsApp, qui a permis aux Big Techs de construire des empires toujours plus puissants. Nous devons nous défendre des seigneuries du web, car ce ne sont pas elles qui nous défendront contre leurs politiques. Sous prétexte d’assurer notre protection, bien souvent, elles ne cherchent qu’à maximiser les revenus qu’elles tirent de leurs utilisateurs.

L’interopérabilité partoutLe livre de Doctorow fourmille d’exemples sur les pratiques problématiques des Big Tech. Par exemple, sur le fait qu’elles ne proposent aucune portabilité de leurs messageries, alors qu’elles vous proposent toujours d’importer vos carnets d’adresse. Il déborde de recommandations politiques, comme la défense du chiffrement des données ou du droit à la réparabilité, et ne cesse de dénoncer le fait que les régulateurs s’appuient bien trop sur les Big Tech pour produire de la réglementation à leur avantage, que sur leurs plus petits concurrents. Nous devons rendre l’interopérabilité contraignante, explique-t-il, par exemple en la rendant obligatoire dans les passations de marchés publics et en les obligeant à l’interopérabilité adverse, par exemple en faisant que les voitures des flottes publiques puissent être réparables par tous, ou en interdisant les accords de non-concurrence. “Les questions de monopole technologique ne sont pas intrinsèquement plus importantes que, disons, l’urgence climatique ou les discriminations sexuelles et raciales. Mais la tech – une tech libre, juste et ouverte – est une condition sine qua non pour remporter les autres luttes. Une victoire dans la lutte pour une meilleure tech ne résoudra pas ces autres problèmes, mais une défaite annihilerait tout espoir de remporter ces luttes plus importantes”. L’interopérabilité est notre seul espoir pour défaire les empires de la tech.

Le verrouillage des utilisateurs est l’un des nœuds du problème techno actuel, expliquait-il récemment sur son excellent blog, et la solution pour y remédier, c’est encore et toujours l’interopérabilité. Ces services ne sont pas problématiques parce qu’ils sont détenus par des entreprises à la recherche de profits, mais bien parce qu’elles ont éliminé la concurrence pour cela. C’est la disparition des contraintes réglementaires qui produit « l’emmerdification », assure-t-il, d’un terme qui est entré en résonance avec le cynisme actuel des plateformes pour décrire les problèmes qu’elles produisent. Zuckerberg ou Musk ne sont pas plus diaboliques aujourd’hui qu’hier, ils sont juste plus libres de contraintes. « Pour arrêter l’emmerdification, il n’est pas nécessaire d’éliminer la recherche du profit – il faut seulement rendre l’emmerdification non rentable ». Et Doctorow de nous inviter à exploiter les divisions du capitalisme. Nous ne devons pas mettre toutes les entreprises à but lucratif dans le même panier, mais distinguer celles qui produisent des monopoles et celles qui souhaitent la concurrence. Ce sont les verrous que mettent en place les plateformes en s’accaparant les protocoles que nous devons abattre. Quand Audrey Lorde a écrit que les outils du maître ne démantèleront jamais la maison du maître, elle avait tort, s’énerve-t-il. « Il n’y a pas d’outils mieux adaptés pour procéder à un démantèlement ordonné d’une structure que les outils qui l’ont construite ».

Cet essai est une chance. Il va permettre à beaucoup d’entre nous de découvrir Cory Doctorow, de réfléchir avec lui, dans un livre joyeusement bordélique, mais qui sait comme nul autre relier l’essentiel et le décortiquer d’exemples toujours édifiants. Depuis plus de 20 ans, le discours de Doctorow est tout à fait cohérent. Il est temps que nous écoutions un peu plus !

La couverture du Rapt d’internet de Cory Doctorow.

La couverture du Rapt d’internet de Cory Doctorow.

Cette lecture a été publiée originellement pour la lettre du Conseil national du numérique du 21 mars 2025.

-

sur Le ChatGPT des machines-outils

Publié: 26 March 2025, 7:00am CET par Hubert Guillaud

Les machines-outils à commandes numériques sont des outils complexes et fragiles, qui nécessitent des réglages, des tests et une surveillance constante. Microsoft travaille à développer une gamme de produits d’IA dédiée, des “Agents d’exploitation d’usine”, rapporte Wired. L’idée, c’est que l’ouvrier qui est confronté à une machine puisse interroger le système pour comprendre par exemple pourquoi les pièces qu’elle produit ont un taux de défaut plus élevé et que le modèle puisse répondre précisément depuis les données provenant de l’ensemble du processus de fabrication. Malgré son nom, le chatbot n’a pas la possibilité de corriger les choses. Interconnecté à toutes les machines outils, il permet de comparer les pannes et erreurs pour améliorer ses réponses. Microsoft n’est pas le seul à l’oeuvre. Google propose également un Manufacturing Data engine.

Mais, bien plus qu’un enjeu de réponses, ces nouvelles promesses semblent surtout permettre aux entreprises qui les proposent un nouveau pouvoir : prendre la main sur l’interconnexion des machines à la place de leurs fabricants.

-

sur Vectofascisme

Publié: 25 March 2025, 7:00am CET par Hubert Guillaud

Dans son passionnant journal, qu’il produit depuis plus de 10 ans, l’artiste Gregory Chatonsky tient le carnet d’une riche réflexion de notre rapport aux technologies. Récemment, il proposait de parler de vectofascisme plutôt que de technofascisme, en livrant une explication et une démonstration passionnante qui nous montre que ce nouveau fascisme n’est pas une résurgence du fascisme du XXe siècle, mais bien une « transformation structurelle dans la manière dont le pouvoir se constitue, circule et s’exerce ». Tribune.

Comme annoncé par Vilèm Flusser nous sommes entrés dans l’ère post-alphabétique. Les appareils nous programment désormais autant que nous ne les programmons. Dans cet univers techno-imaginal où l’ensemble de nos facultés sont traversées par les technologies, la question du fascisme se pose différemment. Qualifier un phénomène contemporain de “fasciste” n’est ni un simple détournement sémantique ni une exactitude historique. C’est plutôt reconnaître une certaine disposition affective qui traverse le socius, un réarrangement des intensités désirantes sous de nouvelles conditions techniques.