Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

5362 éléments (2 non lus) dans 55 canaux

Du côté des éditeurs

(1 non lus)

Du côté des éditeurs

(1 non lus)

Toile géomatique francophone

(1 non lus)

Toile géomatique francophone

(1 non lus)

Toile géomatique francophone

Toile géomatique francophone

-

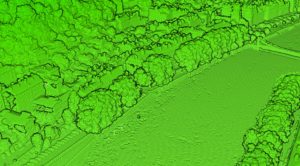

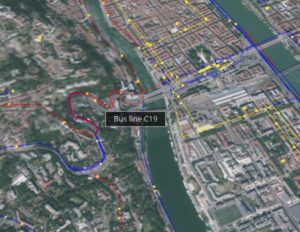

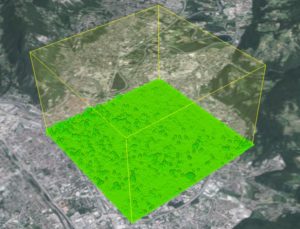

sur QGIS pour afficher des données télémétriques géospatiales

Publié: 19 September 2023, 5:00pm CEST par Florent Fougères

ContexteNous en avions déjà parlé dans un précédent article : l’Agence Spatiale Canadienne (ASC) supporte les vols de ballons stratosphériques ouverts (BSO), opérés en sol canadien, par le CNES. Certains de ces ballons volent à environ 40 km d’altitude dans des conditions proches de l’environnement spatial, d’autres volent plus bas dans l’atmosphère, et tous embarquent un grand nombre d’instruments de mesures et d’observation pouvant atteindre une masse de 800 kg. Une multitude d’organisations (laboratoires, établissements scolaires, industriels, etc), à travers le monde, utilisent de plus petits ballons (du type sondage météo) pour effectuer des expériences. La réglementation des vols de ballons non habité étant différente au Canada, l’ASC a entrepris, en 2018, de développer une plateforme rencontrant les exigences de leurs vols domestiques. Pour suivre ces ballons, leurs données sont transmises à un satellite Iridium, qui les envoie à un serveur sur Terre, où on les récupère.

Ce serveur reçoit donc une trentaine de variables comme la localisation (lat, long), l’altitude, la vitesse, la pression atmosphérique, la température, la tension des batteries etc.

Lors de nos précédents travaux, nous avions construit une preuve de concept, et en concertation avec l’ASC avons décidé d’une autre modalité de représentation de l’information en repartant d’une interface déjà développée par leurs soins. Nous avons transformé l’interface permettant de consulter la télémétrie sans dimension cartographique, en plugin QGIS et l’avons fait évoluer pour visualiser au même endroit les données télémétriques, la position en temps réel et des courbes retraçant l’évolution temporelle de certaines données.

FonctionnalitésLe plugin effectue donc la collecte des données de télémétrie. Il faut dans un premier temps récupérer la donnée et la parser : il s’agit de chaînes de caractères à séparer selon un délimiteur et des longueurs spécifiques.

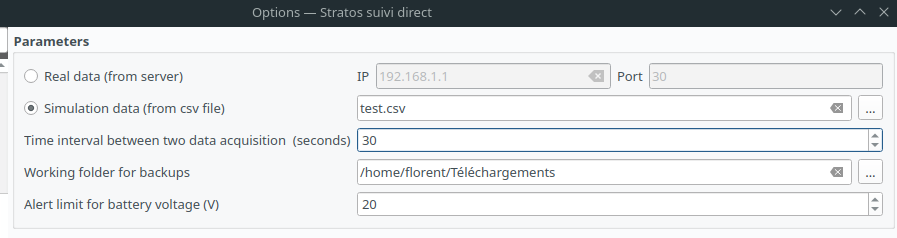

Deux modes d’acquisition des données sont possibles :- Un mode réel où il faut renseigner l’adresse IP et le port du serveur où récupérer les données

- Un mode simulation où il faut renseigner un fichier CSV contenant des données simulant un vol, ou reprenant des vols précédents

Il est possible de mettre l’acquisition en pause et de réinitialiser l’interface.

Enfin, dans les paramètres, il est possible de saisir un seuil d’alerte pour le voltage de la batterie, en-dessous duquel l’utilisateur sera alerté :

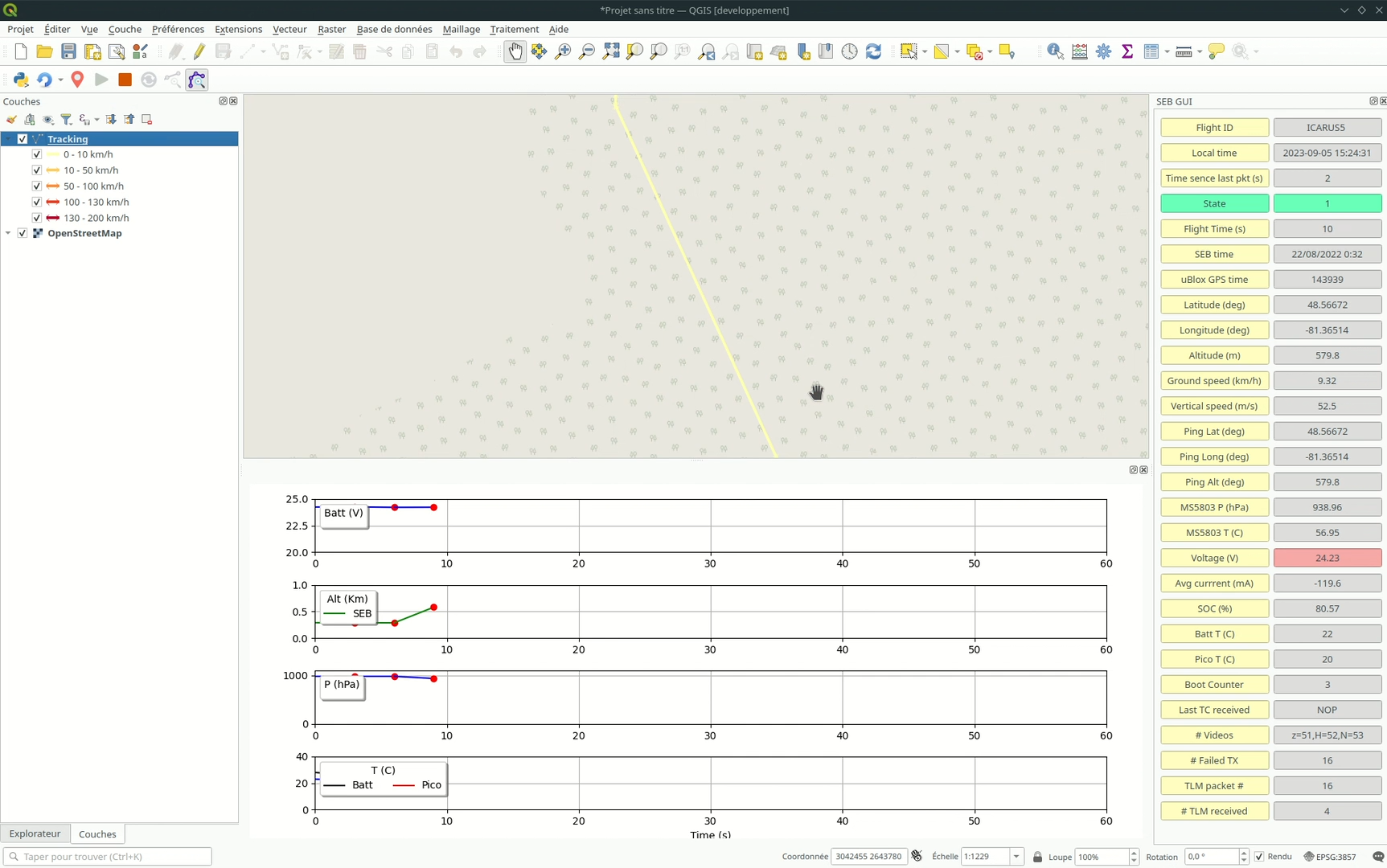

Les données acquises sont présentées dans 3 zones différentes dans l’interface de QGIS :

Les données acquises sont présentées dans 3 zones différentes dans l’interface de QGIS :

- Une colonne (à droite) qui liste toutes les données recueillies

- Un bloc (en bas) dans lequel on trouve différentes courbes (tension de la batterie, altitude, pression et température)

- Et la carte sur laquelle s’affiche le parcours du ballon, avec deux options de zoom possibles :

- Zoom sur la dernière position du ballon

- Zoom sur l’intégralité de la trace

Une fois l’acquisition terminée, les données sont enregistrées dans le dossier précisé dans les paramètres du plugin, partagées dans un fichier CSV pour les données brutes, et dans un Shapefile pour les données géographiques.

Démonstration vidéo

-

sur Inscrivez-vous à la conférence "Noms de lieux étrangers : enjeux culturels pour les uns, politiques pour les autres" le 4 octobre 2023

Publié: 19 September 2023, 1:57pm CEST

Le CNIG vous invite à participer le 4 octobre de 11h00 à 12h00 à la conférence en ligne

"Introduction à l'exonymie : entre enjeux culturels et souveraineté"

-

sur GEO.be : la plateforme open data Belge

Publié: 19 September 2023, 1:49pm CEST par Sogner

Cet article GEO.be : la plateforme open data Belge est apparu en premier sur Veille cartographique 2.0.

La France possède une base de données accessible par tout le monde et qui regroupe des données approuvées par le gouvernement: datagouv, qui se divise en plusieurs catégories selon les domaines: urbanisme, environnement, écologie… Cependant, cela existe également dans les autres pays comme en Belgique, un pays francophone. Ce dernier met à disposition de ses […]

Cet article GEO.be : la plateforme open data Belge est apparu en premier sur Veille cartographique 2.0.

-

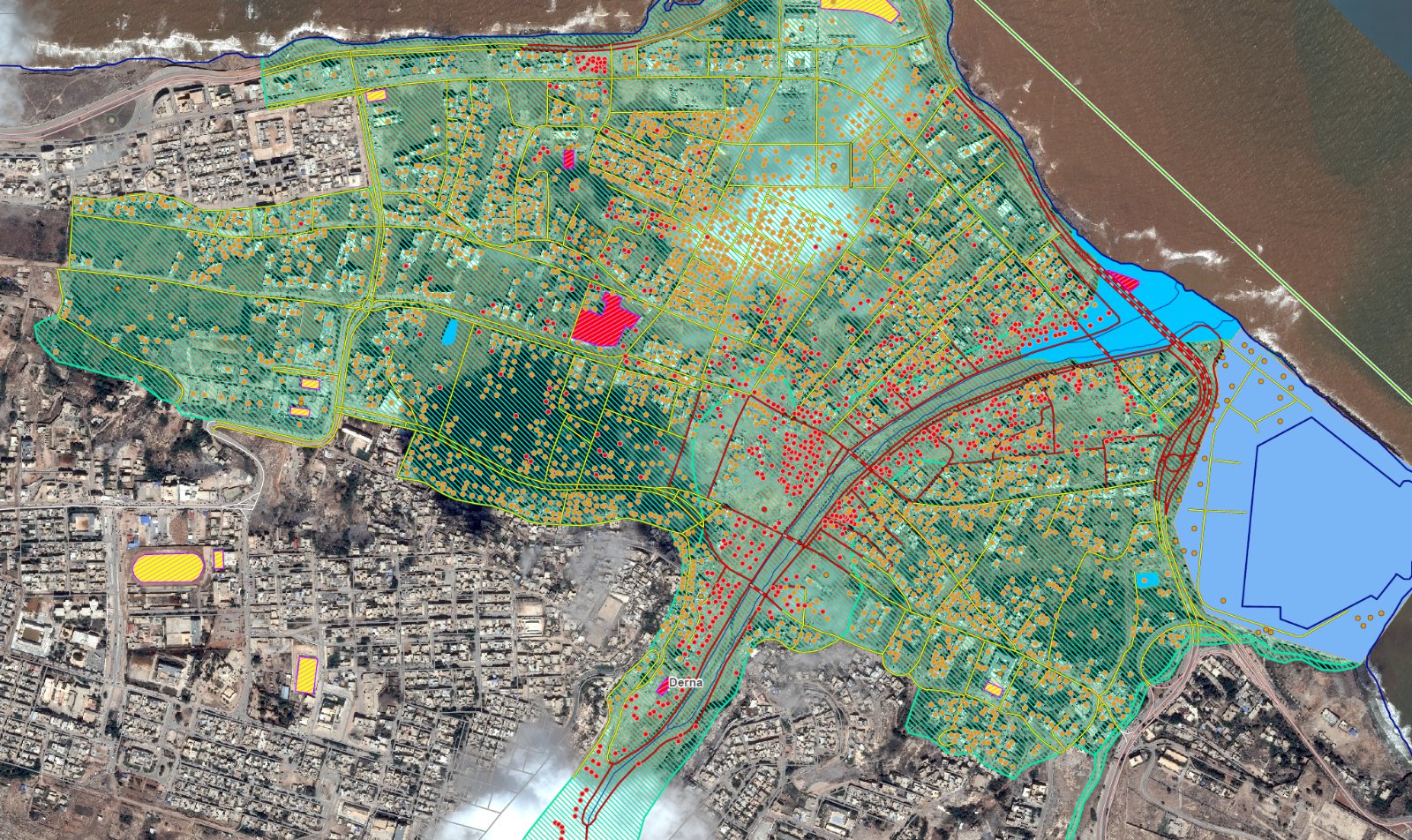

sur Cartes et données sur les inondations en Libye (catastrophe de Derna)

Publié: 18 September 2023, 2:44pm CEST

La tempête Daniel, qui a frappé dans la nuit du 10 au 11 septembre 2023 la ville de Derna (100 000 habitants) au nord-est de la Lybie, a entraîné la rupture de deux barrages en amont provoquant une crue de l’ampleur d’un « tsunami » le long de l’oued qui traverse la cité. Le bilan provisoire s'établit à plus de 11 300 morts au 18 septembre 2023. Selon les experts, la situation sociale, économique et politique difficile du pays a contribué à ce lourd bilan humain. Une situation de chaos qui limite les capacités de prévision des services météorologiques locaux et des systèmes d'alerte et d'évacuation.

Inondations en Libye - EMSR696 (Situational reporting Copernicus Emergency Management Service)

1) Traitement médiatique de la catastrophe« Libye : des inondations dans l'est provoquent des milliers de morts » (RFI). Le gouvernement de l'est libyen, désigné par le Parlement et non reconnu par la communauté internationale, a décrété un deuil national de trois jours, suite à la tempête Daniel qui, après la Grèce, la Turquie et la Bulgarie, a fortement affecté la Libye (voir l'animation de cette tempête).

« Avant/Après : les images impressionnantes des inondations en Libye » (Le Figaro). Vue du ciel, la catastrophe naturelle est impressionnante. Une très large partie de Derna est sous les eaux. Le wadi Derna, un simple petit cours d’eau, s’est transformé en une vague semblable à un « tsunami » d’après plusieurs témoins. La cité a été submergée par des vagues de 7 mètres de haut qui ont tout détruit sur leur passage en emportant les voitures et les maisons. « Avant / Après Inondations en Libye : découvrez l’ampleur des dégâts vus du ciel » (Ouest France).

« Inondations en Libye : à Derna, le nombre de morts est toujours incertain » (Le Monde). Selon l’Organisation internationale pour les migrations (OIM), au moins 30 000 personnes qui vivaient dans cette cité de 100 000 habitants ont été déplacées. Une partie des 10 000 disparus après les inondations à Derna pourraient se trouver en mer, ils ont été emportés vers la mer pendant les inondations. La mer rejette leurs corps vers les plages.

« Comment expliquer les inondations monstres qui touchent le pays ? » (BFM-TV). La tempête Daniel s'est transformée en un cyclone subtropical méditerranéen. Ce sont deux facteurs qui semblent s'être combinés pour recharger le système à bloc. La hausse des températures de l'air sous l'effet du réchauffement climatique qui rend l'air plus humide. Et la hausse des températures des océans. Une mer Méditerranée plus chaude et qui s'évapore plus a donc alimenté la puissance du medicane Daniel. « Pourquoi la tempête Daniel a été aussi dévastatrice en Libye ? » (Futura Science).

« Qu’est-ce qu’un medicane, ce phénomène météo responsable des inondations meurtrières en Libye ? » (Le Parisien) Les météorologues appellent ce phénomène un medicane (contraction de "hurricane" et "Méditerranée"). Ce phénomène hybride présente certaines caractéristiques d'un cyclone tropical et d'autres d'une tempête des latitudes moyennes.

« Inondations en Libye : les deux barrages de Derna étaient fissurés » (Euronews). Dans une étude publiée en novembre 2022, l'ingénieur et universitaire libyen Abdel-Wanis Ashour a mis en garde contre une "catastrophe" menaçant Derna si les autorités ne procèdent pas à l'entretien des deux barrages. Malgré cet avertissement, aucuns travaux n'ont été menés.

« Dans une Libye corrompue, les alertes concernant le délabrement des barrages de Derna restées lettre morte » (Le Monde). Un rapport du groupe d’experts de l’ONU avait déjà dénoncé le comportement « prédateur » des groupes et milices qui se disputent le pouvoir depuis plus de dix ans et ont entraîné « le détournement des fonds de l’Etat libyen et la détérioration des institutions et des infrastructures ». Des militants de la société civile demandent une enquête internationale, craignant que les investigations locales ne puissent être fructueuses dans un pays largement gouverné par des groupes armés et des milices.

« Inondations en Libye : des barrages fragilisés par des années de négligences » (Libération). Les deux barrages avaient été construits dans les années 70 par une entreprise yougoslave non pas pour collecter de l’eau mais pour protéger Derna des inondations. Nonobstant les moyens financiers dont dispose le premier pays pétrolier d’Afrique, les travaux n’ont pas été entrepris.

« L'ONU et l'OMS préoccupées par les risques de maladies » (RFI). À Derna, dans l'est de la Libye, une semaine après les inondations dévastatrices provoquées par la tempête Daniel, un très grand nombre de corps se trouve encore sous les décombres. Cette situation représente une menace pour l'hygiène. Sur place, les agences de l'ONU tentent de prévenir la propagation de maladies.

« Les enfants de Libye sont confrontés à une nouvelle tragédie après plus d’une décennie de conflit » (UNICEF). On estime que près de 300 000 enfants ont été exposés à la puissante tempête. Au-delà des risques immédiats de morts et de blessés, les inondations en Libye présentent un risque grave pour la santé et la sécurité des enfants. Avec des approvisionnements en eau potable compromis, les risques d’épidémies de diarrhée et de choléra, ainsi que de déshydratation et de malnutrition, augmentent considérablement. Parallèlement, les enfants qui perdent leurs parents ou sont séparés de leur famille sont plus exposés aux risques de protection, notamment à la violence et à l’exploitation.

« Les inondations en Libye laissent l'ancienne Cyrène meurtrie et menacée de pillage » (Middle East Eye). Des eaux torrentielles et des glissements de terrain ont emporté certaines antiquités du site du patrimoine mondial de l'UNESCO tout en en exposant d'autres pour la première fois.

2) Pistes d'analyse en termes d'aléa / risque / vulnérabilité et enjeux

« Inondations en Libye : un désastre humanitaire sur fond de crise politique » (France Culture). C’est dans la province agricole de Cyrénaïque, située à l’est du pays, que les inondations ont été les plus meurtrières. La municipalité de Derna, qui souffrait déjà d'un manque d'infrastructures, a vu disparaître dans la mer un quart de son territoire en quelques heures. Jalel Harchaoui, spécialiste de la Libye et chercheur au Royal United Service Institute, rappelle la situation difficile que connaît cette ville depuis une dizaine d’années : « c’est une ville qui a un historique politique tout à fait particulier, qui est marginalisée par rapport au reste de la Cyrénaïque. Elle a été le lieu d’un siège imposé par le maréchal Haftar de 2015 à 2019 et qui s'est achevé par une guerre civile. Depuis 2019, il n'y a pas d’infrastructures comme des hôpitaux ou des transports et les reconstructions ont été négligées. »

« L’interaction entre les précipitations, l’exposition et la vulnérabilité exacerbées par le changement climatique a entraîné des impacts généralisés dans la région méditerranéenne » (World Weather Attribution). Un événement aussi extrême que celui observé en Libye est devenu jusqu’à 50 fois plus probable et jusqu’à 50 % plus intense par rapport unréchauffement qui serait inférieur à 1,2°C. Outre le manque d’entretien, les barrages d’Al-Bilad et d’Abu Mansour ont été construits dans les années 1970, sur la base de précipitations relativement courtes, et n’ont peut-être pas été conçus pour résister à un épisode de pluie sur 300 à 600 ans. Un examen complet portant sur les critères de conception des barrages sera nécessaire pour comprendre dans quelle mesure la conception des barrages et le manque d'entretien ultérieur ont contribué à la catastrophe.

« Les inondations en Libye montrent la nécessité d’alertes multirisques précoces et d’une réponse unifiée » (déclaration du Secrétaire général de l'Organisation Météorologique Mondiale). Le patron de l’OMM qui dépend de l’ONU, Petteri Taalas, a estimé que « la plupart des victimes auraient pu être évitées » pointant du doigt la désorganisation liée à l’instabilité politique dans le pays. L'agence météorologique libyenne a émis des avis d'alerte trois jours avant et l'état d'urgence a été déclaré dans certaines parties de l'est de la Libye.

« Les faits sont clairs. Les alertes précoces sauvent des vies et génèrent d’énormes avantages financiers. J’exhorte tous les gouvernements, institutions financières et société civile à soutenir cet effort » (secrétaire général de l’ONU, António Guterres). Voir le plan publié par l'ONU Alertes précoces pour tous. Plan d'action exécutif 2023-2027. Qu’il concerne les crues, les sécheresses, les vagues de chaleur, ou les tempêtes, un système d’alerte précoce est un système intégré qui permet d’être prévenu de l’approche de conditions météorologiques dangereuses et éclaire sur ce que les pouvoirs publics, la collectivité et les individus peuvent faire pour atténuer le choc de leurs effets imminents.

Ksenia Chmutina & Jason von Meding (2019). A Dilemma of Language : “Natural Disasters”. International Journal of Disaster Risk Science. A propos des catastrophes dites "naturelles" : même si les dangers sont naturels, les catastrophes ne le sont pas. Cet article soutient qu’en rejetant continuellement la faute sur la « nature » et en imputant la responsabilité des échecs du développement à des phénomènes naturels « exceptionnels » ou à des « cas de force majeure », on accepte de ceux qui sont à l'origine des catastrophes qu'ils se satisfassent d'une mauvaise planification urbaine, d'inégalités socio-économiques, de politiques mal réglementées, d'un manque d’adaptation et d’atténuation proactives, autant de facteurs qui augmentent la vulnérabilité.

Introduire le chapitre « Les sociétés face aux risques » en Seconde par les inondations en Libye (académie de Normandie). Les notions de « catastrophe naturelle » (tempête) et « technologique » (rupture de barrage) sont abordées, ainsi que celle d’« aléa ». Aussi, la notion de « prévention » peut être approchée en évoquant le rôle des barrages qui étaient censés protéger la ville, mais trop vétustes et mal entretenus.Ici, les notions qui peuvent être approchées sont celles de « pays en développement », « crise », « résilience », « culture du risque »…3) Cartes et données SIG à visualiser en ligne ou à télécharger

Libye : les dégâts dans la ville de Derna et le barrage détruit vus par le satellite Pléiades Neo (Un autre regard sur la Terre). « J’ai vu beaucoup d’images de catastrophes. Celle de Derna est vraiment sidérante. J’ai ressenti la même sidération pour des désastres comme le tsunami de l’océan indien en 2004, l'ouragan Katrina en 2005 ou le tremblement de Terre d’Haïti en 2010 » (@RegardSurTerre). Voir ce fil twitter de @MagaliReghezza qui montre que le séismé d'Haïti était encore d'une autre ampleur.

Images satellites Maxar et Planet des inondations (Geospatial World). Segmentation automatique des images satellite du programme Maxar Open Data (Samgeo).

Cartes et données SIG élaborées par le Service de gestion des urgences CopernicusEMS (dégâts estimés à partir de l'observation d'images satellites). Voir également les zones impactées par la tempête Daniel en Grèce avec l'animation satellite.

Atlas de la mortalité et des pertes économiques dues à des phénomènes météorologiques, climatiques et hydrologiques extrêmes 1970-2019 (Organisation météorologique mondiale) à télécharger en pdf.

4) Utilisation de la cartographie pour organiser l'aide humanitaire

Inondations en Libye en 2023 - Aperçu de la situation d'urgence (Reliefweb). La tempête Daniel a provoqué des inondations à grande échelle dans le nord-est de la Libye, entraînant des pertes de vies humaines et des dégâts aux infrastructures dans plusieurs villes côtières et le long des rivières, notamment Benghazi, Al-Jabal Al-Akhder, Al-Marj, Batah, Bayada, Albayda, Shahat et Sousse. La ville de Derna semble être durement touchée après la rupture de deux barrages en amont, libérant plus de 30 millions de mètres cubes d'eau dans la ville de Derna. Les premiers rapports suggèrent d'importants dégâts aux logements et aux infrastructures critiques. La tempête a exacerbé les problèmes d'accès à l'eau potable et aux soins de santé. Les zones touchées sont désormais confrontées à des risques plus élevés de maladies infectieuses en raison de services de santé perturbés, des réseaux d'égouts endommagés, de la persistance des eaux de crue et de la boue.

Empreinte des bâtiments de la zone touchée par les inondations à Derna (Google Buildings). Les empreintes des bâtiments sont utiles pour toute une une gamme d’applications, depuis l’estimation de la population, la planification urbaine et la réponse humanitaire, jusqu’aux sciences du climat et de l’environnement. Cet ensemble de données ouvertes à grande échelle contient les contours des bâtiments dérivés de données en haute résolution. Fichiers geojson ou csv à télécharger directement.

Données SIG sur la Libye mises à disposition par Humanitarian Data Exchange (HDX), site dédié au partage de données humanitaires.

Articles connexes

Tempête Alex et inondations dans les Alpes maritimes : accès aux cartes et aux images satellitaires

Cartographier la trajectoire des cyclones avec des données en temps réel

Cartes et données sur les séismes en Turquie et en Syrie (février 2023)

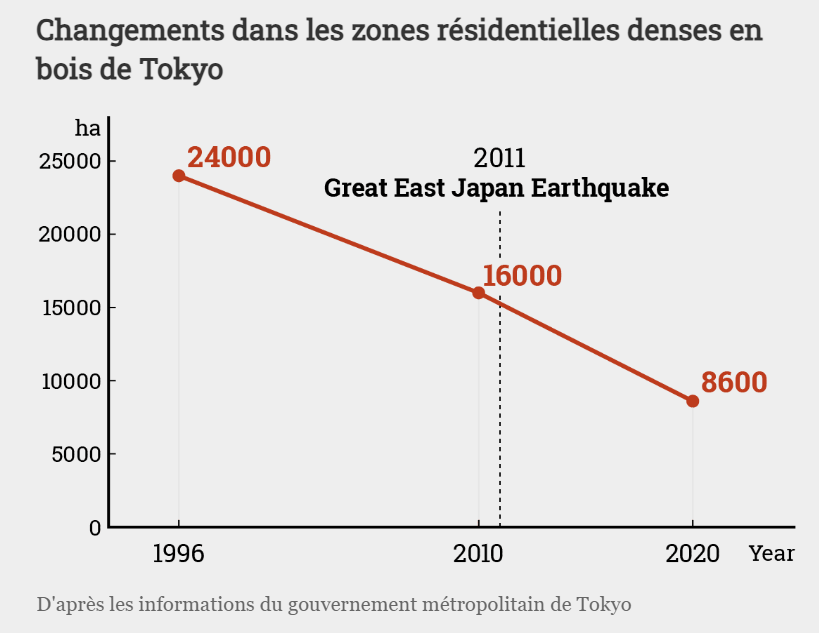

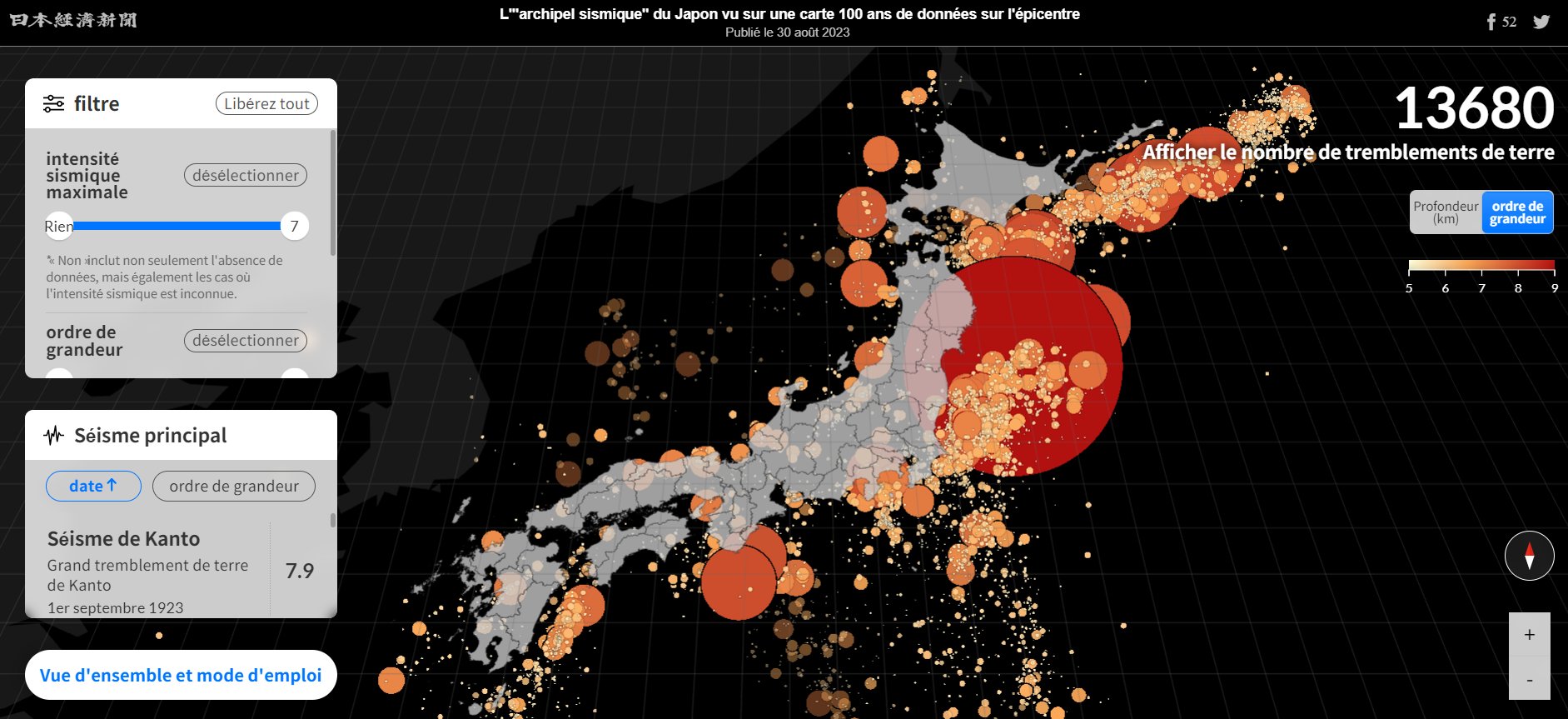

Cartes et données sur les tremblements de terre au Japon depuis 1923

Simuler des scénarios de tremblement de terre en utilisant des cartes

Cartes-posters sur les tsunamis, tremblements de terre et éruptions volcaniques dans le monde (NOOA, 2022)

Analyser et discuter les cartes de risques : exemple à partir de l'Indice mondial des risques climatiques

L'évolution de la cartographie humanitaire au sein de la communauté OpenStreetMap

-

sur Géonature : des applications Web et mobiles au service de la faune et de la flore

Publié: 18 September 2023, 1:00pm CEST par GIGANT

Cet article Géonature : des applications Web et mobiles au service de la faune et de la flore est apparu en premier sur Veille cartographique 2.0.

Le site Géonature propose un ensemble d’outils permettant de saisir, gérer et diffuser les données autour de l’observation de la faune et de la flore. Il propose aux utilisateurs un ensemble de protocoles le permettant et tous disponible en open source. Ces services sont proposés par une collaboration entre les parcs nationaux de France mais […]

Cet article Géonature : des applications Web et mobiles au service de la faune et de la flore est apparu en premier sur Veille cartographique 2.0.

-

sur cocarto, un SIG de collaboration en ligne

Publié: 18 September 2023, 10:43am CEST par DIALLO

Cet article cocarto, un SIG de collaboration en ligne est apparu en premier sur Veille cartographique 2.0.

La suite ESRI particulièrement la partie online (web) nous offre la possibilité de créer des cartes et des applications cartographiques (Dashboard, web applications, sites…) et de pouvoir les partager avec d’autres utilisateurs de son organisation – ou de toute autre structure. Elle demeure, toutefois, plus destinée à des utilisateurs plus ou moins expérimentés vis-à-vis de […]

Cet article cocarto, un SIG de collaboration en ligne est apparu en premier sur Veille cartographique 2.0.

-

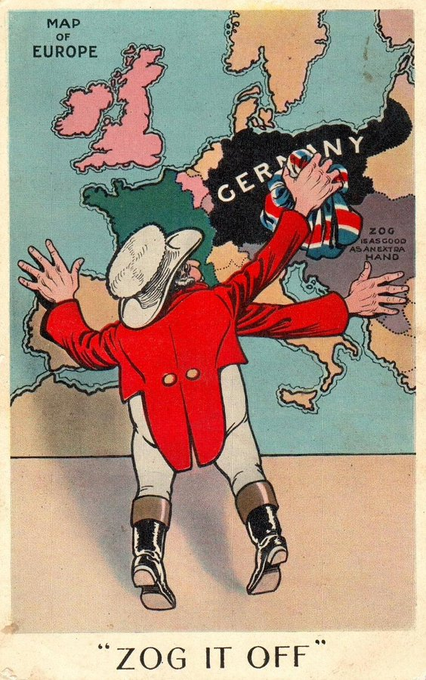

sur Étudier l'expansion de la Chine en Asie du Sud-Est à travers les caricatures de presse

Publié: 17 September 2023, 9:28am CEST

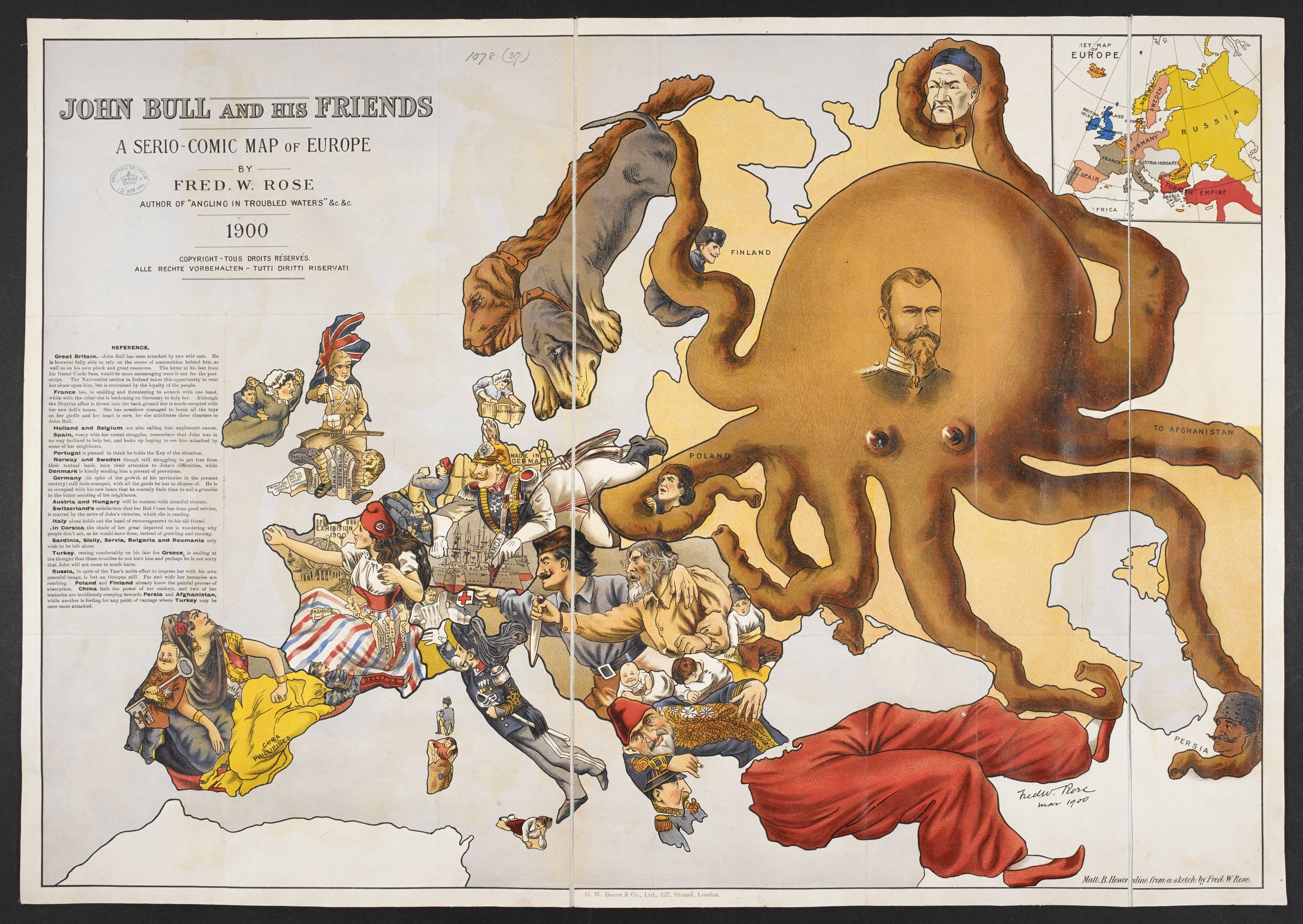

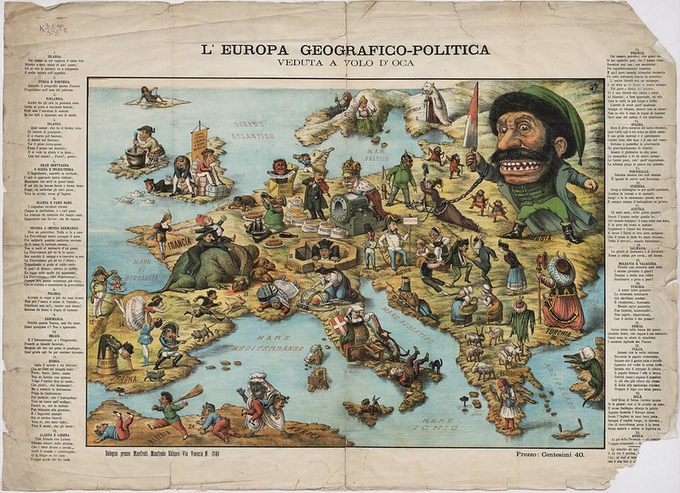

Les cartes humoristiques sont devenues assez courantes dans les médias et sur Internet. Le fil twitter ci-dessous donne des pistes de lecture concernant ces cartes-caricatures, que l'on retrouve souvent en illustrations dans les manuels scolaires. L'objectif est d'en décrypter les symboles et d'en donner une approche critique en confrontant les visions. A l'ère d'Internet et des réseaux sociaux, ces dessins humoristiques circulent de plus en plus. Ils renvoient souvent les uns aux autres dans un jeu de miroir complexe, de sorte qu'il n'est plus possible de les prendre isolément comme on le ferait dans un commentaire classique de document. L'expansion de la Chine en Asie du Sud-Est fournit un bon exemple pour étudier ces représentations et en dégager des visions géopolitiques.Les dessins de Nath Paresh reviennent souvent dans la presse. Il est caricaturiste au National Herald en Inde et ses dessins sont distribués aux États-Unis par Cagle Cartoons (vision indo-américaine) [https:]] pic.twitter.com/0Z5oFEfwrB

— Sylvain Genevois (@mirbole01) May 22, 2023

Les parties du corps émergées du dragon correspondent aux îlots convoités par la Chine. Assez intéressant de voir ici Taiwan assimilé aux îles de la mer de Chine méridionale. La caricature de Nath Paresh est reprise par un journal japonais [https:]]

— Sylvain Genevois (@mirbole01) May 22, 2023

Evolution de la situation géopolitique et de la réprésentation des menaces : l'enjeu n'est pas seulement militaire, il concerne aussi les activités de pêche (allusion ici à la rivalité sino-vietnamienne + incapacité de l'ASEAN à réguler les conflits) [https:]] pic.twitter.com/IAUxyJamyN

— Sylvain Genevois (@mirbole01) May 22, 2023

A confronter avec des dessins humoristiques permettant de jouer sur d'autres stéréotypes que le dragon : la muraille de Chine ou encore le panda... [https:]] [https:]] pic.twitter.com/8t4G1P83Nm

— Sylvain Genevois (@mirbole01) May 22, 2023

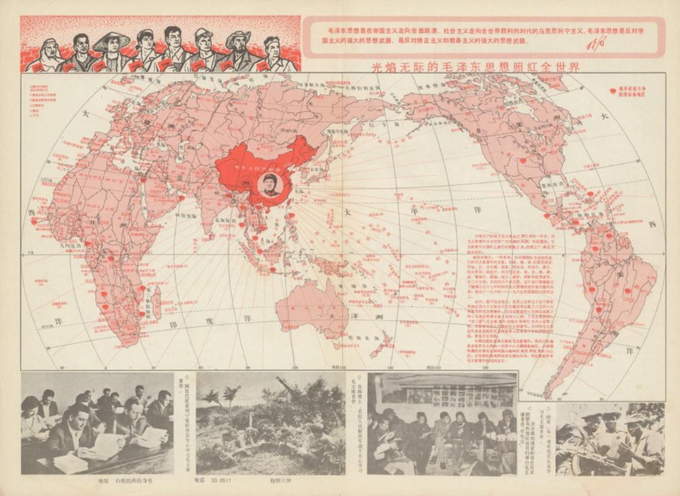

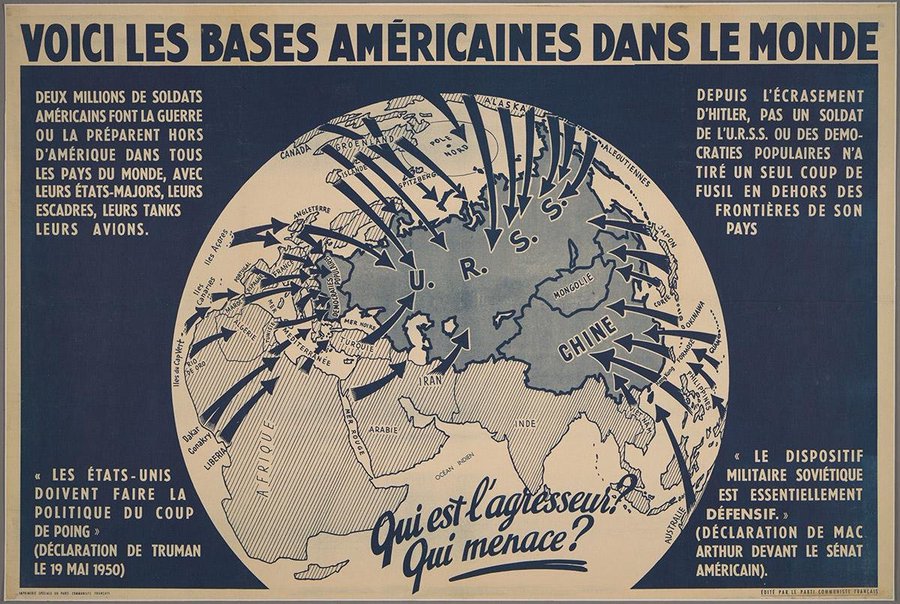

Les visions géopolitiques peuvent être intéressantes à décrypter à travers ces dessins humoristiques dès lors qu'on s'emploie à les contextualiser et en dégager des pistes d'interprétation en les confrontant [https:]] [https:]] pic.twitter.com/NW7KpEX1Uy

— Sylvain Genevois (@mirbole01) May 22, 2023

L'occasion de rappeler ce dessin satirique diffusé lors du G7 de 2021 où le sommet international était déjà accusé de vouloir réprimer la Chine. Voir la caricature et ses symboles décryptés sur ce site [https:]]

— Sylvain Genevois (@mirbole01) May 22, 2023

Tse Tsan-Tai a représenté chaque pays occidental par un animal pour en montrer la brutalité. Voir la lecture des symboles proposée par @Propagandopolis [https:]]

— Sylvain Genevois (@mirbole01) September 17, 2023

L'artiste hongkongais exilé Ah To a mis à jour cette carte « Situation en Extrême-Orient » pour refléter les réalités de 2022. Il peut être intéressant de comparer les symboles pour montrer le renversement de la situation géopolitique un siècle après [https:]] pic.twitter.com/mggBTjOdDE

— Sylvain Genevois (@mirbole01) September 17, 2023

La carte, objet éminemment politique. Les tensions géopolitiques entre Taïwan et la Chine

Articles connexes

La carte, objet éminemment politique : la Chine au coeur de la "guerre des cartes"

Etudier les densités en Chine en variant les modes de représentation cartographique

Comment la Chine finance des méga-projets dans le monde

L'histoire par les cartes : l'Asie du Sud-Est à travers des cartes japonaises de la 2e Guerre mondiale

Cartes anciennes sur l'Asie du Sud-Est (Yale-Nus College de Singapour)

Comment l'Asie perçoit le monde ? (France Culture)

Etudier les conflits maritimes en Asie en utilisant le site AMTI

Cartes et caricatures. Recension de cartes satiriques et de cartes de propagande

Les nouvelles façons de « faire mentir les cartes » à l’ère numérique

Jouer avec les stéréotypes en géographie, est-ce les renforcer ou aider à comprendre le monde ?

-

sur Appel à commentaires pour le standard Sites Économiques juqu'au 16 octobre 2023

Publié: 16 September 2023, 10:15am CEST

Appel à commentaires pour le standard Sites Économiques juqu'au 16 octobre 2023

-

sur Cartes et caricatures. Recension de cartes satiriques et de cartes de propagande

Publié: 16 September 2023, 10:11am CEST

Vous cherchez des images de propagande à base de cartes ? Cette page vous propose une recension de ressources sur Internet qui peuvent vous intéresser.

Le compte twitter @propagandopolis sélectionne et commente chaque semaine des images et des cartes historiques. Voir le site de l'auteur qui propose des cartes de propagande américaine et du monde entier : PropagandopolisLe site commercial Barron Maps propose une impressionnante série de cartes satiriques et de cartes de propagande. Roderick Barron (@barronmaps) est spécialisé dans le domaine des cartes de propagande et des cartes imaginaires. Il alimente un blog associé au site qui contient des articles de fond. Il y explore notamment le phénomène des cartes « sério-comiques » de la fin du XIXe et du début du XXe siècle (voir cette présentation vidéo en anglais). On y trouve les oeuvres de Fred W. Rose qui s'est rendu célèbre par ses cartes caricaturales de l’époque victorienne (avec des pieuvres).

La British Library propose également une belle recension de cartes satiriques du monde entier. La page d'accueil retrace la longue histoire des cartes satiriques depuis le XVIIe siècle jusqu'à nos jours, avec de nombreux exemples empruntés à différents pays et différentes époques.

Le site de la célèbre collection David Rumsey constitue une source de premier ordre. On peut y trouver toutes sortes de cartes satiriques, en utilisant son moteur de recherche interne (par exemple avec les mot-clés "propaganda" ou "satirical").

Le site Vividmaps a sélectionné des cartes satiriques de l'Europe, principalement du XIXe et du début XXe siècle (l'âge d'or des nationalismes ayant donné lieu à beaucoup de cartes de propagande). « L’Europe était le siège d’États puissants souvent en concurrence. Ils ont pris part à des guerres sanglantes et ont tissé des intrigues diplomatiques en coulisses. Dans cette confrontation, la satire était non seulement une forme d'art mais aussi une arme dangereuse, dont le but était de montrer à la population et à celle des autres pays qui est qui dans l'arène politique.»

Last but not the least. La formidable série de "cartes persuasives" de l'Université Cornell. « Plus de 800 ?cartes destinées avant tout à influer sur des opinions ou des croyances - à faire passer un message - plutôt qu'à communiquer une information géographique. La collection contient une grande variété de "cartes pour convaincre" : qu'il s'agisse de la cartographie allégorique, satirique ou picturale, de choix sélectifs de l'information, de l'utilisation inhabituelle de projections, de couleurs, de graphiques et de textes, ou encore d'images ou d'affiches de propagande destinées à tromper intentionnellement, ces cartes véhiculent un large éventail de messages religieux, politiques, militaires, commerciaux, moraux et sociaux. »

En complément

Un fil twitter de @GoncharenkoUA sur "la propagande douce" véhiculée par les cartes qui représentent la Crimée comme séparée de l'Ukraine et comme une partie de la Russie.

Un fil twitter de @mirbole01 sur les cartes et dessins humoristiques concernant l'expansion de la Chine en mer de Chine méridionale.

Série d'images et de cartes utilisant la pieuvre comme élément de caricature. Cette sélection de @WryCritic permet de mettre en évidence des points communs et des spécificités d'une caricature à l'autre.Articles connexes

Les nouvelles façons de « faire mentir les cartes » à l’ère numérique

La rhétorique derrière les cartes de propagande sur le coronavirus

Cartographie électorale, gerrymandering et fake-news aux Etats-Unis

Étudier l'expansion de la Chine en Asie du Sud-Est à travers des cartes-caricatures

Qu'est-ce que le Listenbourg, ce nouveau pays fictif qui enflamme Twitter ? (fake map)

Derrière chaque carte, une histoire : découvrir les récits de la bibliothèque Bodleian d'Oxford

Bouger les lignes de la carte. Une exposition du Leventhal Map & Education Center de Boston

La carte, objet éminemment politique

-

sur Journée d’études CFC : Arts(s) et Cartographie(s), 25 novembre 2023, INHA (Paris)

Publié: 15 September 2023, 7:00pm CEST par catherinevhofmann

Avec le soutien de l’EPHE-PSL (Histara), du CNRS (Lamop) et de la Bibliothèque nationale de France

Entrée libre

On dispose aujourd’hui de nombreuses études sur la place de la cartographie dans l’histoire des savoirs scientifiques, et sur les engagements de la cartographie dans les entreprises politiques. Mais il est nécessaire d’envisager aussi les relations de la cartographie avec les arts et les artistes ainsi que les formes d’implication de la cartographie dans les mondes de l’art et dans les cultures visuelles des sociétés modernes et contemporaines. C’est dans cette optique que la Commission Histoire du Comité Français de Cartographie organise une Journée d’études intitulée « Art(s) et cartographie(s) », avec l’ambition de rassembler et de confronter quelques-unes des pistes principales de la recherche actuelle.

Programme

8h45 Accueil – café Ouverture 9h15 Introduction à la journée par Jean-Marc Besse (CNRS-EHESS) et Catherine Hofmann (BnF, département des Cartes et plans) 9h30 Anca Dan, Professeur attachée en sciences de l’Antiquité, ENS-PSL Cartes sur mosaïque : quelques chorographies antiques 10h Pause-café Première session Artistes-cartographes en Europe au XVIe siècle Sous la présidence de Gilles Palsky (Université Paris I) 10h15 Juliette Dumasy-Rabineau, maîtresse de conférences en histoire médiévale à l’université d’Orléans et Camille Serchuk,professeure d’histoire de l’art à la South Connecticut State University Les artistes cartographes français aux XVe et XVIe siècles 10h45 Jan Trachet, chercheur postdoctoral au département d’archéologie de l’Université de Gand et Bram Vannieuwenhuyze, professeur associé en histoire de la cartographie à l’Université d’Amsterdam Les cartes des artistes-cartographes à Bruges, 1557-1572 : des œuvres isolées ou collaboratives ? 11h15 Ulrike Gehring,professeur à l’Universität Trier Fb III – Art History, Coastal Profiles. The Interface between mimetic and cartographic representation 11h45 Présentation des œuvres exposées par les artistes Annie Lunardi et Marcoleptique 12h15 Pause déjeuner Seconde session Art et cartographie en France aux XVIIe et XVIIIe siècles Sous la présidence de Lucile Haguet (Bibliothèque municipale du Havre) 13h30 Pierre-Olivier Marchal, doctorant à l’EHESS – Centre Alexandre Koyré Représenter le territoire : une circulation des savoirs cartographiques dans l’œuvre de Jean-Baptiste et Pierre-Denis Martin (1659-1742) 14h Geoffrey Phelippot, doctorant à l’EHESS – Centre Alexandre Koyré Cartographie et bricolage ornemental : Nicolas Guérard à la Sphère Royale 14h30 Pause Troisième session 15h Art contemporain et cartographie Mathieu Pernot, photographe, et Monika Marczuk, chargée de collections à la BnF-CPL Cartes en mouvement 15h30-17h Table ronde « Art contemporain et cartographie : rencontres, échanges, déplacements » Animée par Jean-Marc Besse, avec : Ann Valérie Epoudry, artiste plasticienne, diplômée de Sciences-Po Paris, doctorante à l’École Nationale Supérieure d’Architecture de Toulouse (LRA) Guillaume Monsaingeon, philosophe, chercheur et commissaire d’exposition indépendant Florence Troin, géographe-cartographe CITERES-EMAM, CNRS & Université de Tours Pauline Guinard, maître de conférences HDR en géographie, ENS Contact : catherine.hofmann@bnf.fr Fichier pdf. du programme :

Programme-JE-CFC-histoire-INHA-25-novembre-2023Télécharger

-

sur Découvrez nos cartes dédiées aux Journées européennes du patrimoine 2023 - #1Jour1Carte

Publié: 15 September 2023, 10:00am CEST par Marine Faucher, Amandine Boivin

Cette année à l'occasion des Journées du patrimoine, nous vous avons concocté une collection de cartographies dédiées aux thèmes de la culture et du patrimoine. Au programme : les journées du patrimoines, les plus grands labels des villes et les jardins remarquables !

-

sur Bascule des géoservices de l'IGN vers une Géoplateforme

Publié: 15 September 2023, 6:36am CEST

Le programme Géoplateforme vise à doter la puissance publique d’une infrastructure collaborative et mutualisée pour la production et la diffusion des géodonnées. Son ambition est de permettre aux porteurs de politiques publiques et aux collectivités locales qui le souhaitent de bénéficier très simplement de fonctionnalités avancées pour diffuser leurs propres données et s’ouvrir à des communautés contributives. Cet espace, composante géographique de l'État-plateforme reconnue grand projet numérique de l'État, répond notamment aux enjeux de souveraineté des données de l’État face aux géants de l’Internet.La Géoplateforme s'inscrit pleinement dans la dynamique des Géo-communs soutenue par l'IGN. En effet, si l'institut a bien vocation à porter ses propres services sur la Géoplateforme, celle-ci se veut en premier lieu un outil commun au monde public. C'est la mobilisation progressive de partenaires, producteurs et usagers de données géographiques qui doit permettre d'atteindre cet objectif.

L'IGN informe les utilisateurs des géoservices du Géoportail d'une bascule vers sa nouvelle Géoplateforme. La date d’arrêt de l’infrastructure du Géoportail est fixée au 31 décembre 2023. Pour les internautes des sites web portés par l’IGN (Géoportail, Remonter le temps, Géoportail de l’Urbanisme…), c’est transparent.Pour découvrir les nouvelles fonctionnalités de la Géoplateforme

Les principaux changements pour tous les géoservices inhérents au passage à la Géoplateforme sont :

- Changements d’URL

L’usage du protocole [HTTPS] / TLS 1.2 est imposé pour accéder aux géoservices, sans exception possible.

Les géoservices ne sont plus accessibles via le Réseau Interministériel de l’État (RIE)- Changements du contrôle d’accès

Les actuelles « clés » Géoportail (personnelles et publiques) disparaissent, elles sont remplacées par un nouveau mécanisme de contrôle des accès sur les données non libres.

Pour les données à accès restreint (par exemple pour les SCAN 25®, SCAN 100® et SCAN OACI de l’IGN), un nouveau mécanisme de diffusion sera mis en place.

Par défaut, tout devient open source et accessible librement.- Principaux changements de certains géoservices

Les géoservices exposant des standards OGC n'exposent plus que la dernière version :

WMS 1.1 n’est plus supporté (seulement le 1.3)

WFS 1.0 n’est plus supporté (seulement le 2.0)

Le service d’auto-configuration disparaît (l’API JavaScript est adaptée en conséquence) (lien vers article ici)

Les flux INSPIRE intègrent les flux génériques de la Géoplateforme

Les services de téléchargement (via le site Géoservices) et de diffusion de données anciennes (via le site Remonter Le Temps) évoluent sans conservation des interfaces API actuellesLien ajouté le 27 septembre 2023

Le replay et le support de présentation du temps d'info #Géoplateforme consacré à la première version de [https:]] , le futur service public des cartes et données du territoire, sont disponibles ! #Géocommuns

— IGN France (@IGNFrance) September 27, 2023Articles connexes

Depuis le 1er janvier 2021, l'IGN rend ses données libres et gratuites

Les anciens millésimes de la BD Topo disponibles en téléchargement sur le site de l'IGN

Lidar HD : vers une nouvelle cartographie 3D du territoire français (IGN)

Zoom sur le service Edugéo (IGN) proposé à travers le portail de ressources Eduthèque

Chercher une carte IGN par thème d'études

Mise à disposition de la base Demandes de valeurs foncières (DVF) en open data

Carte lithologique de la France au 1/50 000e sur InfoTerre (BRGM)

DataFrance, une plateforme de visualisation de données en open data

Recension de liens pour se procurer des fonds de cartes SIG

-

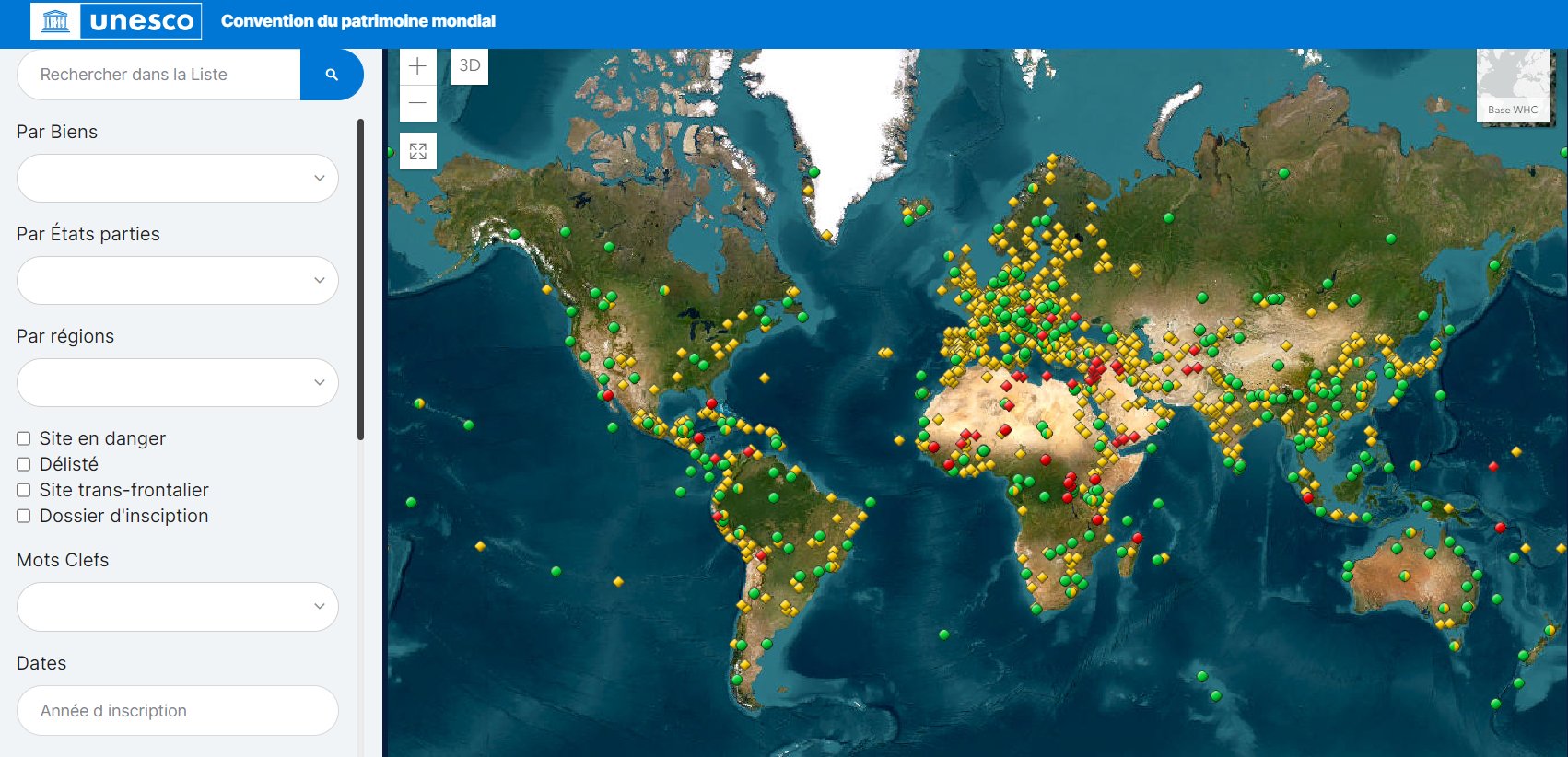

sur Plateforme de cartes en ligne du Patrimoine mondial de l'UNESCO

Publié: 14 September 2023, 8:01pm CEST

L'UNESCO lance une Plateforme de cartes en ligne du patrimoine mondial. Cet outil de suivi, lié aux bases de données existantes de l'UNESCO, affiche les sites géoréférencés du patrimoine mondial avec leurs zones tampons, et permet d'effectuer des opérations cartographiques de base. La plateforme est destinée aux États adhérents à la Convention du patrimoine mondial, aux gestionnaires de sites, aux organisations consultatives, à l'UNESCO et à bien d'autres acteurs.

Accès à la Plateforme de cartes en ligne du patrimoine mondial (source : UNESCO)

La plateforme SIG de l'UNESCO est destinée à :- Renforcer la protection de la valeur universelle exceptionnelle des biens du patrimoine mondial en fournissant aux États membres un système d’information géographique en ligne pour améliorer le suivi de leur état de conservation.

- Améliorer la qualité et la cohérence des cartes des biens du patrimoine mondial, pour faciliter l’accès et l’analyse des données géographiques du patrimoine mondial, afin de développer des systèmes de gestion adéquats.

- Faciliter la planification et la préparation d’évaluations d’impact sur le patrimoine, d’évaluations d’impact environnemental, ainsi que d’autres documents pertinents et complexes sur la base de cartes accessibles et précises des limites des biens du patrimoine mondial et de leurs zones tampons.

- Aider les développeurs de projets (y compris du secteur privé) à mieux comprendre les différentes limites de protection du patrimoine mondial et les guider dans l’évaluation de projets situés dans les limites ou à proximité d’un bien du patrimoine mondial. Il s’agit d’un outil directement pertinent pour la mise en œuvre de l’engagement à respecter des zones d’exclusion ou des projets relatifs à l’énergie éolienne.

Avec la mobilisation de ressources additionnelles, d’autres couches de données pourraient être ajoutées au système, à commencer par les facteurs affectant les biens tels qu’ils sont répertoriés dans le Système d’information sur l’état de conservation.

L’inscription d’un bien sur la liste du Patrimoine mondial est une reconnaissance de sa « valeur universelle exceptionnelle », qui le rend digne d’être préservé comme patrimoine de l’humanité. Les données sur le patrimoine mondial de l'UNESCO sont téléchargeables à partir d'une carte interactive. Les fichiers proposés sur cette page (format kml et xls) intègrent la géolocalisation des sites et permettent une réutilisation des données dans un globe virtuel ou un SIG. La base de données permet de distinguer les sites naturels, culturels ou mixtes (avec leur date d'inscription à la liste de l'UNESCO) ainsi que les sites en danger. Une recherche en plein texte permet, à partir de mots-clés, de raffiner la recherche à partir de certains critères. Il est possible par exemple de choisir en fonction des critères de sélection ayant présidé à leur inscription comme sites naturels, culturels ou mixtes.

Carte interactive avec accès aux données géolocalisées (source : UNESCO)

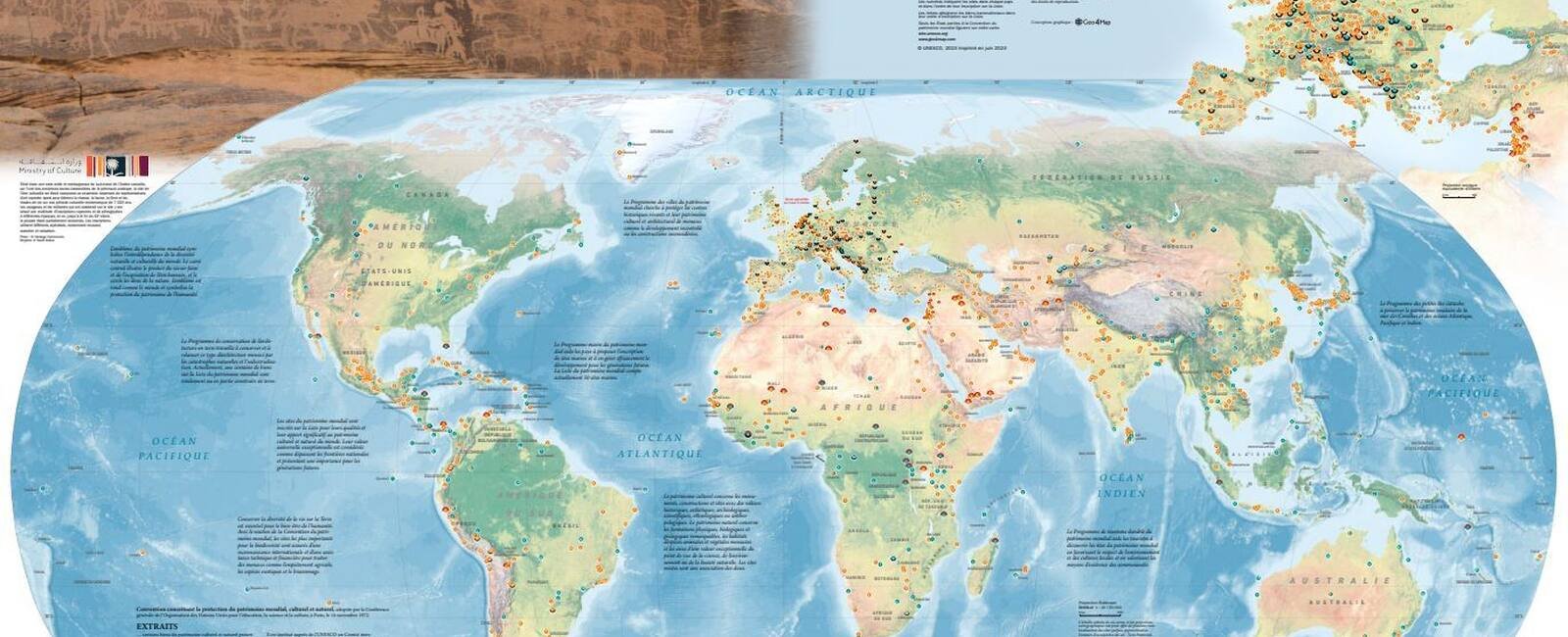

La carte du patrimoine mondial 2023 est disponible en haute résolution et dans différentes langues. Cette carte murale est disponible en téléchargement (avec la possibilité de comparer avec d'anciennes cartes depuis 2002).

Carte des sites du patrimoine mondial au format affiche murale (source : UNESCO)

Données disponibles sur la France :- Plate-forme de données ouvertes du ministère de la Culture (Data.culture.gouv.fr)

- Base des lieux et équipements culturels en France - Basilic (Data.gouv.fr)

- Base de données des Journées Européennes du Patrimoine en France (Data.gouv.fr)

- Liste et localisation des Musées de France (Data.gouv.fr)

Pour aller plus loin

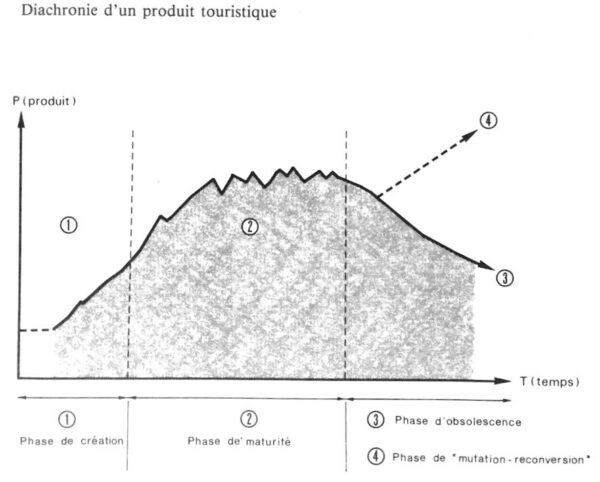

Lionel Prigent (2013). L'inscription au patrimoine mondial de l'Unesco, les promesses d'un label ? Revue internationale et stratégique 2013/2 (n° 90), p.127-135

Mélanie Duval, Ana Brancelj et Christophe Gauchon, Élasticité des normes et stratégies d’acteurs : analyse critique de l’inscription au patrimoine mondial de l’UNESCO, Géoconfluences, juin 2021.

Bernard Debarbieux (2020). Imaginaires et rhétoriques de la mondialité au patrimoine culturel immatériel de l’UNESCO. L’Espace géographique 2020/4 (Tome 49), p. 354-370.

Jean-Christophe Fichet (2020). Le patrimoine mondial de l’UNESCO en cartes. Carto-lycée.Articles connexes

Carte des événements des Journées européennes du patrimoine en France (2019)

L'histoire par les cartes : les cartes de la Société de documentation industrielle, un inventaire du patrimoine industriel de la France de l'entre-deux-guerres

Mise à disposition de la Base de données nationale des bâtiments (BDNB) en open data

France Pixel Bâti. Naviguer dans la structure du patrimoine bâti français en haute définitionEtudier les formes urbaines à partir de plans cadastraux

-

sur Colloque : “Cartographies et représentations des îles en Méditerranée (XVe- XXe siècles)”, Corte, 3-4-5 octobre 2023

Publié: 14 September 2023, 4:05pm CEST par Catherine Hofmann

Argumentaire scientifique

Au cours des trente dernières années le Musée de la Corse a constitué une collection de cartes et plans anciens exclusivement consacrés à l’île ainsi que plusieurs livres attachés à sa géographie historique. Ce fonds rassemble des figures cartographiques qui couvrent la période de 1520 à 1900. L’enrichissement progressif par acquisitions et la mise en œuvre d’un inventaire en ligne incitaient à mettre en lumière cet ensemble patrimonial sous trois formes complémentaires : sa publication sous forme d’un beau livre, sa présentation au public sous la forme d’une exposition, et enfin un colloque scientifique.

L’objet de ce colloque, au regard de l’exposition, est de replacer la cartographie de la Corse dans la perspective plus large de la représentation des îles en Méditerranée depuis le Moyen âge jusqu’à l’époque contemporaine, tant dans les techniques cartographiques utilisées que dans ses différents contextes politiques et intellectuels, aussi bien dans le monde arabe que dans la chrétienté occidentale. Il s’agira d’analyser la spécificité de la représentation de l’espace insulaire méditerranéen, et de ses enjeux territoriaux.

Le colloque dont les sessions sont prévues à Corte, dans les locaux de l’Université de Corse, les 3 et 4 octobre 2023, seront complétées le 5 octobre par une visite de l’exposition Cartografià. La Corse en cartes, au Musée et celle, ensuite, d’une présentation d’ouvrages anciens à la Bibliothèque patrimoniale Tommaso Prelà à Bastia.

Comité scientifique

Vannina Marchi van Cauvelaert, Maître de conférences en histoire du Moyen Âge (UMR 6240 LISA – Université de Corse)

Emmanuelle Vagnon-Chureau, Chargée de recherche CNRS en histoire du Moyen Âge (UMR 8589 LAMOP)

Pierre-Jean Campocasso (Direction du Patrimoine)

Direction scientifique

Maurice Aymard (EHESS)

Henri Bresc (Paris X Nanterre -Institut Européen en Sciences des Religions, Paris)

Coordination

Dominique Gresle, Commissaire de l’exposition, à l’initiative du colloque

Organismes partenaires

UMR 6240 Lieux Identités eSpaces Activités – Université de Corse

UMR 8589 Laboratoire de Médiévistique Occidentale de Paris – CNRS

Musée de la Corse – Collectivité de Corse

Participants

Christophe Austruy (EHESS)

Emiliano Beri (Univ. Genova)

Nathalie Bouloux (Université de Tours)

Lorenzo Brocada (Univ. Genova)

Philippe Colombani (Université de Corse)

Antoine Franzini (Univ. Gustave Eiffel, Marne -La- Vallée)

Catherine Hofmann (BNF – Cartes et plans)

Jean Charles Ducène (EPHE)

Frank Lestringant (Paris Sorbonne)

Joseph Martinetti (Univ. Côte d’Azur)

Paolo Militello (Univ. Catane)

Marie-Vic Ozouf-Marignier (Directeur d’études EHESS)

Pierre Portet (Conservateur général du Patrimoine. Archives de Corse)

Giampaolo Salice (Univ. Cagliari)

Georges Tolias (EPHE Paris – FNRS Athènes)

Programme

(Les exposés de 25 minutes seront suivis de 5 mn de discussion)

Mardi 3 octobre (Université de Corse, amphi à préciser)

9h Discours d’accueil et introduction scientifique des travaux

Maurice Aymard et Henri Bresc

10h- 13h première session : Les îles dans la cartographie médiévale arabe et latine

Henri Bresc

Edrisi au service de Roger II de Sicile

Jean Charles Ducène

La Corse dans la cartographie arabe

Vannina Marchi van Cauvelaert (MCF Hdr, Université de Corse)

Insularité et iléité : les représentations médiévales de la Corse et de la Sardaigne (XIIIe-XVe)

Emmanuelle Vagnon

Grandes et petites îles de Méditerranée occidentale dans les premières cartes marines

Nathalie Bouloux

Les îles de la Méditerranée occidentale (Corse, Sardaigne, Sicile) dans les manuscrits et les éditions de la Géographie de Ptolémée

Déjeuner (buffet)

15h-18h deuxième session : Cartes d’îles et insulaires au XVIe siècle

Antoine Franzini

La carte manuscrite de la Corse présente dans l’Atlas hydrographique de Vesconte Maggiolo (1512)

Georges Tolias

L’avènement de l’insulaire : hypothèses sur la genèse d’un genre.

Frank Lestringant (Sorbonne Université)

La Corse dans le Grand Insulaire d’André Thevet.

PH Colombani

La route des îles de la Couronne d’Aragon : dominer, unir, partager, une histoire méditerranéenne.

Dîner

Mercredi 4 octobre (Université de Corse)

9h30-12h30 troisième session : géopolitique des îles méditerranéennes à l’époque moderne

Maurice Aymard

Architectes militaires et/ou cartographes : la Sicile après Lépante. Représentation et défense du territoire.

Catherine Hofmann

La représentation des îles dans la cartographie marine à Marseille au XVIIe siècle. Le cas de l’Atlas Boyer (1648)

Christophe Austruy

Coronelli et l’Arsenal de Venise. Vraies légendes et fausses cartes.

Giampaolo Salice

Geopolitica e rivoluzione sociale nella conquista delle isole intermedie

tra Sardegna e Corsica.Emiliano Beri et Lorenzo Brocada

La Corsica di Accinelli: una missione strategica in chiave cartografica.

Déjeuner (buffet)

14h30-17h30 quatrième session : La Corse et les îles jusqu’à aujourd’hui

Marie -Vic Ozouf Marignier

Les représentations de la Corse dans les géographies illustrées (1880-1910).

Paolo Militello

James Boswell, Pasquale Paoli et Thomas Phinn dans l’ “Account of Corsica […] illustrated with a new and Accurate Map of Corsica” (1768).

Joseph Martinetti (MCF en géographie, Université Nice Côte d’Azur)Dans la continuité des isolarii, une nouvelle cartographie géopolitique des îles méditerranéennes est-elle possible ?

Dîner de clôture

Jeudi 5 octobre

Matinée : visite de l’exposition Cartografià. La Corse en cartes (Dominique Gresles, commissaire de l’exposition)

Puis transfert à Bastia pour la présentation d’ouvrages issus du fonds Tommaso Prelà

Affiche et programme pdf du colloque :

Colloque-Corte-3-5-octobre-2023-programmeTélécharger Affiche-du-colloqueTélécharger

-

sur Makina Corpus sponsorise la DrupalCon Lille 2023

Publié: 14 September 2023, 11:00am CEST par Amandine Boivin

La DrupalCon 2023 revient en France du 17 au 20 octobre et notre équipe y participe

-

sur Oslandia signe un partenariat avec OPENGIS.ch sur QField

Publié: 14 September 2023, 9:00am CEST par Vincent Picavet

Qui sommes nous ? Pour ceux qui ne connaissent pas Oslandia, ou OpenGIS.ch, ou même QGIS, rafraichissons les mémoires :

Pour ceux qui ne connaissent pas Oslandia, ou OpenGIS.ch, ou même QGIS, rafraichissons les mémoires :

Oslandia est une entreprise française spécialisée dans les systèmes d’information géographique opensource (SIG). Depuis notre création en 2009, nous proposons des services de conseil, de développement et de formation en SIG, avec une expertise reconnue. Oslandia est un « pure-player » opensource, et le plus grand contributeur français à la solution QGIS.

Oslandia est une entreprise française spécialisée dans les systèmes d’information géographique opensource (SIG). Depuis notre création en 2009, nous proposons des services de conseil, de développement et de formation en SIG, avec une expertise reconnue. Oslandia est un « pure-player » opensource, et le plus grand contributeur français à la solution QGIS.

Quant à OPENGIS.ch , il s’agit d’une entreprise Suisse spécialisée dans le développement de logiciels SIG open-source. Fondée en 2011, OPENGIS.ch est de son côté le plus grand contributeur suisse à la solution QGIS. OPENGIS.ch est le créateur de QField, la solution de SIG mobile open-source la plus utilisée par les professionnels de la géomatique.

Quant à OPENGIS.ch , il s’agit d’une entreprise Suisse spécialisée dans le développement de logiciels SIG open-source. Fondée en 2011, OPENGIS.ch est de son côté le plus grand contributeur suisse à la solution QGIS. OPENGIS.ch est le créateur de QField, la solution de SIG mobile open-source la plus utilisée par les professionnels de la géomatique.OPENGIS.ch propose également QFieldCloud en tant que solution SaaS ou on-premise pour la gestion collaborative des projets de saisie terrain.

Certains ne connaissent pas encore #QGIS ?

Certains ne connaissent pas encore #QGIS ?

Il s’agit d’un système d’information géographique libre et opensource qui permet de créer, éditer, visualiser, analyser et publier des données géospatiales. Multiplateforme, QGIS est utilisable sur ordinateur, serveur, en application web ou comme bibliothèque de développement.

QGIS est un logiciel libre développé par de multiples contributeurs dans le monde entier. C’est un projet officiel de la fondation OpenSource Geospatial OSGeo et soutenu par l’association QGIS.org. cf [https:]]

Un partenariat ? Nous sommes aujourd’hui heureux d’annoncer notre partenariat stratégique visant à renforcer et à promouvoir QField, l’application mobile de la solution SIG opensource QGIS.

Nous sommes aujourd’hui heureux d’annoncer notre partenariat stratégique visant à renforcer et à promouvoir QField, l’application mobile de la solution SIG opensource QGIS. Ce partenariat entre Oslandia et OPENGIS.ch est une étape importante pour QField et les solutions SIG mobiles opensource, qui permettra de consolider la plateforme, en offrant aux utilisateurs du monde entier un accès simplifié à des outils efficaces pour la collecte, la gestion et l’analyse des données géospatiales sur le terrain.

Ce partenariat entre Oslandia et OPENGIS.ch est une étape importante pour QField et les solutions SIG mobiles opensource, qui permettra de consolider la plateforme, en offrant aux utilisateurs du monde entier un accès simplifié à des outils efficaces pour la collecte, la gestion et l’analyse des données géospatiales sur le terrain. QField, développé par OPENGIS.ch, est une application mobile opensource de pointe qui permet aux professionnels des SIG de travailler en toute efficacité sur le terrain, en utilisant des cartes interactives, en collectant des données en temps réel et en gérant des projets géospatiaux complexes sur des appareils mobiles Android, IOS ou Windows.

QField, développé par OPENGIS.ch, est une application mobile opensource de pointe qui permet aux professionnels des SIG de travailler en toute efficacité sur le terrain, en utilisant des cartes interactives, en collectant des données en temps réel et en gérant des projets géospatiaux complexes sur des appareils mobiles Android, IOS ou Windows.

QField est multiplateforme, basée sur le moteur QGIS, et permet donc un partage des projets de manière fluide entre les applications bureautiques, mobiles et web.

QField est multiplateforme, basée sur le moteur QGIS, et permet donc un partage des projets de manière fluide entre les applications bureautiques, mobiles et web.

On en dit quoi ? QFieldCloud ( [https:]] ), la plateforme web collaborative de gestion de projets QField, bénéficiera également du partenariat, et pourra être enrichie pour compléter la gamme d’outils de la solution QGIS.

QFieldCloud ( [https:]] ), la plateforme web collaborative de gestion de projets QField, bénéficiera également du partenariat, et pourra être enrichie pour compléter la gamme d’outils de la solution QGIS. Côté Oslandia, nous sommes très heureux de collaborer avec OPENGIS.ch sur les technologies QGIS. Oslandia partage avec OPENGIS.ch une vision commune du développement de logiciel libre et opensource : une implication forte dans les communautés de développement, un travail dans le respect de l’écosystème, une très grande expertise, et une optique de développement logiciel de qualité industrielle, robuste et pérenne.

Côté Oslandia, nous sommes très heureux de collaborer avec OPENGIS.ch sur les technologies QGIS. Oslandia partage avec OPENGIS.ch une vision commune du développement de logiciel libre et opensource : une implication forte dans les communautés de développement, un travail dans le respect de l’écosystème, une très grande expertise, et une optique de développement logiciel de qualité industrielle, robuste et pérenne. Avec ce partenariat, nous souhaitons proposer à nos clients la plus grande expertise possible sur l’ensemble des composants logiciels de la plateforme QGIS, depuis la captation de la donnée jusqu’à sa diffusion.

Avec ce partenariat, nous souhaitons proposer à nos clients la plus grande expertise possible sur l’ensemble des composants logiciels de la plateforme QGIS, depuis la captation de la donnée jusqu’à sa diffusion. Côté OpenGIS.ch, Marco Bernasocchi ajoute :

Côté OpenGIS.ch, Marco Bernasocchi ajoute :

L’engagement pour l’opensourceLe partenariat avec Oslandia représente une étape cruciale dans notre mission visant à fournir des outils SIG mobiles de premier plan avec un réel crédo OpenSource. La complémentarité de nos compétences permettra d’accélérer le développement de QField ainsi que de QFieldCloud, et de répondre aux besoins croissants de nos utilisateurs .

Prêts pour le terrain ? Nos deux entreprises s’engagent à continuer à soutenir et à améliorer QField et QFieldCloud en tant que projets opensource, garantissant ainsi un accès universel à cette solution de SIG mobile de haute qualité sans aucune dépendance à un fournisseur.

Nos deux entreprises s’engagent à continuer à soutenir et à améliorer QField et QFieldCloud en tant que projets opensource, garantissant ainsi un accès universel à cette solution de SIG mobile de haute qualité sans aucune dépendance à un fournisseur. Et vous, êtes vous prêts pour le terrain ?

Et vous, êtes vous prêts pour le terrain ?Alors téléchargez QField ( [https:]] ) , créez des projets sur QGIS, partagez-les sur QFieldCloud !

Si vous avez besoin de formation, support, maintenance, déploiement ou développement de fonctionnalités spécifiques sur ces plateforme, n’hésitez pas à nous contacter, vous aurez les meilleurs experts disponibles : infos+mobile@oslandia.com

Si vous avez besoin de formation, support, maintenance, déploiement ou développement de fonctionnalités spécifiques sur ces plateforme, n’hésitez pas à nous contacter, vous aurez les meilleurs experts disponibles : infos+mobile@oslandia.com

-

sur Le forum d'OpenstreetMap, un lieu d'échange autour des enjeux de la cartographie collaborative et de l'open data

Publié: 13 September 2023, 8:33pm CEST

Le forum d'OpenStreetMap (@OSM_FR) est très intéressant à observer et à analyser pour appréhender les enjeux actuels concernant la cartographie collaborative et l'open data en matière de géodonnées.

Les débats concernent notamment la place et le rôle que doit jouer OpenStreetMap en tant que première plateforme de crowdsoucing, en lien avec la question délicate de la coopération possible (souhaitable ?) avec des entreprises privées. Voir par exemple le problème de la réutilisation d'images haute résolution venant d'autres fournisseurs (Maxar ou autres...). Il s'agit aussi d'anticiper les évolutions et réfléchir à la manière de faire évoluer le modèle de données ouvertes avec des enjeux importants sur la façon de valoriser le modèle attributaire d’OSM. Plus la quantité de données augmente et plus le besoin de standardiser les structures est important. OpenStreetMap présente l’avantage de n’avoir qu’un unique espace sémantique, obligeant la communauté à tenir en cohérence des concepts bien différents qui ne le sont habituellement pas (les bâtiments et la voirie proche, les routes et les réseaux électriques…). Voir la consultation de la communauté sur cette question d'évolution du modèle de données.

Les enjeux en termes d'éducation et formation ne sont pas oubliés, à travers une rubrique EducOSM. Sur cette page, est présenté notamment l'enseignement des Sciences numériques et Technologie (SNT) dans les établissements scolaires. Paru au bulletin officiel de l’Éducation nationale, de la jeunesse et des sports, le bulletin officiel spécial n°1 du 22 janvier 2019 fixe le programme d’enseignement de Sciences Numériques et Technologie de la classe de seconde générale et technologique. Dans le programme en annexe (page 15), dans la thématique Localisation, cartographie et mobilité, il est fait mention de contenus dans lesquels on trouve la capacité attendue "Contribuer à OpenStreetMap de façon collaborative". La communauté OpenStreetMap propose de comparer 7 manuels scolaires de seconde qui traitent de cette capacité (Les manuels scolaires et OSM, quels traitements en SNT ?). Des pistes d'activités pédagogiques sont également proposées autour de "Carto-parties" qui exploitent les données OSM et permettent d'initier à la cartographie collaborative (Carto-Partie au lycée agricole de Beaulieu). Les "bonnes pratiques" pour contribuer à OpenStreetMap en SNT sont décrites sur le site de la DANE de l'académie de Lyon, qui est mis à jour régulièrement. Une page OpenstreetMap, la cartographie collaborative ! présente en détail l'intérêt d'utiliser OSM et de construire des activités pédagogiques avec cet outil open source pour initier et faire réfléchir aux enjeux de la cartographie collaborative et de l'open data.

Articles connexes

Autour d’OpenStreetMap, les tensions grandissent sous l'influence des entreprises

L'évolution de la cartographie humanitaire au sein de la communauté OpenStreetMap

Une cartographie très précise des densités à l'échelle mondiale pour améliorer l'aide humanitaire

Utiliser la grille mondiale de population de la plateforme Humanitarian Data Exchange

Microsoft met en téléchargement 800 millions d'empreintes de bâtiments

Tentative de "caviardage cartographique" à l'avantage de la Chine dans OpenStreetMap

-

sur Panoramax, l’alternative libre pour photo-cartographier les territoires

Publié: 13 September 2023, 1:36pm CEST

Panoramax fédère les initiatives (des collectivités, des contributeurs OSM, de l’IGN...) pour favoriser l'émergence d'un géocommun de bases de vues immersives. Aujourd’hui l’utilisation de photos/vues immersives de rues via Google StreetView et/ou Mapillary, ou via des prestations privées (ESRI/Cyclomédia, SOGEFI etc.) ouvre pas mal d’opportunités en termes de rationalisation des déplacements, facilitation et accélération du recueil d’information nécessaire aux traitements de certaines procédures et finalement d’amélioration de la connaissance du territoire. La collecte, le partage et l’utilisation de ces données restent cependant compliqués : problème de licences, dépendance à des sociétés privées dont la stratégie n’est pas orientée vers l’ouverture des données ou dont la stratégie n’est pas claire, difficulté à partager des bonnes pratiques, à s’assurer de la pérennité d’une solution pour y appuyer des usages métiers à partager, etc.

A terme, Panoramax pourrait devenir une sorte de StreetView à la française, mais il est encore trop tôt pour savoir quel sera l'avenir du projet. Il existe déjà une application semblable Mapillary qui semble rencontrer un succès important à l'échelle mondiale, même si la finalité est un peu différente. Sur Panoramax, les photos sont fournies par la communauté, hébergées sur plusieurs instances, disponibles en licence CC-BY-SA 4.0 et téléchargeables en pleine résolution. Il est d'ores et déjà possible d'y déposer des images et de l'utiliser en lien avec différentes applications cartographiques (notamment QGIS).

- Interface de versement des photos sur le forum Géocommuns.

- Contribution sur GitHub

- Plugin Panoramax pour Q-Gis

- Synchronisation avec JOSM

L'équipe est portée par La Fabrique des géocommuns et sponsorisée par Institut national de l'information géographique et forestière : La Fabrique des géocommuns, incubateur de communs à l’IGN. Lancée en 2021, la Fabrique a pour ambition d'initier et d'accompagner le développement de services publics numériques construits autour de géocommuns.Articles connexes

Pour aider à géolocaliser des photographies, Bellingcat propose un outil de recherche simplifié à partir d'OpenStreetMap

L'évolution de la cartographie humanitaire au sein de la communauté OpenStreetMap

Autour d’OpenStreetMap, les tensions grandissent sous l'influence des entreprises

Facebook prend le contrôle de Mapillary, le principal concurrent de Google Street View

Google Street View et sa couverture géographique très sélective

-

sur Iota2 ne fait pas que de la classification, elle fait aussi des indicateurs environnementaux !

Publié: 13 September 2023, 11:51am CEST par fauvelm

Contexte scientifiqueLe projet SOCCROP, qui a été financé par l’association Planet A, avait pour objectif de développer un indicateur pour quantifier les échanges annuels de CO2 entre les parcelles cultivées et l’atmosphère. Mesurer les flux permet d’accéder à l’évolution des stocks de carbone des sols agricoles. Cet indicateur peut être utile dans différents contextes :

- pour les inventaires nationaux d’émissions de gaz à effet de serre (GES),

- en tant qu’indicateur de l’effet des pratiques sur les bilans de C pour la Politique Agricole Commune (PAC)

- pour quantifier l’évolution des stocks de C pour les marchés du C en agriculture.

Cet indicateur ayant été au préalable testé sur de petites zones en Europe, un des objectifs du projet SOCCROP était de tester la possibilité de l’appliquer sur de vastes territoires et dans des contextes pédoclimatiques plus contrastés (i.e. sur plusieurs continents).

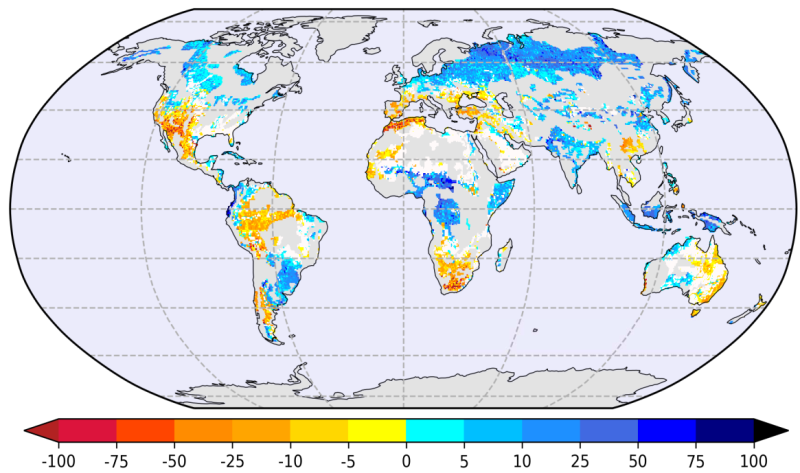

Cet indicateur est calculé en utilisant la chaîne de traitement iota2 à partir des images Sentinel-2 de niveaux 2A afin d’estimer la fixation nette du CO2 trimestrielle sur un an. L’indicateur du projet SOCCROP est basé sur une méthodologie très similaire à celle de l’indicateur “Carbon Tier 1” (CT1) développé dans le cadre du projet H2020 NIVA. Le CT1 NIVA avait été développé en se basant sur la relation empirique décrite par Ceschia et al. (2010) reliant le flux net annuel de CO2 (NEP, pour Net Ecosystem Production) aux nombres de jours où la végétation est photosynthétiquement active (NDAV pour “Number of days of active végétation”) (Figure 1).

Figure 1: Flux net annuel de CO2 en fonction des jours où la végétation est active

Figure 1: Flux net annuel de CO2 en fonction des jours où la végétation est active

Cette relation s’appuie sur une quarantaine d’années de mesures de flux net de CO2 obtenues par la méthode d’Eddy covariance des fluctuations turbulentes, cumulées sur une quinzaine de sites en Europe (couvrant une large gamme de pédoclimats et types de culture). Cette relation est applicable aux principales grandes cultures en Europe. L’indicateur NIVA CT1 utilise donc cette relation relativement simple pour estimer le flux net de CO2 à partir de l’observation du nombre de jours où la végétation est active (NDAV) :

NEP = a · NDAV + b (1)

où les paramètres a et b ont été calibrés sur des mesures de flux du réseau ICOS réalisées en Europe selon

et

et  avec des erreurs respectives de

avec des erreurs respectives de  et

et  . Une expression analytique de l’incertitude peut être dérivée pour cet indicateur. Elle combine l’incertitude intrinsèque du modèle de régression (contenue dans l’incertitude des paramètres) avec l’incertitude sur la mesure du NDAV. Elle s’écrit :

. Une expression analytique de l’incertitude peut être dérivée pour cet indicateur. Elle combine l’incertitude intrinsèque du modèle de régression (contenue dans l’incertitude des paramètres) avec l’incertitude sur la mesure du NDAV. Elle s’écrit :

A ce stade, l’idée naturelle est d’utiliser la télédétection pour estimer le NDAV. Cela repose toutefois sur l’hypothèse forte que la végétation verte observée par satellite est toujours active d’un point de vue photosynthèse. A partir d’images optiques, on produit un indice de végétation comme le NDVI. Dans le cadre du CT1 NIVA, nous avons fait l’hypothèse que le NDAV est bien approximé en comptant le nombre de jours où le NDVI est supérieur ou égal à 0.3 qui est une valeur typique caractérisant un sol nu.

Cependant, dans le cadre du projet SOCRROP, plusieurs améliorations ont été suggérées pour améliorer la précision de l’indicateur. En particulier la prise en compte de variables climatiques comme la température de l’air et le rayonnement global. En effet, en fonction des conditions climatiques, la végétation et le sol n’ont pas le même niveau d’activité.

Ainsi, une analyse précise des données expérimentales du réseau de stations de flux Européennes labellisées par ICOS montre que le modèle initial (1) peut être modifié sous la forme suivante :

(2)

(2)où

est le nombre de jours vert,

est le nombre de jours vert,  est le nombre de jours durant lesquels la respiration du sol est potentiellement plus active car il fait chaud, et c et d sont des paramètres de régression. Dans ce contexte,

est le nombre de jours durant lesquels la respiration du sol est potentiellement plus active car il fait chaud, et c et d sont des paramètres de régression. Dans ce contexte,  est défini comme le nombre de jours où NDVI >0.3.

est défini comme le nombre de jours où NDVI >0.3.  est définie comme le nombre de jours tel que NDVI <0.3 et tel que le rayonnement global est supérieur à un certain seuil

est définie comme le nombre de jours tel que NDVI <0.3 et tel que le rayonnement global est supérieur à un certain seuil  . La calibration de ce modèle sur les données flux du réseau ICOS permet d’obtenir que

. La calibration de ce modèle sur les données flux du réseau ICOS permet d’obtenir que  ,

,  et

et  . Comme pour l’indicateur originel, l’expression analytique de l’incertitude peut être dérivée comme :

. Comme pour l’indicateur originel, l’expression analytique de l’incertitude peut être dérivée comme : (3)

(3)Dans le cadre du projet SOCCROP, c’est l’indicateur (2) avec son incertitude (3) qui sont considérés. Cependant, pour des raisons d’analyse, l’information du nombre de jours de vert peut se révéler intéressante. Ainsi, il a aussi été décidé de conserver le nombre de jours de vert par trimestre.

Enjeux du projetL’enjeu essentiel de ce projet pour l’équipe CS GROUP était de démontrer le passage à l’échelle du code développé par l’INRAe sur un environnement cloud en optimisant les temps de calcul et les coûts associés. Pour démontrer ce passage à l’échelle, 180 tuiles Sentinel-2 ont été produites avec cette chaîne. Ces tuiles couvrent, sur une année agricole entière, 4 pays européens (Belgique, Espagne, Italie et Pays-Bas) ainsi que qu’un ensemble de zones éco-climatiques variées en Australie, au Brésil, aux États-Unis (plus précisément en Géorgie au cœur de la Corn Belt) et au Sénégal.

Figure 2 : Répartition des tuiles

Ce démonstrateur a été déployé sur l’infrastructure d’AWS, sur leur centre de calcul de Frankfurt pour bénéficier d’un accès optimisé aux données Sentinel-2 et de leur service d’orchestration de traitement serverless et managé Fargate. Pour ce faire, les chaînes de traitements MAJA et iota2 ont été instanciées et configurées pour produire rapidement les cartes d’indices voulues en optimisant les coûts. L’objectif final de cette démonstration étant d’anticiper et d’estimer le coût d’une production annuelle de l’indice SOCCROP sur l’ensemble des surfaces continentales.

Aspects techniques de la chaîne de traitement SOCCROPLa chaîne de traitement SOCCROP, mise en œuvre par CS Group, est constituée de 2 blocks de traitements, illustrée dans la figure 2, permettant la récupération des données Sentinel-2 et la production de l’indice.

Figure 3 : Schéma des différents blocs de la chaîne de traitement SOCCROP

Figure 3 : Schéma des différents blocs de la chaîne de traitement SOCCROP

Pour les données Sentinel-2 L2A non disponibles sur le site THEIA, la chaîne MAJA est utilisée pour produire des réflectances de surface (niveau 2A) à partir des images Sentinel-2 de niveau 1C. La chaîne MAJA a été choisie car elle permet la détection précise des nuages et de leurs ombres ainsi que la correction des effets atmosphériques sur des séries temporelles d’images. La précision des masques de nuages obtenus par MAJA offre une meilleure précision à l’indicateur SOCCROP qui est très sensible aux altérations du signal (nuage, saturation, ombre). Cette précision est nécessaire car elle évite les propagations d’erreurs lors d’étapes comme le sur échantillonnage temporel.

De plus, MAJA, dans ses dernières versions, offre la possibilité de ne produire qu’une partie des sorties (réflectances de surface ou masques) ce qui permet d’optimiser les temps de production et de réduire les volumes de donnés à stocker sur une année. En effet, seules les bandes rouges et proche-infrarouges et 3 masques (les masques de nuage, de saturation et de bord) sont nécessaires pour le calcul de l’indice SOCCROP par « iota2 ».

Le second pipeline encapsule la chaîne iota2 qui calcule l’indice de carbone à partir des bandes rouges et proche-infrarouges des produits L2A. La boite à outils iota2 dispose de nombreuses fonctions permettant entre autres de calculer des cartes d’indices spectraux. La chaîne gère de manière automatique les données d’entrées, la configuration de la méthode d’interpolation temporelle et de correction des nuages. Elle offre également la possibilité d’exploiter des données tierces, comme les informations d’ensoleillement et de température disponible dans les données ERA5. De même, pour alléger les coûts de stockage et de calcul, iota2 a été modifié pour ne prendre en compte que les bandes et les masques nécessaires. Grâce à ces améliorations, l’espace stocké des images a pu être réduit de moitié et le temps de production des cartes diminué significativement. Le traitement par tuile natif de iota2 et les traitements hautement parallélisés offert par l’OrfeoToolBox [https:] bibliothèque de traitement d’images sur laquelle les deux chaînes de traitement sont basées, ainsi que les capacités de distribution de traitements du service Fargate d’AWS ont permis de réaliser la production annuelle sur les 180 tuiles en un peu moins d’une semaine (hors temps de récupération des produits L2A depuis Theia).

Au final, les cartes trimestrielles d’indice carbone SOCCROP sont produites sous la forme d’une image multi–bandes :

- Bande 1 : Nombre de jour de vert pour le premier trimestre

- Bande 2 : Nombre de jour de vert pour le deuxième trimestre

- Bande 3 : Nombre de jour de vert pour le troisième trimestre

- Bande 4 : Nombre de jour de vert pour le quatrième trimestre

- Bande 5 : Indicateur de flux net annuel de CO2 (gC/m²) (Equation 3)

- Bande 6 : Incertitude de l’indicateur (Equation 4)

Figure 3 : Cartographie du flux net annuel de CO2 pour l’année 2019 en tC de CO2/ha à l’échelle pixel Sentinel 2 (10m) (Gauche). Cartographie du flux net annuel de CO2 pour l’année 2020 (Droite). Les trois lettres indiquées pour chaque culture correspondent aux codes de cultures du RPG : MIS pour maïs grain, BTH pour blé tendre d’hiver, CZH pour colza d’hiver, SOG pour sorgho, PPH pour prairie permanente, LUZ pour luzerne, SOJ pour soja, MLO pour mélange d’oléagineux, TRN pour tournesol…voir [https:]Le tableau 1 présente les temps moyens de traitement pour chaque étape du pipeline. Le temps requis pour le traitement par MAJA est relativement long dans la mesure où une année entière de données Sentinel-2 est traitée d’un trait. Un découpage de la période temporelle pourrait être réalisé pour distribuer ces calculs, mais cela peut avoir un impact sur la qualité des produits. Les cartes de carbone sont produites en environ 7h par iota2. Ici la majorité du temps est dépensée dans l’interpolation temporelle de la série annuelle.

Temps de traitements des données L1C (peps)

Temps de traitement des données L2A (théia)

Traitement par MAJA : 72h

Téléchargement L2A : 7h

Traitement iota2 : 7h

Traitement iota2 : 7h

Temps de traitement d’une tuile L1C : 79h

Temps de traitement d’une tuile L2A : 14h

Tableau 1 : Coût d’exploitation d’une tuile pour une année de données Sentinel-2, dans le cadre SOCCROP

Conclusion et perspectivesLa collaboration entre l’équipe CS GROUP et l’INRAE a permis de démontrer la possibilité d’un passage à l’échelle du code développé par l’INRAe sur un environnement cloud en optimisant les temps de calcul et les coûts associés. Cet outil nous a permis d’estimer les flux nets annuel de CO2 des principales grandes cultures sur une bonne partie de l’Europe de l’Ouest et sur plusieurs autres zones test dans le monde grâce à l’utilisation des données Sentinel-2 et de la chaine iota2. L’indicateur a montré une bonne cohérence avec les pratiques connues sur le terrain comme la mise en œuvre de cultures intermédiaires (ex. en Bretagne ou en Géorgie).

C’est donc une approche assez opérationnelle permettant d’estimer un indicateur lié au bilan C des grandes cultures dans une optique de versement de primes environnementales (éco-schèmes) pour la PAC ou dans un contexte d’inventaires nationaux d’émissions de GES. Cependant cette approche ne permet pas de prendre en compte l’effet de l’ensemble des pratiques sur les bilans C des parcelles. Pour ce faire, il faudrait intégrer au calcul de l’indicateur des données relatives aux récoltes et aux amendements organiques (ce qui correspond à la méthode TIER 2 du projet NIVA). C’est cette méthode qui serait à privilégier dans le cadre d’un financement des agriculteurs en fonction de la quantité de carbone qu’ils stockent. Pour y parvenir, les agriculteurs et les autorités devraient s’accorder pour que les données de pratiques soient accessibles à l’échelle de la parcelle.

L’approche a toutefois montré ses limites dans les zones à fort ennuagement comme en Belgique ou au Brésil. Pour une production opérationnelle à l’échelle globale, il serait donc nécessaire d’utiliser des données satellitales radar (ex. Sentinel-1) en complément des données optiques Sentinel-2. L’utilisation des donnes Sentinel-1 pour interpoler de manière opérationnelle les trous dans les séries temporelles de NDVI issues de Sentinel-2 est explorée par plusieurs unités de recherches. Ce n’est donc probablement qu’une question de temps avant que l’approche mise en œuvre dans le cadre de SOCCROP puisse être appliquées de manière opérationnelle à l’échelle globale en s’appuyant sur l’utilisation combinée des données Sentinel 1 et 2.

ContributeursPour le CESBIO-INRAe: Ludovic Arnaud, Mathieu Fauvel et Eric Ceschia

Pour CS-Group: Alice Lorillou, Mickael Savinaud et Benjamin Tardy

-

sur CumaCalc : un outil de calcul pour établir les coûts de revient prévisionnels d'investissement en CUMA

Publié: 13 September 2023, 11:30am CEST

Suite à la création de mycumalink pour Fédération Nationale des CUMA, une plateforme de mise en relation et la mutualisation de matériel agricole des C

-

sur Le Satellite Pléiades Neo : L’Ère de l’Imagerie Terrestre de Haute Résolution

Publié: 13 September 2023, 11:17am CEST par GHALIM

Cet article Le Satellite Pléiades Neo : L’Ère de l’Imagerie Terrestre de Haute Résolution est apparu en premier sur Veille cartographique 2.0.

Depuis leur lancement en avril 2021, les satellites Pléiades Neo, exploités par Airbus Defence and Space, ont apporté une révolution dans le domaine de l’observation de la Terre. Cette nouvelle génération de satellites d’observation offre des capacités inégalées en matière d’imagerie terrestre de haute résolution. Leur technologie avancée, leur agilité et leur précision font de […]

Cet article Le Satellite Pléiades Neo : L’Ère de l’Imagerie Terrestre de Haute Résolution est apparu en premier sur Veille cartographique 2.0.

-

sur Les SIG au service de l’agriculture : le Drone Agricole d’ESRI

Publié: 12 September 2023, 2:12pm CEST par LisaFontaine

Cet article Les SIG au service de l’agriculture : le Drone Agricole d’ESRI est apparu en premier sur Veille cartographique 2.0.

Alors qu’un précédent article vous avez présenté les bénéfices des systèmes d’information géographique dans l’agriculture moderne, nous revenons aujourd’hui sur ce sujet pour aborder de manière plus spécifique la nouvelle avancée de la société ESRI : le Drone Agricole. Comme mentionné précédemment, les Systèmes d’Information Géographique (SIG) associés aux dernières avancées technologiques jouent aujourd’hui un […]

Cet article Les SIG au service de l’agriculture : le Drone Agricole d’ESRI est apparu en premier sur Veille cartographique 2.0.

-

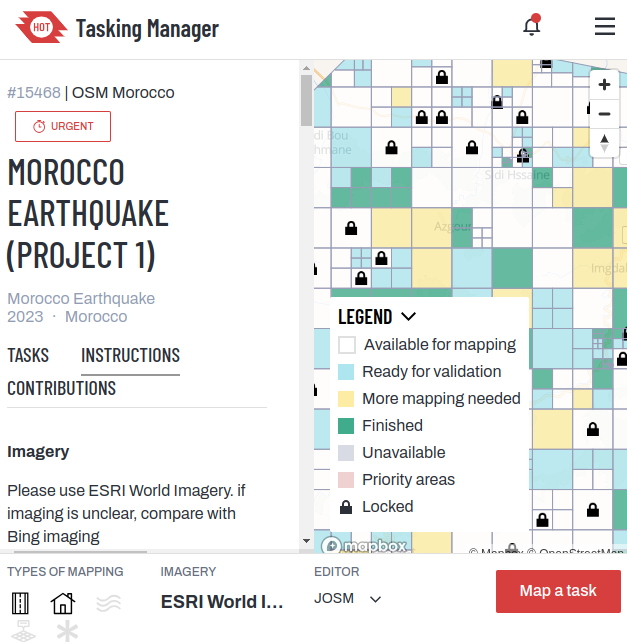

sur La cartographie au service des secouristes : le cas du séisme au Maroc

Publié: 11 September 2023, 10:31am CEST par Andriamasomanana

Cet article La cartographie au service des secouristes : le cas du séisme au Maroc est apparu en premier sur Veille cartographique 2.0.