Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

2772 éléments (101 non lus) dans 55 canaux

Dans la presse

(44 non lus)

Dans la presse

(44 non lus)

Du côté des éditeurs

(9 non lus)

Du côté des éditeurs

(9 non lus)

Toile géomatique francophone

(38 non lus)

Toile géomatique francophone

(38 non lus)

Toile géomatique francophone

Toile géomatique francophone

-

sur Arrêté du 2 octobre 2023 portant nomination au Conseil national de l'information géolocalisée

Publié: 8 October 2023, 11:26am CEST

Arrêté du 2 octobre 2023 portant nomination au Conseil national de l'information géolocalisée

-

sur Loren Munk et ses œuvres d'art en forme de datavisualisations

Publié: 8 October 2023, 7:07am CEST

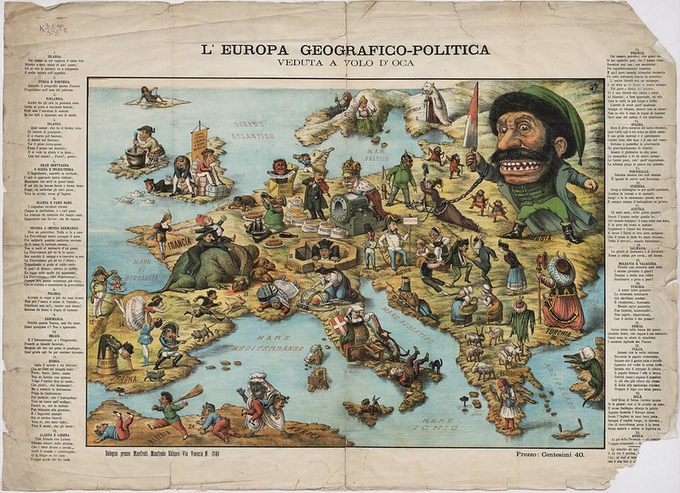

Le peintre Loren Munk réalise des œuvres d'art en forme de datavisualisations. L'artiste a une véritable obsession pour le monde de l’art new-yorkais. Ses oeuvres représentent plus largement les lieux, les histoires, les mouvements et les ontologies du monde de l'art. Sa carte de Soho avec ses innombrables galeries d'art a fait l'objet d'une publication récente dans le New York Times. Sa carte des Avant-gardes européennes de l’Après-guerre se présente comme un véritable labyrinthe, à l'image des nombreux groupes artistiques qui se sont réclamés du mouvement avant-gardiste avant que la publicité ne le vide quasiment de son sens.Extraits des oeuvres d'art de Loren Munk déposées dans la collection David Rumsey (crédit : David Rumsey Map Collection)

« Les cartes criardes que M. Munk peint depuis plusieurs années sont expriment en susbtance sa fixation. Suggérant une admiration pour les dessins animés d'Ad Reinhardt et les formes lumineuses et tactiles de Stuart Davis, celles-ci retracent le flux et le reflux des musées, des expositions, des galeries et surtout de leurs artistes et de leurs studios avec une vivacité implacable et un peu d'esprit » (Loren Munk : Location, Location, Location, Mapping the New York Art World, New York Times, 2011)

La collection David Rumsey contient 15 cartes de Loren Munk :

- The Secret History of American Art, 2005

- Clement Greenberg, 2006

- The East Village, an Attempted Documentation, 2013

- A Simple Hermeneutic Circle of Aesthetics, 2014

- Some California Artists, 2014

- 18 Situations Over 6 Decades, (Hofmann, to SoHo, to Chelsea), 2016

- SoHo: Hell’s Hundred Acres 1960 – 2000, 2016

- The Ontology of Painting, 2017

- Colliding Timelines of the Pictures Generation, 2018

- Post WWII European Avant-Gardes, 2019

- Aesthetics of Transcendence Versus Aesthetics of Distinction, 2019

- The Evolution of the Hermeneutic Circle, 2020

- Paradigm Shifts Within Ideological Epochs, 2021

- The Bowery and the Lower East Side, 2022

- The History of Western Aesthetics, 2023

Des cartes du monde dans le style d'artistes célèbres créées par intelligence artificielle

Articles connexes

Ground Plan. Le monde vu comme un plan de bâtiments par l'artiste Louisa Bufardeci

Les projections cartographiques originales de l'artiste Tauba Auerbach

Les cartes saisissantes de l'artiste Mark Powell

Utiliser des générateurs automatiques de territoires imaginaires

Quand les artistes dessinaient les cartes (exposition aux Archives nationales)

L'exposition Mapping out : quand les artistes s'emparent de l'imaginaire des cartes

Tous les chemins mènent à Rome : une très belle collection de cartes artistiques qui donnent à réfléchir sur nos mobilités

Epoch, une vidéo artistique hypnotique à partir d'images Google Earth

Cartes et atlas imaginaires

Cartes et atlas artistiques

- The Secret History of American Art, 2005

-

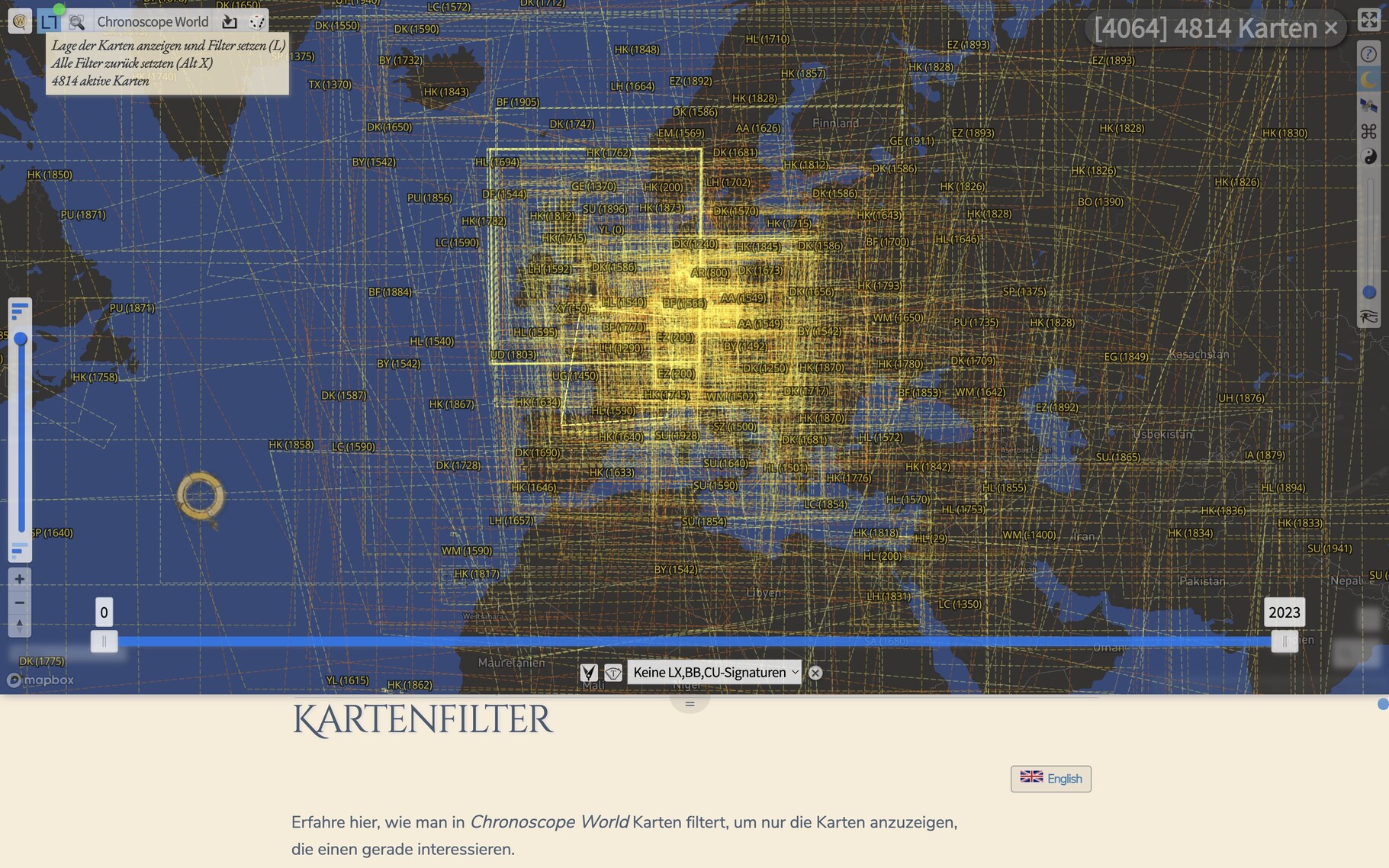

sur SatelliteXplorer : exemple de cartographie orbitale (4/4)

Publié: 7 October 2023, 6:13pm CEST par Nicolas Le Maux

Cet article SatelliteXplorer : exemple de cartographie orbitale (4/4) est apparu en premier sur Veille cartographique 2.0.

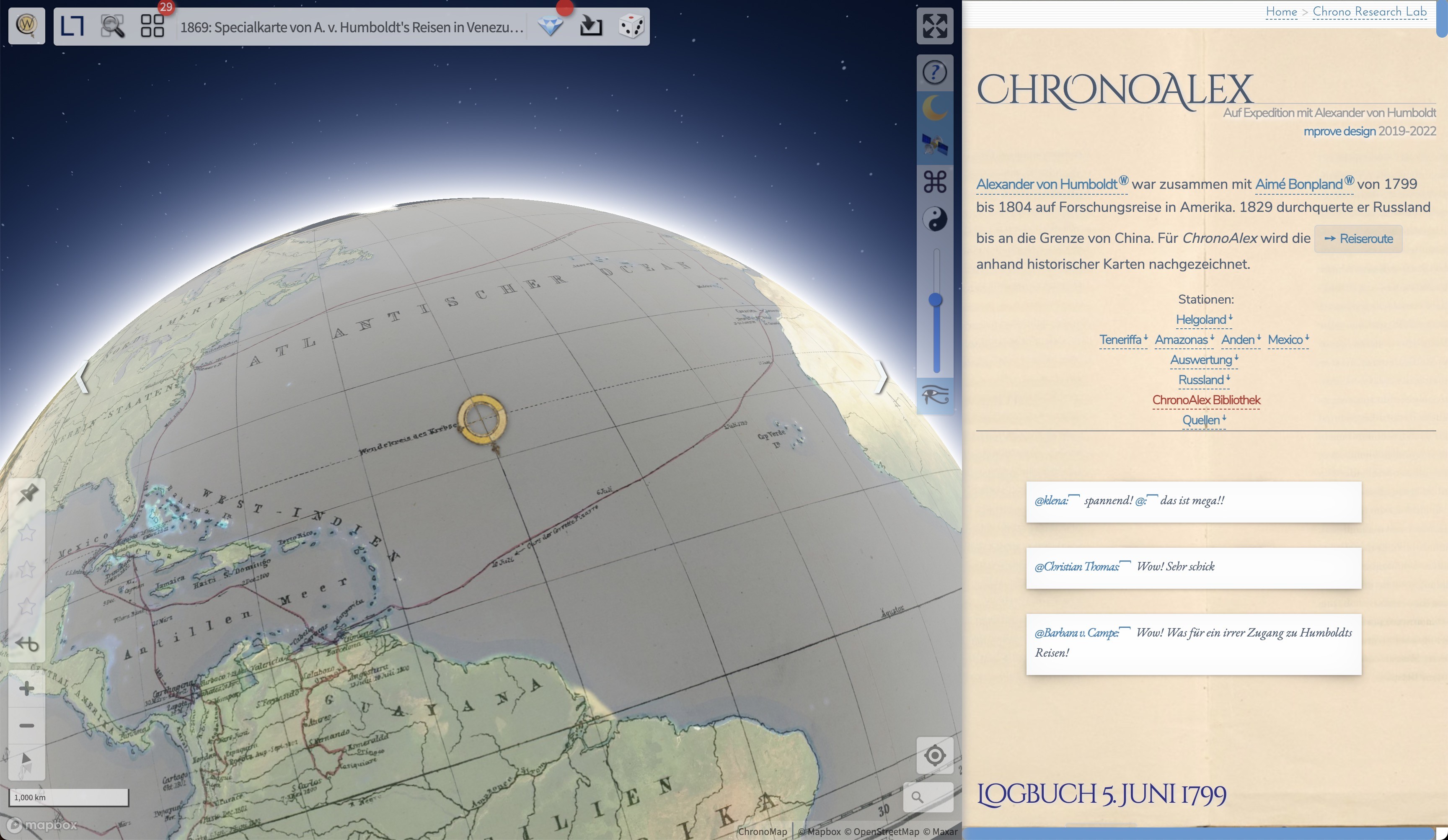

By NICOLX (Nicolas Le Maux) Préambules Nous avons introduit les enjeux et les motivations de cartographies de l’ensemble des corps orbitaux (partie ¼). Ensuite, nous nous sommes penchés sur quelques-uns des outils de cartographie numérique et de visualisations 3D répondant à ces besoins. De fait, nous avons présenté et Wayfinder de Privateer et AstriaGRAPH (parties […]

Cet article SatelliteXplorer : exemple de cartographie orbitale (4/4) est apparu en premier sur Veille cartographique 2.0.

-

sur Les principaux lieux de rencontres princières en France de 1494 à 1789

Publié: 7 October 2023, 3:04pm CEST

De Charles Quint à Kim Jong-un en passant par Louis XIV — pourquoi ceux qui gouvernent ont-ils besoin de se voir ? Sur la période qui s'étend de 1494 à 1788, Jean-Marie Le Gall a recensé plus de 3 340 rencontres au sommet. Dans un ouvrage co-écrit avec Claude Michaud, il déploie une vaste enquête quantitative et qualitative sur la structuration d'une République princière européenne. Battant en brèche les soubresauts juridico-diplomatiques d'un ordre plat entre souverains issu du mythe westphalien, il invite à entrer dans une réalité complexe au prisme de la confiance.

« Qu’est-ce qu’un sommet ? 3 344 rencontres princières analysées, une conversation avec Jean-Marie Le Gall » (Le Grand Continent, 5 octobre 2023).

Les cartes réalisées avec Datawraper sont à consulter sur Le Grand Continent (avec les données à télécharger) :

- Les principaux lieux de rencontre de Charles Quint

- Évolution des lieux de rencontre

- Nations et genre des princes visiteurs dans les plus importants foyers de rencontre princières aux XVII et XVIIIe

- Les principaux lieux de rencontres princières, 1494-1789

- Les principaux lieux de rencontre de Louis XIV

Les principaux lieux de rencontres princières, 1494-1789 (source : Le Grand Continent).png) Au XVIe siècle, la situation était toute autre : un prince perdait son statut une fois hors de ses frontières, il était considéré comme un simple citoyen à l’étranger. Il avait moins de droits que son ambassadeur. Cela a changé au cours de l’époque moderne. Deux éléments ont permis le passage d’une société de la défiance à une société de la confiance entre les princes : l’hospitalité et le cérémonial. En étudiant l’évolution de la géographie des rencontres, on observe une concentration croissante dans certains lieux après une période de forte dispersion. Dès le XVIIe siècle, nombreux sont les princes européens qui entreprennent le « Grand Tour », un voyage éducatif. En dépit de l’existence d’une société cosmopolitique des princes, aucune gouvernance européenne ne se dégage — contrairement à une idée reçue véhiculée par l’imaginaire westphalien. C’est même une époque de montée des nationalismes…

Au XVIe siècle, la situation était toute autre : un prince perdait son statut une fois hors de ses frontières, il était considéré comme un simple citoyen à l’étranger. Il avait moins de droits que son ambassadeur. Cela a changé au cours de l’époque moderne. Deux éléments ont permis le passage d’une société de la défiance à une société de la confiance entre les princes : l’hospitalité et le cérémonial. En étudiant l’évolution de la géographie des rencontres, on observe une concentration croissante dans certains lieux après une période de forte dispersion. Dès le XVIIe siècle, nombreux sont les princes européens qui entreprennent le « Grand Tour », un voyage éducatif. En dépit de l’existence d’une société cosmopolitique des princes, aucune gouvernance européenne ne se dégage — contrairement à une idée reçue véhiculée par l’imaginaire westphalien. C’est même une époque de montée des nationalismes…L'ouvrage complet à découvrir :

Jean-Marie Le Gall et Claude Michaud, Comment la confiance vient aux princes. Les rencontres princières en Europe (1494-1788), Paris, Presses Universitaires de France, 2023, 400 pages (site de l'éditeur)

Articles connexes

La guerre à l’époque moderne par les cartes

Forme du savoir, forme du pouvoir. Les atlas géographiques à l'époque moderne et contemporaine (Jean-Marc Besse)

Des cadres qui parlent : les cartouches sur les premières cartes modernes

L'histoire par les cartes : l'histoire connectée des empires à l'époque moderne

Le peintre hollandais Vermeer et les cartes

L'histoire par les cartes

Cartes et atlas historiques

-

sur Google Maps versus OpenStreetMap : redistribution des cartes sur le Web ?

Publié: 7 October 2023, 1:41pm CEST par Moussa DIABY

Cet article Google Maps versus OpenStreetMap : redistribution des cartes sur le Web ? est apparu en premier sur Veille cartographique 2.0.

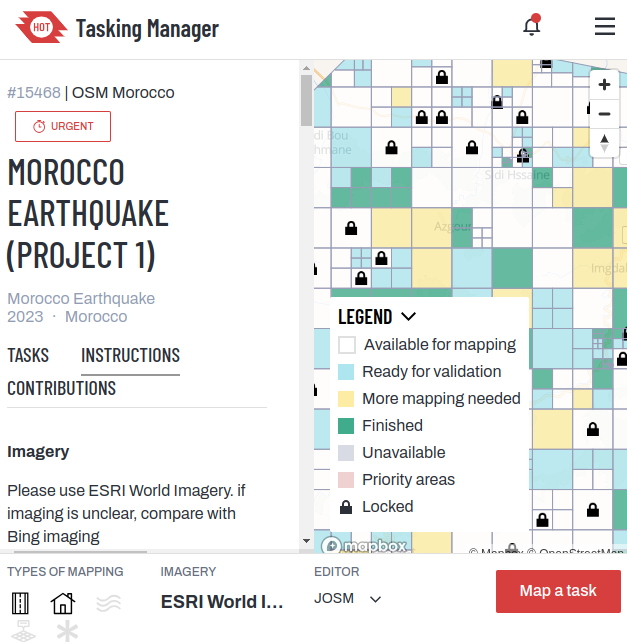

Les services de cartographie web ou encore en ligne sont depuis très longtemps dominés par le géant Google (Google Maps). Cependant, la montée en puissance des services sous licence Creative Commons comme OSM (OpenStreetMap), pourrait bouleverser cette tendance et menacer l’empereur du Net : Google. OpenStreetMap est un projet de cartographie mondiale fondée en 2004 dont […]

Cet article Google Maps versus OpenStreetMap : redistribution des cartes sur le Web ? est apparu en premier sur Veille cartographique 2.0.

-

sur Modélisation 3D de la rade de Brest

Publié: 6 October 2023, 4:08pm CEST par DIALLO

Cet article Modélisation 3D de la rade de Brest est apparu en premier sur Veille cartographique 2.0.

The « ImmerSea Rade, » project supported by the Dassault Systèmes Foundation, has been led by 25 students from the ISblue university school since January 2023. It aims to create an interactive 3D virtual tour of the harbor from Brest to Ouessant, tracing its evolution over 12,000 years in 3 minutes. This experience enables the public to […]

Cet article Modélisation 3D de la rade de Brest est apparu en premier sur Veille cartographique 2.0.

-

sur [Stage 4 à 6 mois - Développement logiciel] - Contribuer à la création et à l'évolution de solutions numériques autour de l'environnement et la valorisation des territoires

Publié: 6 October 2023, 2:28pm CEST par Lise Benazeth

Contrat : Stage

Lieu : Toulouse -

sur [Stage 4 à 6 mois - Développement logiciel] - Concevoir et développer une application, contribuer à des bibliothèques open source

Publié: 6 October 2023, 1:49pm CEST par Lise Benazeth

Contrat : Stage

Lieu : Toulouse

-

sur Le GeoModeller du BRGM : explorez les profondeurs du sous-sol

Publié: 6 October 2023, 1:46pm CEST par KONTA

Cet article Le GeoModeller du BRGM : explorez les profondeurs du sous-sol est apparu en premier sur Veille cartographique 2.0.

GeoModeller est un logiciel de modélisation géologique 3D du sous-sol. Il a été conçu à la base sous la forme d’un éditeur de coupes. Cependant, ce logiciel deviendra vite un éditeur géologique 3D permettant ainsi de définir l’architecture géologique d’un secteur. Les géologues et les professionnels de l’industrie minière, pétrolière, gazière et environnementale utilisent fréquemment […]

Cet article Le GeoModeller du BRGM : explorez les profondeurs du sous-sol est apparu en premier sur Veille cartographique 2.0.

-

sur Sous la ville, géomatique et aménagements urbains souterrains : des défis cruciaux

Publié: 6 October 2023, 1:45pm CEST par KONTA

Cet article Sous la ville, géomatique et aménagements urbains souterrains : des défis cruciaux est apparu en premier sur Veille cartographique 2.0.

La croissance rapide des villes à travers le monde a conduit à une pression croissante sur les espaces au niveau du sol. Dans cette optique, de nombreuses métropoles optent de plus en plus pour des aménagements souterrains pour leurs besoins en transports, parkings, et même habitations. Cependant, la planification et la réalisation de ces projets […]

Cet article Sous la ville, géomatique et aménagements urbains souterrains : des défis cruciaux est apparu en premier sur Veille cartographique 2.0.

-

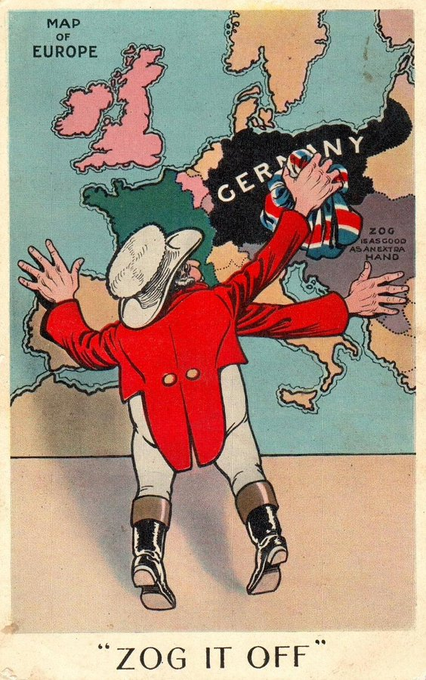

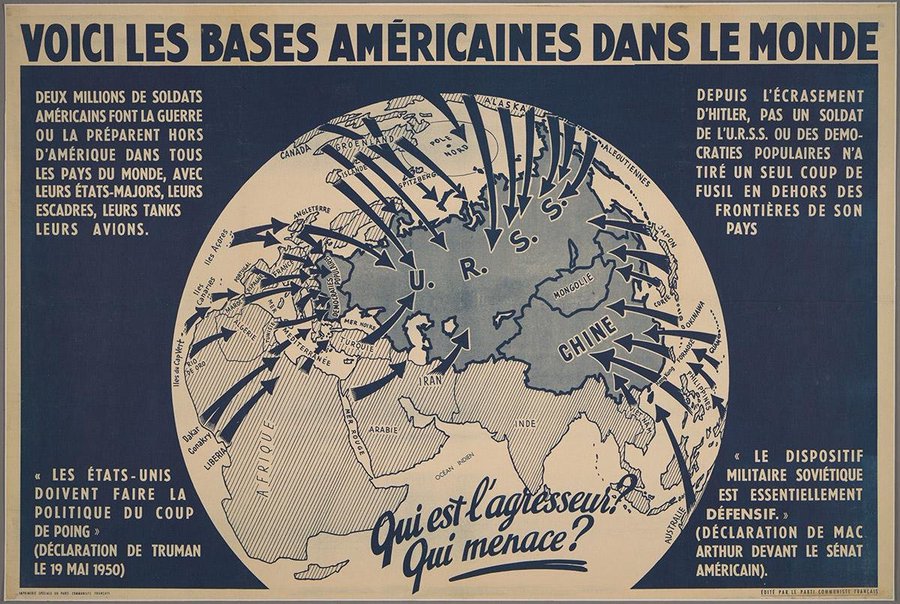

sur La carte, objet éminemment politique : la Société des Nations en 1927

Publié: 6 October 2023, 10:53am CEST

Les Archives des Nations Unies à Genève possèdent une importante collection de cartes du monde qui portent principalement sur l'Entre-deux-guerres et la Deuxième Guerre mondiale. On y trouve des cartes de la SDN, des cartes des empires coloniaux, des cartes des grandes voies de communication terrestres et maritimes ainsi qu'un important matériel cartographique issu de différents pays.

Au sein de cette collection figure une très belle carte concernant La Société des Nations en 1927. La SDN, créée en 1919 en réponse au traumatisme de la Première Guerre mondiale, a été la première organisation internationale dédiée à la préservation de la paix. Sa charte engageait ses membres à la réduction des armements, à la sécurité collective et à un ensemble de procédures pour le règlement pacifique des différends à l'échelle internationale. Bien qu'elle se soit révélée incapable d'empêcher le déclenchement de la Seconde Guerre mondiale, la Société des Nations a joué un rôle important et précurseur en matière d'éducation à la paix. Cette carte participe de cet idéal pacifiste et irénique propre à l'entre-deux-guerres.

Carte de la Société des Nations en 1927 par Laura H. Martin

(crédit : Archives des Nations Unies, licence CC BY-NC-ND 3.0 IGO).jpg)

La carte de la SDN en 1927 a été réalisée à partir d'une projection homolosine de Goode qui coupe les océans mais permet de représenter les pays à parts égales. La projection venait d'être inventée en 1923 par John Paul Goode, professeur de géographie à l'université de Chicago, afin de fournir une alternative à la projection de Mercator jugée trop déformante. La carte a été imprimée par les Presses universitaires de Chicago, alors que les Etats-Unis ne faisaient pas partie de la SDN. Sa conceptrice, la cartographe Laura H. Martin (1884-1956), était notamment spécialisée dans les questions juridiques liées à la souveraineté en Antarctique, à une époque où l'Europe, les États-Unis et le Japon commençaient à convoiter ce continent. Elle était mariée au lieutenant-colonel Lawrence Martin (1880-1955), chef du Département de géographie et cartographie de la Bibliothèque du Congrès et président de l'Association américaine des géographes.

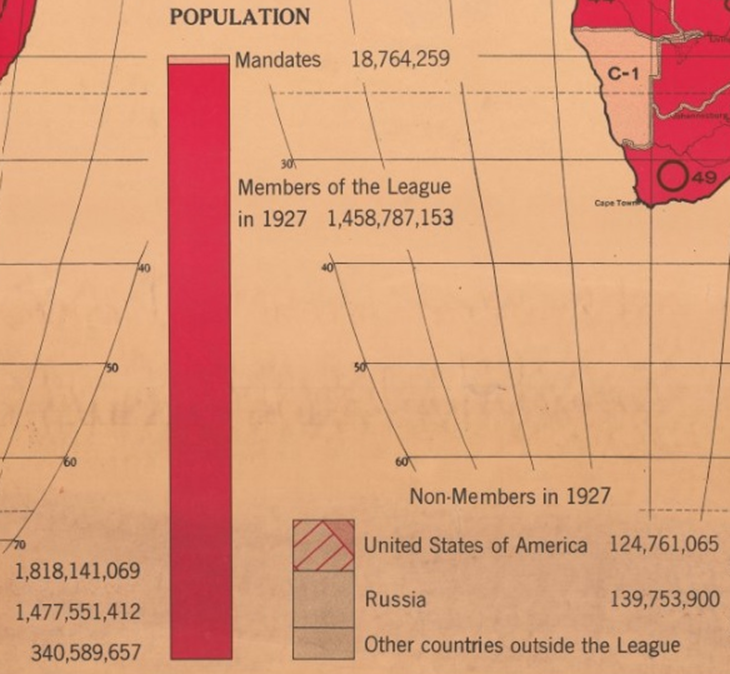

La carte de Laura H. Martin se présente comme une grande carte murale montrant l'importance de la Société des Nations en 1927. Bien que tout de rouge colorée pour montrer l'apparente unité des nations, on y distingue cinq catégories de pays en fonction du dégradé de couleurs et de la trame ajoutée discrètement par dessus : les nations membres de la SDN, les territoires sous mandat (anciennes colonies allemandes et anciennes provinces de l'empire ottoman), les nations non membres, celles non membres mais coopérant officieusement, ainsi que celles qui ont signé mais n'ont pas ratifié le traité fondant la SDN (notamment les Etats-Unis). La carte est complétée par trois tableaux statistiques qui occupent une place importante venant combler le vide laissé par les océans. Ces grands tableaux regroupent les états membres, les non membres et les territoires sous mandats, dans le but de comparer leur poids démographique respectif. Des cercles proportionnels permettent de comparer leur population directement sur la carte. Au bas, un graphique montre que, nonobstant l'absence de grands Etats comme les Etats-Unis ou la Russie, le poids démographique des nations membres de la SDN (55 pays en 1927, soit plus d'1,4 milliards d'habitants) l'emporte sur les nations non membres (340 millions d'habitants).

Détail intéressant : la grande carte murale de la SDN de 1927 (64 x 89 cm) a été précédée d'une carte en plus petit format La Société des Nations en 1925. La carte est ainsi présentée dans l'International Journal of Ethics (vol. 35, n° 4, juillet 1925). : « une nouvelle carte en couleurs qui rendra bien des services à tous ceux qui s'intéressent à l'actualité… Cette carte est dessinée selon la projection homolosine ou à surface égale du Dr J. Paul Goode. Elle mesure 20 ½ pouces x 10 ½ pouces, elle est adaptée à une utilisation au bureau… Un format plus grand pour les conférences (8 x 4 pieds, à vendre à environ 3 $ l'exemplaire) est envisagé pour une publication ultérieure ».

Pour comprendre le pacifisme qui anime cette carte de la SDN, on peut la comparer à une autre carte du monde "rouge sang" montrant tous les pays touchés par la Grande Guerre en 1914. Simple ressemblance ou réminiscence cartographique entre les deux cartes ? Bien que différente par leur projection, les deux cartes restent centrées sur l'Europe qui reste la référence (cf siège de la SDN implanté à Genève).

The Blood-Red World. Map Showing Territory of the Earth Directly Affected by the Great War (crédit : Wikimedia, carte dans le domaine public)

La belle unité affichée par la carte de la Société des Nations en 1927 reste assez fictive quand on la compare à la réalité. La carte rassemeble des territoires aux statut très différents, notamment les possessions coloniales de l'Europe, ce qui augmente d'autant la superficie des membres de la SDN (58 pays à son apogée). Une particularité est cependant à souligner : certaines colonies de l'Empire britannique avaient un siège à la SDN. Dans sa thèse de doctorat en histoire internationale, Thomas Gidney a étudié l'adhésion de trois États coloniaux britanniques à la Société des Nations : l'Inde en 1919, l'Irlande en 1923 et l'Égypte en 1937. Il retrace ainsi l'évolution de la représentation coloniale depuis ses débuts lors de la création de la SDN juqu'au déclin de son autorité dans la seconde moitié des années 1930. Bien que l’admission des colonies dans les organisations internationales n’ait été pratiquée que par l’Empire britannique, l’inclusion des régimes coloniaux dans les organisations internationales révèle de nouvelles pratiques de politique impériale visant à légitimer l’empire face à la résistance nationaliste croissante à la domination coloniale.

La SDN a connu des changements fréquents dans sa composition avec des pays qui ont pu entrer, sortir ou rester complètement en dehors de l'organisation. Alors que le président Woodrow Wilson avait largement promu sa création, les États-Unis n'en ont jamais fait partie du fait que le Sénat refusa d'en ratifier le traité. L'Égypte fut le dernier pays membre en 1937. L'Union soviétique fut exclue de la SDN le 14 décembre 1939, cinq ans après son adhésion le 18 septembre 1934. Il faudra attendre la création de l'ONU en 1945 pour que les Nations Unies ne soit plus "un club limité à certains" (Moreau Defarges, 2004). La carte de reconstitution historique ci-dessous permet d'appréhender ces fragilités internes qui contrastent avec la belle unité affichée par le document source.

Carte du monde montrant les adhésions à la Société des Nations de 1920 à 1945 (source : Wikipédia)

Au sein des Archives des Nations Unies à Genève, on trouve d'autres cartes représentant la Société des Nations, mais celles-ci sont en général plus classiques avec des découpages coloniaux ou des drapeaux représentant chaque pays. On n'y retrouve pas le pacifisme et l'universalisme qui animent la carte de Laura H. Martin. Il faut aller chercher dans l'oeuvre cartographique d'Otto Neurath pour retrouver ce même type d'inspiration. Celui-ci représente la Société des Nations en 1930 sous la forme d'isotype montrant l'importance numérique de la SDN par rapport à la population mondiale. On peut admirer le minimalisme et en même temps le modernisme de ce type de représentation schématique (1 pictogramme pour 100 millions d'êtres humains)

Der Völkerbund - Völkerbundstaaten übrige Staaten - Otto Neurath, 1930 (crédit : David Rumsey Map Collection)

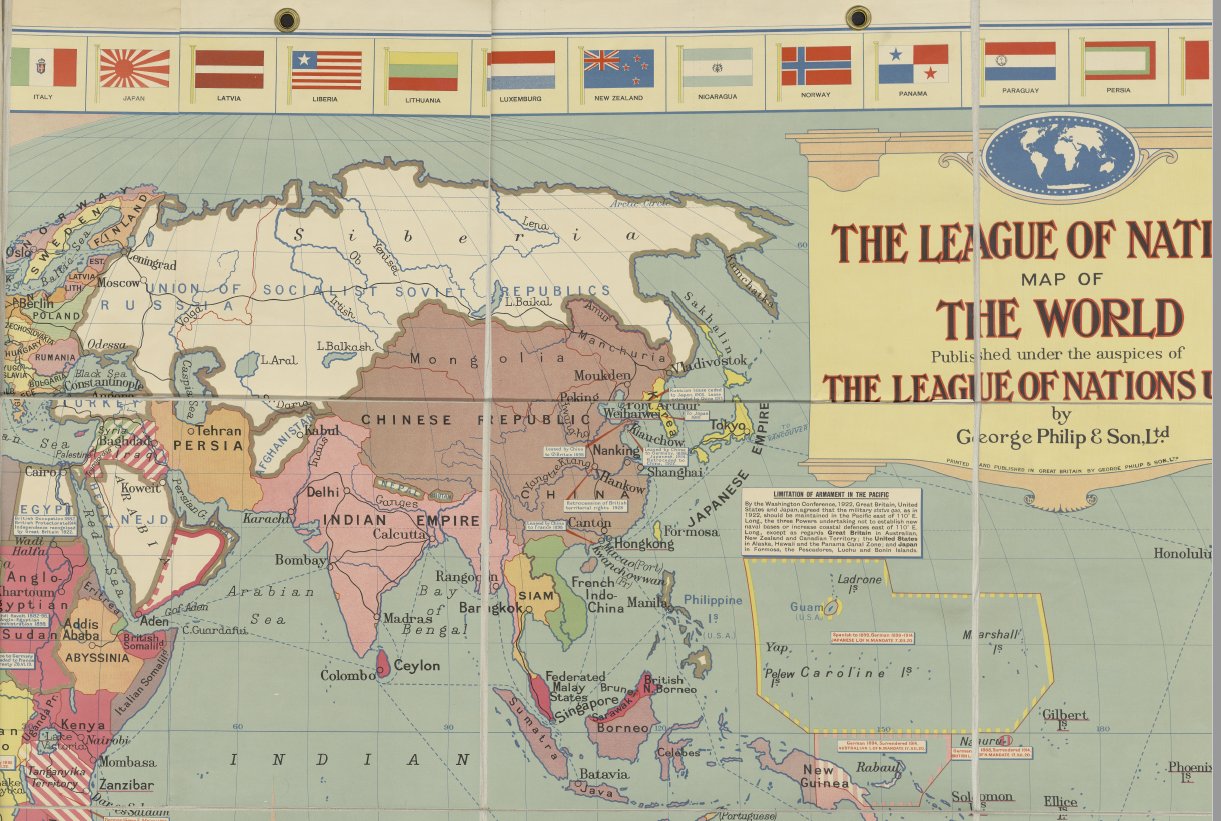

La sobriété et la modernité des isotypes utilisés par Otto Neurath contrastent avec la carte surchargée de détails publiée par l'éditeur Philip en 1929 "sous les auspices de la SDN". Une carte jugée incohérente et sémiologiquement incorrecte déjà à l'époque comme le montre cette critique publiée dans la revue Geographische Zeitschrift.

Extrait de la carte du monde publiée "sous les auspices de la SDN" par George Philip & Son en 1929(crédit : Archives des Nations Unies, licence CC BY-NC-ND 3.0 IGO)

En complément

Pour comparer avec d'autres cartes du monde issues des Archives des Nations Unies à Genève :- Le monde selon la projection homolosine de Goode (fond de carte centré sur l'Europe)

- Le monde selon la projection de Mercator (fond de carte centré sur l'Amérique)

- Fond de carte (Europe, Afrique, Australie) de la SDN hiérarchisant les continents

- Radio-Nations. Projection azimutale centrée sur le pôle nord indiquant les distances exactes depuis Genève

- Die Welt umnauen. Carte du monde entier en projection azimutale

- Carte générale du monde de Stanford à partir de la projection Mercator

- Carte commerciale du monde de Philip

- Série comparative de grandes cartes scolaires de Philip

- Carte des accords commerciaux en 1938 (centrée sur les Etats-Unis)

- Principales routes aériennes du monde

- Carte des voies de communications par TSF

- Carte représentant l'Empire britannique, les routes maritimes, les chemins de fer et les mers ouvertes à la navigation

- Carte Esso célébrant l'importance des transports et le rôle clé de l'énergie en temps de guerre

- Carte des Cinq Parties du Monde

- Cartes polonaises séparant entre hémisphère occidental et oriental

- Carte des continents orientaux selon Goode

- Les grandes étapes du peuplement du monde

- Le Nouveau Monde et le système colonial en 1823 et 1931

La collection de cartes numériques de la bibliothèque de l'American Geographical Society (Université du Wisconsin) contient plus de 19 000 cartes, allant des premières cartes de l'Asie aux cartes historiques du Wisconsin et de Milwaukee, ainsi que d'autres villes, États et parcs nationaux américains.

Articles connexes

La carte, objet éminemment politique

Des usages de la projection Spilhaus et de notre vision du monde

La projection Equal Earth, un bon compromis ?

L'Indice de paix mondiale est en baisse depuis plusieurs années

Cartographier pour un monde durable (ONU)

Projections cartographiques

-

sur Une story map pour découvrir le voyage d'Albert Kahn en Amérique du Sud (1909)

Publié: 6 October 2023, 6:50am CEST

Le musée départemental Albert Kahn organise une exposition « Rio-Buenos Aires 1909, Modernités sud-américaines » (27 juin-19 novembre 2023). Des avenues de Buenos Aires au quartier balnéaire de Rio de Janeiro, l’exposition retrace le voyage d’affaires entrepris par Albert Kahn en Argentine et au Brésil d’août à octobre 1909 et entraîne le visiteur dans un périple sensible, celui du passage à la couleur, avec les premières autochromes répertoriées du Brésil. Véritable archive visuelle, le fonds du voyage en Amérique du Sud est le témoin d’une modernisation urbaine en devenir.

Parcours de visite muséale

Le fonds du voyage en Amérique du Sud, longtemps peu connu, est constitué de 600 photographies stéréoscopiques monochromes, 61 plaques autochromes et 3 minutes de film. Le parcours de visite suit la chronologie du voyage et débute à bord du paquebot König Friedrich August. Après cette introduction maritime, les visiteurs découvriront, dans une déambulation visuelle et sonore, d’étonnants portraits de villes d’Amérique du Sud à rebours des clichés exotiques, ainsi que les premières autochromes de la baie de Rio, qui marquent l'apparition de la couleur. Enfin, l'exposition dévoile le travail d'enquête mené par lemusée autour de ce fonds inédit, juste avant le voyage retour jusqu’aux côtes espagnoles.

Découverte du voyage à travers une story map

Le musée Albert Kahn propose de poursuivre la visite de l'exposition à travers un feuilletoir numérique. L'occasion de découvrir une très belle série de cartes interactives présentant l'intégralité du fonds photographique "Voyage en Amérique du Sud" conservé par le musée départemental Albert Kahn. La storymap s'ouvre sur une carte originale représentant le voyage d'Albert Kahn sous la forme d'un plan de métro (#transitmap) mettant bien en valeur le trajet aller-retour du célèbre voyageur-photographe.

Voyage en Amérique du Sud (conception et rédaction : Delphine Allannic, Jean-André Assié, Gaspard Costa, Serge Fouchard, Isabelle Peretti - crédit : musée Albert Kahn)

.jpg)

Une table ronde pour discuter et analyser ces images

« Quand l’image devient source : regards croisés autour de l’exposition Rio – Buenos Aires 1909 / Modernités sud-américaines ». Table ronde le 10 octobre de 14h à 17h à l'auditorium du musée.

La table ronde réunira, autour des commissaires de l’exposition, des chercheurs, responsables de collections, conservateurs-restaurateurs, documentalistes et débattra de conditions d’usage de la photographie comme source pour l’histoire, des méthodologies à mettre en place et des enseignements que le collectif a pu tirer de ce fonds. Les images réalisées en lors de son voyage en Amérique du Sud sont longtemps restées peu connues. Constitué de 600 photographies stéréoscopiquesmonochromes, 61 plaques autochromes et 3 minutes de film, cet ensemble est présenté dans l’exposition Rio – Buenos Aires 1909 / Modernités sud-américaines du 27 juin au 31 décembre 2023.

Sous le regard d’Albert Kahn et de son photographe se dessine le portrait d’un continent et de villes en pleine mutation où l’Europe apparaît comme une référence incontournable. Cet ensemble d’images réalisé de Porto jusqu’à la baie de Rio de Janeiro, en passant par Buenos Aires, Rosario, São Paulo, avant de se terminer à Lisbonne, sont le point de vue d’un banquier occidental qui fait photographier et filmer son périple. Images souvenir ? Projet documentaire en devenir ? Cet ensemble de photographies enrichit notre connaissance du continent au début du XXe siècle et des relations qui se tissent entre Europe et Amérique. Si Albert Kahn milite très tôt pour que les Archives de la Planète deviennent des documents pour l’Histoire, comment faire l’Histoire par la photographie quand les images sont muettes, pour reprendre les mots de Jorge Semprun ? Fonds partiellement ou mal légendé, sans photographe identifié et sans archives, le fonds du voyage en Amérique du Sud était une matière brute, inexploitable sans l’apport de la recherche.

L'occasion de découvrir les Archives de la Planète (fonds d'archives visuelles du musée Albert Kahn)

Constituées entre 1909 et 1932 et conservées par le musée départemental Albert-Kahn, les Archives de la Planète, sont nées de l’initiative d’Albert Kahn (1860-1940), banquier philanthrope et pacifiste. Soucieux de garder une trace pour l’avenir d’un monde en profonde mutation, intéressé par les questions politiques et sociales, et militant pour le rapprochement entre les peuples, il tire parti de l’apparition de nouveaux modes d’enregistrement mécaniques – l’autochrome (1907) et le film (1895) – pour constituer cette vaste entreprise de production d’archives visuelles. À partir de 1912, sous la direction scientifique du géographe Jean Brunhes (1869-1930), une douzaine d’opérateurs parcourent près de cinquante pays et produisent 72 000 autochromes et plus d’une centaine d’heures de films.

Pour Albert Kahn, la période qui précède le démarrage officiel des Archives de la Planète est un temps d’expérimentation de l’image. Entre 1908 et 1909, lors des voyages que le banquier d’affaire accomplit en Europe, en Asie ou encore en Amérique du Sud, des praticiens réalisent pour son compte de nombreuses photographies stéréoscopiques monochromes, des autochromes ainsi que des films.Articles connexes

Les story maps : un outil de narration cartographique innovant ?

Les grands enjeux alimentaires à travers une série de story maps du National Geographic

Mapstory, un outil pour élaborer et partager des story maps

Exposition virtuelle. Figures d’un géographe, Paul Vidal de la Blache (1845-1918)

Numérisation des archives de la Société de Géographie sur Gallica

Avant l'invention du globe virtuel, les stéréoscopes permettaient déjà une forme de voyage visuel

Les 42 cartes des Voyages extraordinaires de Jules Verne

Cartes narratives et story maps

Cartes et atlas historiques

-

sur GeoTIFF reader/writer performance comparison

Publié: 5 October 2023, 4:17pm CEST par user

Apache Spatial Information System (SIS) version 1.4 contains a Cloud Optimized GeoTIFF (COG) reader for raster data. The development branch of Apache SIS 1.5 (not yet released at the time of writing this blog) contains also a GeoTIFF writer. Those reader and writer are implemented in pure Java code for avoiding the difficulty of bindings to native libraries such as GDAL. Pure Java code also provides more flexibility for Java developers. For example, the Apache SIS reader accepts any implementation of the Java

ReadableByteChannelstandard interface as the source of bytes. Another reason for developing GeoTIFF reader and writer in Java was for prototyping the use of new GeoTIFF keys that are proposed in OGC TestBed-19 — Geospatial in space.Coding yet another GeoTIFF reader and writer seems a duplication of work, since most of the geospatial world uses the popular GDAL library for that purpose. But actually, from Apache SIS perspective, there is not so much duplication. The most difficult part in a GeoTIFF reader and writer is to handle tiling and compression efficiently. But this task is largely format-independent, and SIS needs also to handle netCDF and other formats. The Apache SIS library shares code internally, thus reducing the task of GeoTIFF support to header parsing. By contrast, GDAL is largely an aggregation of independent libraries such as

libtiffandlibpng, each with their own ways to resolve common problems.Nevertheless, coding GeoTIFF support in Java raises questions about how its performances compare to GDAL. There is a widespread belief that Java programs are slower than their C/C++ counterpart. In reality, it depends a lot on the kind of application and how the libraries were coded. Differences in algorithms can play a bigger role than differences in the programming languages. This blog will not answer that debate, because the benchmarks presented here depend a lot on native code, either for I/O operations or for

MethodDEFLATEcompression (the latter is handled by native code in thejava.util.zipstandard package). However, the benchmarks in this blog demonstrate the capability of a Java program to avoid adding overhead. The result is that Apache SIS, at least in those benchmarks, compares favorably with GDAL.The benchmarks reported in this blog are very limited and only scratch the surface on the topic of raster data handling:

- All benchmarks were tested with a single image (in two variants).

- Only one compression method tested (in two variants), together with uncompressed raster.

- No sub-regions and no sub-samplings tested (there is no technical reasons for this omission).

- Multi-thread parallelization not tested (would have required some more developments in Apache SIS).

Sub-regions and requests for reduced resolutions on COG images should be handled efficiently by Apache SIS, but benchmarking those features would have required a more complex setup, especially if we want to test in a cloud environment. The simple benchmarks in this blog used a single image which was always read fully, from a local file on a laptop. The image was a single non-COG raster with the following properties:

Raster Thumbnail Raster Properties

Producer: DigitalGlobe Image date: 2014/06/16 File size: 192 Mb Image size: 8192 × 8192 pixels Strip size: 8192 × 128 pixels Sample model: banded (3 separated arrays of red, green and blue). Sample type: bytes, values ranging from 2 to 255. Compression: None CRS: WGS 84 / UTM zone 31N The image was read and rewritten using three libraries:

Method with deflate compressiongdal_translate, Java Image I/O and Apache SIS. For each library, the read/write operations were repeated 10 times in order to allow the Java Virtual Machine to warmup. The two first iterations were ignored, and execution time of the remaining 8 iterations were recorded. Average times and standard deviations are reported in this blog. In the particular case of the GDAL library, the execution time ofgdalinfohas also been measured and its average value has been subtracted from allgdal_translatetimes. The intend is to take in account the time needed for loading the GDAL binary, or at least the parts required for reading the image header (it also incidentally includes the time for parsing that header). We apply this correction because our benchmark code relaunches the GDAL command in each iteration, contrarily to Image I/O and Apache SIS libraries which are loaded only during their first iteration. The benchmark code is available on GitHub in theGeoTIFF.javafile. The processor of the test machine was Intel Core i7-8750H and the operating system was Fedora Linux 38 (Workstation Edition). Read and write operations were performed in the/tmp/directory, which uses thetmpfsfile system. It means that the raster files reside partially in RAM, so the benchmarks have less delay caused by I/O operations.The same tests were executed again with the

DEFLATEcompression. That compression is performed by thezliblibrary, accessible in standard Java thought thejava.util.zippackage. However, thezlibperformance varies greatly depending on the data to compress. For fair comparisons, we must ensure that all the tested libraries write the same data. It is not the case by default because:- GDAL and Java Image I/O change the sample model from “banded” to “pixel interleaved”.

- GDAL changes the strip height from 128 pixels to 1 pixel, thus writing strips of 8 kb.

- Java Image I/O changes the strip height from 128 pixels to 8 pixels, thus writing strips of 64 kb.

- Apache SIS keeps the sample model and strips height as they were in the image that was read.

For avoiding those differences, the input image has been rewritten by Apache SIS with a “pixel interleaved” sample model and strips of 8 pixels in height. In addition, the

Results-co BLOCKYSIZE=8option has been passed togdal_translate. ADEFLATEcompression has been applied, so the tests will include decompression times in addition of compression times.First, we tested reading the uncompressed image and rewriting it uncompressed too. Average execution times are reported below. The “GDAL (reduced)” label means that the average execution time of

gdalinfohas been subtracted from the execution time ofgdal_translate.

Apache SIS appears faster than other libraries for this particular benchmark. It may be because Apache SIS does not reorganize the pixel layout: it writes the image with banded sample model (called “planar configuration” in TIFF), as it was in the image that SIS has read. By contrast, GDAL and Image I/O reorganize the pixels into the pixel interleaved sample model. Note that for a Java application, the Java2D architecture around the

Results with deflate compressionRaster,SampleModelandColorModelclasses provides a great level of abstraction, generally making unnecessary to restructure the image data.The next benchmark involves reading the same image but with pixel interleaved sample model and deflate compression, then rewriting that image. First, the compression was tested without predictor. The average execution times are reported below. The same

gdalinfomeasurement than in the previous benchmark is reused for the “GDAL (reduced)” column. No attempt was made for instructing GDAL to uselibdeflate(see below):

The benchmark has been repeated many times and Java Image I/O was consistently slightly faster than other libraries. One hypothesis may be that, by default, Image I/O reads the whole image as one single tile, while the other libraries does tiling. We have not tried to adjust Image I/O parameters for testing that hypothesis.

Apache SIS appears slightly faster than GDAL in this benchmark, but we should not make general conclusion from this observation because the Java profiler measured that SIS spend about 95% of its time in the

java.util.zipnative code. We presume that a similar proportion applies to GDAL as well, so 95% of this benchmark is probably comparing the same code. We have no certain explanation for the slight difference nevertheless measured between GDAL and SIS. One hypothesis may be that the startup time estimation based ongdalinfois not good enough. Another hypothesis may be that Apache SIS‘s efforts payoff. SIS tries hard, sometime at the cost of code complexity, to transfer data as directly as possible (i.e. avoid copy operations from one buffer to other temporary buffers before the final destination).Note that GDAL has the capability to use

Results with horizontal differentiating predictorlibdeflateinstead ofzlib, with a reported performance gain of 35-50%. This acceleration has not been tested in this benchmark.Adding the horizontal differentiating predictor at writing time has the same effect on the two tested libraries. The difference between them are within margin errors, so no conclusion can be made. The “Time increase” column is the difference between the time measured here and the time measured in the benchmark without predictor. The majority of this increase is probably caused by time spent in

zlibinstead of time spent in applying the predictor. Note that the file sizes also increase. The image used in this test is a case where applying a differentiating predictor is counter-productive. Conclusion

Conclusion

Because the benchmarks spent 95% of their time in the

zliblibrary (except for the uncompressed case), we cannot make conclusion about the performance of the Java code in Apache SIS compared to the C/C++ code in GDAL. However, the benchmarks suggest that Apache SIS is successful in its attempt to avoid adding overhead. The interfacing between Apache SIS andjava.util.zipandjava.niopackages (e.g. using direct buffers) seems as efficient as the interfacing between GDAL and the native libraries that it uses. The benchmark measurements were slightly in favor of Apache SIS, but close to margin errors. Furthermore, a bias may exist despite our effort to apply a correction for GDAL startup time.The benchmarks reported in this blog are a bit superficial and could be improved in many ways: benchmarks should be run on a lot of different images with different sizes, tilings, sample models and color models, benchmarks should request various sub-regions, enable parallelization, measure raster reprojection times, measure memory consumption, etc. However, doing fair performance comparisons of the writers is time-consuming, because it requires making sure that each library compresses the same data. They usually don’t, because of different choices in sample models and tile sizes. Adjusting the parameters of each library for comparing the same things may need to be done on a case-by-case basis.

However, we can probably conclude one thing: the widely spread belief that a C/C++ library such as GDAL will surely be faster than an equivalent Java library such as Apache SIS is not always grounded in reality. It is true in some circumstances (e.g. startup time of a Java application stay longer), but should not be generalized. Slow Java codes are often due to poor algorithms rather than the language. More benchmarks between libraries written carefully in both languages are needed before to make conclusions.

The post GeoTIFF reader/writer performance comparison first appeared on Geomatys.

-

sur Les modèles de langage (LLMs) utilisés en intelligence artificielle reproduisent l'espace et le temps

Publié: 5 October 2023, 7:54am CEST

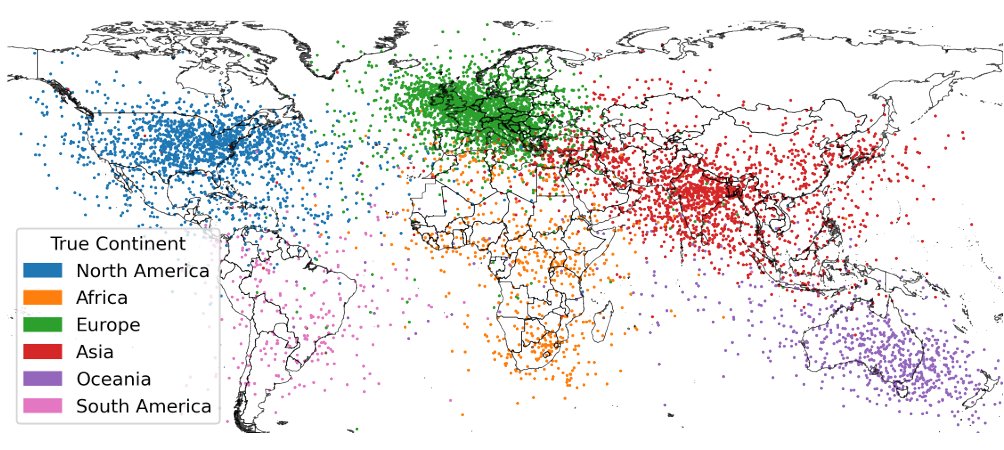

Avec le développement des agents conversationnels, il devient possible de conduire des recherches en langage naturel et de mobiliser des données géospatiales. Les modèles de langage (LLMs) utilisés en intelligence artificielle reproduisent à leur manière l'espace et le temps. C'est ce que tend à montrer l'article publié par Gurnee & Tegmark :Wes Gurnee, Max Tegmark (2023). Language Models Represent Space and Time. ArXiv:2310.02207v1 [cs.LG] 3 Oct 2023. [https:]]

Les capacités des grands modèles linguistiques (LLMs) suscitent des débats autour de la question de savoir si ces systèmes apprennent simplement à partir d'une énorme collection de statistiques ou s'ils constituent un modèle cohérent de génération de données – un modèle mondial. Dans cet article, les auteurs fournissent des preuves concernant le deuxième point en analysant les représentations à partir de trois ensembles de données spatiales (lieux du monde, des États-Unis, de New York) et de trois ensembles de données temporelles (personnages historiques, œuvres d'art, titres d'actualité) dans la famille de modèles Llama-2. Ils montrent que les LLMs apprennent des représentations linéaires de l'espace et du temps à plusieurs échelles. Ces représentations sont robustes pour fournir de l'unité et des variations entre différents types d'entités (par exemple, villes et monuments). De plus, ils identifient des « neurones spatiaux » et des « neurones temporels » individuels qui codent de manière fiable les coordonnées spatiales et temporelles.

Pour télécharger l'article en pdf.

Accès au code et aux données sur Github.

Pour compléter

IA & Géographie. Les intelligences artificielles génératives s'appliquent à beaucoup de domaines, notamment à l'information géospatiale. Il est désormais possible, par exemple, de choisir une liste de lieux, d'en faire chercher automatiquement les coordonnées géographiques par un agent conversationnel (du type ChatGPT ou autre) et de produire directement un fichier kml utilisable dans un globe virtuel (voir ce tutoriel).

Articles connexes

Des outils d'IA gratuits pour identifer un lieu à partir d'une photographieQuand Facebook révèle nos liens de proximité

Territoires virtuels. Carte interactive des 400 000 projets déposés sur GitHub

Guerre de pixels sur Reddit. La lutte des places concerne aussi les territoires virtuels

La carte mondiale de l'Internet selon Telegeography

L'essor parallèle de la Silicon Valley et d'Internet : du territoire au réseau et inversement

Cartographie du réseau social Mastodon

-

sur Cartographier l'anthropocène. Atlas 2023 de l'occupation du sol (IGN)

Publié: 4 October 2023, 8:26pm CEST

Comme le souligne Sébastien Sorano, Directeur général de l’Institut national de l’information géographique et forestière, les défis climatiques nécessitent de repenser l'usage de nos sols. L’IGN publie l'édition 2023 de son Atlas annuel des cartes de l'anthropocène dédié à l’occupation et à l’usage des sols. Un nouveau recueil de cartes et de points de vue pour éclairer les décisions et actions publiques relatives à ce levier majeur pour répondre au défi climatique.

Cet ouvrage de référence aborde la question de l’occupation des sols face aux défis climatiques sous trois points de vue : historique, aménagement du territoire (urbanisme) et environnemental. Cet atlas montre l’influence des choix politiques de « consommation » et recomposition de l’espace naturel : les choix du passé et la façon dont ils ont modelé le territoire français et les choix d’aujourd’hui, répondant à de nouvelles problématiques.

Cartographier l'anthropocène. Atlas 2023 de l'occupation du sol (source : IGN)

- La carte, témoignage de l'histoire. Entretien avec l’architecte et historien Jean-Luc Arnaud

Des ruelles du centre-ville aux grands axes fluviaux, des massifs forestiers aux champs à perte de vue, le sol français est une mosaïque en constante évolution. Depuis sa création, l’IGN oeuvre pour graver sur ses cartes l’état des lieux du territoire à un instant précis. En remontant ses archives cartographiques, les transformations du territoire défilent sous les yeux du lecteur, tel un kaléidoscope.

- Aménager un territoire, une question d'équilibre

Le paysage français n’est pas qu’une simple réalité environnementale, il est le résultat de transformations culturelles et économiques profondes. Son organisation, tiraillée par les intérêts des uns et des autres, produit et supprime des continuités territoriales, reflets des priorités d’époques différentes. Étalement urbain, déprise agricole, reconquête forestière… aménager un territoire est d’abord une question de choix et d’équilibre entre l’usage des espaces communs.

- « Le paysage, partie sensible du territoire ». Découvrir le point de vue de Jacqueline Osty

Le paysage est le résultat d’une forme d’alchimie qui croise de nombreuses thématiques, au carrefour du vécu et du perçu. À une époque où l’on cherche à stopper l’artificialisation des sols, travailler sur le paysage permet de prendre le recul suffisant pour repenser nos territoires de manière plus globale. Entretien avec Jacqueline Osty, paysagiste et Grand prix de l'urbanisme 2020

- Comment adapter le territoire français au changement climatique ?

Sous la pression du changement climatique, le territoire français doit s’adapter. La raréfaction de l’eau douce, la propagation des incendies et l’intensification des épisodes de pluie extrême demandent une réorganisation des espaces. Des îlots de chaleur en ville aux glaciers du Mont-Blanc, des essences d’arbre aux types de culture, connaître l’occupation des sols est la première étape pour structurer un territoire résilient. Un défi auquel l’IGN veut participer par le futur jumeau numérique du territoire.

- « L’eau est un flux dépendant du climat ». Découvrir le point de vue d'Agnès Ducharne

L’eau est un élément précieux. Qu’elle vienne à manquer, et tout le système de société humaine perdra alors l’équilibre. Avec le réchauffement climatique, c’est précisément ce qui se dessine pour l’avenir. Entretien avec Agnès Ducharne, Directrice de recherche au CNRS, spécialiste de la modélisation de l’hydrologie des surfaces continentales.

- L’OCS GE, l'outil phare de l'IGN pour détecter et suivre l'artificialisation du sol

En s’appuyant sur ses données socles, l’IGN pilote la production d’un référentiel à grande échelle pour la description de l’occupation du sol français : l’OCS GE. Cet outil, au service de l’État et des collectivités, cartographie les couches de surface du sol, distingue les zones imperméables, agricoles, forestières et permet de quantifier et de qualifier l’évolution des territoires et leur artificialisation nette. Depuis 2019, l’Institut emploie la télédétection par intelligence artificielle pour accélérer la production et multiplier les usages.

- Énergies renouvelables à la carte

En mai 2023, un nouveau portail cartographique des énergies renouvelables a vu le jour. Réalisé par l’IGN et le Cerema, cet outil est indispensable pour favoriser le développement des énergies renouvelables terrestres.

Consulter l'Atlas de l'occupation du sol en ligneTélécharger l'Atlas en version pdf

En complément

Sébastien Soriano : « On a besoin d’une vision plus sensuelle et moins mathématique du territoire » (interview pour Usbek & Rica).

Articles connexes

Atlas IGN des cartes de l'anthropocène (2022)

Paul Crutzen et la cartographie de l'Anthropocène

Les territoires de l'anthropocène (cartes thématiques par le CGET)

Cartes et données sur l'occupation des sols en France (à télécharger sur le site Theia)

Dynamic World : vers des données d'occupation du sol quasi en temps réel ?

Copernicus : accès libre et ouvert aux cartes concernant la couverture des sols (2015-2019)

L'histoire par les cartes : 30 cartes qui racontent l'histoire de la cartographie (sélection de l'IGN)

Lidar HD : vers une nouvelle cartographie 3D du territoire français (IGN)

Enquête sur la mention « compatible GPS » indiquée sur les cartes IGN des années 1980-90

- La carte, témoignage de l'histoire. Entretien avec l’architecte et historien Jean-Luc Arnaud

-

sur Retrouvez les conférences du CNIG en vidéo

Publié: 4 October 2023, 2:58pm CEST

Retrouvez les conférences du CNIG en vidéo

-

sur Traitements et cartographie de l’information géographique (Cunty & Mathian, 2023)

Publié: 4 October 2023, 12:46pm CEST

Avec la massification des données et la systématisation du référencement géographique de l’information, les cartes constituent aujourd’hui des enjeux importants, tant pour les spécialistes que pour les organismes d’aménagement, d’urbanisme ou le grand public. Cependant, si produire une carte peut paraître facile, le passage concret des données à une carte utile pour la question posée est jalonné par une succession d’opérations précises mobilisant des connaissances en divers domaines : statistique, géographie, cartographie, etc.

Claire Cunty, Hélène Mathian (dir.), Traitements et cartographie de l’information géographique, Isté éditions, 2023 (site de l'éditeur).

L’ouvrage présente une diversité d’enchaînements d’opérations à partir d’exemples variés. Chaque chapitre emprunte un chemin différent, explicitant les choix méthodologiques opérés en fonction du thème traité et du but poursuivi. Cette approche couvrant l’ensemble de la démarche de production d’une carte permettra à tout lecteur, qu’il soit étudiant, chercheur, enseignant ou aménagiste de comprendre les multiples rôles que la carte peut jouer dans des analyses de données géographiques.

Avant-propos et introduction Table des matières1. Cartes et graphiques pour explorer des relations statistiques2. Intégration de données hétérogènes et représentations cartographiques du Géoweb3. Données environnementales et objets cartographiques4. Cartographier et identifier les formes géographiques : l’exemple de la ségrégation5. Carte et modèle statistique pour explorer l’hétérogénéité spatiale6. Cartographier les phénomènes temporels7. Cartogrammes, anamorphoses : des territoires transformés8. Exploration, agrégation et visualisation spatiotemporelle de données massives

Les chapitres sont positionnés le long d'un continuum où sont identifiées les étapes-clés d'un cycle qui relie les données à la carte (cercle orange sur la figure ci-dessous). Les chapitres s'associent, se complètent, renvoient les uns aux autres.

« Carte des chapitres, ce qui les relie, les notions qui les jalonnent » (extrait de l'ouvrage, p. 16)

Claire Cunty est enseignante-chercheuse en géographie à l’Université Lumière Lyon 2, membre de l’UMR Environnement Ville Société. Ses recherches portent sur la conception et les usages des interfaces de géovisualisation d’informations spatiotemporelles ainsi que sur les approches numériques des cartes sensibles.Elle fait partie de l’équipe de pilotage du master Géographies Numériques des Universités Lyon 2 et Saint-Etienne.

Hélène Mathian est ingénieure CNRS en méthodes d’analyse spatiale à l’UMR Environnement Ville Société. Ses travaux intègrent la dimension spatiale dans les traitements et modèles statistiques, et la géovisualisation comme élément d’exploration des données géographiques et des dynamiques spatiales. Elle fait partie de l’équipe de pilotage du master Géographies Numériques des Universités Lyon 2 et Saint-Etienne.

Articles connexes

Les systèmes d'information géographique. Principes, concepts et méthodes (Armand Colin)

La longue histoire qui va conduire à la cartographie numérique et aux débuts des SIG

Des sources aux SIG : des outils pour la cartographie dans les Humanités numériques

L'apport de la cartographie et des SIG pour évaluer l'accès aux vaccins contre le Covid-19

L'histoire des SIG open source et de leurs formats ouverts à travers une infographie interactive

« Cherche appartement pour habiter à Mumbai » ou comment s'initier à l'analyse spatiale avec un logiciel SIG

Jeu de données SIG sur le classement des métropoles mondiales

Cartographier le marché locatif de Beyrouth avec un SIG

Systèmes d'Information Géographique (SIG)

Fonds de cartes pour utiliser dans un SIG

-

sur Should we produce on demand, or globally ?

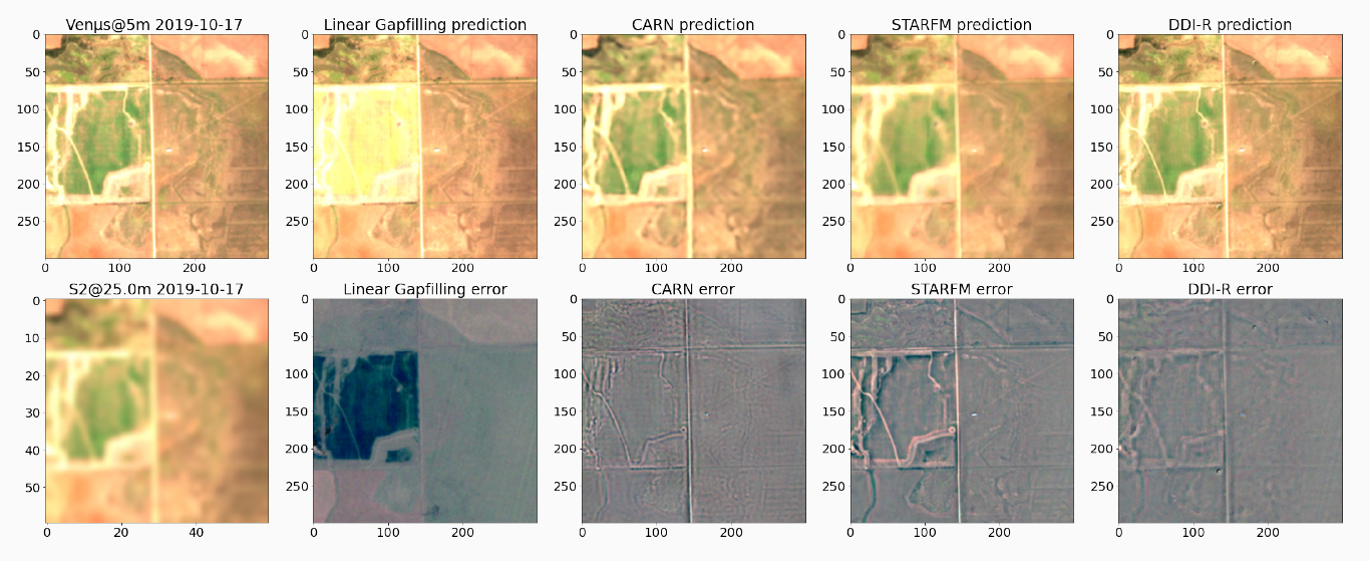

Publié: 4 October 2023, 12:16pm CEST par Olivier Hagolle

=>

=>

As the resolution of our satellite missions improve, the data volume of output products increases, and the share of the computing and storage costs of its products increases too.

Let’s assume we are preparing a new satellite mission, for instance a Sentinel-like mission, with the hope of potential use by operational or private users, as well as scientists, of course. These applications could be for instance: estimating yields, biomass, evapotranspiration, detecting crop diseases, deforestation or monitoring snow melt… These applications could be performed at continental, country or region scales.

This mission will acquire data globally, and produce each day at least a tera byte (TB) of products (L1C) which are then transformed into L2A, L2B, L3A… At the end of the satellite life, let’s assume the mission totals a dozen of peta bytes (PB) during the satellite lifetime, and requires 1000 cores to produce the data in near real time.

In the early stages of a mission, when the ground segment is being defined, the following question usually arises: which of the following choices should we select ?

- a global production, in near real time, with data stored indefinitely, reprocessed when a new better version is available,

- or a production on-demand, where the needed products are only generated when someone asks for them ?

In my opinion, the production should be global and systematic. Here’s why.

Processing costs: hardware Cost of global processingI am not a specialist, but I have colleagues who are, and who found the costs of a computer center of the size that would be necessary to process the data of a Sentinel-like mission with only one satellite. These costs include maintenance, power…

Storage Processing Per year 100 k€/PB/Year 100 k€/1000 cores/year Total/7years (3000 cores/12 PB) 4.2 M€ 2.1 M€ If we need up to 12 PB at the end of the 7 years life, it is almost zero at the beginning. Therefore, storing all the data requires an average of 6 PB during 7 years, or 4.2 M€. After the satellite end of life, data are still useful. As a result, storage should also go on, with the full cost of 12 PB. However, the data could be stored on tapes, with a longer access, but a much lower cost, and we can still hope storage costs and carbon footprint continue to decrease with time.

For a global production of medium resolution data with revisit, the need of processing capacity is at least 1000 cores. Of course it depends on the mission and methods used. It is also necessary to allow reprocessing (because who does a perfect processing at once ?), and a reprocessing needs to run at least 3 times faster than the real time processing. Even with such performances, the final reprocessing at the end of life takes two years ! As a result, at least 3000 cores are necessary, for a total of 2.1 M€ for seven years.

With 12 peta bytes and something like 3000 cores, we should have a total cost (including maintenance, energy…) in hardware around 7 M€. This is less than 5% of the cost of a one satellite Sentinel-like mission, but still a lot.

Cost of on-demand processingSizing the cost for an on-demand production is much more difficult, as it depends on how many users will ask for it. As a result, the selected solution will need monitoring and adaptability, and probably some over-sizing. Of course, there is a large cost reduction in storage, as only temporary storage is needed. In case of success, if each site is processed several times for different users, the processing cost might be greater than that of the systematic production.

Moreover, if data produced on-demand are not kept on the project storage, users will be attempted to store the on-demand products produced for them on their premises.

If we try to provide numbers, a capacity of less than 10% of the global and systematic production is necessary for the storage, and 20% to 50% for the processing.

Carbon budgetOutside the cost, the carbon budget of an on-demand solution is also much better. Most of the carbon, especially in France where electricity is low-carbon, comes from the hardware manufacturing. It is therefore probably proportional to the investment cost.

However, computation experts say that the CPU node has its best yield when it is used at least 80% of the time. As a result, the yield of nodes used for on-demand production, with random variations of production demands, would be lower than that of a well scheduled global production.

Of course it is essential to try to optimise the computing and storage volumes whatever the selected solution is.

Processing costs: the software and exploitationProcessing software is expensive too: you need a data base, a scheduler, processing chains, monitoring and control software. But whether it is for on demand or systematic global production does not change the cost much. On demand production is maybe a little more complex, as it means support for users, development of interfaces, documentations. But a global production in near real time requires complex monitoring solutions

Of course, hybrid solutions exist, processing one part of the globe systematically, and offering the remaining parts on demand. Regarding softwares, it is probably a bit more expensive as it requires implementing both solutions.

Pros and cons of each solutionBesides the costs, described above, each solution has its pros and cons :

Systematic production Advantages- Data are available everywhere without delay. Users may use these data efficiently with cloud solutions.

- Data can be harvested by other processing centers

- It is possible to create downstream products on large surfaces efficiently, with near real time processing if necessary.

- Comparison with older data is easy. Scientists like to observe trends, which can be difficult if you need to ask for a reprocessing before that.

- Data are always available on the mission servers, users do not need to save the data on their own disks, duplicating the archive

- Some of the regions produced might never be downloaded, processing capacity and storage can be used while not necessary. However, this drawback disappears as soon as there is a global production of some variable

- When a new version of processors is available, it takes a long time to reprocess and update the versions

- Larger cost (even if those are small amounts compared to the total cost of the mission)

- Larger carbon emissions (even if those are small amounts compared to the total carbon budget of the mission). Moreover, Sentinel-like mission data are used to try to monitor and reduce carbon emissions.

- Only the needed products are processed

- The processing can always be done with the last version

- Global reprocessing is not necessary

- Reduced cost (even if those are small amounts compared to the total cost of the mission)

- Reduced carbon emissions (even if those are small amounts compared to the total carbon budget of the mission)

- Processing takes time, all the more if some methods used to process data require to process them in chronological order (such as MAJA). In that case, a time series can’t be processed in parallel

- As data are not stored permanently on the project servers, processing on the « cloud » is not optimised. The data might be erased before the user who asked for them has finished his work. As a result, the user needs to download the data.

- Satellite telemetry usually comes in long chunks: processing even a small area of interest (AOI) requires accessing a large volume of data. This drawback is exacerbated for missions with a wide field of view, in which an AOI is seen from different orbits.

- It is hard to estimate the capacity and the computer power necessary to answer the demand. As a result, it requires studies of user demand, and the solution should be quickly adaptable, and maybe over-sized

- If the mission is a success, some regions or countries might have to be processed several times, reducing the gain of on-demand processing.

- On-demand processing prevents any global processing, or even continental scale processing. Even country scale might be problematic.

- Near real time processing is not possible

- Users might be deterred by the processing latency and decide to give up on the mission, or prefer another one, even if it is not the best choice for their application. This is especially important for new missions, where complexity in access might prevent the easy discovery of the interest of the data.

- The mission will not have the impact it might have had with systematic processing

The main advantage of on-demand production is its reduced cost. However, this cost remains small compared to overall mission cost. The carbon budget plays in favor of the on-demand too, but it is probably a small amount compared to the satellite budget. As a result, making full use of the satellite is probably better. And this is even truer if the satellite is used to monitor the environment and help taking decisions to reduce our carbon footprint. Anyway, processors and storage should be optimised of course.

On the other hand, the long list of drawbacks of on-demand processing speaks for itself. It would clearly result in a much less useful mission.

Of course there are hybrid solutions where some regions/countries/continents are processed systematically, and others on-demand. It only changes the proportions of pros and cons of each solution, and may introduce difficulties in case of change of versions between each type of processing.

To conclude, in my opinion, on-demand processing is only interesting if we plan that that mission will not be a success among users. But in that case, do we really need that mission ?

-

sur « Si la nature dessinait une carte du monde, à quoi ressemblerait-elle ? » (Bioregions 2023)

Publié: 4 October 2023, 9:40am CEST

« Si la nature dessinait une carte du monde, à quoi ressemblerait-elle ? ». Nous sommes habitués à voir le monde divisé en pays, États et provinces, mais il existe une autre façon de voir et de mieux comprendre la planète dans laquelle nous vivons. One Earth présente un nouveau cadre biogéographique appelé Bioregions 2023, qui délimite 185 biorégions organisées au sein des principaux domaines biogéographiques du monde.

Une nouvelle carte de la Terre créée en croisant des biomes avec des structures géologiques

à grande échelle et des groupements écorégionaux (source : Bioregions 2023)Télécharger la carte (6 Mo). Crédit : Karl Burkart, One Earth

Les biorégions et les espèces emblématiques associées à chacune peuvent être explorées via un navigateur interactif en 3D.Une biorégion est une zone géographique définie non pas par des frontières politiques mais par des systèmes écologiques. Une biorégion est plus petite qu’un domaine biogéographique mais plus grande qu’une écorégion ou un écosystème. Sur Terre, le cadre biorégional le plus répandu est le « biome » (parfois appelé « écozone »), une vaste communauté de plantes et d'animaux adaptés aux conditions climatiques spécifiques que l'on retrouve sur divers continents. Il existe 14 principaux types de biomes.

Cartes à télécharger en haute résolution (format jpeg) :- Carte des 14 principaux biomes de la Terre

- Carte des 185 biomes de la Terre

- Carte des 844 écorégions terrestres de la Terre

- Carte des 52 sous-domaines du cadre Biorégions 2023

- Carte des 62 écorégions marines du monde

One Earth est une organisation à but non lucratif qui s'efforce d'accélérer l'action collective pour résoudre la crise climatique. Les solutions à la crise climatique existent déjà, et les dernières recherches scientifiques menées par One Earth montrent que "l'on peut atteindre l'objectif critique de 1,5°C grâce à trois piliers d'action collective" :- Une transition juste vers une énergie 100 % renouvelable ;

- Protection et restauration de la moitié des terres et des océans de la planète ;

- Un passage à des systèmes alimentaires à consommation zéro nette.

Articles connexes

Données SIG sur les écorégions terrestres (Resolve et OneEarth)

Une carte mondiale des types d'habitats terrestres

Atlas de l'Anthropocène : un ensemble de données sur la crise écologique de notre temps

Les territoires de l'anthropocène (cartes thématiques proposées par le CGET)

Feral Atlas, une exploration de l’Anthropocène perçu à travers la féralisation

Le calcul de l'IDH prend désormais en compte le calcul des pressions exercées sur la planète (IDHP)

Paul Crutzen et la cartographie de l'Anthropocène

-

sur Le Centre de recherche sur l’épidémiologie des catastrophes

Publié: 4 October 2023, 9:17am CEST par Da Silva

Cet article Le Centre de recherche sur l’épidémiologie des catastrophes est apparu en premier sur Veille cartographique 2.0.

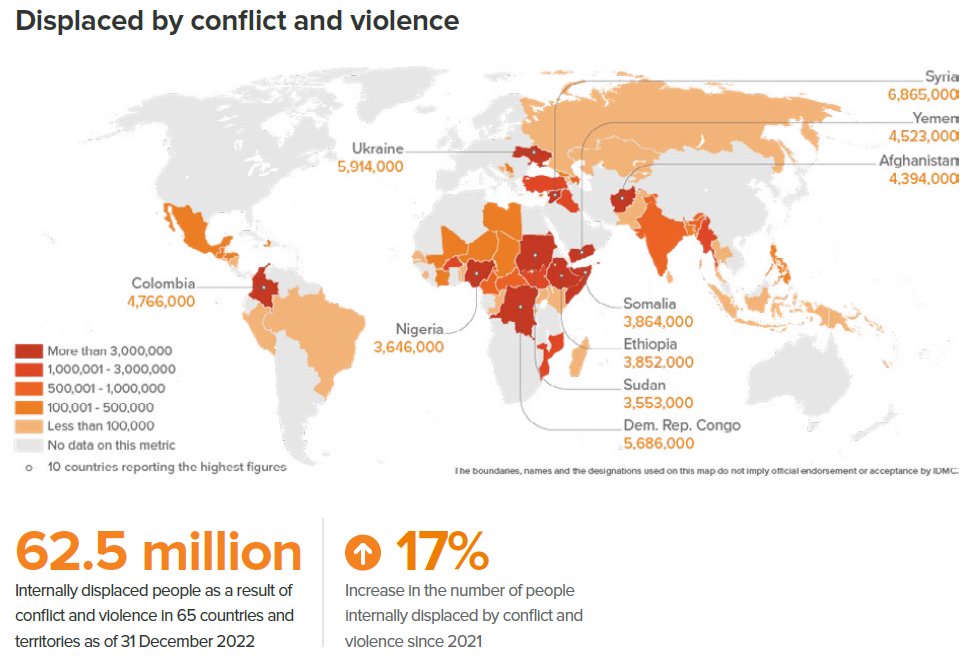

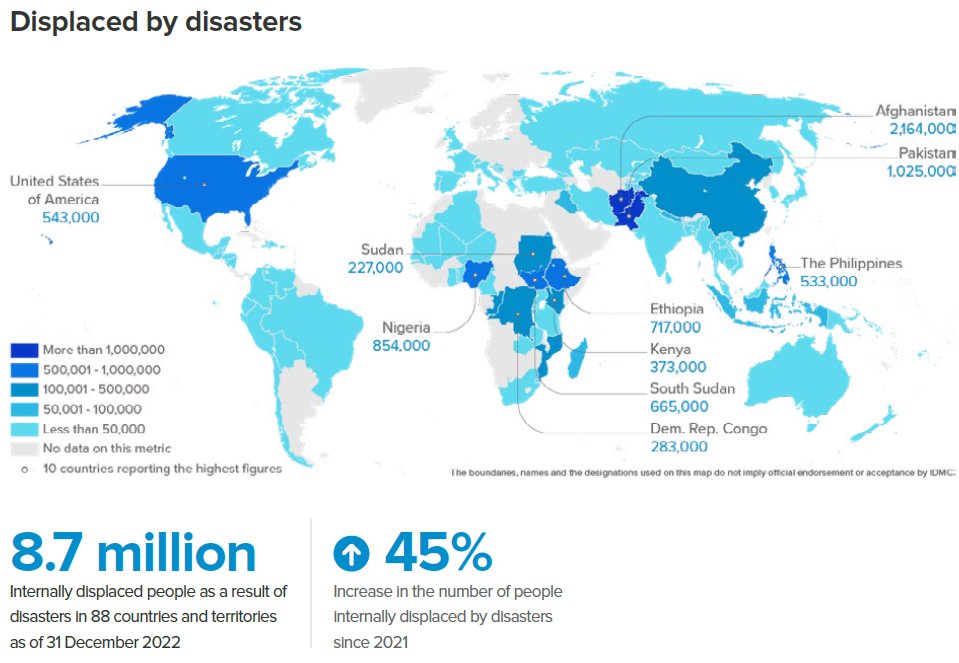

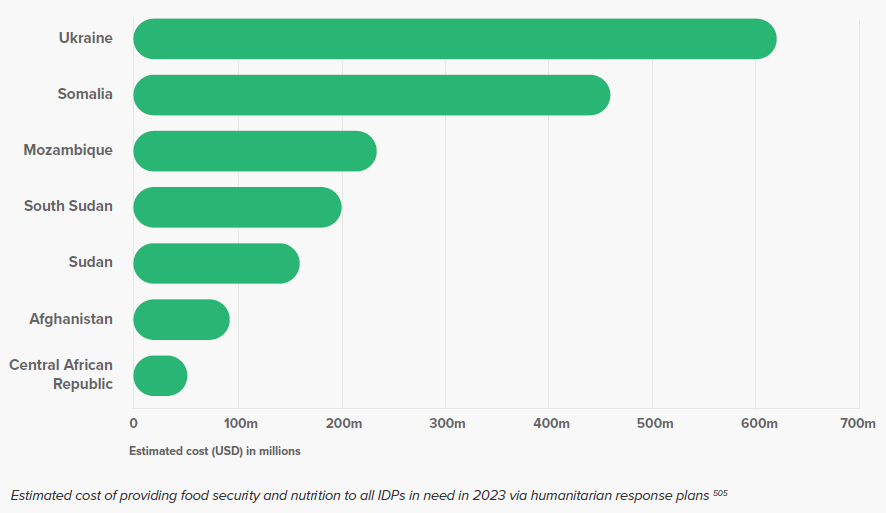

Ce centre travaille sur deux axes principaux qui sont les suivants : les catastrophes naturelles ainsi que les conflits pouvant toucher les populations sujettes aux événements. Il étudie les crises et urgences humanitaires qu’elles soient socio-économiques, sur les questions de genre ou encore environnementales dans un but d’éditer des rapports mais aussi d’aider les populations […]

Cet article Le Centre de recherche sur l’épidémiologie des catastrophes est apparu en premier sur Veille cartographique 2.0.

-

sur AstriaGraph : exemple de cartographie orbitale (3/4)

Publié: 3 October 2023, 10:10pm CEST par Nicolas Le Maux

Cet article AstriaGraph : exemple de cartographie orbitale (3/4) est apparu en premier sur Veille cartographique 2.0.

Par NICOLX (Nicolas Le Maux) Introduction Les déchets anthropiques de toutes sortes polluent désormais l’espace. Ils proviennent de l’essor du domaine spatial : déploiement de nombreuses sondes, lanceurs, satellites et autres projets militaires. De telle sorte que les différentes agences spatiales étudient comment nettoyer l’horizon orbital. La cartographie des débris et autres corps en orbite présente […]

Cet article AstriaGraph : exemple de cartographie orbitale (3/4) est apparu en premier sur Veille cartographique 2.0.

-

sur Wayfinder : exemple de cartographie orbitale (2/4)

Publié: 3 October 2023, 9:46pm CEST par Nicolas Le Maux

Cet article Wayfinder : exemple de cartographie orbitale (2/4) est apparu en premier sur Veille cartographique 2.0.

Par NICOLX (Nicolas Le Maux) Présentation Wayfinder est une application lancée par Steve Wozniak, cofondateur d’Apple. Elle est mise en ligne depuis début 2022. Elle permet de suivre en temps quasi réel l’évolution des débris et des engins gravitant autour de la Terre. Le but était d’aider « l’humanité à traiter l’environnement spatial comme si nos […]

Cet article Wayfinder : exemple de cartographie orbitale (2/4) est apparu en premier sur Veille cartographique 2.0.

-

sur L’intérêt de la télédétection dans la surveillance du niveau moyen des mers

Publié: 3 October 2023, 10:21am CEST par Admin User

Cet article L’intérêt de la télédétection dans la surveillance du niveau moyen des mers est apparu en premier sur Veille cartographique 2.0.

Alors qu’ils couvrent plus de 70 % de la surface terrestre, les océans jouent, entre autres, un rôle crucial pour l’équilibre climatique de la planète. Depuis quelques décennies, les marégraphes, instruments mesurant le niveau moyen des mers depuis le 19e siècle enregistrent une montée des eaux « à une vitesse de l’ordre de 2 mm par […]

Cet article L’intérêt de la télédétection dans la surveillance du niveau moyen des mers est apparu en premier sur Veille cartographique 2.0.

-

sur Organic molecules’ cartography, Mars : the most recent updates from Perseverance rover

Publié: 3 October 2023, 9:01am CEST par Nicolas Le Maux

Cet article Organic molecules’ cartography, Mars : the most recent updates from Perseverance rover est apparu en premier sur Veille cartographique 2.0.

By NICOLX (Nicolas Le Maux) Introduction Mars 2020 is a space mission which consists of deploying the Perseverance rover on Martian soil to study its surface and collect soil samples. This Mars exploration mission is being developed by JPL (NASA). It constitutes the first in a series of three missions whose final objective is to […]

Cet article Organic molecules’ cartography, Mars : the most recent updates from Perseverance rover est apparu en premier sur Veille cartographique 2.0.

-

sur Rapport annuel 2023 du Haut conseil pour le climat « Acter l’urgence, engager les moyens »

Publié: 2 October 2023, 3:10pm CEST

Le Haut conseil pour le climat (HCC) est un organisme indépendant chargé d’évaluer la stratégie du gouvernement en matière de climat, et sa cohérence avec les engagements européens et internationaux de la France, en particulier l’Accord de Paris, l’atteinte de la neutralité carbone en 2050, et le respect des budgets carbone de la France.

En 2022, année record avec +2,9°C de température moyenne en France, le changement climatique a eu des impacts graves sur les personnes, les activités économiques, les infrastructures et les écosystèmes. Les dispositifs de prévention et de gestion de crise n’ont pas permis d’éviter toutes ces conséquences. La France n'est manifestement pas prête à faire face aux effets du changement climatique (avec un réchauffement qui pourrait atteindre +4°C en 2100).

Le réchauffement futur dépendra des émissions futures de GES (source : rapport 2023 du HCC)

.jpg)

Le rapport grand public rendu par le Haut Conseil pour le Climat (HCC) présente, en 16 pages illustrées, une analyse des impacts récents du changement climatique ainsi qu'un suivi des émissions des Gaz à effets de serre (GES) et des politiques associées. Le rapport ne se contente pas d'un état des lieux mais propose aussi des recommandations :

- Connaître et anticiper les impacts du changement climatique. Les nombreux impacts liés aux conditions climatiques de l’année 2022 soulignent l’importance de renforcer conjointement les dispositifs de gestion de crise et ceux de prévention, et d'anticiper les années extrêmes au sein desprojections climatiques.

- Opérationnaliser l’adaptation au changement climatique. Les politiques d’adaptation doivent changer d'échelle en France, en s’appuyant sur la trajectoire de référence de +4°C, en tenant compte des coûts d’adaptation pour les finances publiques et privées, et en améliorant le suivi de l’action publique d’adaptation et l’évaluation de son efficacité.

- Systématiser le cadre d’action public. Le cadre stratégique qui se construit doit être mis en œuvre de manière opérationnelle et systématique. La nouvelle stratégie climatique (SFEC) est l’occasion de préciser les engagements de la France afin de renforcer leur portée.

- Engager les moyens nécessaires. La politique économique permettant de déclencher les changements nécessaires à l’atteinte des objectifs climatiques doit être renforcée, y compris la politique budgétaire, fiscale, commerciale, industrielle et de l'emploi, tout en accompagnant les plus vulnérables dans un esprit de transition juste.

- Prioriser le déploiement des énergies renouvelables et les mesures de sobriété. La France doit consolider les mesures de sobriété structurelles prises cette année, et poursuivre les efforts pour formuler et appliquer des mesures structurelles qui encouragent la sobriété énergétique des infrastructures et des usages de manière systématique pour tous les secteurs émetteurs.

- Relancer la dynamique internationale. La France peut œuvrer au développement d'un plan d'investissement climat européen. Au niveau international, elle peut préparer sa position pour la COP28, et œuvrer à un meilleur suivi des engagements internationaux qu’elle soutient

Ressources pédagogiques à télécharger

Articles connexes

Renforcer l'atténuation, engager l'adaptation (3e rapport du Haut Conseil pour le climat - 2021)

Quels sont les États qui ont le plus contribué au réchauffement climatique dans l’histoire ?

Comment la cartographie animée et l'infographie donne à voir le réchauffement climatique

Aborder la question de l'inégalité des pays face au changement climatique

Analyser et discuter les cartes de risques : exemple à partir de l'Indice mondial des risques climatiques

Les plus gros émetteurs directs de CO² en France

La pollution de l'air est la première menace mondiale pour la santé humaine (rapport de l'EPIC, août 2023)

Quand la lutte contre les émissions de CO² passe par la dénonciation des entreprises les plus concernées

Le tourisme international et son impact sur les émissions de CO²

Qualité de l'air et centrales thermiques au charbon en Europe : quelle transition énergétique vraiment possible ?

- Connaître et anticiper les impacts du changement climatique. Les nombreux impacts liés aux conditions climatiques de l’année 2022 soulignent l’importance de renforcer conjointement les dispositifs de gestion de crise et ceux de prévention, et d'anticiper les années extrêmes au sein desprojections climatiques.

-

sur Ecouter le monde: une cartographie des ambiances sonores

Publié: 2 October 2023, 9:07am CEST par Admin User

Cet article Ecouter le monde: une cartographie des ambiances sonores est apparu en premier sur Veille cartographique 2.0.

Mené par cinq personnes qui ont en commun dans leur différent métier le son, le projet “écouter le monde”, propose de raconter, à travers les sons enregistrés dans différentes villes du monde, l’histoire du lieu. Monica Fantani (auteure à Radio France Internationale) s’est associée avec Paola Zavagna (compositrice et professeur de musique électroacoustique, Séverine Janssen […]

Cet article Ecouter le monde: une cartographie des ambiances sonores est apparu en premier sur Veille cartographique 2.0.

-

sur Prix du Livre de géographie 2024

Publié: 1 October 2023, 3:53pm CEST par r.a.

Le Prix du Livre de géographie des lycéens et étudiants sera décerné en 2024 à un des ouvrages cités ci-dessous.

Gilles Fumey, Alexandre de Humboldt. L’eau et le feu, Double ligne, 2022.

Raphaël Mathevet et Roméo Bondon, Sangliers. Géographies d’un animal politique, Actes Sud, 2022.

Basile Michel, Les quartiers culturels et créatifs, Le Manuscrit, 2022.

Marion Tillous (dir.), Espace, genre et violences conjugales, ce que révèle la crise de la Covid 19, GéoTraverses, 2022.

Nephtys Zwer (dir.), Ceci n’est pas un atlas, Éditions du commun, 2023.

-

sur Un prochain colloque sur l’Intelligence artificielle à Albi

Publié: 1 October 2023, 3:47pm CEST par r.a.

Nos amis d’Albi nous informent de la tenue d’un colloque, les 5 et 6 octobre 2023 sur “l’IA et les Institutions publiques”, au campus de Champollion à Albi. Vous pouvez vous inscrire grâce au lien [https:]]

Le programme se trouve sur la page des Cafés d’Albi.

-

sur Comment migrer vers une version récente de Django ?

Publié: 1 October 2023, 2:39pm CEST par Yann Fouillat, Sylvain Boureliou

Que ce soit pour avoir les dernières fonctionnalités ou les correctifs de sécurité, rester sur une version récente de Django est important pour la pérennité de son projet.

-

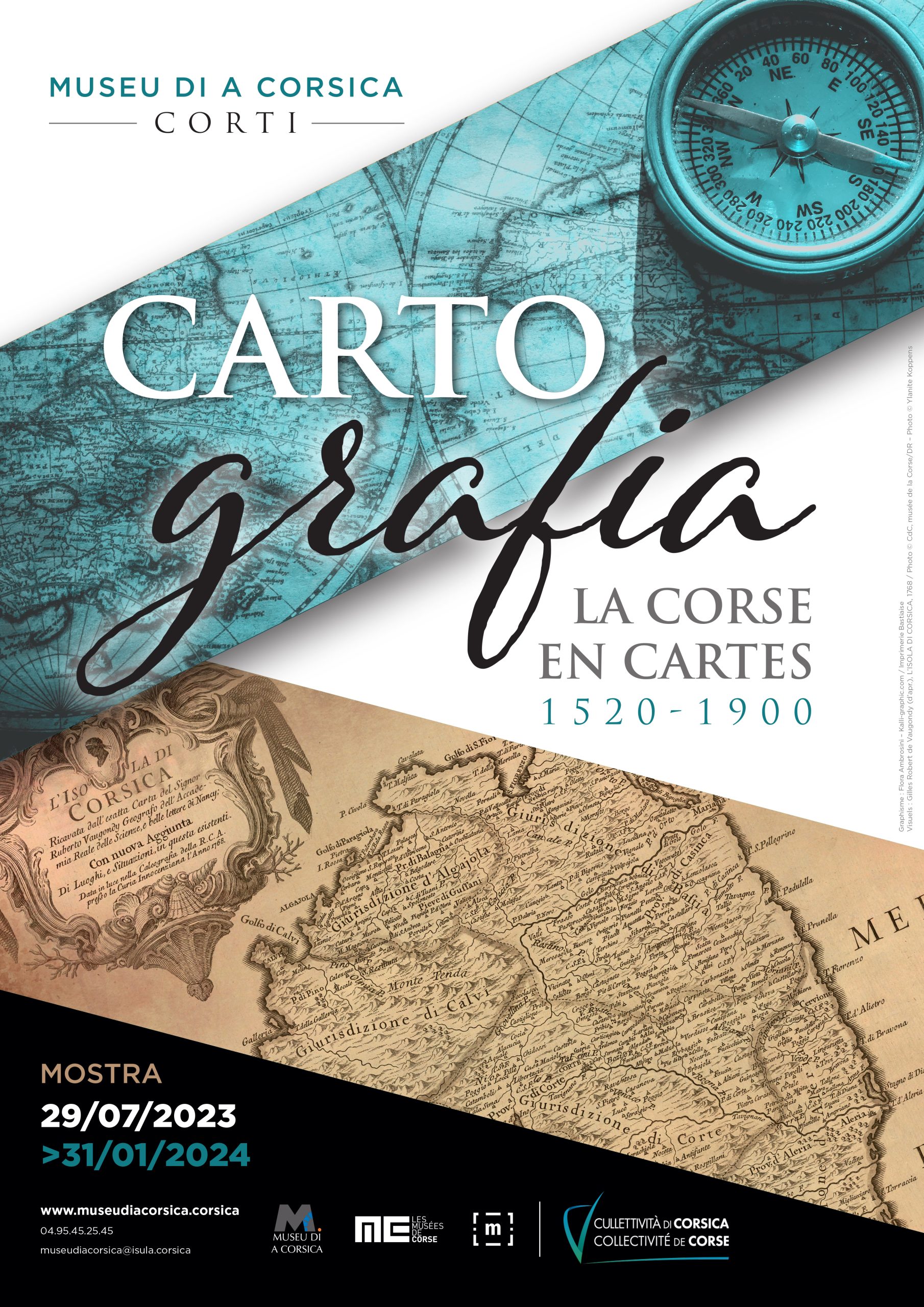

sur Exposition « Cartografia, la Corse en cartes 1520-1900 »

Publié: 1 October 2023, 5:54am CEST

Le musée de la Corse vous invite au voyage et à la découverte du monde des cartes. « Cartografia, la Corse en cartes 1520-1900 » réunit géographie et histoire dans un corpus de représentations de l’île et de la Méditerranée tracé sous l’œil du cosmographe, du politique, du militaire, de l’hydrographie. L’exposition présente une sélection de documents anciens, de cartes et de plans, de livres et d’atlas, ainsi que les acteurs et les nombreuses techniques qui participent à la discipline cartographique. La diversité des collections exposées éclaire par leurs formes, leurs matières et leurs couleurs. La présentation rassemble un florilège d’images qui témoignent de l’intérêt dont la Corse fut l’objet durant plusieurs siècles.

Dossier de presse de l'exposition à télécharger en PDF.

Le parcours de l’exposition s’inscrit dans la longue durée. 1520-1900 : quatre siècles de regards portés sur le territoire corse et ses rapports au monde. La présentation d’une sélection des collections du musée de la Corse vise à partager une part du patrimoine insulaire enrichi par la participation de prêts d’œuvres de diverses institutions corses, nationales, internationales et de collections particulières, très rarement présentées au public. Cette exposition est aussi l’occasion d’accéder à une longue et précieuse séquence figurative de l’histoire corse. Construite autour de deux séquences principales et 5 sections distinctes, l’exposition « Cartografia, la Corse en cartes 1520-1900 » présente plus de 300 œuvres.

Séquence I : L’ère géographique

• Section 1 : le XVIe siècle et l’extension du monde connu

• Section 2 : le XVIIe siècle, l’héritage des pairs

Séquence II : L’ère scientifique

• Section 3 : le XVIIIe siècle et la souveraineté disputée

• Section 4 : le XIXe siècle et la topographie moderne

Du plan Terrier à la carte de Jacotin (1770-1824)

Parmi les cartes remarquables à découvrir :

- La Mer Méditerranée et les costes des Estats qui la borne (1709) par Nicolas de Fer, géographe, graveur

- Carte de l'isle de Corse pour servir aux vaisseaux du roi (1768) par le Sr Bellin

- Insula Corsica olim regni Tiulo insignis nunc Genuensis reipublicae potestati subjecta par Matthaeum Seutter

- Le Plan Terrier, une grande entreprise cartographique qui se déroula de 1770 à 1796 (données disponibles sur Open data Corsica)

- De l'usage de la carte dans l'art depuis les années 1960

Articles connexes

Atlas stratégique de la Méditerranée et du Moyen-Orient (FMES)

Etudier les formes urbaines à partir de plans cadastraux

« Un bon croquis vaut mieux qu'un long discours ». Napoléon et les cartes

Cartes et atlas historiques

L'histoire par les cartes

-

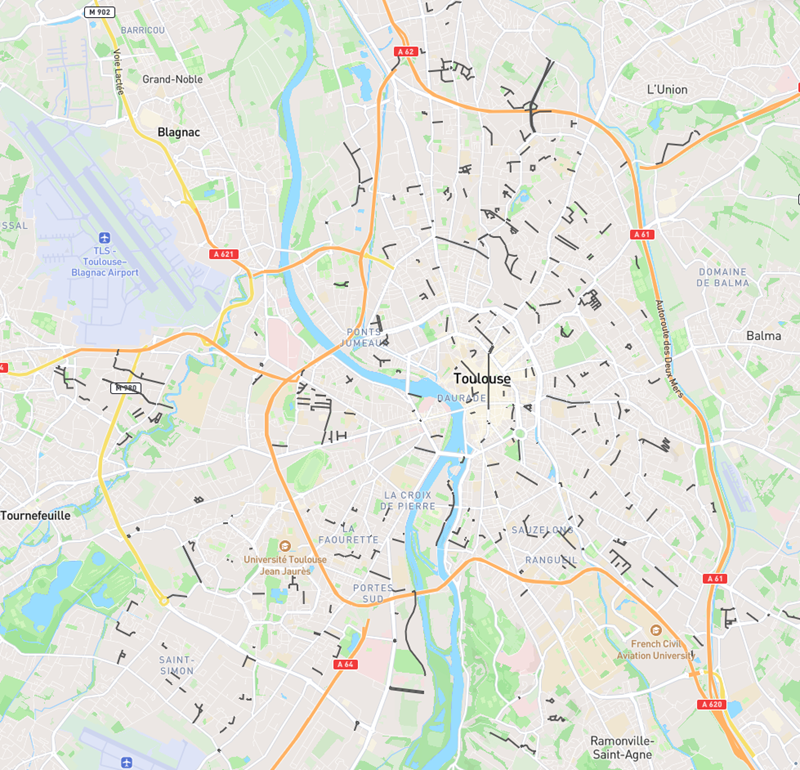

sur Où sont les femmes dans les rues de Toulouse (et d’ailleurs) ?

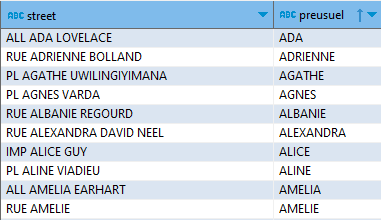

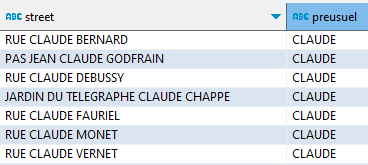

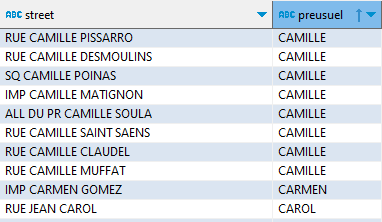

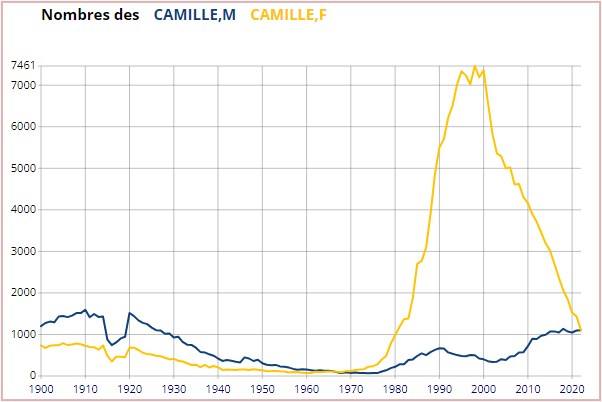

Publié: 30 September 2023, 8:20am CEST par Éric Mauvière