Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

4737 éléments (1 non lus) dans 55 canaux

-

Cybergeo

Cybergeo

-

Revue Internationale de Géomatique (RIG)

Revue Internationale de Géomatique (RIG)

-

SIGMAG & SIGTV.FR - Un autre regard sur la géomatique

SIGMAG & SIGTV.FR - Un autre regard sur la géomatique

-

Mappemonde

Mappemonde

-

Dans les algorithmes

Dans les algorithmes

-

Imagerie Géospatiale

-

Toute l’actualité des Geoservices de l'IGN

Toute l’actualité des Geoservices de l'IGN

-

arcOrama, un blog sur les SIG, ceux d ESRI en particulier

-

arcOpole - Actualités du Programme

arcOpole - Actualités du Programme

-

Géoclip, le générateur d'observatoires cartographiques

-

Blog GEOCONCEPT FR

Blog GEOCONCEPT FR

Toile géomatique francophone

(1 non lus)

Toile géomatique francophone

(1 non lus)

-

Géoblogs (GeoRezo.net)

-

Conseil national de l'information géolocalisée

Conseil national de l'information géolocalisée

-

Geotribu

Geotribu

-

Les cafés géographiques

Les cafés géographiques

-

UrbaLine (le blog d'Aline sur l'urba, la géomatique, et l'habitat)

UrbaLine (le blog d'Aline sur l'urba, la géomatique, et l'habitat)

-

Icem7

Icem7

-

Séries temporelles (CESBIO)

Séries temporelles (CESBIO)

-

Datafoncier, données pour les territoires (Cerema)

Datafoncier, données pour les territoires (Cerema)

-

Cartes et figures du monde

Cartes et figures du monde

-

SIGEA: actualités des SIG pour l'enseignement agricole

SIGEA: actualités des SIG pour l'enseignement agricole

-

Data and GIS tips

Data and GIS tips

-

Neogeo Technologies

(1 non lus)

Neogeo Technologies

(1 non lus) -

ReLucBlog

ReLucBlog

-

L'Atelier de Cartographie

L'Atelier de Cartographie

-

My Geomatic

-

archeomatic (le blog d'un archéologue à l’INRAP)

archeomatic (le blog d'un archéologue à l’INRAP)

-

Cartographies numériques

Cartographies numériques

-

Veille cartographie

Veille cartographie

-

Makina Corpus

-

Oslandia

Oslandia

-

Camptocamp

Camptocamp

-

Carnet (neo)cartographique

Carnet (neo)cartographique

-

Le blog de Geomatys

Le blog de Geomatys

-

GEOMATIQUE

GEOMATIQUE

-

Geomatick

Geomatick

-

CartONG (actualités)

CartONG (actualités)

Toile géomatique francophone

Toile géomatique francophone

-

17:08

17:08 Dessin du géographe n°93. Des leporellos géographiques : E. F. Bossoli dans les Alpes italiennes

sur Les cafés géographiquesEn parcourant les allées du Salon international des Carnets de Voyage d’Aix-en-Provence, j’ai constaté que beaucoup de carnetières et carnetiers dessinent des croquis panoramiques sur des bandes de papiers pliants qu’on appelle des « leporellos », en souvenir du valet de Don Juan chez Mozart et de la liste des femmes conquises par son maître, qu’il déplie en chantant au début du premier acte de l’opéra. Or, il est arrivé à des géographes de dessiner de grands croquis panoramiques en assemblant des feuilles dans le sens de la largeur, selon les besoins de la largeur de l’horizon topographique à prendre en compte. Dans la page web que j’ai consacrée ici à Pierre Deffontaines, j’aurais pu signaler son assemblage panoramique concernant la ville de Barcelone vue du Mont Tibidabo. [https:]]

Lequel était largement battu en dimension par celui qu’il avait réalisé au Brésil concernant la Baie de Rio (plus d’un mètre de large), étudié par Antoine Huerta en 2009 (« Une ascension, une œuvre : la baie de Rio de Janeiro vue du Corcovado par Pierre Deffontaines », Confins, número 5).

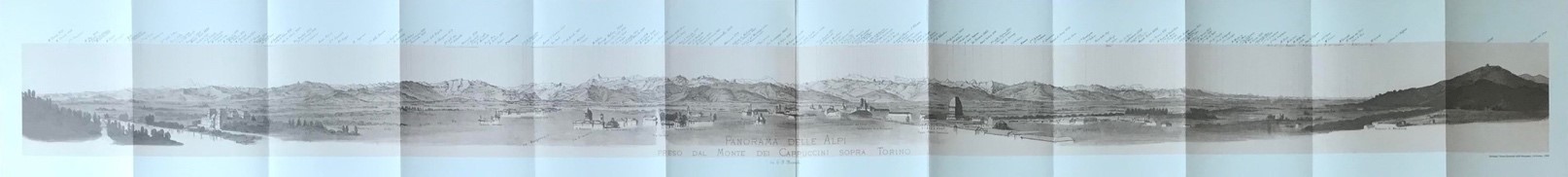

[confins.revues.org]Mais il faut reconnaître que sur le plan de la qualité du dessin panoramique, les dessinateurs et peintres professionnels ont produit dans la seconde moitié du 19e siècle des leporellos pour la clientèle touristique des régions de montagne, plus efficaces et imposants. Il s’agissait de procurer aux visiteurs des images permettant de situer et de reconnaître sur le terrain les principaux sommets des grandes chaînes. Les nouveaux voyageurs voulaient pouvoir nommer et mémoriser ces grands sites dans un nouveau « musée imaginaire » des formes de la terre. Lors d’un passage à Turin, une excursion au Monte dei Cappuccini m’a permis d’acquérir un classique de ce genre de leporello : le Panorama delle Alpi (dal Monte dei Cappuccini, Torino, 1874), réalisé par Edoardo Francesco Bossoli, peintre piémontais spécialisé dans les panoramas de montagne et qui fit une grande carrière dans ce type de dessin.

Fig. 1-Panorama des Alpes (depuis le Mont des Capucins, Turin) (E. F. Bossoli, 1874). Source : collection de l’auteur.

Sur un accordéon de papier de 1,93 sur 0,14m (surface de l’image), il a représenté à l’encre (plume et lavis) les Alpes Piémontaises depuis la vallée alpine du Po au SO jusqu’au Monte Generoso au NE, c’est-à-dire le versant italien de la chaîne depuis la haute vallée du Po à gauche du panorama jusqu’à la région des Lacs à droite, en passant par la région du val d’Aoste au centre. Le Mont Blanc n’est pas visible car masqué par le massif du Grand Paradis. Le Mont Rose (4 638m) et le Lyskamm (4 538m) sont donc les 2 plus hauts sommets de la ligne des crêtes figurées par le peintre.

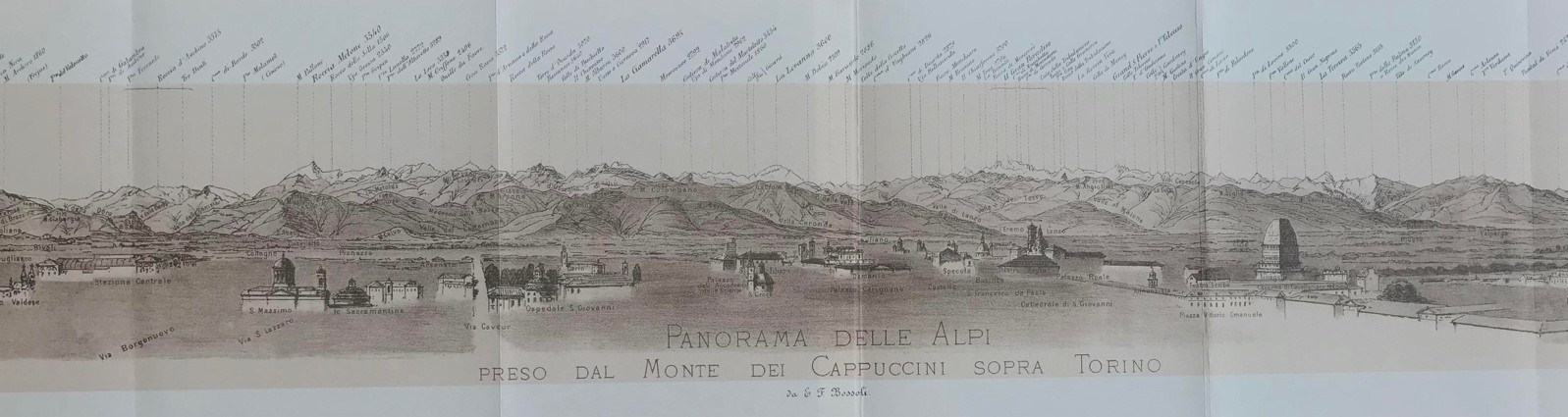

Fig. 2-Panorama des Alpes (depuis le Mont des Capucins, Turin) (E. F. Bossoli, 1874) (détail, partie centrale). Source : collection de l’auteur.

L’essentiel est donc ici de figurer les sommets de la façon la plus « lisible » possible, d’où le dessin au trait (plume) et le lavis d’encre sépia. Mais dans les avant-plans de la ville et de sa campagne un certain nombre de monuments et d’édifices urbains bien connus sont dessinés pour servir de points de repère à la visée des sommets et à leur position sur la ligne des crêtes, le croquis panoramique servant alors pour le touriste de mini-table d’orientation.

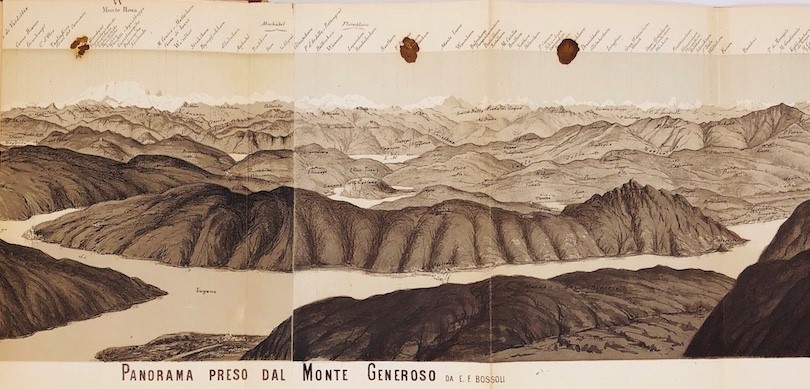

Dans ce cas turinois, la faible altitude relative du Mont des Capucins au-dessus de la ville (moins de 70 m au-dessus du Pô) en fait une vue presque horizontale, et l’effet de masque des sommets des premiers plans devant les suivants en devient très important. Un autre leporello emblématique de la production de Bossoli, celui du Panorama preso dal Monte Generoso, réalise une vue quasi aérienne du lac de Lugano et de ses environs, car le sommet en question domine ce lac de ses 1 701 m (soit 1 361m d’altitude relative) et offre des vues spectaculaires vers les grandes Alpes Suisses, Italiennes et Françaises à l’horizon nord et ouest. Le croquis devient franchement panoramique et permet une lecture du paysage qui se rapproche de celle d’une carte. Les lignes de crêtes se succèdent en profondeur sur plus de 60 kilomètres, et la dernière (la plus lointaine) est celle des plus de 4 000 m du Mont Blanc, du Mont Rose, des Alpes du Valais et de l’Oberland bernois, figurée en blanc.

Fig. 3-Panorama pris depuis le Monte Generoso (E. F. Bossoli, 1875). Source : Boletino del Club Alpino Italiano.

Ces deux œuvres sont donc emblématiques de cette production picturale considérable dans la seconde moitié du 19e siècle, destinée à participer de l’invention du paysage de la chaîne des Alpes. Une bibliographie abondante en a repris l’étude dans la géographie contemporaine. Par exemple Cllaudio Ferrata a étudié pour le Tessin La Fabrique du Paysage dans la Région des lacs du Sud des Alpes (Le Globe, tome 147/ GEA, N°23/ 2007, p.29-48). Il cite dans II teatro del paesaggio, (in Ferrata C. (a cura di), //senso dell’ospitalita?, pp. 57-67, 2006)) les travaux graphiques alpestres de Bossoli, dans un paragraphe où il traite de l’« art de voir ». On ne peut être mieux au cœur de la question du dessin géographique.

Roland Courtot, mars 2023

-

15:31

15:31 Du 14 au 16 novembre 2023 à Aix en Provence : formation "savoir utiliser les Fichiers fonciers"

sur Datafoncier, données pour les territoires (Cerema)Publié le 10 novembre 2023Une session de formation "Savoir utiliser les Fichiers fonciers" se tiendra du 14 au 16 novembre 2023 (30 Rue Albert Einstein, sur le site du Cerema Méditerranée à Aix en Provence) Cette session est à destination des bénéficiaires des Fichiers fonciers et des bureaux d'études. Vous trouverez le contenu et le coût de la formation dans la rubrique Accompagnement Inscription jusqu'au 25 octobre (…)

Lire la suite

-

8:10

8:10 Utilisation de la géomatique pour la gestion optimisée des chantiers de construction urbaine

sur Veille cartographieCet article Utilisation de la géomatique pour la gestion optimisée des chantiers de construction urbaine est apparu en premier sur Veille cartographique 2.0.

La gestion des chantiers de construction urbaine constitue un défi majeur dans les environnements urbains d’aujourd’hui. Pour répondre à ce défi, l’utilisation de la géomatique offre des possibilités prometteuses. En combinant les technologies géospatiales avancées avec les pratiques de construction traditionnelles, il est possible d’optimiser la planification, la mise en œuvre et la gestion des […]

Cet article Utilisation de la géomatique pour la gestion optimisée des chantiers de construction urbaine est apparu en premier sur Veille cartographique 2.0.

-

17:14

17:14 Reappearance of the Dnieper river after the destruction of Kakhovka dam

sur Séries temporelles (CESBIO)The Kakhovka Reservoir was created in 1956. As the level of the reservoir drops at a staggering rate of two meters per day, it is now possible to see the ancient river reappear in satellite images.

I have georeferenced a 1943 German military map published by Defense Express in their article « 1943 Maps Show What Ukraine’s Kakhovka Reservoir Will Look Like When the Waters Settle Down » to verify if the Dnieper returns to its original state before the dam was constructed.

German General Staff map issued in 1943 and Sentinel-2 image acquired on 18 June 2023

German General Staff map issued in 1943 and Sentinel-2 image acquired on 18 June 2023

18 June 2023 vs 1943

18 June 2023 vs 1943

The former river is also visible near the Zaporizhzhia Nuclear Power Plant. According to the French Institute for Radiation Protection and Nuclear Safety the dikes of the cooling pond can withstand a Dnieper level of 10 m in the vicinity of the power plant. The level reached 11.8 m on June 9. It should be already well below 10 m by now but the cooling pond remains full.

Almost two weeks after the destruction of the dam this is how Lake Kakhovka looks… (June 18) pic.twitter.com/KQRvshMZEf

— Simon Gascoin (@sgascoin) June 19, 2023

The lake water level can be monitored by satellite altimetry in Theia’s HydroWeb website. However, the data are no longer updated due to the lack of water to reflect the signal emitted by the altimeter.

Update on June 21, with a new Sentinel-2 image acquired on June 20:

The magnitude of the hydrological disruption caused by the destruction of the #KakhovkaDam is mind-blowing. 2000 square kilometers (800 sq miles) restored to pre-1956 condition in two weeks. @CopernicusLand pic.twitter.com/wUWvwDAloH

— Simon Gascoin (@sgascoin) June 21, 2023

Top picture by Katerina Polyanska – Own work, CC BY-SA 3.0, [https:]

-

20:55

20:55 uMap, un logiciel open source qui permet de créer des cartes en ligne

sur Veille cartographieCet article uMap, un logiciel open source qui permet de créer des cartes en ligne est apparu en premier sur Veille cartographique 2.0.

uMap a été développé sous le modèle de OpenStreetMap. Ce logiciel permet de créer des cartes en ligne à l’échelle du monde entier. En outre vous pouvez vous géolocaliser sur la carte, faire des mesures de distances à l’aide de différents points, ajouter des points (marqueurs), des lignes, des polygones en précisant le calque dans […]

Cet article uMap, un logiciel open source qui permet de créer des cartes en ligne est apparu en premier sur Veille cartographique 2.0.

-

17:39

17:39 Rivalités sino-américaines autour de la cartographie géologique de l’astre lunaire (partie 2/2)

sur Veille cartographieCet article Rivalités sino-américaines autour de la cartographie géologique de l’astre lunaire (partie 2/2) est apparu en premier sur Veille cartographique 2.0.

Par NicoLX (Nicolas Le Maux) De la nouvelle carte géologique nippo-américaine de la Lune en 2020 à celle de la Chine en 2022 Après une longue rivalité avec l’URSS, les États-Unis ont longtemps été seuls à la pointe de la Sélénologie : l’étude du satellite lunaire, et plus parfois, plus particulièrement, l’étude géologique de […]

Cet article Rivalités sino-américaines autour de la cartographie géologique de l’astre lunaire (partie 2/2) est apparu en premier sur Veille cartographique 2.0.

-

16:43

16:43 Rivalités sino-américaines autours de la cartographie géologique de l’astre lunaire (partie ½)

sur Veille cartographieCet article Rivalités sino-américaines autour de la cartographie géologique de l’astre lunaire (partie ½) est apparu en premier sur Veille cartographique 2.0.

Par NicolasLX (Nicolas Le Maux) Cartographie géologique lunaire américaine : des années 60 à 2020 Les premières cartes américaines géologiques de la lune datent toutes des missions Apollo de 1961 à 1972. Une numérisation des versions s’opère depuis 2013. Elles réunissent en 6 volets nommés cartes régionales, la totalité de la surface lunaire (Lunar 1:5M […]

Cet article Rivalités sino-américaines autour de la cartographie géologique de l’astre lunaire (partie ½) est apparu en premier sur Veille cartographique 2.0.

-

13:04

13:04 Prix du Livre de Géographie des Lycéens et Etudiants 2023

sur Les cafés géographiquesLe prix du Livre de Géographie des Lycéens et Etudiants est une création récente (2020), destinée à faire découvrir et aimer la géographie à travers une sélection annuelle de cinq ouvrages reflétant la diversité de la discipline. Les deux premières éditions avaient récompensé en 2021 Sylvie Lasserre pour Voyage au pays des Ouïghours (Editions Hesse, 2020) et en 2022 Camille Schmoll pour Les damnées de la mer (La Découverte, 2020).

Cette année, le prix a été accordé à Monde enchanté, Chansons et imaginaires géographiques de Raphaël Pieroni et Jean-François Staszak (1). On comprend l’enthousiasme des jeunes gens qui l’ont choisi pour un ouvrage ludique et joyeux dont l’objet d’analyse est constitué de 36 chansons (2) écrites majoritairement en français et en anglais, des années 1930 à nos jours.

Jean-François Staszak a présenté, à la Société de géographie, son travail et celui de son collègue, comme une réalisation de géographie culturelle qui étudie le monde tel qu’on l’appréhende à travers les différents systèmes de représentation. Face aux critiques qui reprochent à cette discipline son caractère trop souvent élitiste et conceptuel, il se réjouit de présenter un travail portant sur des chansons, c’est-à dire des témoignages de la culture populaire empreints d’émotion.

Il a été demandé aux collègues genevois des auteurs de choisir une chanson connue comme enjeu géographique et de produire un texte court à destination du grand public. Ce choix peut être suggéré par le texte même de la chanson ou par les lieux où elle a été entendue. Certaines chansons ont participé à la construction de lieux. Il est ainsi plaisant de savoir qu’un Café Pouchkine a été inauguré en 1999 par Gilbert Bécaud sur la Place Rouge à Moscou, alors que sa chanson Nathalie date de 1964 ! (3)

Michèle Vignaux, juin 2023

1) Georg Editeur, 2021. Cet ouvrage a été suivi de Villes enchantées, en 2022. Il sera à son tour complété par Voyages enchantés en cours de réalisation. 2) Les trois ouvrages évoqueront 121 chansons dont 81 en français. 3) Le 22 septembre 2022, dans Géographie à la carte, France Culture a présenté le sujet des rapports entre la géographie et la chanson, en invitant notamment Jean-François Staszak. Parmi les principales questions abordées lors de l’émission, on retrouve bien sûr celles du livre qui vient d’être récompensé : comment les chansons racontent-elles les villes ? La culture populaire peut-elle matériellement transformer un territoire ? La puissance évocatrice de certaines villes dans les chansons a-t-elle un aspect géopolitique ? [https:]] -

12:59

12:59 Géopolitique de la Corée du Sud

sur Les cafés géographiques

-

14:11

14:11 Cartographie des capteurs de vélo automatiques de la métropole de Bordeaux

sur Veille cartographieCet article Cartographie des capteurs de vélo automatiques de la métropole de Bordeaux est apparu en premier sur Veille cartographique 2.0.

La métropole de Bordeaux s’engage pour la mobilité et les pratiques de mobilités douces notamment le vélo. Elle a récemment obtenu le statut de “Territoire vélo” qui reconnaît les actions favorisant toutes les pratiques cyclables à la fois en termes de loisirs, tourisme ou mobilités quotidienne. Pour obtenir ce statut, la métropole a su proposer […]

Cet article Cartographie des capteurs de vélo automatiques de la métropole de Bordeaux est apparu en premier sur Veille cartographique 2.0.

-

17:43

17:43 NEYOS, une passion pour la randonnée en montagne

sur Veille cartographieCet article NEYOS, une passion pour la randonnée en montagne est apparu en premier sur Veille cartographique 2.0.

Si vous êtes passionnés par la randonnée, ne serait-ce qu’un peu comme moi ou que vous soyez un véritable adepte de ce sport, et si par dessus le marché vous êtes un amoureux des cartes et des systèmes de positionnement, alors vous êtes bien tombés sur le bon article car celui-ci va vous parler des […]

Cet article NEYOS, une passion pour la randonnée en montagne est apparu en premier sur Veille cartographique 2.0.

-

16:50

16:50 La cartographie dans le domaine militaire

sur Veille cartographieCet article La cartographie dans le domaine militaire est apparu en premier sur Veille cartographique 2.0.

Introduction La cartographie, en tant qu’outil de représentation géographique, joue un rôle essentiel dans le domaine militaire. En effet, depuis des siècles, les armées du monde entier ont utilisé des cartes pour comprendre le terrain, prendre des décisions stratégiques. Cet article explore l’utilisation de la cartographie dans le domaine militaire, mettant en évidence son importance […]

Cet article La cartographie dans le domaine militaire est apparu en premier sur Veille cartographique 2.0.

-

16:34

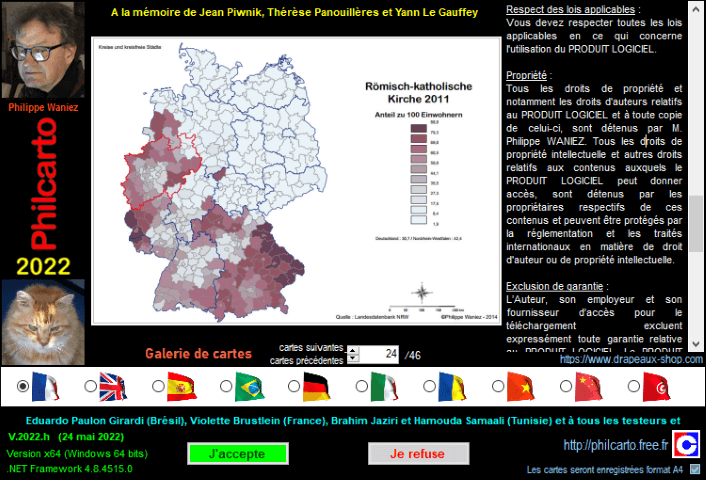

16:34 Présentation du logiciel Philcarto

sur Veille cartographieCet article Présentation du logiciel Philcarto est apparu en premier sur Veille cartographique 2.0.

De nombreux logiciels sont disponible pour aider les géomaticiens ou les cartographes à cartographier ou représenter leurs données. Philcarto est l’un d’entre eux. Il a été crée par Philippe Waniez, géographe à l’université de Bordeaux et est un logiciel totalement gratuit. En parallèle du logiciel Philcarto, il est à l’origine de Phildigit et Eclat, des […]

Cet article Présentation du logiciel Philcarto est apparu en premier sur Veille cartographique 2.0.

-

14:30

14:30 CartONG continue d’amplifier son offre de soutien pro bono !

sur CartONG (actualités)Pour la deuxième année consécutive et grâce au Fonjep, CartONG propose un soutien ponctuel pro bono en cartographie et/ou gestion des données aux petites et moyennes structures de solidarité locale et internationale.

-

9:57

9:57 GeoRhena : un SIG qui fait dialoguer trois pays

sur Veille cartographieCet article GeoRhena : un SIG qui fait dialoguer trois pays est apparu en premier sur Veille cartographique 2.0.

GeoRhena est un SIG accueillant des données géographiques transfrontalières, en opendata, capitalisée à l’échelle du Rhin supérieur croisant le territoire français, suisse et allemand. Logo GeoRhena : [https:] Ce projet est porté par la Collectivité européenne d’Alsace et co-financées par plusieurs collectivités de chacun des 3 pays (3 en France, 5 en Allemagne et […]

Cet article GeoRhena : un SIG qui fait dialoguer trois pays est apparu en premier sur Veille cartographique 2.0.

-

9:56

9:56 L’évènement annuel de la géonumérique : le GeoDataDays 2023 fixé à Reims

sur Veille cartographieCet article L’évènement annuel de la géonumérique : le GeoDataDays 2023 fixé à Reims est apparu en premier sur Veille cartographique 2.0.

La représentation spatiale au service des enjeux environnementaux est un réel défi de ces dernières années. Cartographie, modélisation, différentes méthodes pouvant être utilisée pour représenter les conséquences du changement climatique et y développer des outils d’aide pour les études environnementales : gestion durable des ressources naturelles, identification des corridors écologiques à protéger, zones de température à […]

Cet article L’évènement annuel de la géonumérique : le GeoDataDays 2023 fixé à Reims est apparu en premier sur Veille cartographique 2.0.

-

9:27

9:27 Quelles adaptations pour l’augmentation de la demande de logements et pour le réchauffement climatique pour Paris d’ici 2030 ?

sur Veille cartographieCet article Quelles adaptations pour l’augmentation de la demande de logements et pour le réchauffement climatique pour Paris d’ici 2030 ? est apparu en premier sur Veille cartographique 2.0.

Quelles adaptations pour l’augmentation de la demande de logements et pour le réchauffement climatique pour Paris d’ici 2030 ? Le lundi 5 juin 2023, le Conseil de Paris doit voter le nouveau Plan Local d’Urbanisme de la Capitale. Ce nouveau plan s’inscrit dans le contexte de neutralité carbone d’ici 2050 et d’adaptation aux impacts du changement […]

Cet article Quelles adaptations pour l’augmentation de la demande de logements et pour le réchauffement climatique pour Paris d’ici 2030 ? est apparu en premier sur Veille cartographique 2.0.

-

16:25

Évolution d'Act'if, la plateforme de l'économie circulaire

sur Makina CorpusLa CCI Occitanie a fait appel à Makina Corpus pour apporter une évolution substantielle à la solution Act'if.

-

12:32

12:32 La différence entre les SIG et la géomatique

sur Veille cartographieCet article La différence entre les SIG et la géomatique est apparu en premier sur Veille cartographique 2.0.

Bien qu’ils partagent certains concepts et outils, ils ont des domaines d’application distincts et des approches différentes. La géomatique est un terme plus large qui englobe l’ensemble des disciplines et des technologies liées à l’acquisition, à la gestion, à l’analyse et à la représentation de données géographiques. Elle intègre différents domaines tels que la géodésie, […]

Cet article La différence entre les SIG et la géomatique est apparu en premier sur Veille cartographique 2.0.

-

9:26

9:26 Webinaires "Carte blanche" sur les formes contemporaines de cartographies et de géovisualisations de données (GDR Magis)

sur Cartographies numériques

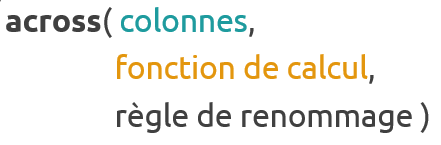

Dans le cadre de ses activités, l'AR9 propose une série de Webinaires mensuels sous la forme d'une "Carte blanche", un temps consacré à l'exploration et aux discussions sur les formes contemporaines de cartographies et de géovisualisations de données. L'objectif de ces temps d'échange est à la fois de permettre des présentations de travaux, de réalisations ou d'expérimentations cartographiques diversifiées et des échanges collectifs sur les leviers et les enjeux actuels de la représentation de données spatiales tant d'un point de vue conceptuel, opérationnel, méthodologique que technique.Format

Durée : Á partir de 12h30, pour 30mn de présentation en mode visioconférence + 30 mn d'échanges et de discussions. Le webinaire est animé et modéré par l'un.e des porteurs de l'AR 9 (Anne-Christine Bronner, Boris Mericskay, Etienne Côme, Françoise Bahoken, Nicolas Lambert).

Webinaires à venir- 6 juillet 2023 : Najla TOUATI et Laurent JÉGOU : De la carte climatique au chorotype climatique : propositions de modèles graphiques (animation Anne-Christine Bronner)

- 7 septembre 2023 : Jean-Philippe GAUTIER présentera www.cartostat.eu, une application web de cartographie statistique (animation Anne-Christine Bronner)

- 5 Octobre 2023 : Julien GAFFURI, Eurostats, @julgaf, gridviz (Animation Etienne Côme)

- 7 Novembre 2023 : [Maher BEN REBAH], UMR 7533 LADYSS, La plateforme ELYSSA de géovisualisation sur les élections (Animation Françoise Bahoken)

Webinaires passés- 11 mai 2023 : RAJERISON Mathieu, Cerema, @datagistips

Génération (de) cartes (animation Etienne Côme). ? Vidéo du Webinaire ? Ressources Slides

- lundi 17 avril 2023 : DOUET Aurélie, IE UMR Géographie-cités,

CartoDouetna.rm=TRUE. Requête, interactivité et gestion des données manquantes

? Vidéo du Webinaire ? Ressources

- Jeudi 2 février 2023 AUMOND Pierre (CR, Univ. Gustave Eiffel-CEREMA/UMRAE), @SoundCartograp1

Cartographie du paysage sonore urbain ? Vidéo du Webinaire

- Mercredi 7 décembre 2022 Philippe RIVIERE (Visions carto, Observable)

Faire des cartes statistiques avec Observable Plot ? Vidéo du Webinaire

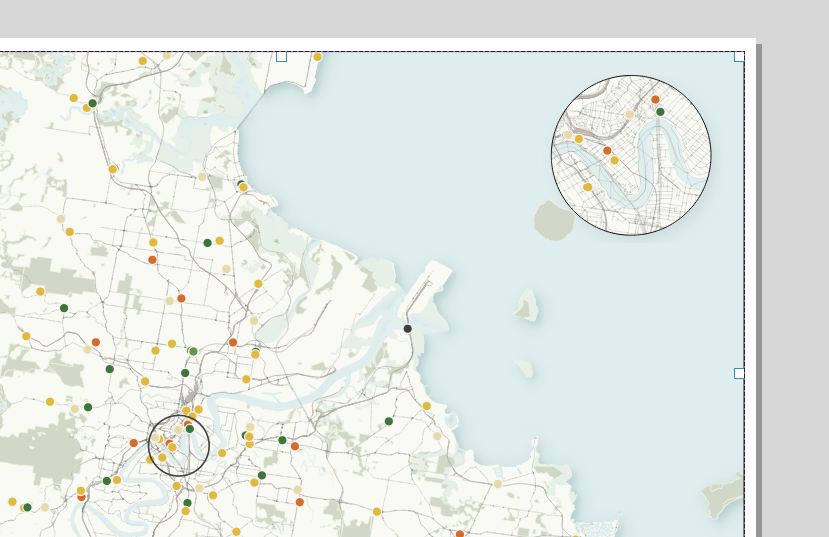

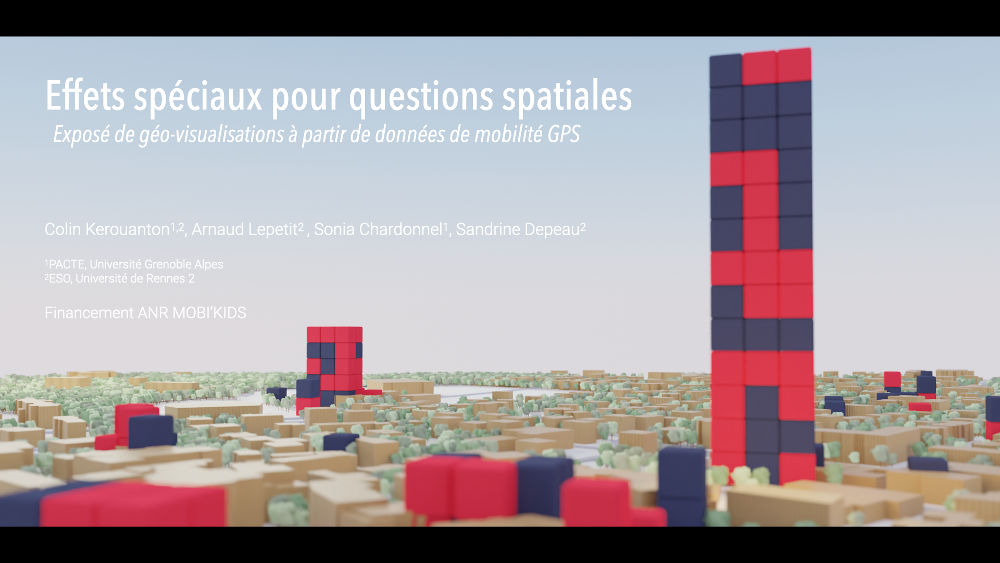

- Mardi 8 novembre 2022 Colin KEROUANTON (IR, PACTE)

Effets spéciaux pour questions spatiales ? Vidéo du Webinaire

Intervenir dans le webinaire

Si vous êtes intéressé.e.s à venir présenter vos travaux ou expérimentations cartographiques vous êtes les bienvenus ! Que vous soyez dans le monde académique, dans le secteur privé ou passionné de cartographie et de géovisualisation contactez le collectif de l'AR9 : @ collectif de l'AR.

Informations nécessaires sur votre intervention :- un titre ;

- une image ;

- un résumé de 3-4 lignes ;

- vos noms, prénoms @ et affiliations.

Projet de l'action de recherche AR9 du GDR Magis

L'objectif général de cette action de recherche du GDR MAGIS est de fédérer des réflexions et des travaux scientifiques d’origines disciplinaires variées menés autour de la (carto)graphie contemporaine au sens large et de la (géo)visualisation de données. Pour ce faire, elle propose d’une part, de mener une veille théorique, méthodologique et technique sur les modalités de la fabrique des cartes et, d’autre part, de fédérer et d’animer une communauté de chercheurs (essentiellement géographes, géomaticiens, cartographes, informaticiens...) lors d’ateliers et de séminaires thématiques et méthodologiques. Lire le projet.

Articles connexes

Conférence Spatial Analysis and GEOmatics (SAGEO) 2023Des sources aux SIG : des outils pour la cartographie dans les Humanités numériques

Des outils pour la cartographie dans les humanités numériques (Plateforme géomatique de l'EHESS)

Humanités numériques spatialisées (revue Humanités numériques, n°3, 2021)

Utiliser l'application Observable pour créer ses propres visualisations de donnéesComment différencier infographie et data visualisation

- 6 juillet 2023 : Najla TOUATI et Laurent JÉGOU : De la carte climatique au chorotype climatique : propositions de modèles graphiques (animation Anne-Christine Bronner)

-

9:00

Outil de suivi temporel des anomalies sur une plateforme de qualité des analyses et des prévisions océanographiques

sur Makina CorpusMercator Océan possède un outil de visualisation et d'analyse de données océanographiques dénommé Moniqua.

-

12:16

12:16 L’ère des superpétroliers. Les transports maritimes français au XXe siècle

sur Les cafés géographiques

Ce travail d’historien (1) porte sur un court XXe siècle. Le pétrole n’est devenu l’« or noir » qu’entre le moment où la Grande Guerre révéla la dépendance dangereuse de notre pays et celui où il s’est transformé en « mal-aimé » dont il faut se débarrasser le plus possible dans les dernières années du siècle. Entre temps il occupe une place majeure dans les préoccupations des gouvernants, des dirigeants d’entreprise, mais aussi une place non négligeable dans celle des Français de plus en plus attachés à leur voiture. Quant à l ’« ère des superpétroliers » qui donne son titre à l’ouvrage, elle ne dure guère plus de deux décennies car la prouesse technique se révèle vite une catastrophe financière.

Le sujet comprend plusieurs composantes, économique, technique et politique. La première composante comprend la production ou l’achat du pétrole brut, le transport par oléoduc et surtout par bateau et le raffinage sur le sol national. Ces trois activités peuvent être assurées par une même compagnie ou par plusieurs compagnies, parfois filiales d’un maison-mère. Les achats se font suivant des contrats à long ou à court terme ou sur un marché spot (2). Sur le plan technique, les chantiers navals ont produit des pétroliers de plus en plus performants, c’est-à-dire offrant des coûts de transport de plus en plus bas par tpl (tonne de port en lourd) transportée, grâce à leur gros tonnage. Mais la géographie a ses impératifs. Avec un tirant d’eau élevé un superpétrolier ne peut emprunter des détroits comme celui de Malacca, ou le canal de Suez. La composante politique est majeure. Dans une France dont le sous-sol ne contient pas pétrole, le devoir de l’Etat est d’assurer la sécurité de l’approvisionnement, donc d’avoir des relations stables avec les producteurs. Ce n’est pas la même chose d’acheter du pétrole à la Norvège ou dans un des pays du Moyen-Orient ! Ces trois composantes n’évoluent pas selon les mêmes rythmes. Plusieurs années s’écoulent entre la conception et la livraison d’un nouveau type de pétrolier alors qu’une crise politique peut bouleverser les flux pétroliers maritimes en quelques semaines, voire quelques jours. C’est en fonction de ces données que l’auteur a distingué quatre périodes entre 1931 et 1994.

1931-1958 : un programme d’autonomie maritime

Au lendemain de la Première Guerre mondiale, le nouvel Office National des Combustibles Liquides (1925) se donne comme objectifs de constituer une industrie pétrolière française avec la construction de navires-citernes et de rechercher des approvisionnements. Ce dernier but est facilité par les traités qui mettent fin à la domination ottomane au Moyen-Orient. La nouvelle CFP (Compagnie française des pétroles) obtient, au titre de réparations de guerre, 23,7% de la Turkish Petroleum Compagny. Le pétrole, extrait à Kirkouk, est alors transporté par oléoduc jusqu’à Tripoli puis convoyé par la CNP (Compagnie navale des pétroles, filiale de la CFP jusqu’aux ports de Gonfreville (Normandie) et La Mède (Provence).

Entre 1928 et 1938, la consommation de pétrole est multipliée par quatre et la France est le deuxième acheteur européen alors que le transport du brut s’effectue majoritairement sur des tankers étrangers. Par crainte d’une dépendance dangereuse en cas de guerre, le gouvernement fait voter une loi en 1928, renforcée par un décret en 1931, puis par un nouveau décret en 1950 (le premier décret est suspendu en 1939) instaurant l’obligation de pavillon. 50% des importations (en 1931) puis 66% (en 1950) doivent être faites sous pavillon français. Cette particularité – qui a duré jusqu’en 1992- a entraîné la perte de compétitivité de notre flotte, le coût du transport sur des navires à l’équipage uniquement français étant beaucoup plus élevé que sur les bateaux concurrents.

La Deuxième Guerre mondiale conduit à la dévastation de l’industrie pétrolière française qui doit être entièrement reconstruite. Le redressement maritime est achevé au début des années 1950. La France peut alors profiter de nouveaux gisements en Irak et la CNP livre des bateaux qu’on appelle déjà des « supertankers » avec un port en lourd supérieur à 30 000 tpl (norme permettant le passage dans le canal de Suez). Ses 104 navires permettent à la France d’occuper le 7ème rang mondial en 1954.

1956-1973 : l’âge d’or des transports maritimes français

En 1956, le Moyen-Orient (surtout l’Irak) fournit la majeure partie de la consommation pétrolière française. Chaque année, 25 Mt de brut sont exportés par les ports de Méditerranée orientale et 58 Mt empruntent le canal de Suez. La « Crise de Suez » bouleverse ce trafic. En juillet 1956, Nasser nationalise le canal de Suez, ce qui provoque, trois mois plus tard, une intervention militaire franco-britannique. Le canal est alors entièrement bloqué et les oléoducs Irak-Méditerranée détruits. Il faut réorganiser les itinéraires. Une seule solution : le contournement de l’Afrique par la route du cap de Bonne-Espérance (20 900 km entre le golfe Persique et la mer du Nord, au lieu de 12 000km par Suez), ce qui provoque l’explosion des taux d’affrètement. Même après la réouverture du canal, on ne revient pas à la situation antérieure. On combine un aller France-Moyen-Orient par Suez et un retour par Le Cap avec des bateaux chargés, mais surtout on envisage d’utiliser des pétroliers de très gros tonnage.

Les années 1960 sont des années de réorganisation avec l’arrivée du pétrole algérien et le lancement d’un ambitieux programme d’armement par la CNP qui devient le premier armateur français. Pour diminuer les coûts de transport, on construit des Very Large Crude Carrier (VLCC), de 150 000 tpl à 320 000 tpl. Le premier gros tanker de la CNP sort des chantiers navals en 1970. Ces superpétroliers sont le produit d’innovations technologiques de pointe qui doivent permettre de compenser les charges qui grèvent le pavillon français. Nouvelles proportions, aciers spéciaux, automatisation des tâches de chargement/déchargement, augmentation du débit des pompes…, les superpétroliers assurent une augmentation de la vitesse moyenne et une économie de personnel. Ils n’embarquent que des équipages très spécialisés, moins nombreux (les besoins en équipage ne croissent pas avec la taille du navire), aux conditions de travail attractives (avantages financiers et confort). Néanmoins, les dépenses d’équipage restent plus élevées que sous les pavillons étrangers car tous les marins doivent être français.

La course au gigantisme semble justifiée par une nouvelle fermeture du canal de Suez provoquée par la Guerre des 6 jours (1967). Même si on s’approvisionne alors sur des marchés plus diversifiés et plus proches de l’Europe (Algérie, Etats-Unis, Venezuela), le Moyen-Orient reste un fournisseur majeur. Le pétrolier-roi semble alors le 200 000 tpl capable d’emprunter à l’aller, le canal de Suez sur ballast et, au retour, la route du Cap en pleine charge. Le tonnage moyen de la CNP triple en 10 ans (1961-1971). Ces très gros navires posent néanmoins des problèmes de logistique (équipement des ports, taille des raffineries, passages des détroits), ce qui ne décourage pas la commande des Ultra Large Crude Carriers (ULCC) de plus de 350 000 tpl. L’industrie pétrolière française est alors partagée entre CFP-Total et Elf-Erap qui ont des participations dans les sociétés d’armement.

A la fin des années 1960, la consommation continue d’augmenter, mais la demande est flexible alors que l’offre est rigide. Les premiers doutes sur la viabilité du marché des transports apparaissent. Les experts évoquent le risque d’un excédent de tonnage dans les années à venir d’autant que de lourdes charges pèsent sur le pavillon français alors que les pavillons de complaisance se multiplient dans le monde.

1973- 1979 : les transports maritimes pétroliers dans la tourmente

1973 est une année-tournant dans l’histoire des transports pétroliers. A la suite de la guerre du Kippour (octobre 1973), les pays arabes membres de l’OPEP décident d’augmenter unilatéralement le prix du baril de brut (quadruplement du prix en un trimestre) et d’instaurer un embargo sur les exportations destinées aux pays alliés d’Israël. C’est le premier choc pétrolier. Stagnation de la consommation et accès à des ressources plus proches du consommateur (Alaska, mer du Nord) entraînent la surcapacité des transports maritimes et de l’industrie du raffinage. Il faut alors annuler les commandes et réduire les charges au maximum. Pour répondre à ce dernier objectif, plusieurs solutions sont adoptées : ralentissement de la vitesse, utilisation des pétroliers comme stockage flottant ou comme minéraliers ou céréaliers. Mais les armateurs français souffrent toujours d’un handicap supplémentaire par rapport à leurs concurrents, l’obligation de pavillon.

Dans les années 1970, la France est le seul pays à imposer à sa flotte pétrolière de naviguer sous pavillon national (les Etats-Unis ne l’imposent que pour le cabotage le long de leurs côtes). Le surcoût est alors évalué à 1 milliard de francs par an (de plus, l’obligation de pavillon est incompatible avec le Traité de Rome). En 1977 38% du port en lourd mondial naviguent sous un pavillon de complaisance (Panama, Liberia, Bahamas…) qui fait bénéficier les armateurs d’avantages fiscaux, de facilité d’immatriculation et de l’emploi d’équipages étrangers aux charges sociales et salariales réduites. Mais les marées noires provoquées par des navires affrétés sous pavillon de complaisance soulèvent la colère des opinions publiques. Le traumatisme du naufrage de l’Amoco Cadiz (234 000 tpl) au large de Portsall (Bretagne) en est un exemple. Les organisations internationales doivent durcir leur réglementation.

1979-1994 : le crépuscule de la flotte pétrolière française

La Révolution iranienne de 1979 puis la guerre Iran-Irak de 1980-1988 provoquent une nouvelle flambée du prix du brut (augmentation du prix du baril par 5 ou 6 depuis 1978). C’est le deuxième choc pétrolier. Il est rapidement suivi d’un contre-choc (1981) car la demande s’effondre dans les pays consommateurs qui s’approvisionnent de plus en plus ailleurs qu’au Moyen-Orient (mer du Nord, Afrique de l’Ouest, Mexique…). C’est le cas de Total qui n’y achète plus que la moitié de son pétrole (Arabie Saoudite, E.A.U.). Entre 1979 et 1985, le trafic mondial de brut chute de 58%, ce qui provoque un excédent mondial de pétroliers, surtout dans la catégorie des plus grosses unités.

Face à cette baisse des besoins de capacité de transport, les armateurs français sont contraints d’opérer le retrait de navires, voués à la reconversion en vraquiers ou au désarmement et souvent à la démolition dans de grands chantiers où ils sont transformés en ferraille servant à la fabrication de nouveaux aciers.

Le redressement du commerce du pétrole à la fin des années 1980 ne permet pas d’éviter le naufrage des superpétroliers français. Les ULCC (Ultra large crude carrier) de plus de 300 000 tpl qui arrivent alors sur le marché, sont une réussite de la technologie française mais un échec économique. Lorsqu’ils sont mis en chantier au début des années 1970, deux certitudes motivaient le choix de pétroliers de gros tonnage, celle de la primauté croissante du golfe Persique comme fournisseur et celle d’une croissance continue de la demande. On néglige l’obstacle de leur tirant d’eau, trop élevé pour franchir le canal de Suez ou traverser les détroits de Malacca et du Pas de Calais. La CNN, filiale d’Elf, et la Société maritime Shell commandent donc quatre supertankers aux Chantiers de l’Atlantique capables de construire des navires de 500 000tpl. Mais dès leur mise en service, leur intérêt est remis en cause, révélant l’absence d’études sérieuses sur leur coût de fonctionnement. Non seulement leurs charges financières sont trop lourdes, mais il est difficile de trouver des cargaisons suffisantes. La contrainte du tirant d’eau les empêche de passer par Suez où la navigation est rétablie et l’impossibilité de rejoindre Rotterdam est un handicap majeur. Pour les opérateurs pétroliers, Le Havre dont l’arrière-pays est limité ne peut remplacer le port néerlandais ouvert sur le gros marché européen. Les ULCC sont donc condamnés.

La crise des transports pétroliers français est illustrée par le choix d’Elf qui désarme ses navires pour affréter l’équivalent à l’étranger. Plusieurs rapports commandés par l’Etat arrivent à la même conclusion : une surcapacité de la flotte, des navires vieillissants et surtout une absence de compétitivité due à la contrainte du pavillon. Pour continuer à assurer la sécurité des approvisionnements d’un pétrole dont on importe 96% de la consommation, on adopte un nouveau cadre juridique, le pavillon Kerguelen, en 1986. Sous ce pavillon, les équipages ne comprennent plus que 35% de marins français et ce sont les lois sociales et fiscales des TAAF qui s’appliquent. En 1996 c’est l’ensemble de la flotte pétrolière française (14 bateaux) qui arbore le pavillon Kerguelen. Mais le registre TAAF n’est qu’une réponse partielle à la crise car tous les pays européens adoptent des registres internationaux (dits « bis ») qui leur permettent de recruter des équipages entiers à très bas coût.

Après l’abandon d’une flotte en propre par le groupe Total puis la vente de CNN, dernier armateur français, en 1998, tous les tankers transporteurs de brut sont de propriété étrangère. C’est la fin des illusions françaises.

Aujourd’hui l’essentiel de la flotte mondiale circule sous pavillons de complaisance. Elle est répartie entre 350 compagnies qui siègent dans 50 pays. Les Majors ne possèdent plus que 4% du tonnage mondial. Les efforts de l’Etat français pour assurer la sécurité de l’approvisionnement en pétrole ne portent plus sur le brut mais sur le transport des produits raffinés (3).

Notes :

(1) Benoît Doessant, L’ère des superpétroliers, Editions universitaires François Rabelais, Tours, 2022. (2) Marché spot : appelé aussi « marché au comptant ». Dans ce cas,les actifs négociés font l’objet d’une livraison et d’un règlement instantanés. (3) En dehors de l’évolution de la taille des navires pétroliers, la double coque représente une innovation technologique importante pour limiter le risque des pollutions. L’échouement du pétrolier Exxon Valdez en 1989 a joué un rôle important dans l’essor de cette technologie en suscitant de nouvelles réglementations maritimes.Michèle Vignaux, mai 2023

-

19:35

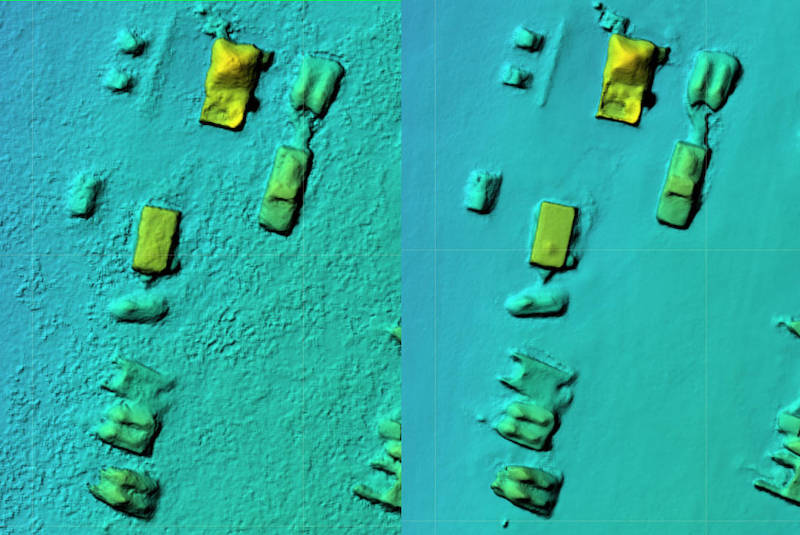

19:35 Suivi du réservoir de Kakhovka par satellite

sur Séries temporelles (CESBIO)La rupture du barrage de Kakhovka au sud de l’Ukraine a eu lieu tôt le matin du 6 juin 2023.

L’évolution de la hauteur d’eau du lac mesurée par altimétrie satellite est disponible sur Hydroweb. On peut constater que le niveau du lac est passé de 13,80 m le 8 juin à 08:18 à 11,86 m le 9 juin à 08:28, soit une baisse proche de deux mètres en 24h. La surface du lac Kakhovka dans la base OpenStreetMap est 2055 km2 (*). Donc en négligeant les apports en amont du réservoir et l’évaporation, on peut estimer le débit sortant en m3/s : 2055 km2 × 2 m / jour = 2055’000’000 × 2 / (24 × 3600) = 48’000 m3/s. A titre de comparaison, ce débit est similaire à celui du fleuve Congo, ou bien cent fois celui de la Seine.

Hauteur d’eau du réservoir de Kakhovka. Les données proviennent de trois satellites : Sentinel-6A (track number: 42), Sentinel-3A (track number: 197, 311, 584, 698) et Sentinel-3B (track number: 311,425,698).

La vidange du lac se voit aussi par imagerie optique. La bande infrarouge du capteur OLCI du satellite Sentinel-3 permet de bien distinguer la surface inondée en aval du barrage autour de Kherson [voir dans le EO Browser].

Images Sentinel-3 du 5 juin et 7 juin 2023

Images Sentinel-3 du 5 juin et 7 juin 2023

Ces images ont une résolution assez faible (300 m/pixel) donc on ne peut pas vraiment zoomer davantage sur Kherson. Pour cela il faut chercher des images Sentinel-2 à 20 m de résolution. Malheureusement, la fréquence de revisite de Sentinel-2 est plus faible et les inondations autour de Kherson sont cachées par des nuages dans l’image Sentinel-2 du 8 juin. En revanche, les images radar du satellite Sentinel-1 ne sont pas obstruées par les nuages et révèlent les zones inondées (baisse de la rétrodiffusion = teintes plus sombres) [EO Browser] :

Images Sentinel-1 la de rétrodiffusion en polarisation VV du 28 mai et 9 juin

Images Sentinel-1 la de rétrodiffusion en polarisation VV du 28 mai et 9 juin

Les images Landsat montrent aussi l’ampleur des inondations. La montée des eaux dans le fleuve Dniepr a même causé la remontée du niveau de l’eau dans son affluent l’Inhoulets !

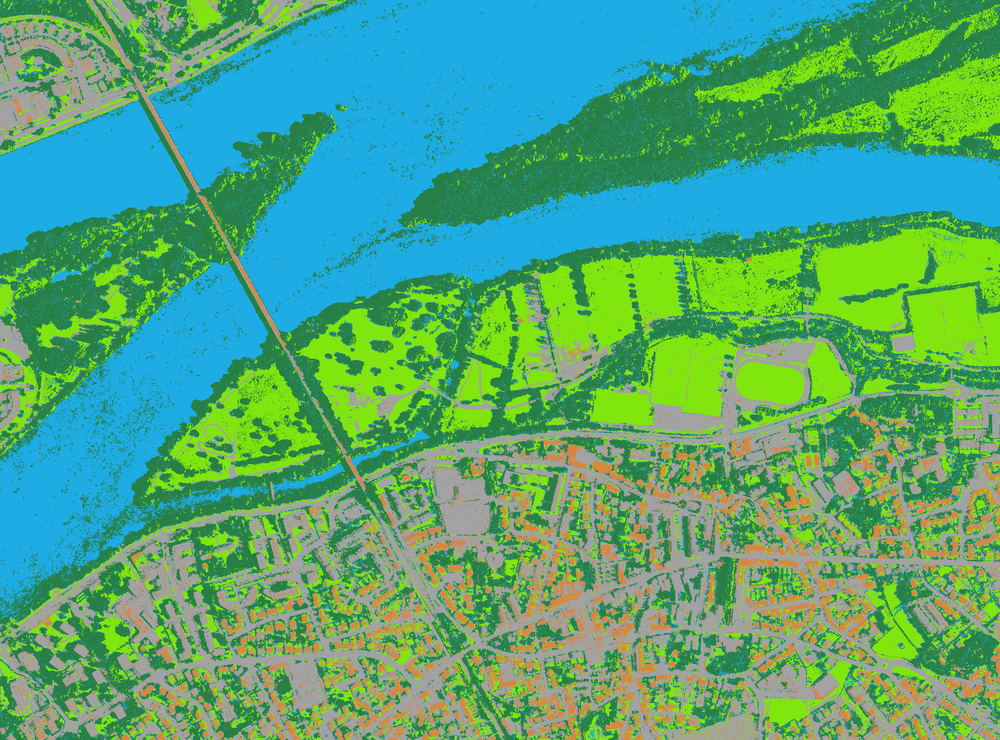

Images Landsat du 01 et 09 juin 2023 (composition colorée avec la bande infrarouge)

Images Landsat du 01 et 09 juin 2023 (composition colorée avec la bande infrarouge)

Sentinel-2 nous permet tout de même de voir le retrait du lac en amont du barrage. Vers Marianske, le trait de côté a reculé de plusieurs centaines de mètres en trois jours.

Images Sentinel-2 du 5 juin et 8 juin 2023

Images Sentinel-2 du 5 juin et 8 juin 2023

Toutes ces images et données sont publiques et peuvent être diffusées librement.

(*) On peut récupérer le polygone du lac via le plugin QuickOSM par exemple en recherchant la clé wikidata donnée sur openstreetmap.

et calculer sa surface via le menu vecteur > ajouter les attributs de géométrie (attention à bien sélectionner « Ellipsoïdale » ou bien d’utiliser un système de projection adapté au calcul des aires).

Pour s’assurer que le polygone est correct on peut l’exporter en GeoJSON ou KML et le superposer à une image satellite (ici Sentinel-3 09/06/2023) dans le EO Broswer.

Pour s’assurer que le polygone est correct on peut l’exporter en GeoJSON ou KML et le superposer à une image satellite (ici Sentinel-3 09/06/2023) dans le EO Broswer.

Pour en savoir plus sur Hydroweb : Cretaux J-F., Arsen A., Calmant S., et al., 2011. SOLS: A lake database to monitor in the Near Real Time water level and storage variations from remote sensing data, Advances in space Research, 47, 1497-1507 [https:]]

Photo du barrage de Kakhovka par Lalala0405 (Avril 2013) CC BY-SA 3.0, [https:]]

-

19:03

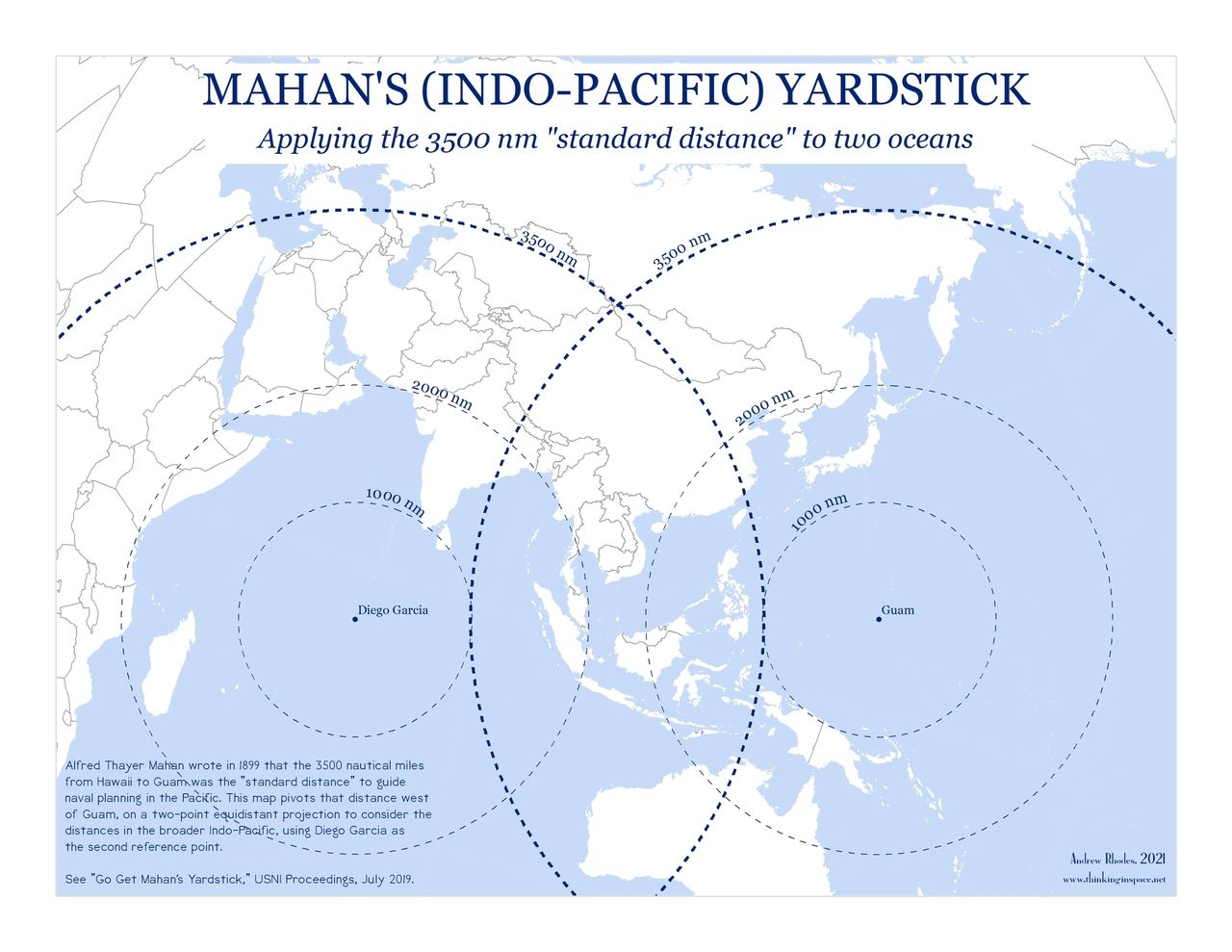

19:03 Le site Thinking in Space et ses cartes originales (Andrew Rhodes)

sur Cartographies numériques

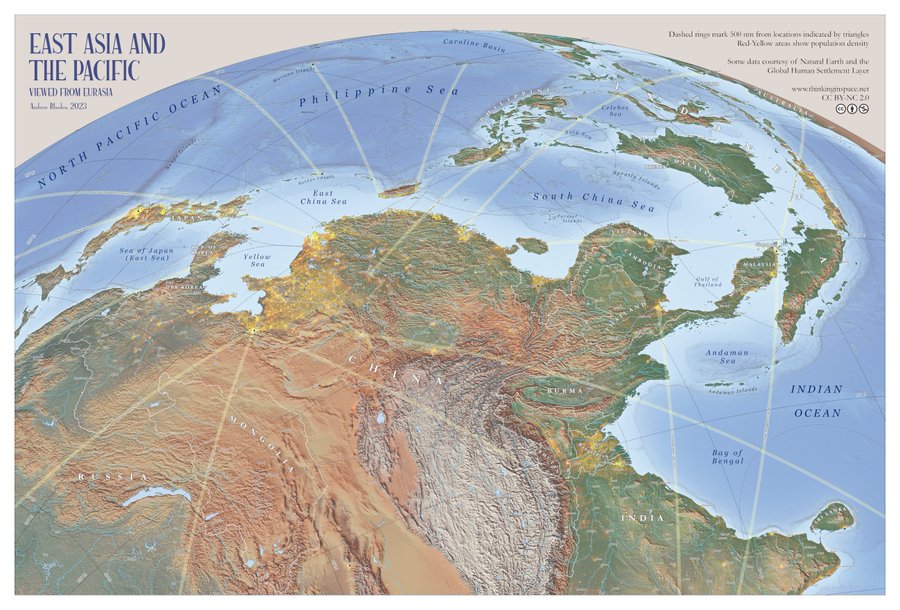

Sur son site Thinking in Space ("Penser dans l'espace"), Andrew Rhodes propose des cartes originales à télécharger gratuitement et des réflexions sur les cartes, la géographie et la géopolitique. Le site tient son nom de l'article qu'il a publié en 2019 dans la Texas National Security Review : Thinking in Space : The Role of Geography in National Security Decision-making. Pour l'auteur, « pouvoir penser dans l'espace constitue un outil crucial, mais souvent sous-estimé par les décideurs. Afin d'améliorer sa capacité à penser dans l'espace, la communauté qui travaille sur les questions de sécurité nationale doit pouvoir évaluer objectivement l'efficacité avec laquelle elle utilise l'information géographique et saisir toutes les occasions d'affiner ses compétences dans ce domaine ».Andrew Rhodes invite à regarder l'Asie et le Pacifique sous un angle différent et à discuter des enjeux géopolitiques et géostratégiques en Indopacifique. Selon lui, « invoquer la "tyrannie de la distance" est devenu un sujet de discussion habituel pour les responsables, soulignant les difficultés d'une réponse rapide et l'importance d'un déploiement avancé dans le Pacifique. Mais le contenu géographique est insuffisant pour prendre en charge ces éléments au-delà des anneaux de distance rudimentaires – qui sont souvent inexacts ». Reprenant les projections orthographiques de Richard Edes Harrison où il puise son inspiration, Andrew Rhodes invite à dépasser les visions imprimées par les projections traditionnelles. Sa carte murale de l'Asie orientale et du Pacifique vus de l'Eurasie est assez originale. Elle renverse le regard en privilégiant le point de vue de la Chine (cf ceintures de pays et d'îles voisines considérés sous son influence). La carte en haute résolution est téléchargeable en licence Creative Commons sur son site.

L'Asie orientale et le Pacifique vus depuis l'Eurasie

(source : A. Rhodes, Thinking in Space, licence Creative Commons, juin 2023)

Dans la même idée, Andrew Rhodes a élaboré la carte "Mahan's Yardstick" centrée à la fois sur l'île de Diego Garcia dans l'océan Indien et celle de Guam dans le Pacifique. L'idée est de reprendre la "distance standard" de 3500 milles nautiques établie en 1899 par Alfred Mahan estimée comme la zone d'intervention maximale pour conduire des opérations navales. Même si les moyens d'intervention militaires ont évolué depuis le XIXe siècle, la carte donne une perspective intéressante sur l'Indo-Pacifique (voir cet article) en soulignant les distances énormes à prendre en compte.

Carte reprenant la distance de 3 500 milles nautiques établie par Alfred Mahan pour appréhender l'immensité de la zone indo-pacifique (crédit : © A. Rhodes, Thinking in Space, 2021) Andrew Rhodes est l'auteur de plusieurs articles de réflexion croisant géopolitique et cartographie. La série de cartes en noir et blanc "Comment la Chine voit l'Asie" est à découvrir. Il cherche aussi à reproduire des cartes anciennes, telle cette carte murale DOD des années 1960. Il est par ailleurs l'auteur d'un article sur James Monteith, cartographe et auteur de manuels de géographie au XIXe qu'il considère comme « le maître des marges » (article en accès libre ici). Au travers de la géographie et des cartes, la visée pédagogique n'est jamais loin : il s'agit de comprendre le monde dans la complexité et la pluralité des regards. Avant de publier ses cartes, Andrew Rhodes les soumet souvent sur son compte Twitter pour voir les réactions qu'elles suscitent et pouvoir intégrer des améliorations en fonction des commentaires. Voir par exemple la carte de l'alliance militaire AUKUS (Australie - Royaume-Uni - Etats-Unis) telle qu'imaginée initialement et le projet cartographique repris et peaufiné quelques mois plus tard.

Andrew Rhodes est l'auteur de plusieurs articles de réflexion croisant géopolitique et cartographie. La série de cartes en noir et blanc "Comment la Chine voit l'Asie" est à découvrir. Il cherche aussi à reproduire des cartes anciennes, telle cette carte murale DOD des années 1960. Il est par ailleurs l'auteur d'un article sur James Monteith, cartographe et auteur de manuels de géographie au XIXe qu'il considère comme « le maître des marges » (article en accès libre ici). Au travers de la géographie et des cartes, la visée pédagogique n'est jamais loin : il s'agit de comprendre le monde dans la complexité et la pluralité des regards. Avant de publier ses cartes, Andrew Rhodes les soumet souvent sur son compte Twitter pour voir les réactions qu'elles suscitent et pouvoir intégrer des améliorations en fonction des commentaires. Voir par exemple la carte de l'alliance militaire AUKUS (Australie - Royaume-Uni - Etats-Unis) telle qu'imaginée initialement et le projet cartographique repris et peaufiné quelques mois plus tard.

Compte Twitter de Rhodes Cartography : @RhodesCartogra1

Liens pour télécharger directement les cartes achevées sur le site Thinking in Space

Sélection de cartes invitant à décentrer le regard sur la zone Indopacifique avec les commentaires :- Mahan's (Indo-Pacific) Yardstick (2021)

- Bathymetry of the Pacific Ocean (2021)

- Composite China Poster (2022)

- Population Density in Asia (2022)

- New Wall Map: East Asia and the Pacific (2023)

- Andrew Rhodes, Thinking in Space: The Role of Geography in National Security Decision-Making, Texas National Security Review 2.4 (November 2019): 90-108.

- Andrew Rhodes, Go Get Mahan’s Yardstick, U.S. Naval Institute Proceedings 145.7 (July 2019)

- Andrew Rhodes, The Second Island Cloud: A Deeper and Broader Concept for American Presence in the Pacific Islands, Joint Force Quarterly 95 (Fourth Quarter 2019): 46-53.

- Andrew J. Rhodes, The Geographic President: How Franklin D. Roosevelt Used Maps to Make and Communicate Strategy, The Portolan, Washington Map Society (Spring 2020) : 7–16.

- Andrew Rhodes, Same Water, Different Dreams: Salient Lessons of the Sino-Japanese War for Future Naval Warfare, Journal of Advanced Military Studies 11.2 (Fall 2020): 35–50.

- Andrew S. Erickson, The Andrew Rhodes Bookshelf: Guiding Leaders across the Indo-Pacific through Geo-History, Strategy & Visual Communications, China Analysis from Original Sources, 12 May 2021.

Articles connexes

La carte, objet éminemment politique : la Réunion au coeur de l'espace Indo-Pacifique ?

La carte, objet éminemment politique : la Chine au coeur de la "guerre des cartes"

La carte, objet éminemment politique. Les tensions géopolitiques entre Taïwan et la Chine

Etudier les conflits maritimes en Asie en utilisant le site AMTI

Une carte réactive de toutes les ZEE et des zones maritimes disputées dans le monde

Les frontières maritimes des pays : vers un pavage politique des océans ?

L'histoire par les cartes : James Monteith, cartographe et éducateur (1831-1890)

Le nord en haut de la carte : une convention qu'il faut parfois savoir dépasser

Projections cartographiques

-

15:41

15:41 Carte interactif de donations: de nouveaux indicateurs à réfléchir

sur Veille cartographieCet article Carte interactif de donations: de nouveaux indicateurs à réfléchir est apparu en premier sur Veille cartographique 2.0.

Comme le souligne Lukas Frank dans son article « Carte interactive d’aide alimentaire en Alsace« , 2016, les cartographies interactives présentent un intérêt dans l’accompagnement des donateurs dans leur démarche. En comparant plusieurs cartes de ce type sur des sites d’associations, on se rend compte qu’elles ont toutes les mêmes caractéristiques. Autrement dit, les informations transmises sont […]

Cet article Carte interactif de donations: de nouveaux indicateurs à réfléchir est apparu en premier sur Veille cartographique 2.0.

-

14:20

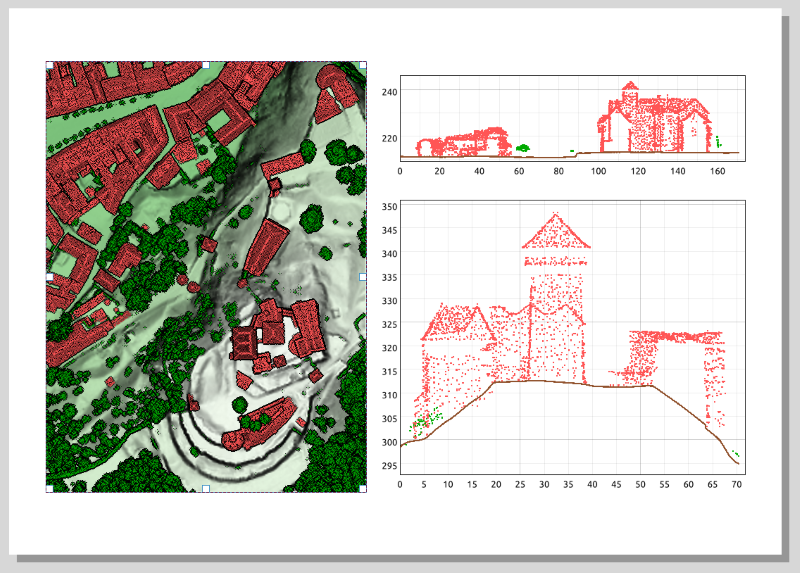

14:20 Revue de presse du 9 juin 2023

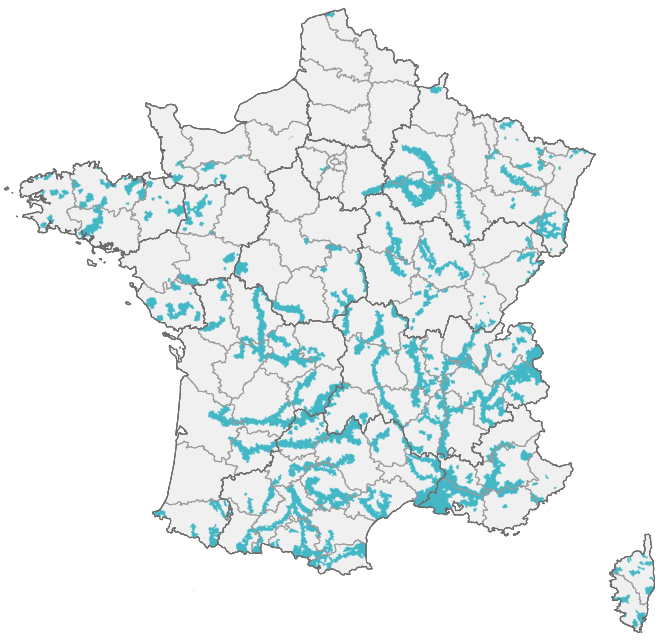

sur Geotribu Revue de presse de la géomatique : SotM FR 2023, LiDAR HD, Panoramax, QField, chronotrains et d'autres sujets encore.

Revue de presse de la géomatique : SotM FR 2023, LiDAR HD, Panoramax, QField, chronotrains et d'autres sujets encore. -

14:20

14:20 Revue de presse du 9 juin 2023

sur Geotribu Revue de presse de la géomatique : SotM FR 2023, LiDAR HD, Panoramax, QField, chronotrains et d'autres sujets encore.

Revue de presse de la géomatique : SotM FR 2023, LiDAR HD, Panoramax, QField, chronotrains et d'autres sujets encore.

-

9:09

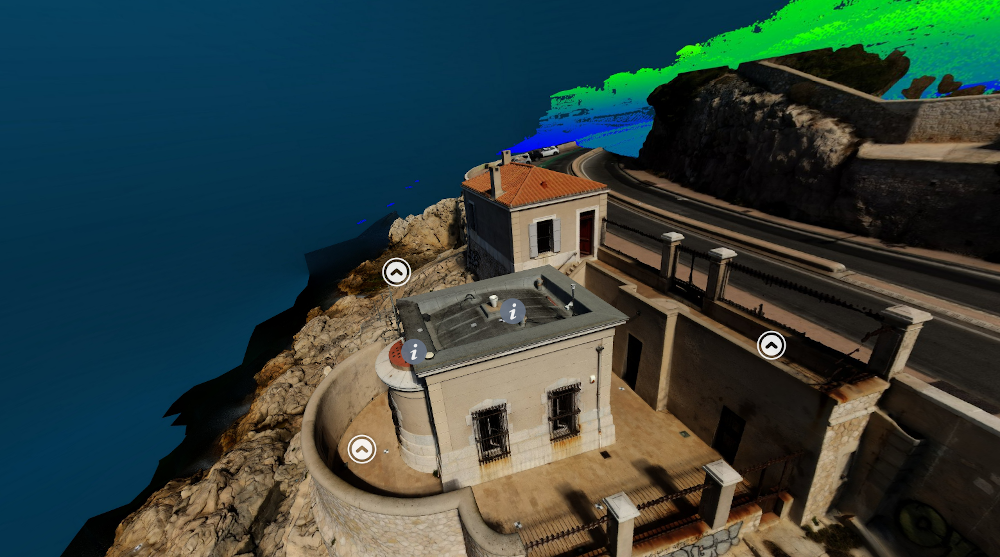

9:09 Le jumeau numérique : l’avenir de la géomatique ?

sur Veille cartographieCet article Le jumeau numérique : l’avenir de la géomatique ? est apparu en premier sur Veille cartographique 2.0.

Qu’est-ce qu’un jumeau numérique ? Le jumeau numérique est un concept relativement nouveau, mais qui a déjà révolutionné de nombreux domaines industriels, notamment la géomatique. Un jumeau numérique est une réplique virtuelle d’un objet ou d’un processus réel, qui peut être utilisé pour simuler, surveiller et optimiser son fonctionnement. Le jumeau numérique peut être utilisé pour […]

Cet article Le jumeau numérique : l’avenir de la géomatique ? est apparu en premier sur Veille cartographique 2.0.

-

5:21

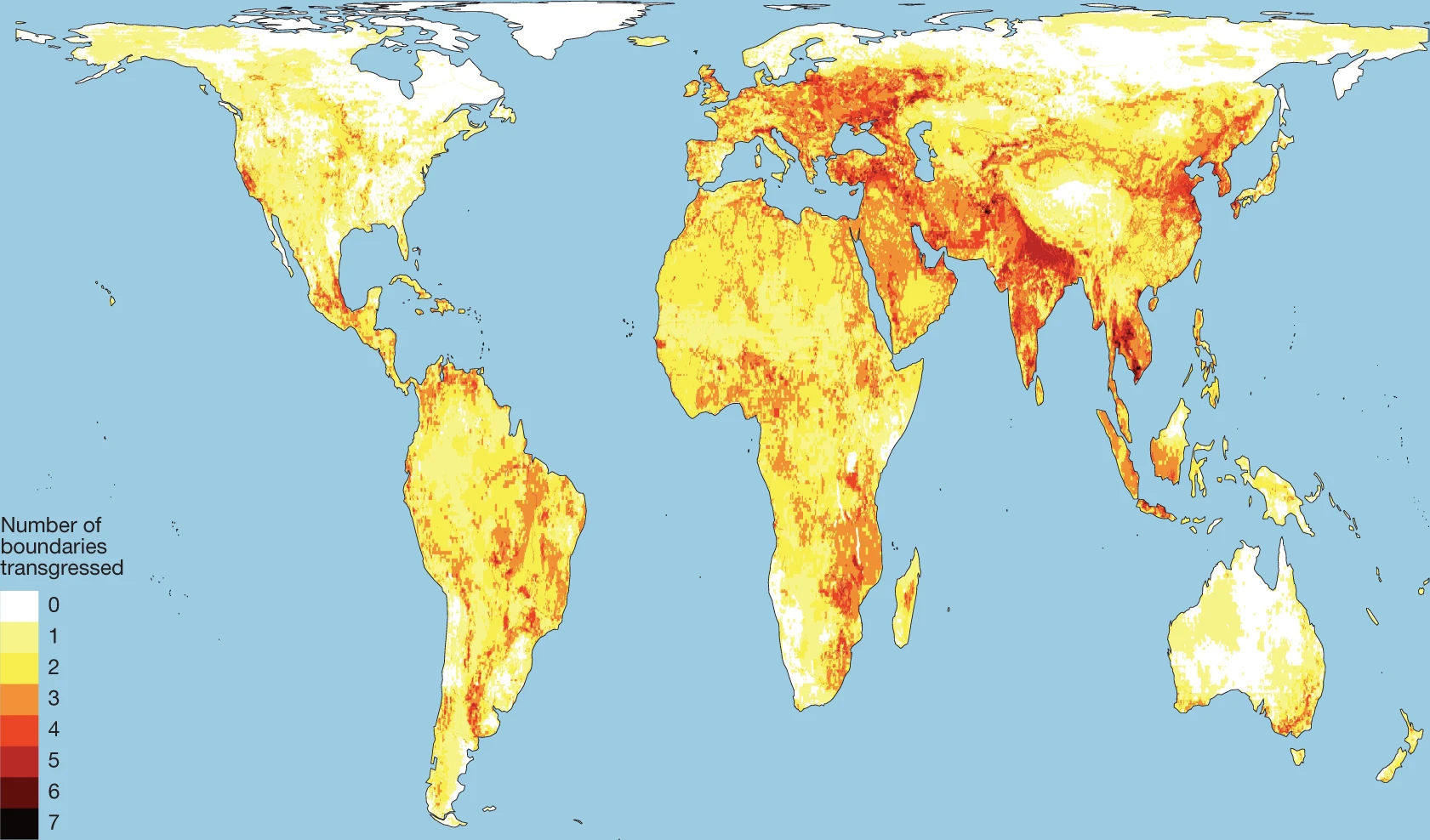

5:21 Limites planétaires. Des chercheurs expliquent dans Nature pourquoi la Terre menace de devenir inhabitable

sur Cartographies numériques

Accès à l'article scientifique

« Plus de 40 experts alertent, dans la revue Nature, sur le franchissement de 7 des 8 lignes rouges planétaires. Ces seuils fatidiques concernent principalement le climat, la biodiversité, l’eau douce, ainsi que les cycles de l’azote et du phosphore. Cette publication s’inscrit dans la longue lignée d’articles scientifiques dédiés aux « limites planétaires ». Théorisée en 2009, la notion englobe neuf paramètres écologiques indispensables à l’équilibre du « système Terre » et, par extension, se rapporte aux seuils limites de perturbation que ces derniers peuvent endurer sans mettre en danger, de manière irréversible, les fondamentaux naturels de la planète » (source : « Des chercheurs expliquent dans Nature pourquoi la Terre menace de devenir inhabitable », Libération).

Rockström, J., Gupta, J., Qin, D. et al. (2023). Safe and just Earth system boundaries. Nature [https:]] . Article publié sous licence Creative Commons Attribution 4.0 International.

Lieux où les « limites planétaires » (ESB) ont déjà été dépassées (source : Rockström & al., 2023) Résumé

Résumé

La stabilité et la résilience du système Terre et le bien-être humain sont inséparablement liés, mais leurs interdépendances sont généralement peu reconnues ; ils sont par conséquent souvent traités indépendamment. Nous utilisons ici la modélisation et l'évaluation de la littérature pour quantifier, à l'échelle globale et sous-globale, les limites sûres et justes du système Terre (Earth System Boundaries) concernant le climat, la biosphère, les cycles de l'eau et des nutriments ainsi que les aérosols. Nous proposons des limites planétaires pour maintenir la résilience et la stabilité du système terrestre (ESB sûres) et minimiser l'exposition à des dommages importants pour les humains du fait des changements du système terrestre (une condition nécessaire, mais non suffisante pour la justice). Nos résultats montrent que ce sont les considérations de justice plus que les considérations de sécurité qui contraignent les ESB intégrés pour le climat et la charge d'aérosols atmosphériques. Sept des huit limites planétaires quantifiées à l'échelle mondiale et au moins deux ESB sûres et justes à l'échelle régionale sont déjà dépassées sur plus de la moitié de la superficie terrestre mondiale. Nous proposons que notre évaluation fournisse une base quantitative pour la sauvegarde des biens communs mondiaux, pour tous aujourd'hui et à l'avenir.

Visualisations concentriques (a) et parallèles (b) des « limites planétaires » ou ESB (crédit : Rockström & al., 2023)

Disponibilité du code et des données

Le codes et les données utilisés pour produire les couches d'information et les figures sont disponibles dans l'article. Les chercheurs se sont appuyés sur plusieurs ensembles de données déjà publiés dans Nature, en ce qui concerne notamment les limites pour le climat, les limites pour l'azote (voir les fichiers modèles), le phosphore (voir les ventilations des scénarios), et un résumé des indicateurs de durabilité agricole, les excédents actuels pour l'azote (voir le référentiel) avec la limite critique de surplus d'azote soustraite, et la concentration sous-globale estimée de phosphate dans le ruissellement sur la base de sa charge estimée dans l'eau douce et des données locales de ruissellement.

L'intégrité fonctionnelle actuelle est calculée à partir de la carte d'occupation du sol WorldCover à résolution de 10 mètres de l'Agence spatiale européenne. La limite de sécurité et l'état actuel des eaux souterraines sont dérivés de l'expérience Gravity Recovery And Climate Experiment et du Global Land Data Assimilation System.

Pour compléter

La 6e limite planétaire est franchie : le cycle de l’eau douce (Bon pote)

Lien ajouté le 30 août 2023

Belle data visualisation interactive et en 3D du Berliner MorgenPost sur les lieux qui risquent de devenir inhabitables d'ici 2100 en raison de la crise climatique. Approche par risques.

— Sylvain Genevois (@mirbole01) April 13, 2022

Climate crisis : Mapping where the earth will become uninhabitable. [https:]] pic.twitter.com/cRH0YqnLlhArticles connexes

Comment le changement climatique a déjà commencé à affecter certaines régions du monde

Atlas de l'Anthropocène : un ensemble de données sur la crise écologique de notre temps

Les territoires de l'anthropocène (cartes thématiques proposées par le CGET)Feral Atlas, une exploration de l’Anthropocène perçu à travers la féralisation

Le calcul de l'IDH prend désormais en compte le calcul des pressions exercées sur la planète (IDHP)

Paul Crutzen et la cartographie de l'Anthropocène

Données SIG sur les écorégions terrestres

Cartes et données sur la disparition des oiseaux en Europe

Eduquer à la biodiversité. Quelles sont les données... et les représentations ?

Une carte de l'INPN pour analyser et discuter la répartition de la biodiversité en France

Utiliser les données de l'UN Biodiversity Lab sur la biodiversité et le développement durable

-

16:28

16:28 L'histoire par les cartes : Biélorussie, histoire d'une nation (BnF-Gallica)

sur Cartographies numériques

La BnF propose des rendez-vous réguliers qui interrogent les notions d’État et de démocratie sur tous les continents, en présence de spécialistes et d’acteurs de la politique. La séance du 12 juin 2023 consacrée à la Biélorussie questionne en particulier les enjeux et les conséquences de la guerre en Ukraine pour ce pays.

Carte de la République démocratique Blanche-Ruthénienne, 1919 (source : Gallica)

La couverture médiatique de la situation politique en Biélorussie est relativement faible alors qu’une vague de répression féroce s’abat sur les oppositions, sur la société civile mais aussi sur l’ensemble de la population à la suite du mouvement de contestation sans précédent de 2020 contre la réélection frauduleuse d’Alexandre Loukachenko pour un sixième mandat. Plus de 1 500 prisonniers politiques sont aujourd’hui détenus en Biélorussie dans des conditions particulièrement inhumaines parmi lesquels Ales Bialiatski, fondateur de l’ONG Viasna de défense des droits humains et co-lauréat du prix Nobel de la paix en 2022.

Depuis le 24 février 2022, la Russie utilise la Biélorussie comme base arrière dans son agression contre l’Ukraine. La Biélorussie représente donc un enjeu important de cette guerre. Le régime d’Alexandre Loukachenko, qui s’efforçait de préserver son pouvoir et son indépendance vis-à-vis du Kremlin, soutient désormais l’agression russe contre l’Ukraine. Le 25 mars 2023, Vladimir Poutine a même annoncé avoir conclu un accord avec Alexandre Loukachenko pour le déploiement d’armes nucléaires tactiques russes sur le territoire biélorusse.

Quel est l’impact de la nouvelle situation géopolitique sur le régime politique biélorusse et sur son positionnement régional ? Comment évolue la situation intérieure en Biélorussie ? Comment l’opposition biélorusse se structure-t-elle en exil ? Enfin, quelles pourraient être les perspectives d’intégration de la Biélorussie dans un nouvel ordre européen, dans le cas d’une résolution de la guerre de la Russie contre l’Ukraine ?

Table ronde organisée par la BnF et le ministère de l’Europe et des Affaires étrangères, en français et en anglais avec traduction simultanée en français.

Avec Ryhor Astapenia, chercheur et directeur de l’initiative sur le Bélarus à Chatham House, Tatsiana Khomich, représentante du Conseil de coordination des prisonniers politiques biélorusses, et Tatyana Shukan, docteure en science politique et membre du projet de recherche BIELEXIL – Les exilés bélarusses en Europe centrale et orientale. La table ronde est animée par Faustine Vincent, journaliste au service international du Monde chargée de l’espace post-soviétique.

A cette occasion, le site Gallica consacre un dossier thématique à la « Biélorussie, histoire d'une nation », qui retrace la genèse de ce pays à partir de cartes historiques. Pour comprendre la concurrence des mémoires du passé biélorusse, il convient de revenir sur l’histoire politique de ce pays d’Europe de l’Est, bordé par la Russie au nord-est et à l’est, la Lettonie au nord, la Lituanie au nord-ouest, la Pologne à l’ouest et l'Ukraine au sud. Ayant fait office de confins pendant des siècles, son territoire a été un espace de contact entre les peuples slaves occidentaux et orientaux, entre le monde catholique et le monde orthodoxe, longtemps disputé entre Varsovie et Moscou. Indépendante depuis 1991 seulement, la Biélorussie a été successivement intégrée à la Rus’ de Kiev (Xème-XIIème siècle), au Grand-Duché de Lituanie (1236-1795), à l’Union des Deux-Nations (ou République de Pologne-Lituanie) (1569-1795), à l’empire russe (1795-1917), et enfin à l’Union des républiques socialistes soviétiques (URSS) au sein de laquelle elle a été l’une des républiques soviétiques (1922-1991).

Sources

Article consacré à la Biélorussie sur Wikipédia.

Goujon, Alexandra, Nationalisme et identité en Biélorussie, in Dov Lynch (ed.), Changing Belarus, Chaillot Paper, n° 85, November 2005, pp. 13-24.

Articles connexes

La carte, objet éminemment politique : la guerre en Ukraine

La carte, objet éminemment politique. L'annexion de quatre territoires de l'Ukraine par la Russie

La carte, objet éminemment politique. La vision réciproque de la Russie et de l'Europe à travers la guerre en Ukraine

La carte, objet éminemment politique : l'adhésion de la Finlande à l'OTAN

Ukraine-Russie. Retour sur un an de guerre en cartes et en analyses (février 2022 - février 2023)

Cartographier les dommages subis par les populations civiles en Ukraine (Bellingcat)

Comment cartographier la guerre à distance ?

La cartographie russe et soviétique d'hier à aujourd'hui

-

10:40

10:40 L’analyse géo spatiale pour la gestion des réseaux de distribution d’énergie électrique

sur Veille cartographieCet article L’analyse géo spatiale pour la gestion des réseaux de distribution d’énergie électrique est apparu en premier sur Veille cartographique 2.0.

L’analyse géospatiale est devenue un outil inestimable pour la gestion efficace des réseaux de distribution d’énergie électrique. En combinant les technologies de l’information géographique (SIG) avec les données sur les réseaux électriques, cette approche permet aux gestionnaires de prendre des décisions éclairées basées sur la localisation, la topologie et les conditions environnementales. L’un des principaux […]

Cet article L’analyse géo spatiale pour la gestion des réseaux de distribution d’énergie électrique est apparu en premier sur Veille cartographique 2.0.

-

7:00

7:00 L’implant cérébral Géonumérique obligatoire en 2054 [SF]

sur GeomatickVous êtes en 2054 et l’implant cérébral géonumérique devient obligatoire dès la naissance. La technologie 13G ne permet plus seulement d’améliorer les interconnexions entre les machines. Mais elle garantit également les transferts de signaux électromagnétiques dans le cerveau humain. Grâce aux implants bioniques cérébraux, le système de pensée automatique déclenche… Continuer à lire →

L’article L’implant cérébral Géonumérique obligatoire en 2054 [SF] est apparu en premier sur GEOMATICK.

-

14:20

14:20 Revue de presse du 26 mai 2023

sur Geotribu En cette période quasi estivale, nous vous proposons une série de news rafraîchissantes pour supporter la transition !

En cette période quasi estivale, nous vous proposons une série de news rafraîchissantes pour supporter la transition ! -

10:20

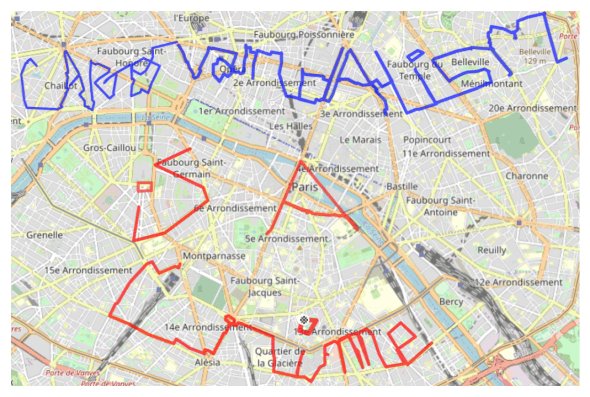

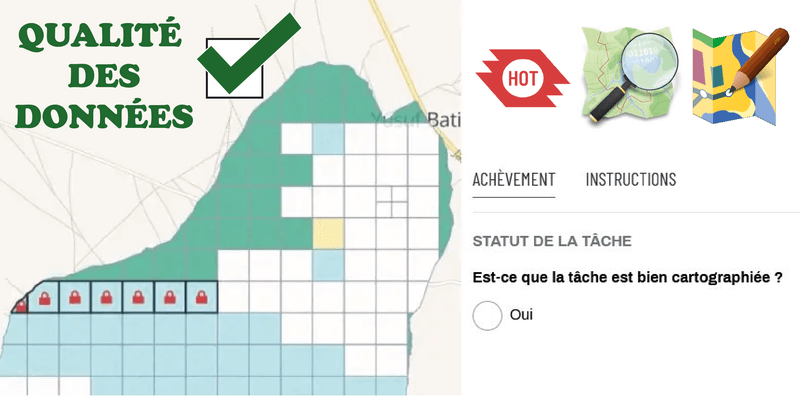

10:20 Carto-vandalisme dans OpenStreetMap : mythe ou réalité ?

sur Geotribu Détection du vandalisme cartographique dans OSM grâce à de l'apprentissage automatique

Détection du vandalisme cartographique dans OSM grâce à de l'apprentissage automatique -

14:20

14:20 Revue de presse du 12 mai 2023

sur Geotribu La GeoRDP n'a pas été remarketée, elle s'appuie toujours sur vos contributions et son prix n'a pas changé;)

La GeoRDP n'a pas été remarketée, elle s'appuie toujours sur vos contributions et son prix n'a pas changé;)

-

19:20

19:20 Dancing statistics

sur Carnet (neo)cartographiqueAvertissement.

Ce billet ne traite pas de cartographie, mais de statistiques et de (choré)graphie.

Il n’en demeure pas moins intéressant, je vous l’assure !Alors imagines, tu aimes bien la cartographie et la chorégraphie, plus généralement la représentation graphique de données … les statistiques. Et puis un jour, frais et pluvieux, en procrastinant sur le site de la jolie revue Images des maths, tu tombes sur un court billet d’Avner Bah-Hen (professeur de Statistiques), intitulé Statistiques et danse pour l’enseignement (voir) et donc qui parle de ça :

Dancing Statistics c’est le nom d’un projet de courts métrages de la British Psychological Society pour aider le public non matheux de formation à comprendre les statistiques. Le projet porté par Lucy Irving de Middlesex University & Andy Fields de l’University of Sussex vise à présenter des concepts et notions de statistique sous une forme moderne et dansée (danse moderne, of course).

Pour cela ils mobilisent une population d’individus, à savoir une petite troupe où les individus sont des danseurs et danseuses contemporain.e.s, positionnés comme suit au départ d’un sujet.

La chorégraphie à laquelle ils et elles prennent part est visualisée en vue de dessus et logiquement accompagnée de musique. Elle se déploie sur une scène qui, parce qu’elle est munie d’axes et de positions tracés au sol facilite, d’une part, le repérage rapide de leurs positions relatives les unes par rapport aux autres, fussent-ils et elles en mouvement ; elle permet d’autre part aux spectatrices de visualiser les éléments clés de concepts et notions usuel.le.s des statistiques ainsi dansés.

Jugez-en par vous même ci-dessous en regardant cette première danse présentant la distribution de fréquence.

D’autres vidéos sont également disponibles :

Échantillonnage et erreur standard

Géographe et cartographe, Chargée de recherches à l'IFSTTAR et membre-associée de l'UMR 8504 Géographie-Cités.

-

10:20

10:20 Geotribu déménage

sur Geotribu Après 3 ans sur un sous-domaine, le site va revenir sur son domaine principal. Attachez vos ceintures de favoris !

Après 3 ans sur un sous-domaine, le site va revenir sur son domaine principal. Attachez vos ceintures de favoris !

-

11:21

11:21 Appel à communications : “Art(s) et Cartographie(s)”, date-butoir : 31 mai 2023

sur Cartes et figures du monde

La Commission Histoire du Comité Français de Cartographie organise le 25 novembre 2023 à l’Institut national d’histoire de l’art à Paris une Journée d’études intitulée « Art(s) et cartographie(s) ».

Par-delà les études classiques sur la place spécifique de la cartographie dans l’histoire des savoirs scientifiques, et les analyses répétées sur les engagements de la cartographie (et des cartographes) dans diverses opérations politiques, il est nécessaire d’envisager les relations de la cartographie avec les arts et les artistes ainsi que ses formes d’implication dans les cultures visuelles des sociétés modernes et contemporaines. Les recherches sur ce sujet sont déjà nombreuses, et fructueuses, et ont permis d’établir de façon décisive les multiples niveaux et formes d’interaction entre les mondes de la cartographie et les mondes de l’art.

Cette Journée d’études souhaiterait être l’occasion de rassembler et de confronter quelques-unes des pistes principales de la recherche actuelle et, en ce sens, elle accueillera des propositions dans plusieurs directions :

1/ Les artistes et la cartographie

Les artistes, depuis longtemps, ont mobilisé la cartographie dans leurs œuvres et ont eux-mêmes dessiné des cartes. Des peintres furent impliqués à la Renaissance dans la réalisation des cartes à grande échelle ; les « pourtraiteurs » au service des corps de ville ont pleinement participé au renouvellement de la cartographie urbaine et de la chorographie à l’époque moderne ; les ingénieurs des Ponts et Chaussées au XVIIIe siècle étaient formés à la cartographie comme au dessin de paysages. Aujourd’hui, de nombreux artistes font de la cartographie un domaine d’investigation privilégié. Ils et elles conçoivent des cartes, ou bien utilisent des cartes déjà faites, les transforment, les assemblent, ou les insèrent dans leurs œuvres. La cartographie est un champ d’actions artistiques très variées et, parfois même, une forme de l’art. On aimerait, au cours de cette Journée d’études, réunir des contributions qui viendraient à la fois illustrer et interroger cette longue fréquentation des artistes et de la cartographie. Les propositions peuvent aborder les périodes les plus anciennes comme les contemporaines.

2/ La cartographie et les métiers d’art

De façon plus spécifique, on aimerait aussi interroger les circulations professionnelles, les transferts et transmissions de pratiques, entre art et cartographie, là encore sur un temps long. Quels sont les métiers d’art impliqués dans les opérations de fabrication des cartes ? Comment, par exemple, s’articulent en termes de pratiques et d’identités professionnelles, les intentions scientifiques, informationnelles, et les motivations décoratives, ornementales, ou symboliques ? Ou bien, autre exemple, peut-on dégager la présence de « styles » ou d’« écoles » dans l’écriture des cartes ? Ou encore, peut-on repérer les trajectoires par lesquelles les cartes sont introduites, reproduites et mobilisées dans les entreprises de divertissement et plus généralement dans les cultures visuelles de leur époque ?

3/ Cartographie, collections, et marché de l’art

Les cartes sont des objets, parfois luxueux, souvent conservés et exhibés (ou au contraire dissimulés) comme des pièces précieuses. Et, à cet égard, elles sont recherchées par des spécialistes, des amateurs, des collectionneurs fortunés, mais aussi des institutions publiques de conservation et de documentation. Autrement dit les cartes, au-delà de leur dimension cognitive, ont d’autres valeurs, tout à la fois affectives, symboliques, patrimoniales, et marchandes, et à ce titre leur circulation dans le public dépend aussi des possibilités et des contraintes du marché. Cette Journée réunira des contributions qui voudront mener l’interrogation dans cette direction : la carte comme objet de collection, comme objet convoité, exhibé pour le prestige ou dissimulé à des fins de capitalisation. Elle aimerait mettre en lumière le rôle décisif des collectionneurs, curateurs, ou autres animateurs du marché, dans la circulation des objets cartographiques et, au-delà, des contenus de connaissance que ces objets véhiculent.

Modalités pratiques

Les propositions de communication (environ 1500 signes), accompagnées d’une courte bio-bibliographie, sont à envoyer à l’adresse suivante : catherine.hofmann@bnf.fr

avant le 30 avril 2023.

Le comité de sélection se réunira en mai et communiquera les résultats de l’appel à communication courant juin. Les communications retenues auront vocation à être publiées dans un numéro de la revue du Comité français de cartographie, Cartes & Géomatique, au courant de l’année 2024.

Bibliographie indicative

Ouvrages

Baynton-Williams Ashley, The curious map book. Chicago, The University of Chicago Press, 2015, 240 p.

Besse Jean-Marc et Tiberghien Gilles A. (ed.), Opérations cartographiques, Arles : Actes Sud ; [Versailles] : ENSP, 2017, 1 vol. (345 p.)

Béziat Julien, La carte à l’oeuvre : cartographie, imaginaire, création, Pessac : Presses universitaires de Bordeaux : Centre de recherche CLARE-ARTES, 2014, Collection ARTES, 1 vol. (162 p.)

Buci-Glucksmann Christine, L’oeil cartographique de l’art, Paris : Galilée, 1996, 1 vol. (177 p.)

Cartwright William, Gartner Georg, Lehn Antje (ed.), Cartography and art, New-York : Springer, 2009, collection : Lectures Notes in Geoinformation and Cartography, 1 vol. (391 p.)

Casey Edward S., Earth-mapping : artists reshaping landscape, Minneapolis : University of Minnesota Press, 2005, 1 vol. (242 p.)

Castro Terasa, La Pensée cartographique des images. Cinéma et culture visuelle, Lyon, Aléas, 2011.

Cosgrove Denis, Apollo’s eye : a cartographic genealogy of the earth in the western imagination. Baltimore ; London : Johns Hopkins university press, 2001, 1 vol. (331 p.)

Dorrian Mark and Pousin Frédéric (ed.), Seeing from above : the aerial view in visual culture. London : I.B. Tauris, 2013, 1 vol. (312 p.)

Dryansky Larisa, Cartophotographies : de l’art conceptuel au land art, [Paris] : CTHS : INHA, Institut national d’histoire de l’art, 2017, 1 vol. (335 p.)

Ferdinand Simon, Mapping beyond measure : art, cartography, and the space of global modernity, Lincoln : University of Nebraska Press, 2019, 1 vol. (298 p.)

Field Kenneth, Cartography : a compendium of design thinking for mapmakers, Redlands, California : Esri Press, 2018, 1 vol. (549 p.)

Harley John B. and Woodward David; Monmonier Mark; Edney Matthew H. and Pedley Mary Sponberg (ed.), The history of cartography, Chicago ; London : The University of Chicago press, 1987-, vol. 1- 4, 6. [Volumes 1, 2, 3 et 6 accessibles en ligne sur le site de l’éditeur : https://press.uchicago.edu/books/HOC/index.html]

Harmon Katharine, You are here : personal geographies and other maps of the imagination. New York : Princeton architectural press, 2004, 1 vol. (191 p.)

Hofmann Catherine (ed.), Tesson Sylvain (préf.), Artistes de la carte : de la Renaissance au XXIe siècle : l’explorateur, le stratège, le géographe, Paris : Autrement, 2012, 1 vol. (223 p.)

Landsman Rozemarijn, Vermeer’s maps, New York, The Frick Collection, DelMonico Books, 2022, 128 p.

Lewis-Jones Huw, The Writer’s map : an atlas of imaginary lands, Chicago : The University of Chicago Press, 2018, 1 vol. (256 p.)

Paez Roger, Operative mapping : maps as design tools. New York : Actar Publishers ; [Barcelona] : ELISAVA, 2019, 1 vol. (327 p.)

Rodney Shirley, Courtiers and cannibals, angels and amazons: the art of the decorative cartographic titlepage, GH Houten : HES & DE GRAAF, 2008, 1 vol. (272 p.)

Schulz Juergen, La cartografia tra scienza e arte : carte e cartografi nel Rinascimento italiano, Modena : F. C. Panini, 2006, 1 vol. (202 p.)

Woodward David (ed.), Art and cartography: six historical essays, Chicago ; London, University of Chicago press, 1987, collection : The Kenneth Nebenzahl Jr. lectures in the history of cartography, 1 vol. (249 p.)

Catalogues d’expositions (par ordre chronologique)

Cartes et figures de la terre [Exposition, Centre Georges Pompidou, Paris, 24 mai-17 novembre 1980]. Paris : Centre Georges Pompidou, Centre de création industrielle, 1980, 1 vol. (479 p.)

Monique Pelletier (ed.), Couleurs de la Terre : des mappemondes médiévales aux images satellitales. [Exposition. Paris, BnF, « Figures du ciel et Couleurs de la Terre », 8 octobre 1998-10 janvier 1999]. Paris : Seuil : BnF, 1998, 1 vol. (175 p.)