Planet GeoRezo

Agrégateur de flux RSS - Actualités et contenus géomatiques

La carte dite de « Christophe Colomb » (1491) réexaminée à l'aide de l'imagerie multispectrale

GeoSolutions: GeoServer 3 Release date announced

You must be logged into the site to view this content.

Everything, Everywhere, All at Once

Mapping the World’s Largest Human Migration

From Bargain to Bank-Breaking: The NYC Rent Heat Map

[FR]Explorer les ENC avant import : le catalogue NOAA au service de S57Manager

Travailler avec des données ENC (S-57) pose un défi bien particulier : leur richesse et leur complexité rendent toute approche « à l’aveugle » inefficace.Avant même de parler d’import ou de structuration dans QGIS, une question…

The post [FR]Explorer les ENC avant import : le catalogue NOAA au service de S57Manager first appeared on Blog SIG & Territoires.

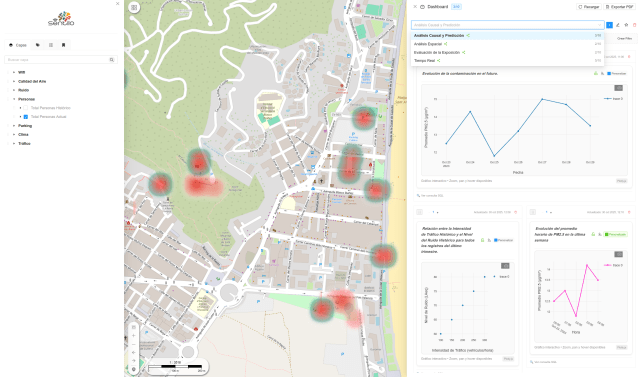

gvSIG Team: gvSIG as European Digital Infrastructure

What does it mean to speak about European digital infrastructure? It means:

- Use of open standards (such as those promoted by the Open Geospatial Consortium).

- Compliance with regulatory frameworks such as INSPIRE.

- A real possibility of self-hosting.

- Independence from unilateral changes in licenses or terms of use.

- The ability to audit, evolve, and adapt the system over the long term.

Europe has clearly defined its commitment to the digital commons and technological sovereignty.

But that strategy is not materialized through declarations. It is materialized through real infrastructures.

gvSIG Team: gvSIG como infraestructura digital europea

¿Qué significa hablar de infraestructura digital europea? Significa:

- Uso de estándares abiertos (como los promovidos por el Open Geospatial Consortium).

- Cumplimiento de marcos normativos como la directiva INSPIRE.

- Posibilidad real de autohospedaje.

- Independencia frente a cambios unilaterales de licencias o condiciones de uso.

- Capacidad de auditar, evolucionar y adaptar el sistema a largo plazo.

Europa ha definido claramente su apuesta por el bien común digital y la soberanía tecnológica. Pero esa estrategia no se concreta en declaraciones. Se concreta en infraestructuras reales.

...Toulouse: Rencontre OpenStreetMap, Le samedi 21 février 2026 de 14h00 à 18h00.

Connaissez-vous OpenStreetMap, une carte créée de manière collaborative, à l'instar de Wikipédia ? Savez-vous que vous pouvez :

...

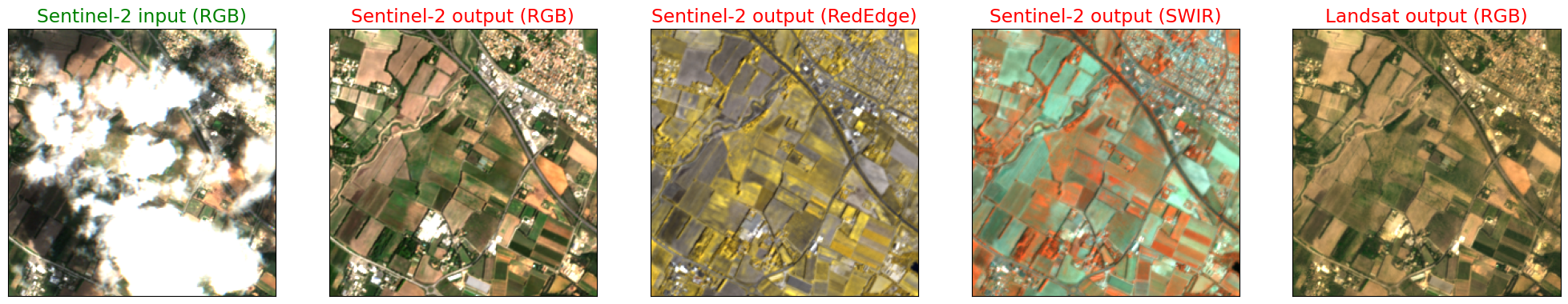

Terres cultivées et évaluation mondiale des émissions de gaz à effet de serre

Source : Pei Yu Cao, Franco Bilotto, Carlos Gonzalez Fischer et al (2026). « Spatially explicit global assessment of cropland greenhouse gas emissions circa 2020 » [Évaluation mondiale spatialement explicite des émissions de gaz à effet de serre des terres cultivées vers 2020]. Nature Climate Change, https://www.nature.com/articles/s41558-026-02558-4 (article en open access).

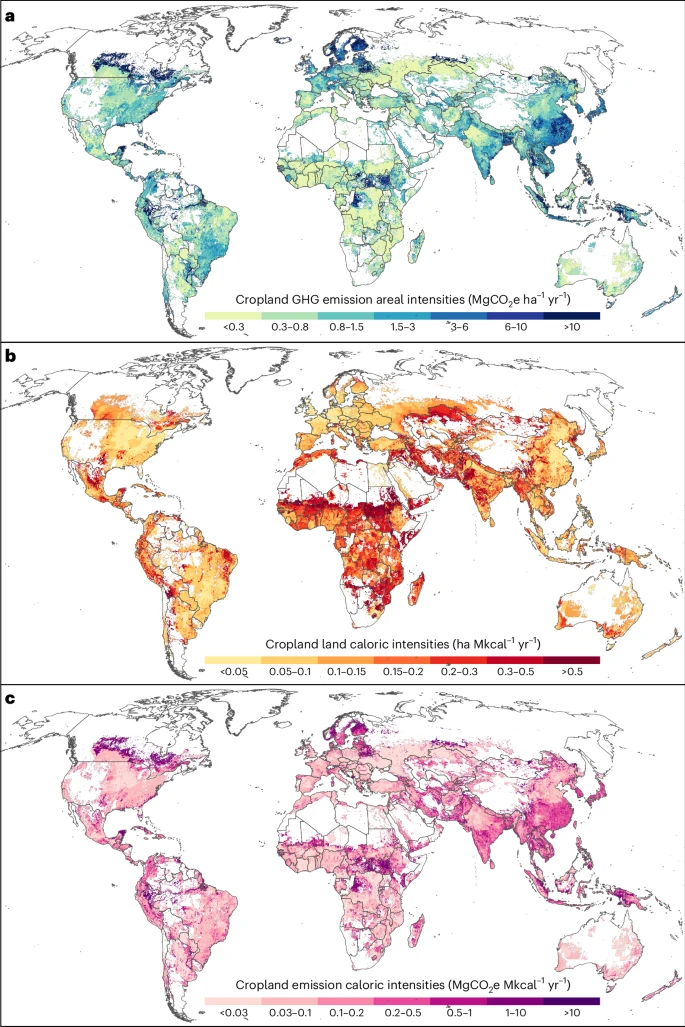

GeoServer Team: GeoServer 3 First public release date

We are happy to announce that GeoServer 3 is approaching general availability with a target release date of 15th of April 2026.

This major upgrade modernises the platform’s foundation with the migration to Spring 7 and JDK 17, brings a refreshed user experience and replaces legacy image-processing components with ImageN to deliver significantly improved raster performance and maintainability. The release aligns GeoServer with current Java ecosystems, strengthens security and vulnerability management, and simplifies cloud-native deployments. You can read more about the GeoServer 3 initiative on this page.

...

GIScussions: Does vibe coding democratise software tools?

No maps in this post!

I mentor a couple of people and I was about to start a new project this week. I was going to knock up a Google Sheet or Doc to track goals, talks and meetings and share with the mentee and my co-mentor. It occurred to me that I could vibe code an app to track the mentee’s progress and to provide structure to our regular meetings.

With a lot of help from Claude I’ve got something running that does that for a few mentors and mentees, it runs on desktop and mobile and quite a lot of the input is voice to text which is particularly useful in mobile. It took about 3 hours, to build test and deploy.

I am sure that I’ll find some problems or feature gaps in the future but that doesn’t matter in my use case. I don’t plan to build this into a business or to scale it up to thousands of users it’s just a tool that makes record keeping for me and my mentees easier.

...

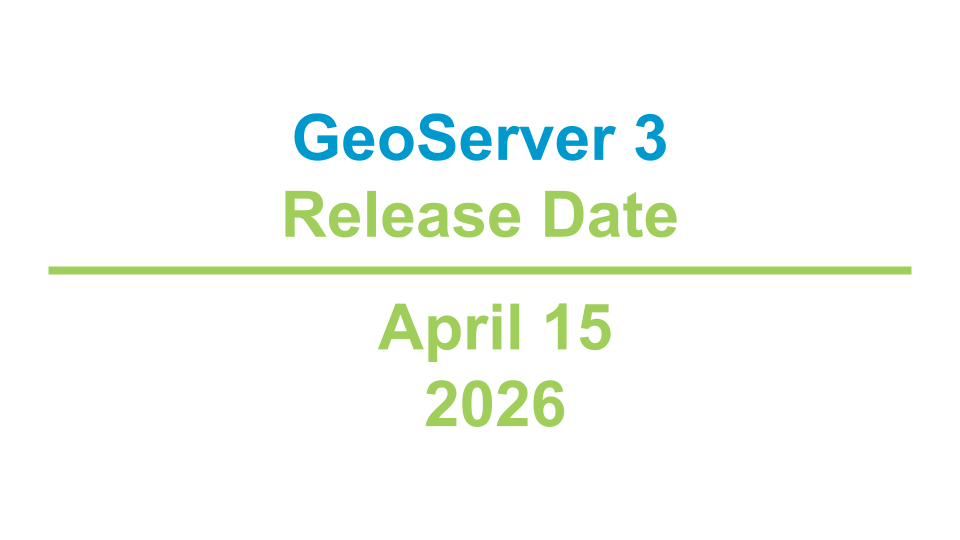

Stefano Costa: IOSACal 0.7

IOSACal 0.7 was released yesterday. Here is a quick summary of what’s new.

One of the standard plots rendered in the latest IOSACal version. It looks exactly as before.This long cycle was mostly about documentation improvements and some maintenance tasks, the boring but essential work that keeps the project going.

Version 0.7 is already available in PyPI and conda-forge. There is an updated version record at Zenodo.

All changes were contributed by Stefano Costa.

...

Retrait d'ArcGIS Web AppBuilder dans ArcGIS Online

La plupart des fonctionnalités de parité prévues dans ArcGIS Experience Builder sont déjà disponibles, et Esri continue finaliser les restantes pour vous offrir ainsi les outils dont vous avez besoin pour conserver vos workflows actuels. Dans cet article, nous allons rev...

Cartographie et racisme environnemental. L'exemple de « Cancer Alley » en Louisiane

L'allée du cancer (« Cancer Alley ») est le surnom donné à un corridor de 135 km le long du fleuve Mississippi, entre Bâton-Rouge et La Nouvelle-Orléans en Louisiane. Ce couloir industriel abrite plus de 200 raffineries et usines pétrochimiques. En 2012, cette zone représentait 25 % de la production pétrochimique des États-Unis. Dès les années 1970, l’Agence de protection de l’environnement (EPA) a documenté une grave pollution de l’eau et de l’air. Les écologistes considèrent cette région comme une zone sacrifiée où les taux de cancer dus à la pollution atmosphérique dépassent les seuils de risque acceptables fixés par le gouvernement fédéral. L' « allée du cancer », au sens large, s'étend plus à l'ouest le long de la côte du Golfe du Mexique, dans la région de Freeport, au Texas.

...The Rename the World Map

Camptocamp: Think you know Switzerland, France, and Germany? Prove it with Geo Challenge

FOSSGIS e.V. News: Nur noch wenige Wochen bis zur FOSSGIS 2026 in Göttingen - die Vorfreude steigt

Die FOSSGIS-Konferenz 2026 findet vom 25.-28. März 2026 in Göttingen und Online statt. Es sind nur noch wenige Wochen bis zur Konferenz. Die Vorfreude wächst stetig und die Vorbereitungen laufen auf Hochtouren!

Die Konferenz wird vom gemeinnützigen FOSSGIS e.V, der OpenStreetMap Community in Kooperation mit dem Geographischen Institut der Georg-August-Universität Göttingen organisiert und findet auf dem Campus der Uni Göttingen statt.

Auch in diesem Jahr zeichnet sich ein großes Interesse an der Konferenz ab. Die Anmeldungen steigen von Woche zu Woche. Zum Glück bietet das Zentrale Hörsaalgebäude der Uni Göttingen ausreichend Platz, so dass es die bisher größte FOSSGIS-Konferenz werden könnte.

...

hebdoOSM 812

05/02/2026-11/02/2026

[1] osm-mapper-globe par Martijn van Exel | données cartographiques © Cartographes OpenStreetMap.

...

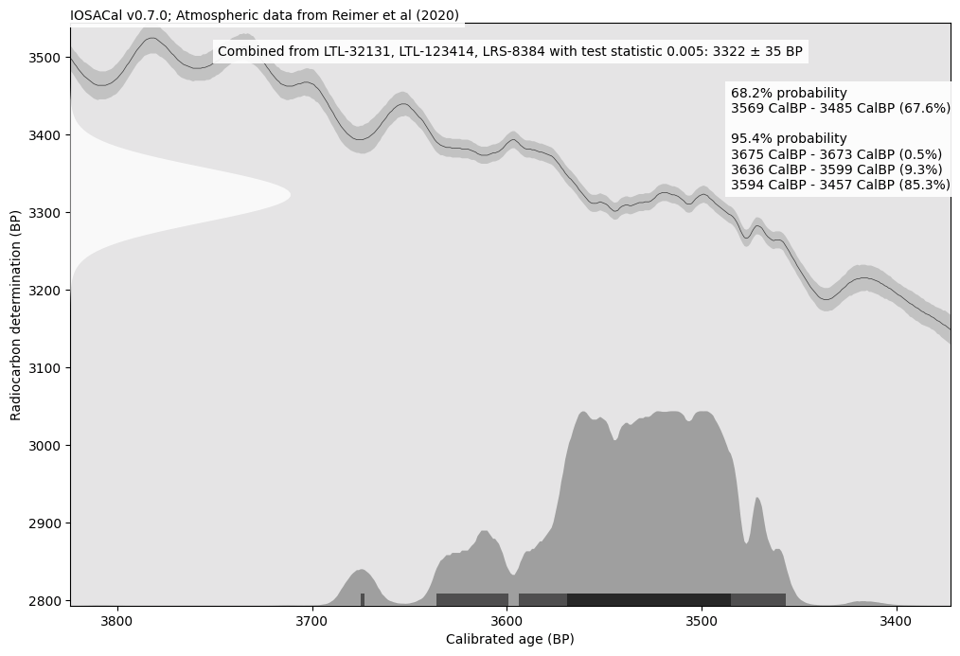

From GIS to Remote Sensing: Remotior Sensus Update: Version 0.6

- Added optional dependency Pandas for performance improvement in tabular data.

- In tool “Band classification” added option for using PyTorch pretrained model. In case a pretrained model is selected, and additional algorithm is selected for classification, using the same parameters of the named algorithm (e.g. random forest); after executing the pretrained model, the additional algorithm is executed on the embeddings for classification. Currently, it works with models pretrained by the Allen Institute for Artificial Intelligence (SatlasPretrain: https://satlas-pretrain.allen.ai) in particular, Sentinel-2 swin-v2-base single-image multispectral and swin-v...

TorchGeo: v0.9.0

TorchGeo 0.9 includes 13 new datasets and a number of improvements required for better time series support, encompassing 3 months of hard work by 15 contributors from around the world. We are now trying to make more frequent releases to get exciting new features out to users as quickly as possible!

Highlights of this release Embeddings datasets ...Comment bien préparer un date avec QGIS et l’analyse spatiale ?

Adding a Dolly Zoom to Your Map

Atlas archéologique de la Grèce

La Grèce antique a laissé de nombreux sites archéologiques. Les trouver impliquait autrefois de consulter des guides touristiques et des sites web souvent disparates ou obsolètes. Cet Atlas archéologique de la Grèce recense tous les sites archéologiques et musées importants : 424 sites avec leurs coordonnées géographiques, leurs descriptions et leurs catégories. Que vous planifiez un voyage en Crète, fassiez des recherches sur les forteresses mycéniennes ou souhaitiez simplement découvrir les environs d’Athènes, vous trouverez toutes les informations nécessaires.

Atlas archéologique de la Grèce (source : archaeological-greece.vercel.app)

...The Most Googled Bird in America is ...

Journées d’études Géovisualisation des migrations : du tableau à la carte, 31 mars – 1er avril 2026

Deux journées d’étude sur la géovisualisation des migrations sont organisées par l’UMR 7301 Migrations internationales, espaces et sociétés (MIGRINTER) et l’UMR 5194 Laboratoire de science sociale (PACTE), avec le concours de l’Action de recherche (Carto)graphies et (Géo)visualisation de données (AR9) du GdR CNRS MAGIS.

Crédit données : The story behind a line.

...Mapping Every Ancient Site in Greece

OPENGIS.ch: QField search and routing plugins updates

Throughout the first month of 2026, our ninjas added a nifty set of improvements to three useful plugins that we love: the GeoMapFish Search, OpenStreetMap Nominatim Search, and OSRM Routing plugins. These plugins all provide genuinely useful functionalities as well as being great showcases of how easy it is to integrate QField with online REST endpoints.

All three plugins have been updated to ship with useful endpoint presets out of the box, and users also have the option to configure their own custom endpoints for more flexibility. To configure endpoints, open QField’s settings panel, navigate to the plugin manager, and click the settings button next to the desired plugin.

...

L’Afrique du Sud, plus de trois décennies après l’apartheidAlain Dubresson, Philippe Gervais-Lambony

Professeurs émérites à l’université de Nanterre, Alain Dubresson et Philippe Gervais-Lambony sont les invités de ce Café géographique animé par Denis Wolff pour évoquer l’Afrique du Sud (Café géo de Paris au Flore, mardi 27 janvier 2026).

Alain Dubresson rappelle que c’est en 1991 que l’arsenal juridique de l’apartheid a été démantelé et aboli, c’est-à-dire un an après la libération de Nelson Mandela (11 février 1990) qui devient président le 10 mai 1994. Quelles sont les idées dominantes, les expressions qui caractérisent l’Afrique du Sud ?

De gauche à droite : Alain Dubresson, Denis Wolff, Philippe Gervais-Lambony au Flore. Photo de Micheline Huvet-Martinet

...

Fernando Quadro: Curso de Python com GIS do Zero

Se você trabalha com GIS/QGIS e ainda depende de cliques, processos manuais e retrabalho, chegou a hora de mudar isso.

Estão abertas as inscrições para o Curso Python com GIS do Zero, uma formação técnica e prática para quem quer sair do modo operacional e começar a programar o geoprocessamento de verdade.

Aqui você aprende Python aplicado ao GIS, não Python genérico.

O que você vai dominar:

Python do zero com foco técnico

Pandas e Geopandas aplicados ao GIS

Processamento de vetores e rasters (GDAL/OGR)

Análises espaciais e estatísticas zonais

SQL Espacial moderno com DuckDB Spatial

Automação de processos no QGIS

Introdução ao desenvolvimento de plugins

Tudo aplicado a problemas reais, como acontece no mercado.

Para quem é este curso?

...

Extraire des modèles 3D de contexte depuis votre Jumeau Numérique ArcGIS

Les architectes, les urbanistes ou encore les ingénieurs en BTP ont souvent besoin d'un contexte 3D précis et accessible pour visualiser et concevoir de nouveaux projets au sein d'environnements urbains existants. Pour faciliter la récupération de ce type de contexte 3D à partir de votre Jumeau Numérique ArcGIS, une nouvelle application open source "City Download Portal" est désormais disponible. Développée avec le SDK ArcGIS Maps for JavaScript, cette dernière permet justement d'extraire rapidement un ou plusieurs modèles 3D pour un usage dans des outils de conception 3D externes au SIG. En délimitant u...

Forest Navigator, un outil pour explorer les données forestières à l'échelle européenne

L'outil cartographique Forest Navigator permet d'explorer des données sur les forêts de l'Union européenne. Ces données en haute résolution abordent des thèmes tels que la santé des forêts, l'atténuation du changement climatique ou l'adaptation à celui-ci. Les cartes et les données sont mises à disposition en haute résolution.

Interface de la plateforme de données forestières à l'échelle de l'UE (source : Forest Navigator)

...

L'histoire par les cartes. Une carte de Kingsbridge (Devon) assez unique de 1586

Source : « New Acquisition : Devon Tudor », Map South West Heritage Trust, https://swheritage.org.uk/news/devon-tudor-map/

« On trouve rarement des illustrations de petites villes de cette époque ». Une carte exceptionnellement rare d'une ville du Devon a été acquise par le South West Heritage Trust. La carte du XVIe siècle enrichit le patrimoine historique du comté et ouvre de nouvelles perspectives pour des recherches approfondies sur l’héritage des Tudors dans le Devon, après être restée quatre siècles entre les mains de propriétaires privés.

Une carte Tudor exceptionnellement rare de Kingsbridge, dans le Devon, a été acquise pour le public

(crédit : South West Heritage Trust)

How Indo-European Shaped Half the World

[FR]Importer les cartes marines NOAA ENC directement dans QGIS avec S57Manager

Les ENC (Electronic Navigational Charts) constituent aujourd’hui la référence pour la cartographie marine numérique.Avec la dernière évolution du plugin S57Manager, QGIS se dote désormais d’un module dédié au catalogue officiel NOAA ENC, permettant de rechercher, filtrer…

The post [FR]Importer les cartes marines NOAA ENC directement dans QGIS avec S57Manager first appeared on Blog SIG & Territoires.

GIScussions: Dead Reckoning Part 2 – Claude smashes Gemini

Click on the image above to view Dead Reckoning v2

A couple of weeks ago I finished my Dead Reckoning V1 app and I was pretty pleased with it, all the gigs that the Dead had played summarised and displayed along with set lists, sound tracks and more. I released it just before Geomob and got some good feedback so a few days later I decided to publicise it to the Grateful Dead community on Reddit, then the storm broke!

...Retour sur le live « L’année IA 2026 des CIO : sur quels sujets clés se mobiliser? » du 29 janvier 2026

Le jeudi 29 janvier 2026 à 11h a eu lieu le Live LinkedIn « AIMission#10- L’année IA 2026 des CIO : sur quels sujets clés se mobiliser ? ». Dans le cadre de ses missions pour l’Afigéo, Benjamin CHARTIER (Optéos) vous propose une synthèse de cet évènement : Actualité récente de janvier 2026 : Points marquants de […]

...

Mise à jour de la roadmap 2026 d'ArcGIS Experience Builder

Votre générateur d'application préféré "ArcGIS Experience Builder" continue d'évoluer en 2026. Comme chaque année, l'équipe d'Experience Builder communique en avant première ce que le générateur d'application vous réserve pour l'année 2026 via une nouvelle version de sa slide de roadmap.

En avant-première, vous retrouvez la page dans les ressources de la communauté Esri dédiée à Experience Builder : https://experience.arcgis.com/experience/f13f9e5ec1b94b7cbac0c84532fd5fb3

Vous noterez que cette roadmap présente les éléments à titre indicatif. Ils sont susceptibles d'être modifiés à tout moment selon les aléas d...

Comment l’Europe a nommé le monde, par Nicolas Perrot.

Partout sur le globe, des villes, des pays, des montagnes, des fleuves, des déserts, des îles, ont été nommés par les Européens au gré des explorations et des colonisations, à partir du XVe siècle. Dans sa préface, Christian Grataloup souligne le fait que de très nombreux toponymes sont l’héritage du fait colonial, même s’ils reprennent des noms locaux, plus ou moins déformés et européanisés. Il invite à « picorer » l’ouvrage de Nicolas Perrot, qu’il qualifie de « buffet géographique ». Alors, picorons ensemble cette sorte de dictionnaire qui passe en revue une grande partie des lieux du monde découverts puis ayant appartenu à des Européens.

Nicolas Perrot, préf. de Christian Grataloup. Comment l’Europe a nommé le monde. Riveneuve, 2025

...Pinning Photo History to the Map

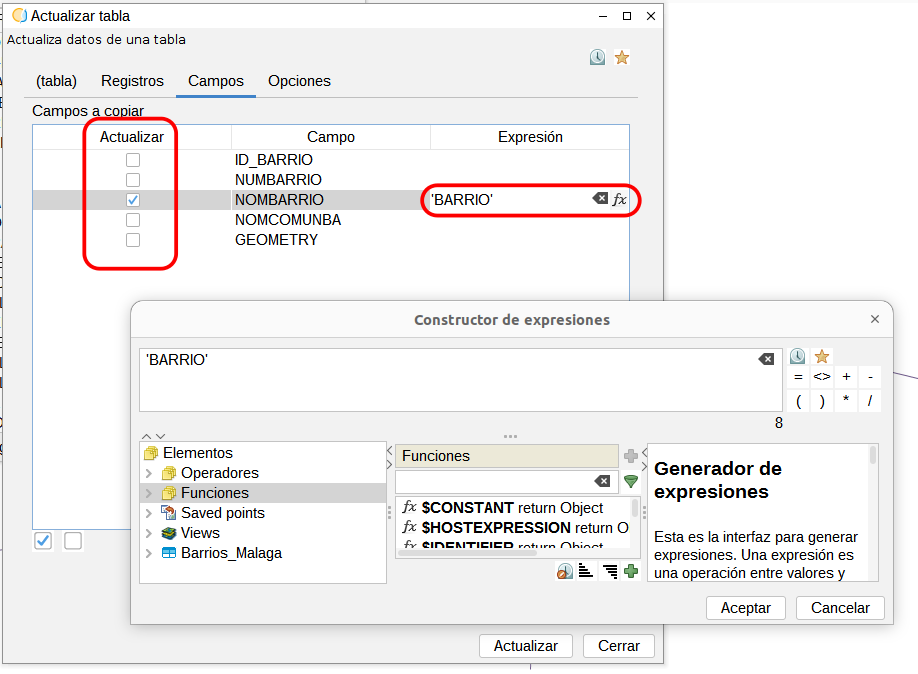

gvSIG Team: Novedades gvSIG Desktop 2.7: Nueva Calculadora de campos

La nueva versión 2.7 de gvSIG Desktop incluye una nueva calculadora de campos, cuyas principales ventajas son, por un lado, que se pueden rellenar varios campos a la vez, y por otro, que ha mejorado significativamente el rendimiento cuando se pretenden rellenar muchos registros a la vez, al no cargarse en memoria todos ellos sino por bloques.

La nueva calculadora se basa en la herramienta de actualizar tabla que se había incluido en la versión anterior, donde se había mejorado la parte de rellenado de registros. Ahora dispone de una pestaña “Opciones” donde se puede seleccionar el número de registros en los que se quiere que termine edición y reinicie. De esa forma no carga todos los datos en memoria y no bloquea el equipo, evitando así también posibles pérdidas de datos.

...

Appréhender les vulnérabilités sociales territoriales à différentes échelles

Source : Olivier Portier, Les vulnérabilités sociales territoriales. Cahier de recherche, Caisse des dépôts et OITC, janvier 2026.

...PostGIS Development: PostGIS Patch Releases

The PostGIS development team is pleased to provide bug fix releases for PostGIS 3.0 - 3.6. These are the End-Of-Life (EOL) releases for PostGIS 3.0.12 and 3.1.13. If you haven’t already upgraded from 3.0 or 3.1 series, you should do so soon.

Sean Gillies: Quad Rock training week four

The numbers went up in week four.

13 hours, 23 minutes all training

30.2 miles running

4,108 ft D+ running

More important is that I got in my power-building workouts. A big session of back squats and single-leg step-downs, among other exercises, at the gym on Tuesday after seeing my physical therapist. A session of hill sprints on Thursday after an easy run with a friend at Pineridge Open Space.

Saturday I went on another Quad Rock training run with a big crowd on an extraordinarily warm day. I'm glad I wore shorts and brought a third bottle of water. There were some icy spots early, but they'd melted on the return leg. I paid the price for going out too fast with some cramping at the finish, and struggled with knee stiffness, but mostly had a great morning.

...

hebdoOSM 811

29/01/2026-04/02/2026

[1] OSM Kids! | © MapLibre – OpenFreeMap – OpenMapTiles – Données cartographiques © Cartographes OpenStreetMap.

...![[Le blog SIG & URBA] SRU comme Structuration des Règlements d'Urbanisme](https://blog.georezo.net/sigurba/files/2026/02/SRU4_acteurs-600x239.jpg)

[Le blog SIG & URBA] SRU comme Structuration des Règlements d'Urbanisme

Here Grows New York

Retour sur le colloque interrégional « géoprospective » du 22 janvier 2026

L’Afigéo a participé le 22 janvier 2026 au 3ème colloque interrégional du collectif « Géofuturs méditerranéens » à l’espace Castel de Lunel (Provence-Alpes-Côte d’Azur, Occitanie, Corse). Le Collectif Géoprospectif méditerranéen vise à analyser les données, outils et méthodes utiles pour les gestionnaires du territoire dans des contextes à forts enjeux. Cette journée a permis de mettre en lumière des axes structurants pour toutes […]

...Repenser les formulaires Symfony : une approche moderne

Module Itinéraires ou Outdoor, lequel choisir ?

Les projets structurants de l’IGN présentés aux territoires

Le 26 janvier 2026, l’IGN a invité les Directeurs généraux des services des Régions et des plateformes régionales d’information géographique, ainsi que le CNIG et l’Afigéo à une réunion de présentation des projets en cours. Les échanges contribuent ainsi utilement au Comité national de programmation de l’IGN et complètent les collaborations existantes entre les Régions, les plateformes […]

The post Les projets structurants de l’IGN présentés aux territoires first appeared on Afigéo.The Flight Sim Globe

py3dtiles v12 : encore plus simple de passer vos données 3D au web

py3dtiles est un outil Python qui permet de convertir des données géospatiales 3D issues de formats variés vers le standard 3D Tiles, afin de les visualiser facilement et efficacement dans des applications web 3D temps réel.

Il peut être utilisé via une ligne de commande ou intégré directement dans une application grâce à son API.

...

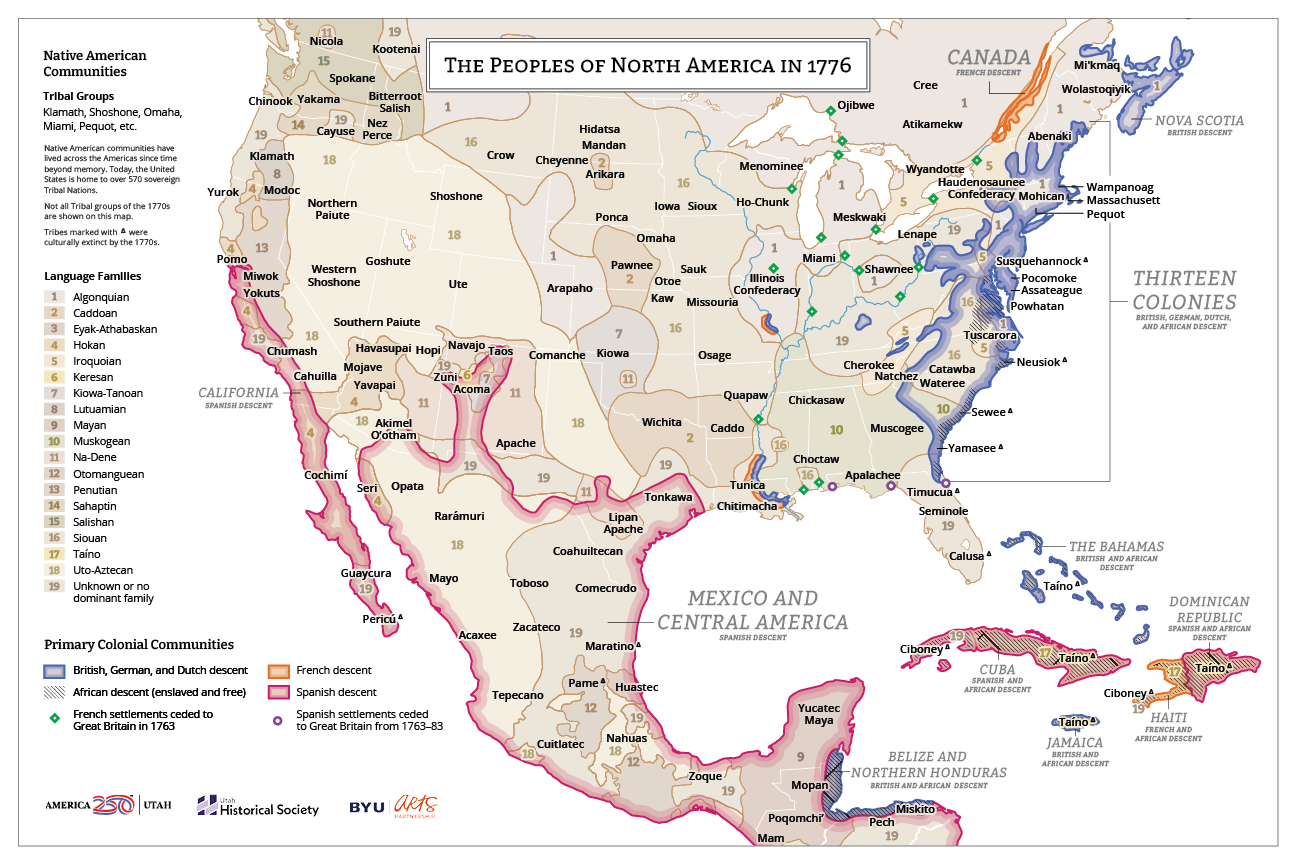

L'histoire par les cartes. Les peuples d'Amérique du Nord en 1776

Dans le cadre des célébrations du 250e anniversaire de l'indépendance américaine, la Société historique de l'Utah publie une carte intitulée « Les peuples d'Amérique du Nord en 1776 ». Il s'agit d'une ressource utile pour tous ceux qui s'intéressent à l'histoire des peuples autochtones en Amérique du Nord. Le principal intérêt de la carte est de mettre en évidence l'implantation des communautés amerindiennes au moment de l'indépendance des États-Unis et de l'expédition Domínguez-Escalante qui eut lieu à la même date.

Les peuples d'Amérique du Nord en 1776 (source : America250 Utah)

...Recrutement Technicien Système d’Information Routier (H/F)

La Collectivité Territoriale de Guyane recrute un technicien Système d’Information Routier (SIR) (catégorie B, cadre d’emploi des techniciens territoriaux), au sein de la Direction Générale Équipements et Mobilités.

Dans le cadre du développement de son Système d’Information Routier, la CTG souhaite renforcer ses équipes afin d’assurer le pilotage, l’administration et l’évolution d’un outil structurant pour la gestion des infrastructures de transport.

Le poste porte notamment sur l’assistance à maîtrise d’ouvrage de projets à composantes spatiales, l’administration du SIR (structuration et gestion des données routières, SIG), ainsi que le paramétrage, le déploiement et la maintenance des solutions logicielles en lien avec la maîtrise d’œuvre.

...Polygon Map Effects

Lille: Rencontre Openstreetmap à Lille, Le mardi 3 mars 2026 de 18h00 à 20h00.

Une rencontre des contributeurs Openstreetmap à Lille, où nous discutons beaucoup de la cartographie des aménagements cyclables, mais pas que !

Vous pouvez vous inscrire ici : https://framadate.org/WNN1wXOwrzjaeRjf

Et rejoindre la liste de discussion ici : https://listes.openstreetmap.fr/wws/subscribe/local-npdc

Toute personne intéressée par OpenStreetMap peut s'intégrer à cette rencontre, tout particulièrement les débutants qui souhaiteraient des conseils pour se lancer.

A bientôt !

The Fallout - Vault-Tec Map

Face à Google Maps, comment la France joue la carte de la souveraineté

Source : Jules Grandin, Face au mastodonte Google Maps, comment la France joue la carte de la souveraineté, Les Echos (1er février 2026).

La carte est l'objet de pouvoir par excellence. Comment pourrait-on connaître, administrer ou défendre son territoire sans l'avoir cartographié avec précision ? En France, c'est la mission de l'IGN, dont le modèle économique est en train de basculer du papier vers les pixels. Cette enquête est déclinée sous forme de vidéo sur YouTube.

Vidéo : « Comment la France se bat contre Google Maps »

...

La carte du ciel des Skidi Pawnee, pour le premier jour de la carte

Aujourd’hui, c’est le premier jour du Jour de la Carte, on parle de Cartographia, qui présente une épopée de la (re)présentation cartographique du Monde. Si vous aimez les cartes, vous y apprendrez, notamment :

– d’où viennent ces termes de carte et cartographie ;

– comment, depuis la nuit des temps, l’humanité s’y est prise pour bâtir des cartes du monde qui l’entoure et au-delà ;

– comment les usages des cartes ont pu évoluer, de même que leur image ;

– comment et selon les époques, les cartes ont su donner à voir différentes visions du Monde, selon différents points de vue ;

– ce sont que les cartes géographiques, du monde terrestre, maritime et fluvial, géologique et bathymétrique, mais aussi les cartes célestes qui nous intéresse aujourd’hui – sans oublier, bien sur, les cartes statistiques ou encore les cartes mentales, le tout présenté dans une perspective critique.

Le Groenland et la France

En ce mercredi 28 janvier 2026, et en parallèle à la visite à Paris des dirigeants du Danemark et du Groenland, le Musée national de la Marine propose un temps d’échanges entre scientifiques, acteurs culturels et sociétés civiles de Groenland et de France.

Le glacier de Jakobshavn dans la baie de Disko (photo de Giles Laurent, https://www.musee-marine.fr/nos-musees/paris/expositions-et-evenements/les-evenements/groenland-asavara/je-taime-groenland.html)

...

gvSIG Team: Cuando el software libre es la opción conservadora

En muchas ocasiones, hablar de software libre o de código abierto en proyectos públicos se asocia a innovación. Y aunque es cierto que el acceso al conocimiento permite innovar de forma más eficiente en muchos ámbitos, también suele interpretarse como una apuesta por soluciones alternativas o incluso de riesgo.

Si nunca lo fue, hoy todavía menos: esa lectura ya no encaja con la realidad.

Cada vez más, el verdadero riesgo no está en el software libre. Está en la dependencia.

...Fallout - Would You Survive a Nuclear War?

OSGeo Announcements: [OSGeo-Announce] Happy Birthday OSGeo! Celebrating 20 years of Free and Open Source Software for Geospatial

2026-02-04 | Celebrate 20 years of OSGeo with us

In February 2026, the Open Source Geospatial Foundation (OSGeo) will celebrate its 20th anniversary. What began as a small group of individuals and projects with a shared vision for free and open-source software for geospatial applications (FOSS4G) has evolved into a global organisation with projects, local chapters, conferences and communities spanning all continents.

While looking back over the last 20 years is important, it is even more important to consider what OSGeo represents today and how the foundation continues to evolve.

...

QGIS Blog: Documentation and Infrastructure Report 2025

It’s our pleasure to share our first Documentation and Infrastructure Report with highlights ranging across documentation, web infrastructure, and community-facing work. While this blog post provides a brief summary and team introduction, you can find the full report here.

...

GeoSolutions: FREE Webinar: GeoNode 5.0 Release

You must be logged into the site to view this content.

Mises à jour février 2026

Announcing SotM 2026 Travel Grant Program

The State of the Map Organizing Committee provides a Travel Grant Programme (TGP) to facilitate accessibility and diversity at the global SotM 2026 Conference, which will happen in Paris, France, August 28-30.

Taking into consideration the success of last year, the programme will also dedicate a portion of the budget available to support remote attendance (e.g. by providing access to a reliable internet connection) for those who cannot travel to Paris because of imposed restrictions, travel costs, or other reasons.

The call for applications to the Travel Grant Programme will be open until 1st March 12:00 UTC.

It is fundamental to read all the information on this page before submitting an application.

...

La projection pizzaïolo

(english below)

Imaginez la Terre comme une boule de pâte à pizza. On la prend entre les mains, on l’étale avec soin, on l’aplatit patiemment jusqu’à lui donner la forme d’un carré parfait. L’hémisphère Nord se retrouve sur le dessus, l’hémisphère Sud en dessous. Un bref passage au four, juste ce qu’il faut, puis sur un côté de cette croûte désormais terrestre, on incise une croix. Quatre triangles se détachent, que l’on peut alors déployer sur un même plan.

La métaphore de la boule de pizza peut surprendre. Et pourtant, elle décrit avec une étonnante justesse la projection cartographique quincunciale de Peirce, imaginée dès 1877 par le philosophe et mathématicien américain Charles Sanders Peirce. Une projection aussi élégante que déroutante, longtemps restée confidentielle.

Le résultat ?

...S57Manager : exploiter des données ENC S-57 dans QGIS avec GeoPackage

Une solution légère, autonome et portable pour les données marines Introduction Si PostGIS est idéal pour les environnements professionnels structurés, collaboratifs et multi-projets, il n’est pas toujours nécessaire — ni souhaitable — pour tous les usages.…

The post S57Manager : exploiter des données ENC S-57 dans QGIS avec GeoPackage first appeared on Blog SIG & Territoires.

L’équipe Oslandia en séminaire !

Oslandia se veut une structure atypique, avec des valeurs affirmées basées sur l’autonomie, la confiance et l’ouverture.

Des valeurs que nous retrouvons dans notre organisation : nous avons depuis la création de l’entreprise, misé sur un fonctionnement en télétravail avec des collaborateurs répartis dans la France entière. Un fonctionnement qui permet à toutes et tous une organisation libre des missions et de la journée de travail

Mais nous avons aussi grand plaisir à nous retrouver, c’était le cas la semaine dernière à Paris pour notre Corpo d’hiver !

Ces journées sont l’occasion de partager des moments privilégiés, d’échanger sur des sujets de fond et … de faire une belle photo d’équipe

Pour cette session, nous avons inauguré un jeu sérieux conçu par notre équipe, le « jeu des mille projets » :

...

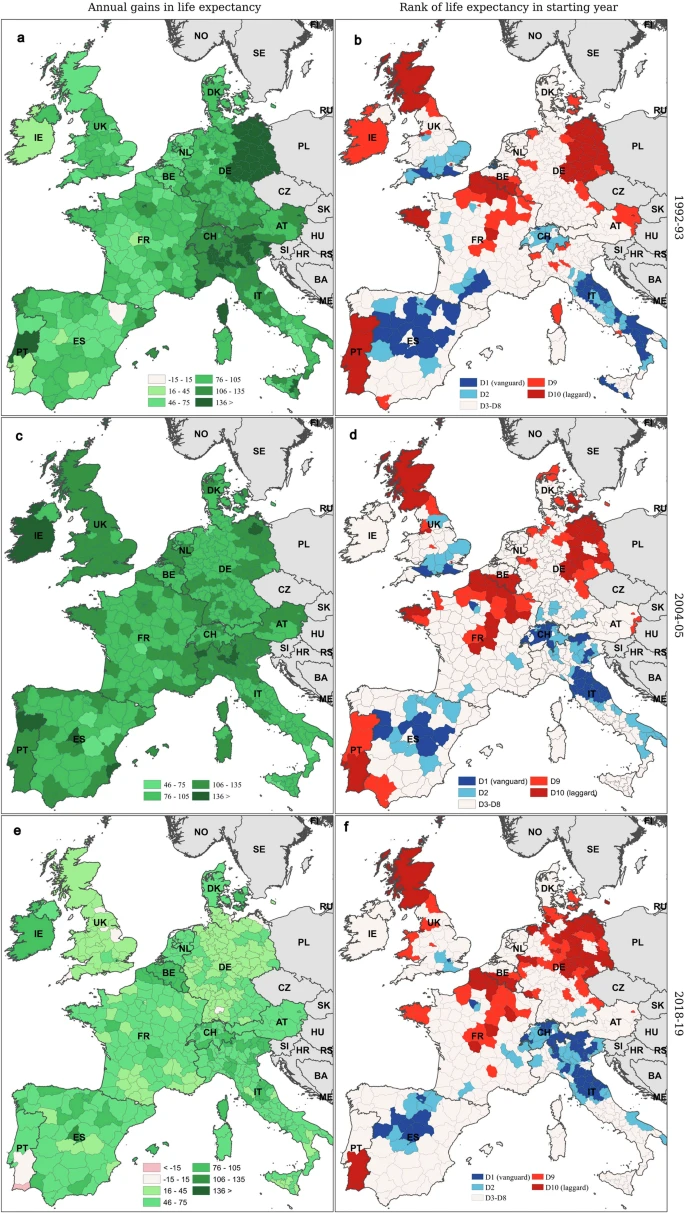

Évolution contrastée de l'espérance de vie en Europe (1992-2019)

Grenoble: Atelier de février du groupe local OSM de Grenoble : uMap avancé, Le lundi 9 février 2026 de 19h00 à 21h00.

Après un rappel sur le générateur de cartes personnalisées uMap, Binnette nous présentera :

- Une démo de ses cartes uMap : différents besoins et cas d'usage.

- La création de cartes uMap avec des données Overpass

- Des scripts pythons de génération de carte uMap

- Les limitations de uMap et les problèmes de performance

Informations pratiques

- Lundi 9 février 19h - 21h

- À la Turbine.coop, 5 Esplanade Andry Farcy, 38000 Grenoble (entrée sur le côté du bâtiment, nous serons dans la salle de réunion au rez-de-chaussée)

- Atelier ouvert à tous et à toutes

- Inscription souhaitée via ce formulaire

Making environmental compensation visible. Biased data transparency and agrobusiness strategies in the Bahianese agricultural frontier of the Cerrado

Although environmental compensation has become a cornerstone of contemporary environmental legislation, its visibility in both landscapes and public debate remains limited. This article provides a geographical analysis of the (re)location of Legal Reserves (RLs) in the agricultural frontier of western Bahia, Brazil. Legal Reserve are portions of rural properties set aside from productive activities to support environmental conservation within agricultural landscapes. They are mandatory and they must cover 20% of each property in western Bahia. Using public datasets from the Rural Environmental Registry (CAR) —Brazil’s public digital platform for monitoring environmental compliance— we developed a novel GIS-based methodology to trace RL compensation linkages across this vast territory. Our findings reveal four key patterns: 1) Compensation is extensively used by agribusiness, often involving long-distance transfers that displace conservation oblig...

GIScussions: Dead Reckoning – if Gemini was my employee, I’d fire him/her/them

Click on the image above to view Dead Reckoning

This could be a long post because this was an ambitious project that was full of challenges and there are a few learnings, but first a bit of context.

A friend turned me on to the Grateful Dead in 1969, one listen to Live Dead and I was hooked. I still think the transition from Dark Star to St. Stephen is one of the most sublime bits of music ever. When the Dead came to England in 1972 I managed to get to most of their London gigs and made the journey to Bickershaw for the longest performance I have ever seen, I think it ran out at nearly 5 hours!

...

Café géo de Paris, mardi 17 février 2026 : La Pologne, nouvelle puissance européenne, avec Pierre Buhler

Mardi 17 février 2026, de 19h à 21h, Café de Flore, salle du premier étage, 172 boulevard Saint-Germain, 75006 Paris

Alors que l’Europe se trouve face à son défi le plus existentiel depuis la fin de la guerre froide, la Pologne consolide son statut de puissance européenne grâce notamment à sa position géographique, son poids économique et démographique et sa puissance militaire en construction rapide.

Pour mieux comprendre le rôle de la Pologne en Europe dans un moment particulièrement important, nous avons le privilège d’accueillir au Café de Flore le diplomate français Pierre Buhler qui fut ambassadeur à Varsovie entre 2012 et 2016. Pierre Buhler a publié en 2025 une remarquable synthèse sur l’histoire de la Pologne sous le titre Pologne, histoire d’une ambition. Comprendre le moment polonais (Tallandier, 2026).

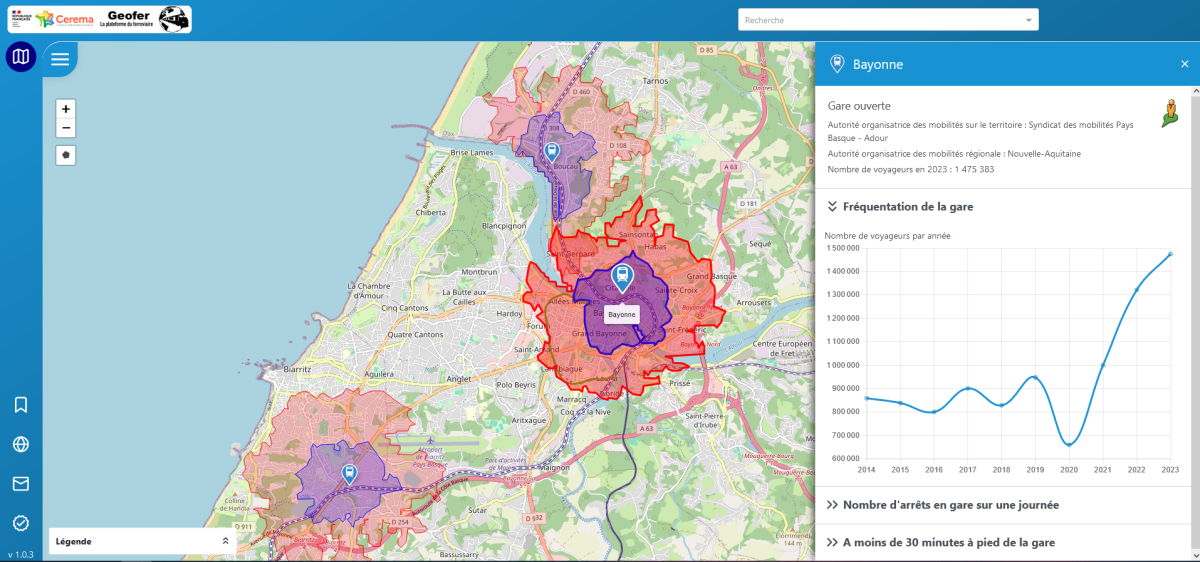

Géofer, une plateforme pour connaître le potentiel des gares voyageurs et des sites fret

La plateforme du Cerema Géofer a pour objectif d’être un outil d’aide à la décision permettant de visualiser le potentiel ferroviaire. Elle propose un système de couches, que l’on peut choisir d’afficher ou non. L’outil intègre également des bases de données permettant de consulter différents paramètres en cliquant sur des points d’intérêt. À ce jour, ces points regroupent environ 3 500 gares voyageurs et 3 000 ITE (Installations terminales embranchées, c’est-à-dire des sites de chargement et de déchargement de marchandises) réparties sur l’ensemble du territoire français.

Interface cartographique de la plateforme Geofer (source : Cerema)

Parmi les nouveautés de la plateforme Géofer :

Vienne: OpenStreetMap, rencontre mensuelle, Le mercredi 18 février 2026 de 18h30 à 20h30.

Discussion entre contributeurs.trices viennois.es du projet OSM et acteurs intéressés.

Toute personne intéressée par OpenStreetMap peut s'intégrer à cette rencontre, tout particulièrement les débutant.e.s qui souhaiteraient des conseils pour se lancer.

Lieu de réunion: MJC de Vienne, 2 Rue Florentin Laurent, 38200 Vienne - à partir de 18h30

gvSIG Team: INSPIRE and SDIs in the era of AI and digital twins

We are living in a time when almost every territorial project is presented alongside concepts such as artificial intelligence, digital twins or advanced analytics. The message is appealing: prediction, automation, intelligent decision-making.

But there is a less visible and far more decisive reality:

these systems only work properly when data is well structured.

AI applied to territorial management does not just require large volumes of information. It requires data that is coherent, comparable and maintainable over time. This is where standards come into play.

...

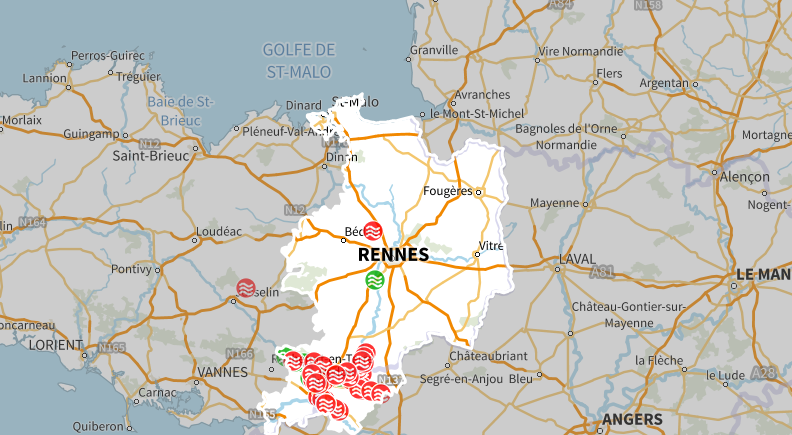

En temps réel, les coupures routières liées à des inondations lors des crues de la Vilaine et de ses affluents.

Suite aux inondations exceptionnelles de janvier 2025, l'État en Ille-et-Vilaine, en partenariat avec les gestionnaires routiers, ont développé un outil qui permet la consultation des coupures routières liées à des inondations lors des crues des cours d'eau.

Il centralise les informations connues, recueillies et partagées par les différents gestionnaires routiers du territoire sur l'état de praticabilité de leurs réseaux.

Un temps est nécessaire entre l'observation d'un évènement et sa remontée dans ce visualiseur. L'information n'y est donc ni exhaustive ni instantanée.

Rendez-vous sur https://geobretagne.fr/app/routes_coupees_inondation

Introducing GeoCards – A Wiki Labeled Map

gvSIG Team: Cómo descomprimir y ejecutar una versión portable de gvSIG Desktop

Desde la versión 2.7, gvSIG Desktop se ofrece directamente para descargar como distribución portable, con lo que no se instala nada en el equipo del usuario, simplemente es un fichero ZIP que se descomprime y ya se puede ejecutar. Esta versión se podría tener incluso en una tarjeta SD en el ordenador portátil, o llevarla en un pen-drive y ejecutarla en otros equipos, siempre que tengan el mismo sistema operativo, lo que mantendrá la configuración que teníamos en ella.

Un detalle a tener en cuenta al descomprimir los ficheros .ZIP es que no se debe hacer en rutas con espacios, acentos o eñes ni en rutas largas.

Sobre las rutas largas, un problema que suele haber en la distribución de Windows es que si se descomprime con el descompresor del sistema, se generan dos carpetas con el mismo nombre, por lo que genera una ruta más larga. En este vídeo te mostramos las posibles soluciones:

...

Cartes et données sur le recul du trait de côte en France

Le recul du trait de côte affecte l’ensemble des milieux littoraux et n’épargne aucune région française, outre-mer compris. L’évolution passée du trait de côte sur au moins 50 ans, montre que près de 900 km de côte sont observées en recul et que ce recul concerne majoritairement les côtes basses sableuses (680 km) sur l’emprise étudiée (hors secteurs portuaires et estuaires). La conséquence du recul du trait de côte est la disparition, souvent définitive (à l’échelle humaine), des terrains et des enjeux situés à proximité au bord de mer. Une étude du Cerema (2019) sur l’évaluation prospective des enjeux affectés par le recul du trait de côte tente de fournir les premiers ordres de grandeurs des enjeux potentiellement impactés en France. Selon plusieurs scénarios, le nombre de logements (maison et appartement) possiblement atteints par le recul du littoral en 2100 serait compris entre environ 5000 et 50000 en métropole et dans les DROM, pour u...

Formulation de ma projection cartographique du monde (2010) #2/2

Pour réaliser ma carte [présentée ici], j’ai dû me procurer une base de données des coordonnées GPS (angulaires) de points situés sur les côtes, les frontières, les principaux fleuves et de ceux des capitales.

Les terres émergées du planisphère équivalent de Patrick Étienne (2010)

Crédit : Patrick Etienne, 2026

C’est Mr Charles H. Culberson un géographe américain créateur du logiciel VersaMap qui me l’a fournie.

...Sean Gillies: Quad Rock training week three

Week three had some good workouts and social running.

12 hours, 9 minutes all training

23.9 miles running

3,268 ft D+ running

Yoga on Monday, as usual. Hill sprints Tuesday on a moderately steep dirt ramp at Pineridge Open Space. Elliptical spin and sets of back squats on Thursday. A long easy bike ride Friday.

Saturday, yesterday, I went for a long run in the snow at Horsetooth Mountain with friends. I kept it super easy until the last mile and a half, when I jumped onto a train of younger, faster runners who were coming down from a different route.

...Les données d’achat des pesticides en France spatialisées à l’échelle de la commune

Les données d’achat des pesticides en France sont publiées annuellement à l’échelle des codes postaux. Or, cette échelle est souvent trop vaste dans les zones rurales, qui sont pourtant concernées au premier chef par les enjeux sanitaires et environnementaux liés à l’usage de ces produits. Cet article propose une méthode pour ramener ces données à l’échelle communale, afin de faciliter leur suivi dans l’espace et leur appariement à d’autres données. Notre méthode s’appuie sur : (i) des informations concernant les doses d’application autorisées de pesticide ; et (ii) sur une couche géographique représentant finement les surfaces susceptibles de recevoir des traitements. La méthode de spatialisation employée permet de localiser finement plus de 95 % de la quantité de substances actives totale pour les années de 2015 à 2020. Ces données peuvent être utilisées en épidémiologie, agronomie, écologie et économie...

Découverte de la Guyane en vues immersives (01/2026)

Les vues immersives sont des images panoramiques géolocalisées acquises sur le terrain. Elles permettent de visualiser certaines parties du territoire depuis le web est d’analyser l’espace avec un niveau de détail inédit. Concrètement, elles permettent de visualiser un lieu comme si vous y étiez.

Sur les applications thématiques de Guyane-SIG, depuis quelques semaines, la librairie Panoramax vient compléter celle de Mapillary pour proposer un panel d’images enrichi dans le volet « Vues immersives ». Ces outils assurent un complément précieux aux données cartographiques classiques.

Projet open source, Panoramax vise à constituer une base d’images libres, réutilisables par tous, au service de la connaissance des territoires, de l’aménagement, de l’environnement ou encore de la gestion des infrastructures. Contrairement à des solutions propriétaires, Panoramax s’inscrit dans une logique de souveraineté et de partage des données.

...Stage Bac+5 en télédétection optique

SEAS Guyane recrute un(e) stagiaire (Bac+5) pour travailler sur l’optimisation de l’exploitation de l’imagerie satellitaire optique en contexte amazonien. Le dispositif SEAS Guyane assure la réception, le traitement et la diffusion d’images satellitaires au service des politiques publiques (environnement, aménagement, surveillance du territoire) à l’échelle de la région amazonienne et des Petites Antilles.

Le stage portera sur la prise en compte de l’ennuagement en imagerie optique, notamment la détection des nuages et des ombres portées (calcul de masques) ainsi que la combinaison multi-temporelle d’images en vue de produire des cartographies utilisables pour l’aménagement et l’aide à la décision.

Missions principales :

...

hebdoOSM 810

22/01/2026-28/01/2026

[1] | « N’achetez pas de plans de ville fantaisistes, créez les vôtres avec ce script gratuit » | Données cartographiques © Cartographes OpenStreetMap.

...Sean Gillies: Quad Rock training weeks one and two

The first two weeks of my Quad Rock training program went by quickly. My running mileage is still low, as I'm emphasizing power and speed, with generous recovery, and biking, treadmill, or elliptical chuggingfor easy aerobic base building. The quality of my running workouts has been good, in a way that doesn't show up in these numbers.

In week one, I did hill sprint sessions on Tuesday and Thursday on a block of Wallenberg Drive with a 3-4% incline. Running up at nearly maximum effort took about 25 seconds. This was not an aerobic workout in any way. I was focused solely on power and turnover.

11 hours, 7 minutes all training

26.4 miles running

1,545 ft D+ running

...

geomatico: La tierra no es plana. Pero tampoco es redonda.

Los mapas en papel son planos, las pantallas en las que vemos Google Maps también lo son. Y nadie duda de su admirable exactitud. En cambio, nos dicen que la tierra es redonda… sospechoso, ¿no? ¡Hemos vivido en una mentira toda la vida! Ellos nos engañan.

¿Pero quiénes son ellos?

Los mapas, naturalmente.

Porque resulta que la Tierra no es plana, pero tampoco es perfectamente redonda, y comprender cómo describimos su forma es el primer paso para entender la cartografía moderna, la navegación o el funcionamiento del GPS.

La Tierra es una realidad única, pero existen distintos modelos para representarla: desde su superficie real, hasta los mapas planos que utilizamos a diario.

...Drive Anywhere on Earth

Quand les bars ferment. Érosion du lien social et progression de l'extrême-droite

Source : Hugo Subtil (2026). « Quand les bars-tabacs ferment : l’érosion du lien social local et la progression du vote d’extrême droite en France », Observatoire du bien-être, Centre pour la Recherche Économique et ses Applications (CEPREMAP).

Propulsé par FreshRSS | 1307 articles au total