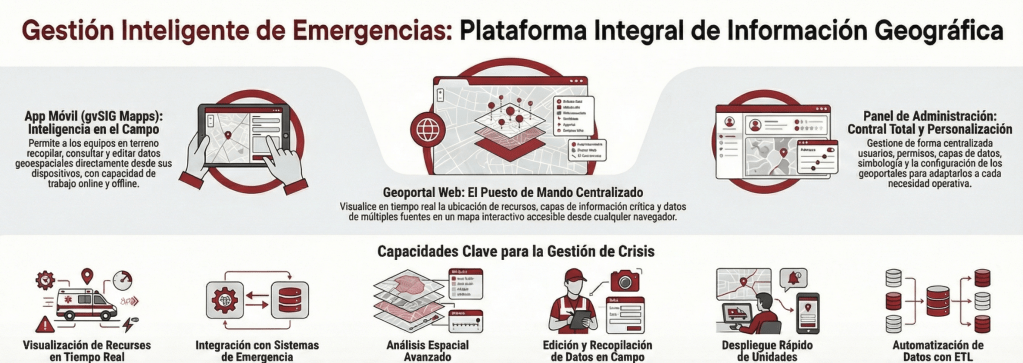

gvSIG Team: The gvSIG Suite as a partner for better municipal management

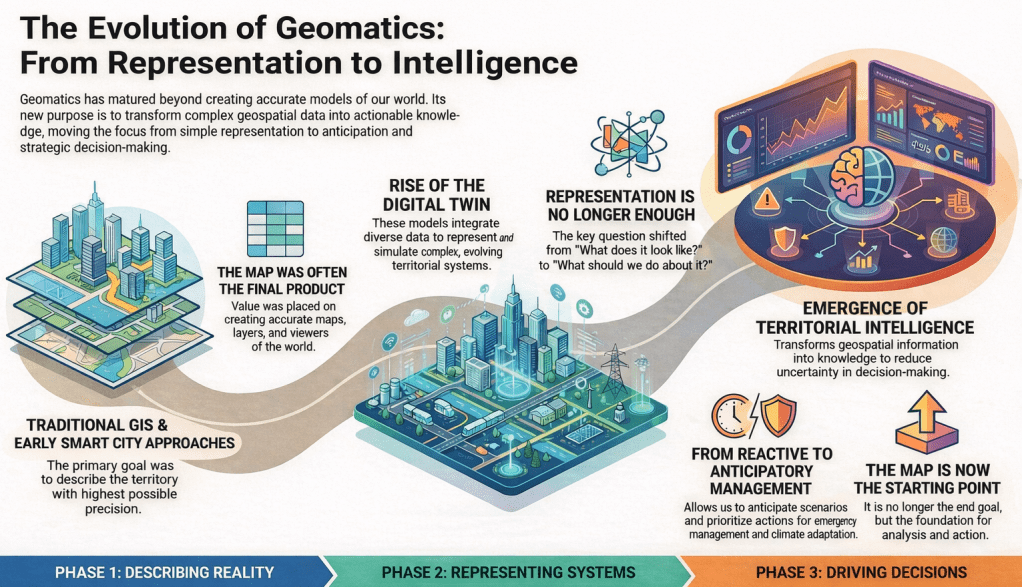

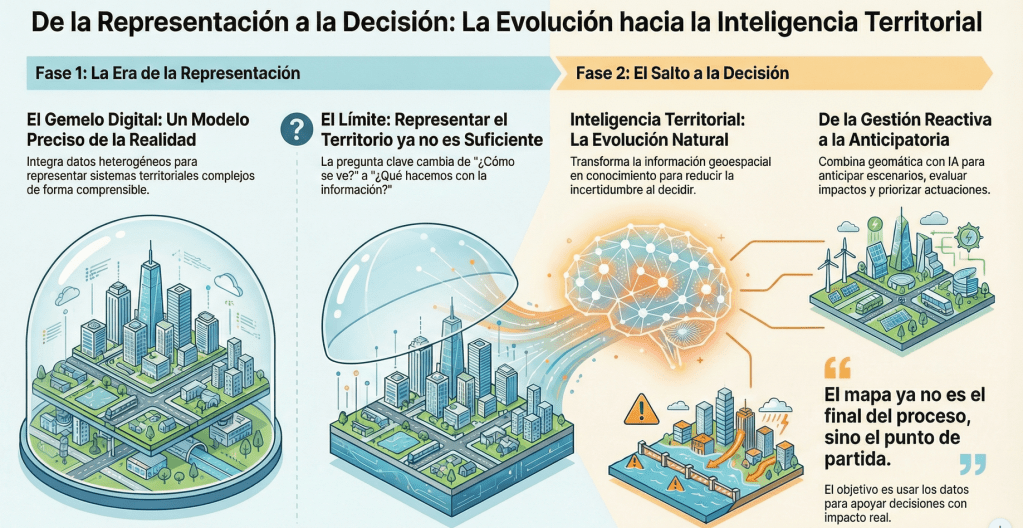

In the day-to-day management of a city council, information is key. But it is not just about having data—it is about knowing how to organize it, keep it up to date, and turn it into useful knowledge for decision-making. This is where the geographic dimension plays a fundamental role: infrastructures, administrative procedures, public services, environment, urban planning, or heritage… almost everything happens in a specific place within the territory.

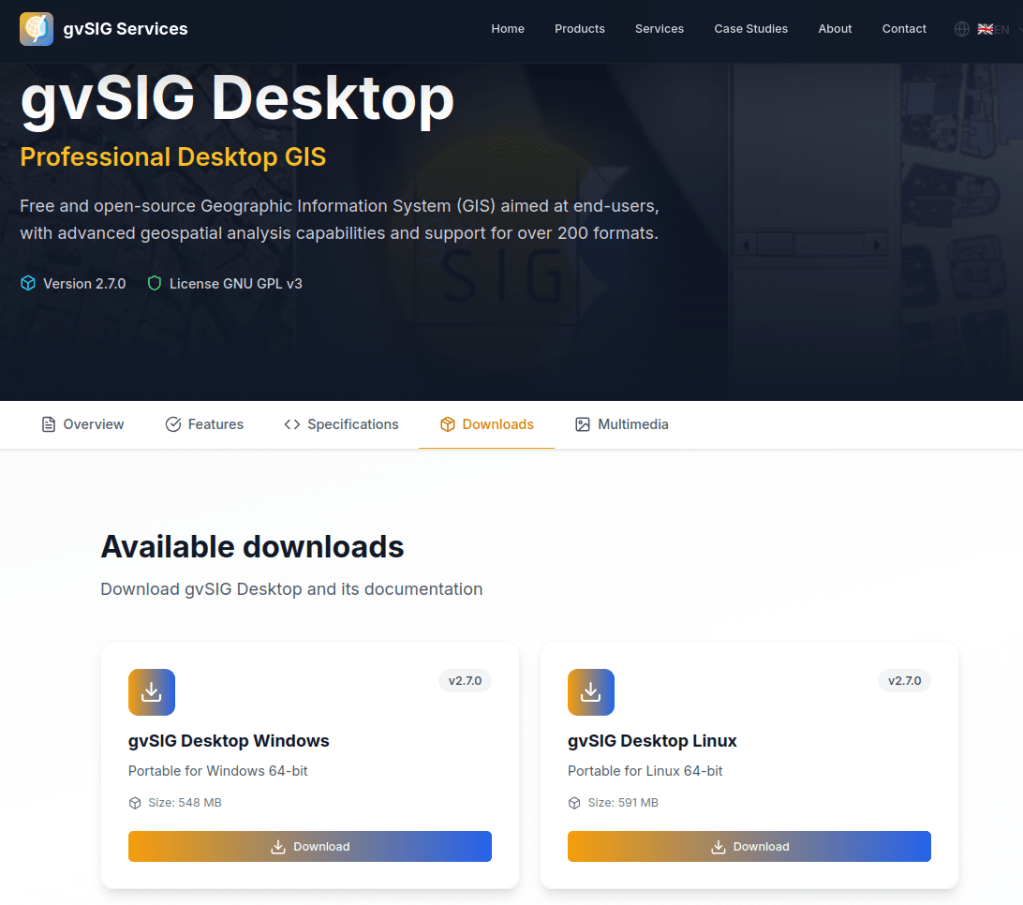

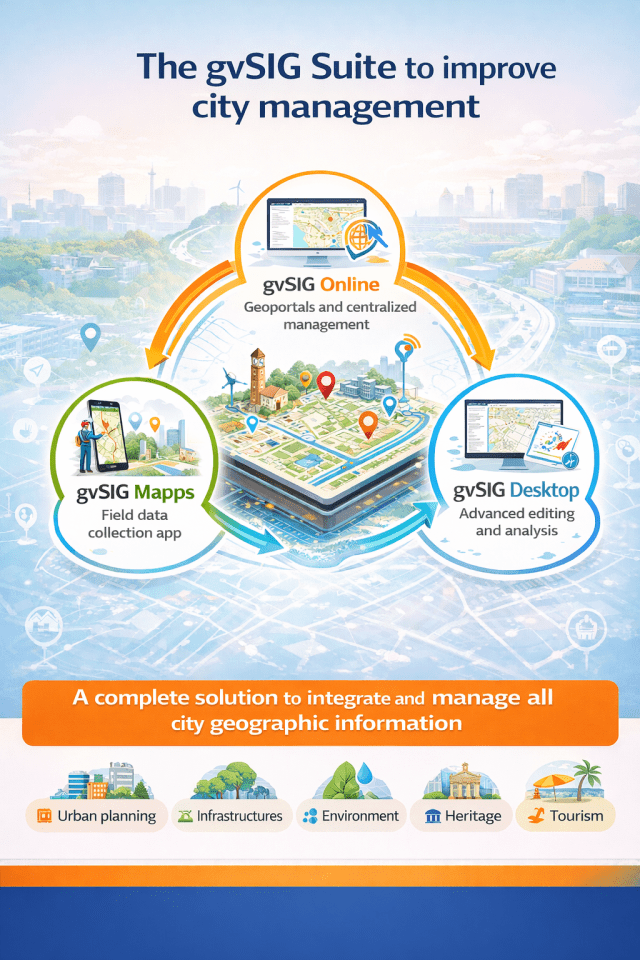

The gvSIG Suite provides a comprehensive response to this challenge by combining three tools that cover the entire lifecycle of municipal geographic information: gvSIG Online, gvSIG Mapps, and gvSIG Desktop.

...

![OSGeo Announcements: [OSGeo-Announce] OSGeo Board Election 2025 results](https://www.osgeo.org/wp-content/uploads/cropped-osgeo-emblem-rgb-1-32x32.png)