Saint-Brieuc: Rencontre OpenStreetMap, Le samedi 21 février 2026 de 14h00 à 18h00.

Rencontre des utilisateurs OSM Ă Saint-Brieuc.

Venez contribuer Ă la carte collaborative ou vous informer sur son utilisation Ă travers de nombreuses applications.

Agrégateur de flux RSS - Actualités et contenus géomatiques

Rencontre des utilisateurs OSM Ă Saint-Brieuc.

Venez contribuer Ă la carte collaborative ou vous informer sur son utilisation Ă travers de nombreuses applications.

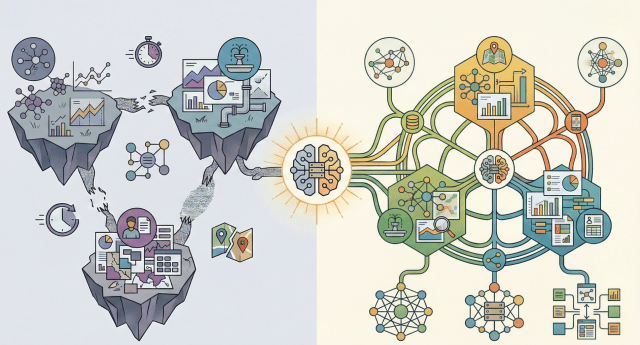

Vivimos un momento en el que casi cualquier proyecto territorial se presenta asociado a conceptos como inteligencia artificial, gemelos digitales o analĂtica avanzada. El mensaje es atractivo: predicciĂłn, automatizaciĂłn, toma de decisiones inteligente.

Pero hay una realidad menos visible y mucho mĂĄs determinante:

estos sistemas solo funcionan bien si los datos estĂĄn bien estructurados.

La IA aplicada al territorio no necesita Ășnicamente grandes volĂșmenes de informaciĂłn. Necesita datos coherentes, comparables y mantenibles en el tiempo. Y ahĂ es donde entran en juego los estĂĄndares.

...

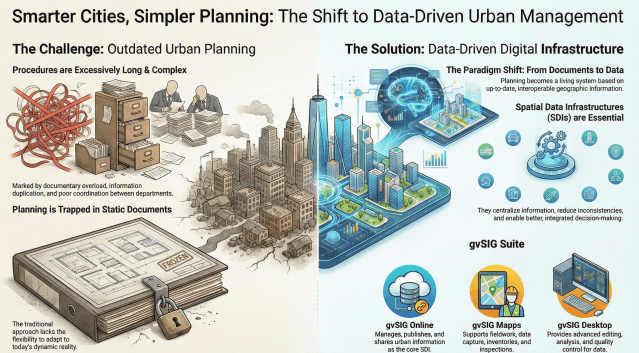

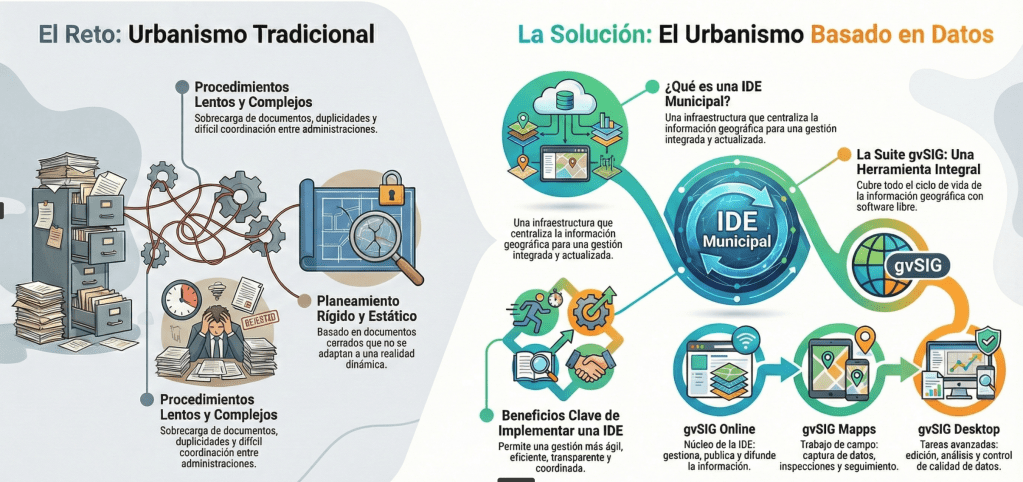

In many countries and regions, public administrations are revising their urban planning and land-use legislation with a shared goal: to simplify procedures, reduce administrative burdens, and adapt territorial management to an increasingly complex and dynamic reality.

The Valencian Community (Spain) is a recent example of this process, with the promotion of a new Land Law based on a widely shared diagnosis: excessively long procedures, documentary overload, duplication of information, and difficulties in coordinating data across departments and administrations. A situation that, to a greater or lesser extent, is repeated in many other territories.

...

Â

La Ville de Marseille ouvre ses cartes du territoire (plans anciens, fonds marins, localisation des animaux sauvages, etc.) et vous propose de participez à une véritable cartopartie !

Mercredi 4 février 2026 de 10h à 16h30.

Espace Villeneuve Bargemon (HĂŽtel de Ville).

Au programme :

...

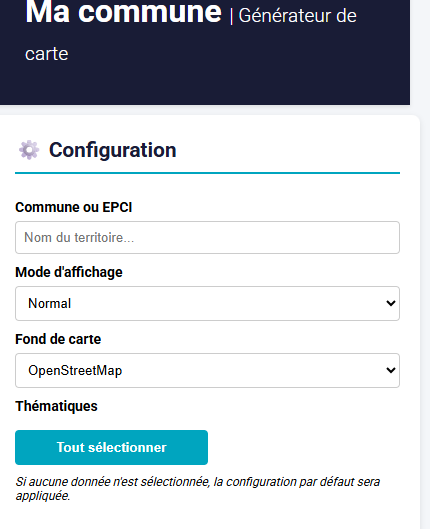

Mégalis Bretagne et GéoBretagne lancent « Ma carte communale », un outil en ligne permettant aux communes de publier facilement une carte claire et actualisée de leur territoire à partir de données publiques.

Simple dâutilisation, il offre plusieurs thĂ©matiques (Ă©quipements, environnement, urbanismeâŠ) et sâintĂšgre en quelques clics sur le site internet communal.

En muchos paĂses y regiones, las administraciones pĂșblicas estĂĄn revisando su legislaciĂłn urbanĂstica y territorial con un objetivo comĂșn: simplificar procedimientos, reducir cargas administrativas y adaptar la gestiĂłn del territorio a una realidad cada vez mĂĄs compleja y dinĂĄmica.

La Comunitat Valenciana es un ejemplo reciente de este proceso, con el impulso de una nueva Ley del Suelo que parte de un diagnĂłstico ampliamente compartido: procedimientos excesivamente largos, sobrecarga documental, duplicidades y dificultades para coordinar informaciĂłn entre departamentos y administraciones. Un escenario que, en mayor o menor medida, se repite en muchos otros territorios.

...

Source : Arnaud Serry, Ronan Kerbiriou (2025). « Les ports du Havre, de Marseille et de Dunkerque face Ă la concurrence europĂ©enne », The Conversation.Â

...AprĂšs un Bac Gestion et administration Ă Evry, Alicia sâoriente vers un BTS comptabilitĂ© et gestion Ă Dammarie-les-Lys puis un diplĂŽme supĂ©rieur, Ă©quivalent licence. Alicia aime la Compta !

« Ma mĂšre avait un poste administratif et je suis passĂ©e la voir un jour au bureau, jâai tout de suite compris que je voulais travailler dans ce domaine ! Et comme je suis plus Ă lâaise avec les chiffres quâavec les lettres, jâai choisi la voie comptabilitĂ© ! »

Alicia obtient son BTS en alternance avec une premiĂšre expĂ©rience dans la grande distribution puis assure des missions dâinterim chez Conforama en comptabilitĂ©, avant de rejoindre Oslandia en 2024.

« Je cherchais un poste dans la comptabilitĂ©, je suis tombĂ©e un peu par hasard sur lâoffre Oslandia, jâai tentĂ© ! Il me manquait quelques connaissances et expĂ©riences sur certaines tĂąches mais ça a marchĂ© ! »

Source :  « Mapping Outside the Lines ». Exposition de la bibliothÚque Newberry de Chicago (9 octobre 2025 - 14 février 2026), https://www.newberry.org/calendar/mapping-outside-the-lines

Source : « La nature dans le rouge â Alimenter lâĂ©conomie de transition vers la nature ». Rapport du PNUE 2026 sur l'Ă©tat des finances pour la nature, https://wedocs.unep.org/items/a4a8edaa-3896-4811-b527-1583dfce7201

« Pour chaque dollar investi dans la protection de la nature, 30 dollars sont dépensés pour la détruire ».

...

Aujourdâhui, nous recevons Patrick ETIENNE, un ingĂ©nieur aujourdâhui retraitĂ© qui a effectuĂ© toute sa carriĂšre dans lâindustrie et en particulier dans lâautomobile bien loin de la cartographie. Patrick E. nous a contactĂ©s aprĂšs la lecture de lâarticle de Claire Legros âComment les cartes sont devenues des contre-pouvoirs pour pour redessiner le mondeâ publiĂ© dans le Monde (02/01/2026) sur la cartographie critique, pour nous informer de sa crĂ©ation dâune âmappemonde Ă©quivalenteâ. Vue lâactualitĂ© gĂ©opolitique sur la question des projections cartographiques, nous lui avons proposĂ© de nous prĂ©senter son travail. Nous lui laissons la paroleâŠ

...

Ce 4 février 2026, nous célébrerons le premier « Jour de la Carte ».

Une initiative de « la République des Cartes » invitant, partout en France, curieux, novices comme passionnés à découvrir les cartes et leurs territoires sous des angles surprenants, originaux et inédits !

« Le Jour de la Carte » a pour but de rĂ©vĂ©ler le pouvoir des cartes comme levier pour faire dĂ©mocratie, rendant ainsi visible leur rĂŽle essentiel pour comprendre, dĂ©cider et agir ensemble.Â

Nous, acteurs·trices de la cartographie et passionné·e·s des cartes, vous donnons rendez-vous à « Cartographie(S) », l'événement nantais du « Jour de la Carte ».

Pour sa 9Ăšme Ă©dition, lâĂ©vĂšnement incontournable qui rĂ©unit la filiĂšre gĂ©onumĂ©rique organisĂ© par AfigĂ©o, sera accueilli par les partenaires de la dynamique autour de la donnĂ©e territoriale : Do.TeRR GĂ©oCentre et ceux de rang national, les 16 et 17 septembre au Palais des congrĂšs de Tours.ÂConfĂ©rences, ateliers, salon dâexposition, parcours « le spatial pour les territoires », animations, autant dâopportunitĂ©s [âŠ]

The post DEVENEZ ACTEUR DES GEODATADAYS 2026 đ first appeared on AfigĂ©o.Import, structuration et exploitation des cartes marines officielles dans une base spatiale robuste Introduction Les cartes marines au format S-57 (ENC â Electronic Navigational Charts) sont des donnĂ©es officielles, structurĂ©es, complexes et riches sĂ©mantiquement.Si elles sontâŠ

The post S57Manager : gérer des données ENC S-57 dans QGIS avec PostGIS first appeared on Blog SIG & Territoires.Le webinaire thématique sur le sujet des données adresses initialement prévu le mardi 27 janvier 2026 est reporté.

Pour mémoire :

...

Ya desde los inicios de la red de autĂłnomos que fue el germen de GeomĂĄtico, tenĂamos la costumbre de hacer, todos los años, al menos una reuniĂłn presencial de todo el equipo. Para quienes trabajĂĄis en empresas cien por cien en remoto, sabĂ©is lo importante que es juntarse y convivir con otros humanos.

En GeomĂĄtico, ademĂĄs, al ser una cooperativa, aprovechamos la ocasiĂłn para realizar lo que legalmente es nuestra Asamblea Ordinaria. En nuestro caso, utilizamos este evento tanto para la toma de decisiones que requieren el debate de todas las personas socias como para lo que comĂșnmente llamamos âfrikearâ un poco.

Durante todo este tiempo, cuando se acercaban estas fechas, elegĂamos dĂłnde querĂamos vernos y nos ponĂamos a buscar alojamiento. Hace cuatro años decidimos que nos reunirĂamos en Segovia y, durante la bĂșsqueda, dimos con Duermevela.

...

For years, at gvSIG we have insisted on a concept that was often dismissed as ideological, romantic, or even naĂŻve: technological sovereignty.

Today, in a context marked by geopolitical tensions, supply chain disruptions, and structural dependence on external technologies, this concept has moved beyond academic debate to become a strategic necessity.

Europe imports around 80% of its digital infrastructure and technologies. This is not only an economic issue: it is a political, operational, and democratic vulnerability. We depend on decisions taken outside our legal frameworks, our interests, and, in many cases, our values.

...

Durante años, en gvSIG hemos insistido en un concepto que muchas veces se despachaba como ideolĂłgico, romĂĄntico o incluso ingenuo: la soberanĂa tecnolĂłgica.

Hoy, en pleno contexto de tensiones geopolĂticas, disrupciones en las cadenas de suministro y dependencia estructural de tecnologĂas externas, ese concepto ha dejado de ser un debate acadĂ©mico para convertirse en una necesidad estratĂ©gica.

Europa importa alrededor del 80 % de su infraestructura y tecnologĂa digital. Esto no es solo una cuestiĂłn econĂłmica: es una vulnerabilidad polĂtica, operativa y democrĂĄtica. Dependemos de decisiones tomadas fuera de nuestro marco legal, de nuestros intereses y, en muchos casos, de nuestros valores.

...

Ces rencontres mensuelles se veulent ĂȘtre des instants conviviaux pour faire un compte-rendu des activitĂ©s du mois prĂ©cĂ©dent, mais aussi pour prĂ©senter les opĂ©rations et rendez-vous Ă venir que proposent les groupes HĂ©rOSM. Naturellement, elles sont Ă©galement ouvertes Ă tout public, en prĂ©sence et Ă distance.

Si vous avez des propositions nâhĂ©sitez pas Ă complĂ©ter la page dĂ©diĂ©e.

Programme :

...

Source : S. Colin, I. Delhomme, M. Kraszewski, Ch. Manceau (2026). MĂ©thode dâestimation de lâaccĂšs aux amĂ©nitĂ©s environnementales en milieu urbain, Documents de travail, n° 2026-02 â Janvier 2026, https://www.insee.fr/fr/statistiques/8727452

Quatre chercheuses prĂ©sentent une mĂ©thode pour mesurer lâaccĂšs aux espaces verts en ville. Leurs travaux montrent que lâaccĂšs aux amĂ©nitĂ©s environnementales est un enjeu important pour des villes durables et socialement plus justes. En France, 4 habitants sur 5 vivent en ville, dont la moitiĂ© dans de grands pĂŽles urbains denses. Selon lâOrganisation mondiale de la santĂ©, les espaces verts amĂ©liorent la santĂ©, le bien-ĂȘtre et la qualitĂ© de vie urbaine. La mĂ©thode dĂ©veloppĂ©e par lâInsee et le SDES combine les donnĂ©es de la BD TOPO de lâIGN et dâOpenStreetMap pour cartographier prĂ©cisĂ©ment les espaces verts dâintĂ©rĂȘt. LâaccĂšs est m...

This is a bugfix and maintenance release. While there are no new features or API changes, this release includes important bug fixes, documentation improvements, and minor enhancements across datasets, models, and testing.

Note

TorchGeo's documentation has been updated to use the PyData Sphinx Theme, bringing a modern look and feel along with improved navigation and accessibility. The new theme aligns TorchGeo with other scientific Python projects like NumPy, pandas, and xarray, providing a familiar experience for users across the ecosystem.

...

15/01/2026-21/01/2026

Warning: This export contains empty Articles

[1] Comment crĂ©er une carte des phares Ă lâaide de QGIS et QuickOSM | par Mashford Mahute | DonnĂ©es cartographiques © Cartographes OpenStreetMap.

...

World beyond War est une organisation à but non lucratif présente dans le monde entier. Elle utilise l'éducation, le militantisme et les médias pour « promouvoir la fin de toutes les guerres et l'instauration d'une paix durable ». Fondée en 2014, l'organisation publie réguliÚrement des rapports et conduit des actions en faveur de la paix. Parmi les ressources mises à disposition, figure un Guide visuel des bases militaires étrangÚres. Pour World beyond War, « mettre fin à toutes les guerres implique la fermeture de toutes les bases militaires à l'étranger ».

...

Weâre genuinely excited to co-organise the upcoming QGIS User Conference together with QGIS User Group Switzerland, and to do so in Laax, right here in the Swiss Alps.

Laax is home to OPENGIS.ch and the place where QField was born. It is a setting that has shaped how we work, how we collaborate, and how we think about building open-source tools that are meant to be used in the real world.

Bringing the global QGIS community together in such a place feels just right. People and ideas come together around open source, with space to exchange, reflect, and collaborate, in an environment that mirrors values that are deeply rooted in our DNA and our close connection to nature.

...Une session de formation "Observation des marchĂ©s fonciers et immobiliers - le potentiel de DV3F" organisĂ©e par le Cerema se tiendra le 31 mars 2026 Ă Lille.Cette session est Ă destination des bĂ©nĂ©ficiaires des fichiers donnĂ©es fonciĂšres (Fichiers Fonciers et DV3F) et des bureaux (âŠ)

Une session de formation "Le potentiel des Fichiers Fonciers" organisĂ©e par le Cerema se tiendra le 2 juin 2026 Ă Lille.Cette session est Ă destination des bĂ©nĂ©ficiaires des fichiers donnĂ©es fonciĂšres (Fichiers Fonciers et DV3F) et des bureaux d'Ă©tudes.Vous trouverez le contenu et le coĂ»t de la formation dans la rubrique (âŠ)

Searchable City propose une exploration visuelle de Manhattan (New York) à travers des images Street View prises au niveau des rues. Le site permet de découvrir des objets urbains, des styles architecturaux et des textures urbaines grùce à une recherche sémantique basée sur l'IA. Il s'agit du premier atlas sémantique à vocabulaire ouvert de la ville de New York. L'auteur, Sean Hardesty Lewis, a traité des centaines de milliers d'images des rues de Manhattan à l'aide d'un modÚle de langage visuel (VLM). Au lieu de demander des coordonnées au modÚle, il lui a demandé de décrire ce qu'il voyait.

Le premier atlas sémantique à vocabulaire ouvert de la ville de New YorkLes cartes sont aveugles

...

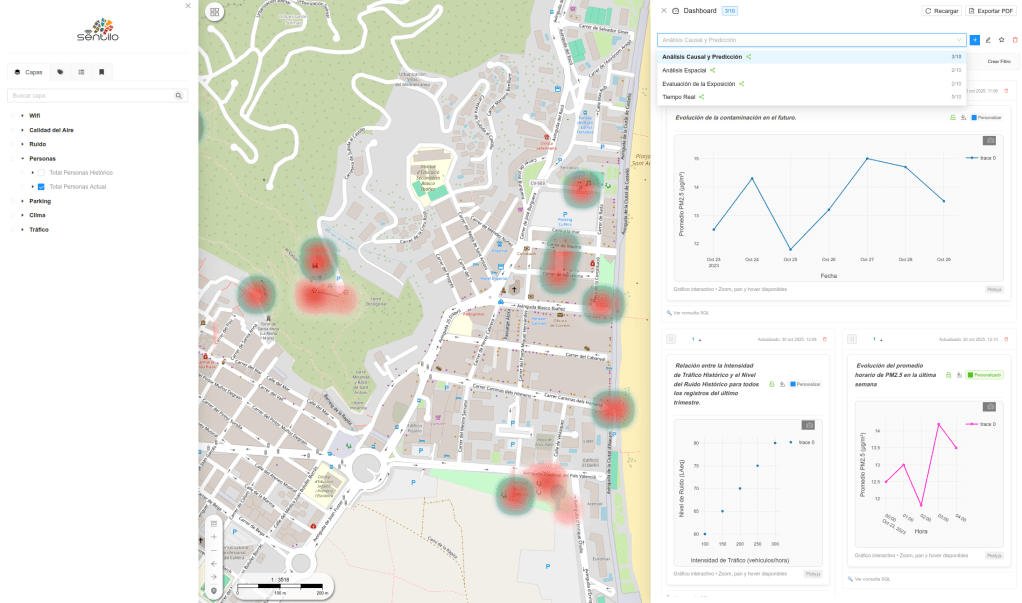

El nuevo frontend de gvSIG Online da un paso adelante en usabilidad, claridad y experiencia de usuario.

En este breve vĂdeo te mostramos, de forma rĂĄpida y directa, las principales herramientas y elementos de la interfaz: navegaciĂłn por el geoportal, gestiĂłn de capas, herramientas habituales de consulta, ediciĂłn, marcadores, etc⊠y una organizaciĂłn del interfaz pensada para trabajar de forma mĂĄs ĂĄgil y eficiente con informaciĂłn geoespacial.

Ver el vĂdeo:

Una buena oportunidad para conocer, en solo unos minutos, cĂłmo evoluciona gvSIG Online y quĂ© aporta su nuevo frontend al trabajo diario con mapas y datos territoriales. Y esto solo son las herramientas principalesâŠ

Ce mardi 13 janvier 2026, Jean Estebanez (J.E.), gĂ©ographe Ă lâUniversitĂ© de Paris Est-CrĂ©teil, est venu nous parler dâun lieu qui nous est Ă la fois familier et Ă©tranger, le zoo. Les cafĂ©s de gĂ©o avaient dĂ©jĂ eu le plaisir dâaccueillir J.Estebanez (1.).  Il y a consacrĂ© une thĂšse qui a Ă©tĂ© la source dâun ouvrage destinĂ© Ă un plus large public, Zoos. Aux lisiĂšres du domestique (1). Cette Ă©tude pose de nombreuses questions : comment capter la vie animale ? Comment prĂ©senter le « sauvage » sans lâabsorber ? Comment le sauvegarder ? Câest Micheline Huvet-Martinet (M. HM.) qui conduit la discussion.

Micheline Huvet-Martinet et Jean Estebanez (à droite) au Café de Flore. Photo de M. Vignaux.

M.HM. : Pouvez-vous dĂ©finir ce quâest un zoo et rappeler la genĂšse de vos travaux ?

...Une rencontre des contributeurs Openstreetmap Ă Lille.

Toute personne intéressée par OpenStreetMap peut s'intégrer à cette rencontre, tout particuliÚrement les débutants qui souhaiteraient des conseils pour se lancer..

Should I keep this for April Foolâs Day? Nah, a good laugh is always welcome whenever it comes! Thanks Brilliant Maps for sharing.

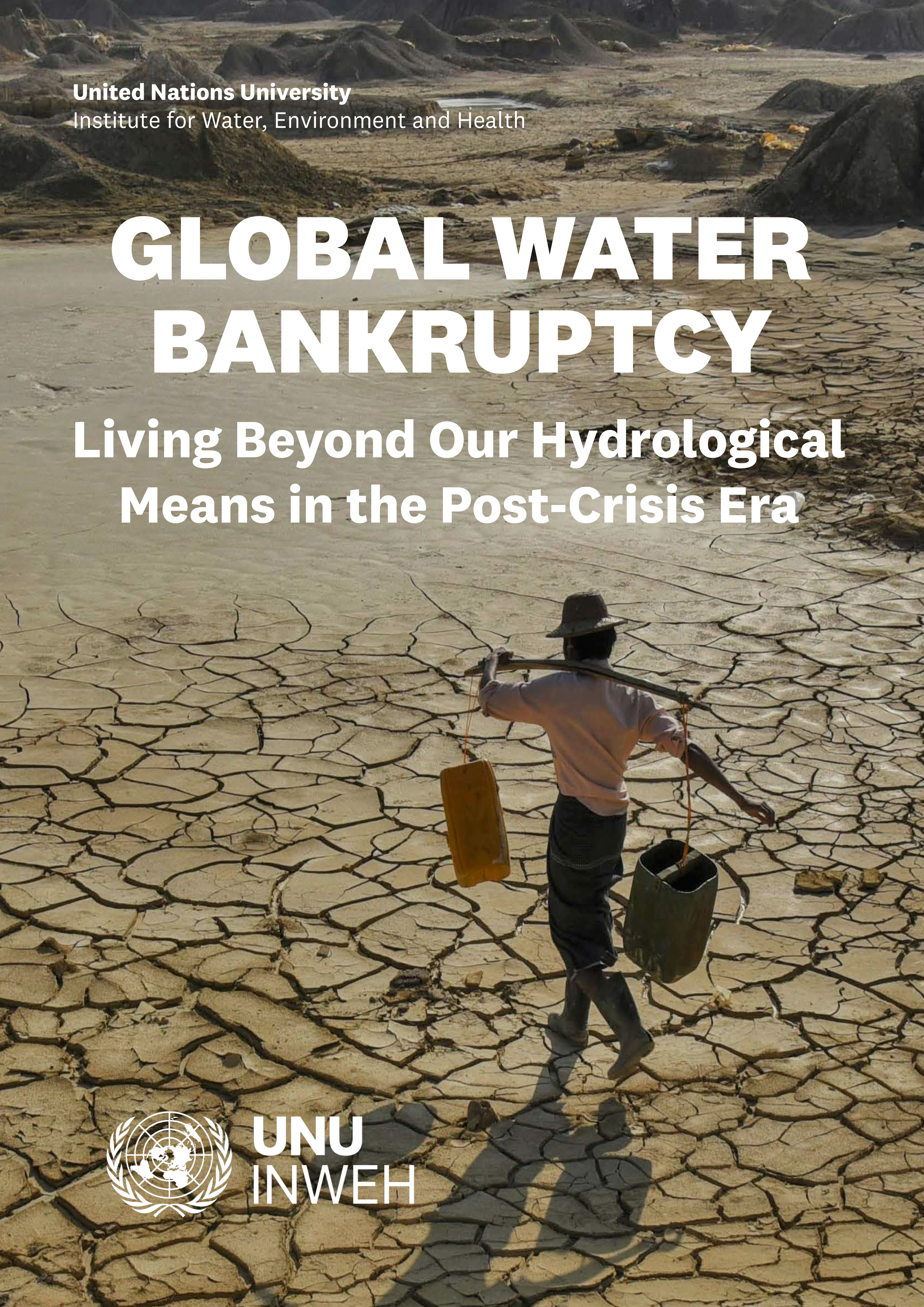

Source : Madani, K. (2026). « Global Water Bankruptcy : Living Beyond Our Hydrological Means in the Post-Crisis Era » [Faillite mondiale en matiĂšre dâeau : vivre au-delĂ de nos moyens hydrologiques Ă lâĂšre post-crise ]. United Nations University Institute for Water, Environment and Health (UNU-INWEH), Richmond Hill, Ontario, Canada. https://unu.edu/inweh/collection/global-water-bankruptcy

GeoServer 2.28.2 release is now available with downloads (bin, war, windows), along with docs and extensions.

This is a stable release of GeoServer recommended for production use. GeoServer 2.28.2 is made in conjunction with GeoTools 34.2, and GeoWebCache 1.28.2.

Thanks to Gabriel Roldan for making this release.

Release notesImprovement:

...You must be logged into the site to view this content.

Voir aussi la version texte de ce graphique.

Voir en ligne : /cartes/chrono-gaza-2023-2025

âdvdmccâ shared this detail from a hoodie.

Depuis la rentrée 2023, les temps de rencontre autour d'OpenStreetMap sont relancés.

L'occasion de se rencontrer (ou de se retrouver), d'Ă©changer sur OpenStreetMap et de lancer des projets en commun.

Comprendre les cartes marines Ă©lectroniques avant de les exploiter dans un SIG Introduction Les ENC â Electronic Navigational Charts sont aujourdâhui la rĂ©fĂ©rence mondiale pour la navigation maritime professionnelle.Produites par les services hydrographiques nationaux, elles respectentâŠ

The post Pourquoi les ENC (S-57) sont des donnĂ©es complexes first appeared on Blog SIG & Territoires.2026 sâouvre avec un nouvel outil pour amĂ©liorer la donnĂ©e bĂątimentaire et sa qualitĂ© au sein du rĂ©fĂ©rentiel national ! DĂ©sormais, les Ă©ditrices et les Ă©diteurs du RNB ont Ă leur disposition des indicateurs de donnĂ©es Ă amĂ©liorer directement sur la carte : des signalements gĂ©olocalisĂ©s. En traitant ces signalements, effectuĂ©s par la communautĂ© et par des [âŠ]

The post Lancement dâun nouvel outil par le RNB first appeared on AfigĂ©o.Nourredine Idir est GĂ©omaticien Ă lâAgence dâUrbanisme Catalane (AURCA), au sein du pĂŽle ressources qui assure lâensemble des missions autour de la cartographie, traitement de la donnĂ©e, data visualisation, SIG, assistance aux utilisateurs, maintenance du parc informatiqueâŠetc.

LâAgence dâUrbanisme Catalane est un centre interdisciplinaire de ressources, dâĂ©tudes, de recherches, de conseils et dâingĂ©nierie partenariale crĂ©Ă©e Ă lâinitiative des Ă©lus et de lâĂtat. Elle a Ă©tĂ© crĂ©Ă©e en 2007 pour accompagner les collectivitĂ©s dans la dĂ©finition des politiques dâamĂ©nagement et de dĂ©veloppement durable du territoire.

Nourredine Idir revient sur la collaboration avec Oslandia :

...

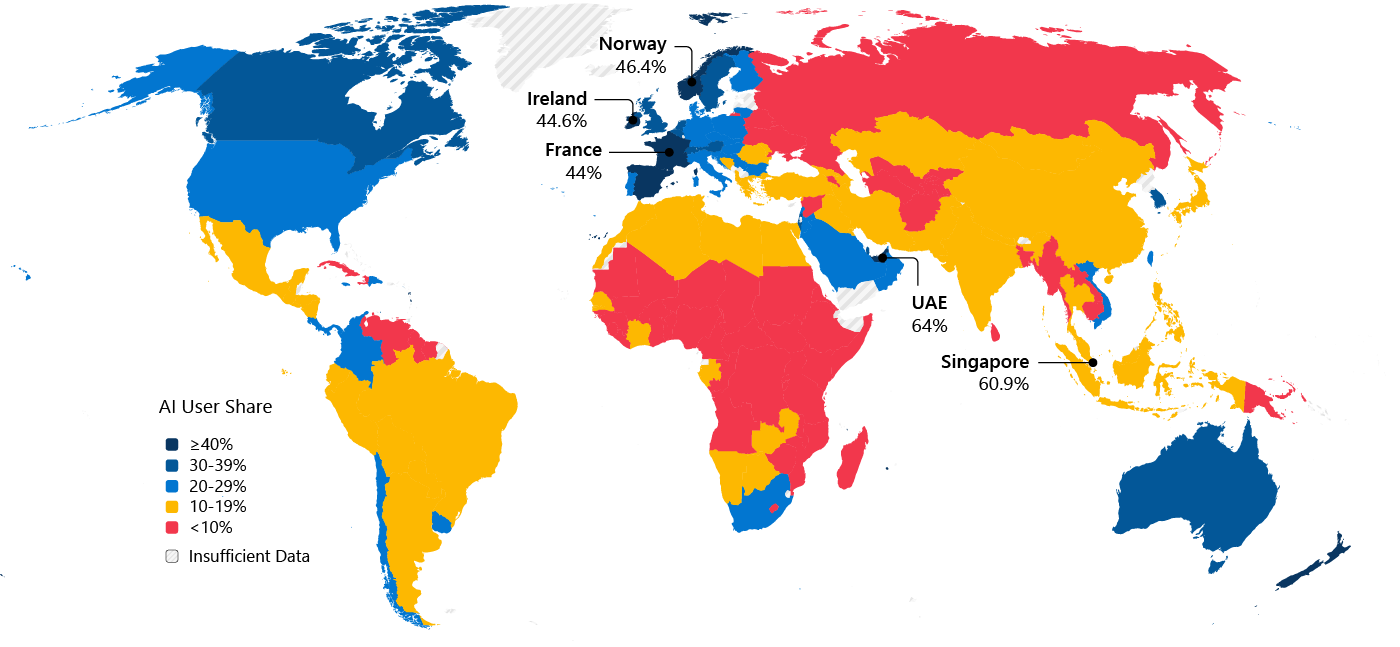

Source : Global AI Adoption in 2025âA Widening Digital Divide [Adoption mondiale de l'IA en 2025 : une fracture numĂ©rique qui se creuse], Microsoft AI Economy Institute, 8 janvier 2026.

Sallie âbumbling about town đđâ on BlueSky shared this cross-stitch project in progress.

I've made my long range plan for 2026. It's different from my plans from 2023-2025, which were about recovering from injuries and trying to finish a 100 mile race. I succeeded in the former, but not in the latter.

In 2026 I am trying to be more intentional about training for speed. I'm going to do some workouts that develop power and neuromuscular adaptations, without any concern for building aerobic capacity during those workouts. I'm going to do more strides during longer runs and sign up for some shorter 5-10K races. I'm going to remind myself that running briefly, but regularly, at 100 percent can translate to running faster at 80-85 percent during a longer run.

...

Jeudi 12 février 2026 à 18h, Amphithéùtre du Lycée Renan, Saint-Brieuc.

Thibault BARBOSA, géographe, a soutenu sa thÚse en 2023

« lâhistoire du continent austral : un mythe au service de la gĂ©ographie moderne ».

« Pendant prĂšs de deux millĂ©naires, les savants, les navigateurs et les cartographes ont cru Ă lâexistence dâun immense continent situĂ© au sud de la planĂšte : Terra Australis. Ce continent imaginaire a pourtant guidĂ© des expĂ©ditions majeures, nourri les cartes et inspirĂ© des rĂ©cits utopiques. Thibault Barbosa nous invite Ă explorer comment ce mythe a façonnĂ© notre façon de penser le monde, un voyage oĂč lâailleurs devient lâun des moteurs de la construction de la gĂ©ographie occidentale moderne ».

08/01/2026-14/01/2026

[1] Un podcast dâhistoire germano-autrichien bien connu publie sur une carte OSM les cartes postales de fans qui lui sont envoyĂ©es | Leaflet â donnĂ©es cartographiques © Cartographes OpenStreetMap.

...

We all enjoy a nice cup of tea with family or friends over Christmas, Walter Schwartz spotted this mappy teapot on his travels.

âThis little teapot, short and stout, was in the Two English Ladies Tea Shoppe, a booth at the San Francisco Dickens Fair. It says âCardewâs London Mapsâ on the bottom and may have originally been for sale in 1992. Although it is in the collection of the shop owner, they removed from it display case and let me photograph it because I explained it was for the internationally renowned mappery.org website.â

My guess is that this was made for Multimap, a London based mapping business at the time of the first dotcom boom (late 90âs early 2000âs), as a corporate gift. Maybe one of my friends who worked there will be able to confirm.

In the Christmas market at Covent Garden, London, I spotted this map seller. Unfortunately there was no time to peruse and purchase.

Une part importante de la population française subit une situation de prĂ©caritĂ© alimentaire, câest-Ă -dire quâelle ne dispose pas dâun accĂšs garanti Ă une alimentation suffisante, de qualitĂ© et choisie. Les facteurs de la prĂ©caritĂ© alimentaire sont multiples. Au-delĂ de la dimension Ă©conomique, des aspects spatio-temporels, pratiques et socio-culturels entrent en compte. Pour lutter contre la prĂ©caritĂ© alimentaire, le systĂšme traditionnel dâaide alimentaire reste la principale rĂ©ponse institutionnalisĂ©e, mais prĂ©sente de nombreuses limites. En rĂ©ponse, diverses formes alternatives dâaide Ă©mergent, portĂ©es par des acteurs divers, tant institutionnels quâassociatifs. Les institutions publiques Ă plusieurs Ă©chelles (Ătat, DĂ©partements) sâengagent aujourdâhui dans lâaccompagnement des transformations de lâaide alimentaire. Les Projets Alimentaires Territoriaux (PAT) apparaissent notamment comme un nouveau levier pour lutter contre la prĂ©caritĂ...

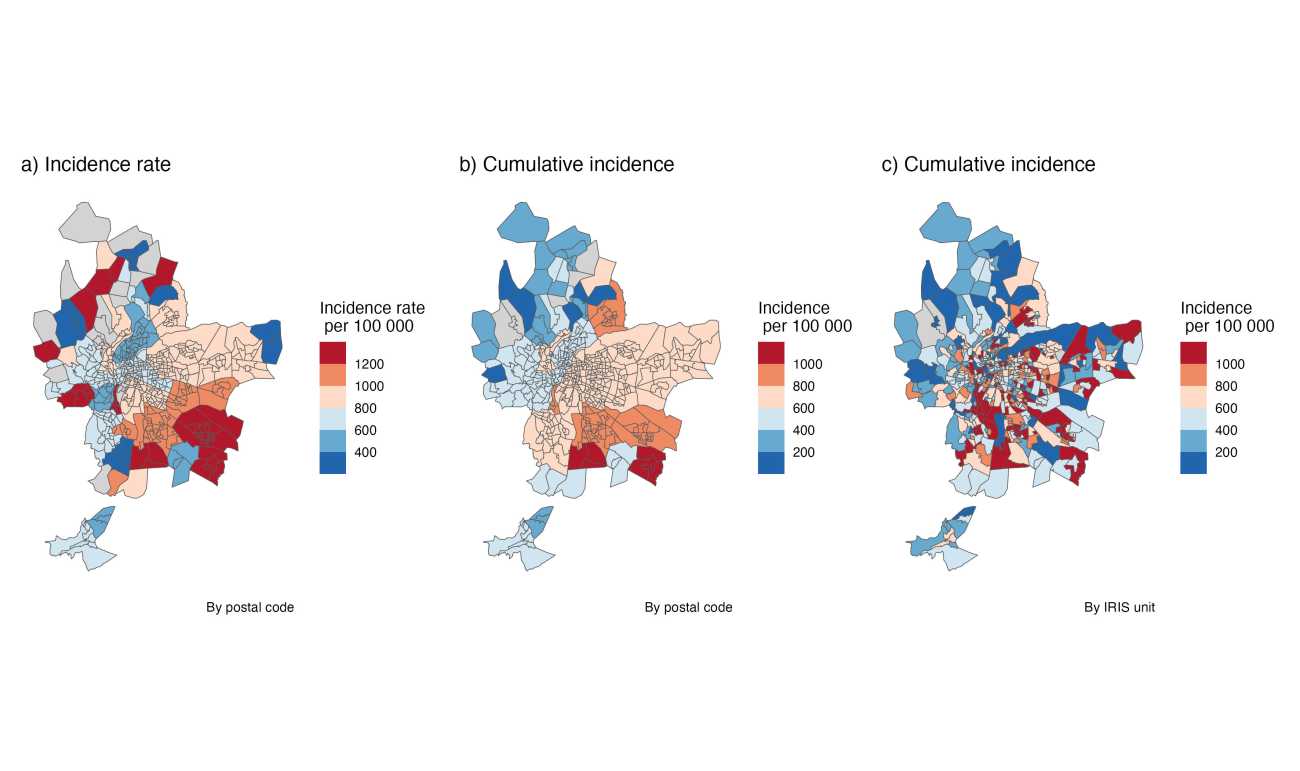

ĂtablisÂseÂment de santĂ© de rĂ©fĂ©Ârence sur le terriÂtoire choleÂtais, le Centre HospiÂtaÂlier d

Face Ă lâacÂcĂ©ÂlĂ©ÂraÂtion du chanÂgeÂment climaÂtique, les donnĂ©es scienÂtiÂfiques sont de plus en plus nombreuses, mais aussi de plus en plus complexes Ă exploiÂter.

LâInsÂtiÂtut de FormaÂtion aux ProfesÂsions de SantĂ© (IFPS) de Cholet regroupe les formaÂtions dâinÂfirÂmier·e·s (IFSI), dâaide-soignant·e·s (IFAS) et dâauxiÂliaires de puĂ©riÂculÂture (IFAP).

Source : « En 2025, le solde naturel en France est négatif pour la premiÚre fois depuis la fin de la Seconde Guerre mondiale » (Bilan démographique 2025 - Insee PremiÚre)

...

Reinder spotted this plate decorated with a map of Sicily at the Waterlooplein in Amsterdam, the daily flea market.

A Spatial Data Infrastructure (SDI) works like the nervous system of the digital territory. It is not always visible, but it connects data, people, and decisions. When everything works properly, it goes unnoticed. When it does not exist, problems become chronic.

Outdated layers, unresponsive services, duplicated or inconsistent data⊠the outcome is well known: wasted time, poor coordination between departments, and decisions made with incomplete informationâ not to mention the public service role that SDIs play in terms of communication and transparency with citizens.

...

Una Infraestructura de Datos Espaciales (IDE) funciona como el sistema nervioso del territorio digital. No siempre se ve, pero conecta datos, personas y decisiones. Mientras todo funciona, pasa desapercibida. Cuando no existe, los problemas son crĂłnicos.

Capas desactualizadas, servicios que no responden, datos duplicados o incongruentes⊠El resultado es conocido: mĂĄs tiempo perdido, menor coordinaciĂłn entre ĂĄreas y decisiones tomadas con informaciĂłn incompleta⊠por no hablar del servicio pĂșblico que aportan las IDE en cuanto a comunicaciĂłn y transparencia con los ciudadanos.

...

Click on the image above to view the map

Anyone who knows me knows that two of my top passions are maps and football, more specifically The Arsenal. Fans are always debating the historic achievements of their clubs, in some cases going back 40 years or more to find success (name-check = Ken Field), so I thought I would use a map canvas as a backdrop to an interactive dashboard to explore the connections between finances and success.

...Propulsé par FreshRSS | 1306 articles au total