Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

4770 éléments (3 non lus) dans 55 canaux

Du côté des éditeurs

(1 non lus)

Du côté des éditeurs

(1 non lus)

Toile géomatique francophone

(2 non lus)

Toile géomatique francophone

(2 non lus)

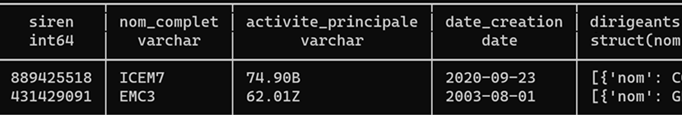

Icem7

-

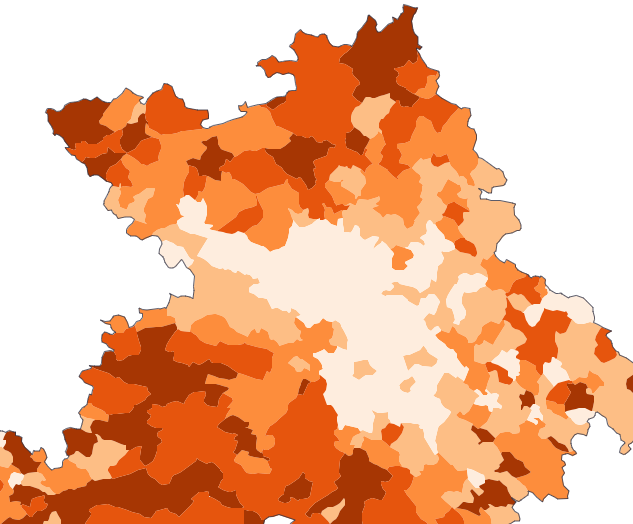

sur La discrétisation “Head/tail” produit des cartes mieux hiérarchisées

Publié: 15 October 2024, 12:00pm CEST par Éric Mauvière

Deux exigences opposées tiraillent le cartographe : schématiser pour mieux imprimer les messages essentiels, ou délivrer le maximum de détails, tant que l’image le permet. Ces exigences ne sont pas forcément contradictoires.

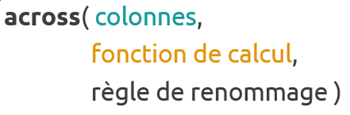

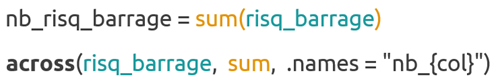

En cartographie thématique, l’art de la coloration repose d’abord sur le découpage en classes, ce que l’on appelle discrétiser. Les bons logiciels proposent plusieurs méthodes automatiques : quantiles, intervalles égaux et Jenks (ou seuils naturels) sont les plus fréquentes.

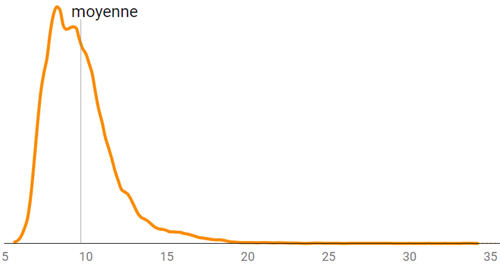

La discrétisation Head/tail, proposée en 2013 par le géographe Bin Jiang, et récemment mise en lumière en France par Thomas Ansart dessine fort bien les données hiérarchisées, dont la distribution dissymétrique comprend typiquement beaucoup de petites valeurs et quelques valeurs élevées. C’est le cas par exemple de la population des communes, des revenus moyens, ou des loyers.

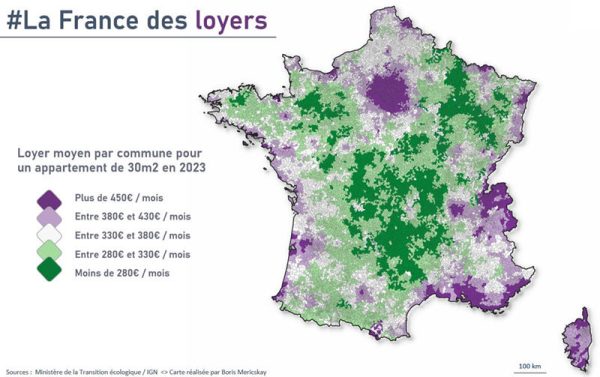

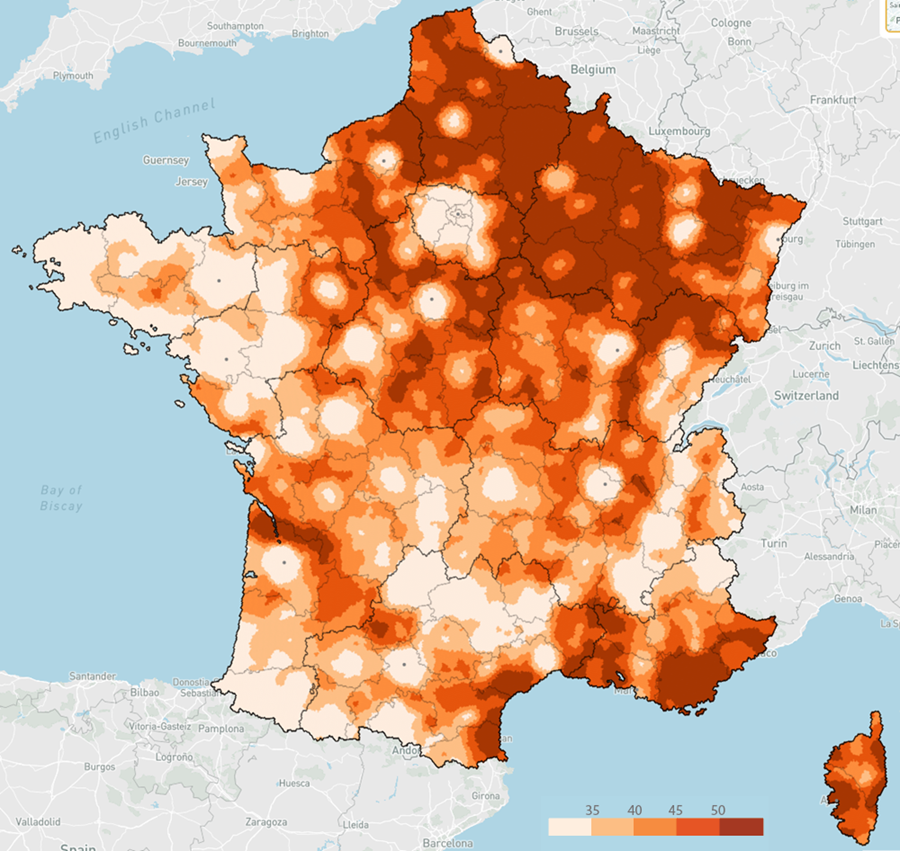

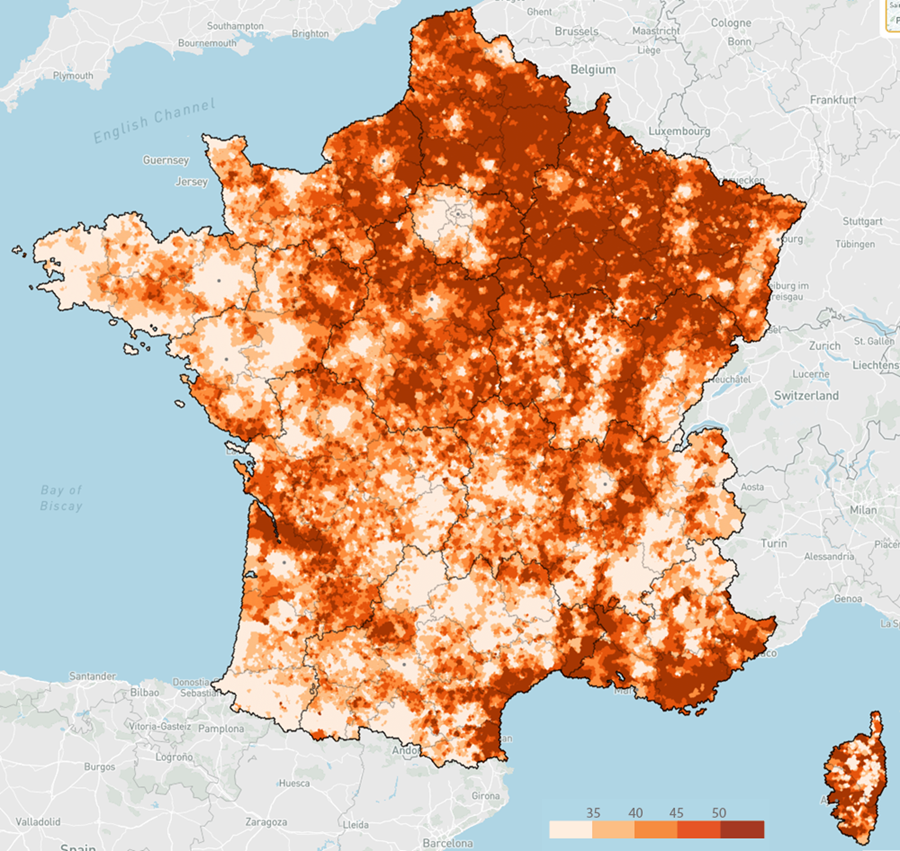

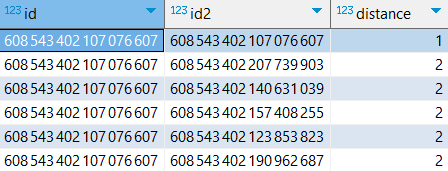

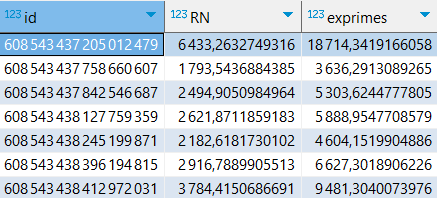

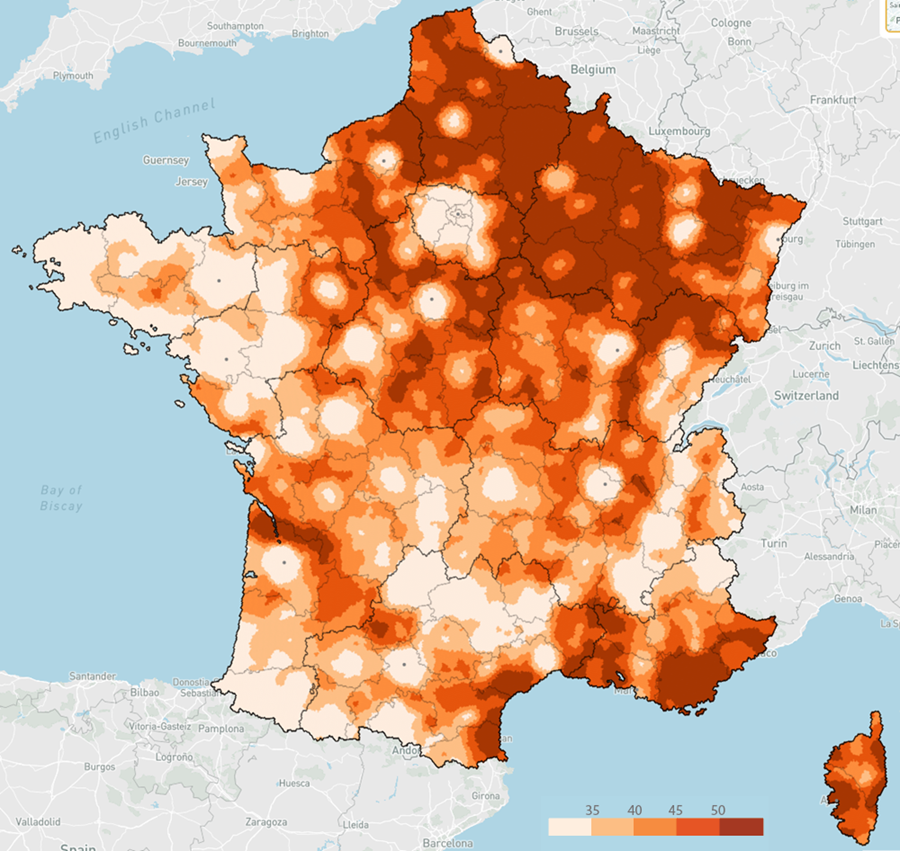

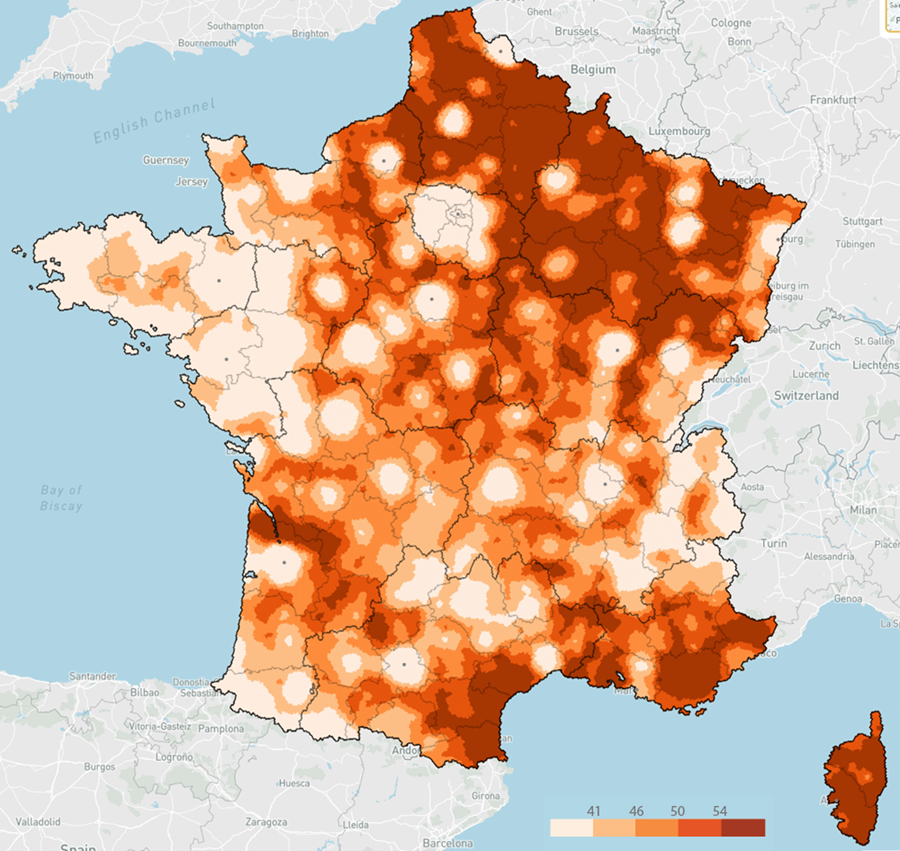

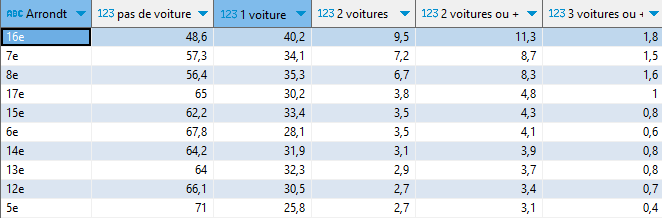

Voici une première illustration, avec le coût par m² du loyer mensuel des appartements par commune et arrondissement en France, en 2023.

Source : ministère de la Transition écologique – Cliquez pour zoomerHead/tail à gauche prend la moyenne comme premier seuil, considère les données supérieures (head), puis calcule de façon itérative des moyennes emboitées.

La méthode de Jenks est également itérative. Elle délimite x groupes les plus homogènes possibles, et en même temps les plus distincts les uns des autres. Elle est proche dans l’esprit de la méthode des K-moyennes.

Ces différentes méthodes aspirent à déterminer des « seuils naturels », des ruptures inhérentes aux données plutôt qu’imposées de l’extérieur par des intervalles égaux ou des effectifs égaux (quantiles). Elles sont puissantes et complémentaires.

Head/tail assume de simplifier drastiquement la représentation en neutralisant la première partie de la distribution, celle sous la moyenne (le tail). Ce qui permet de mieux dégager la hiérarchie des valeurs supérieures à la moyenne (head).

J’aime beaucoup ce rendu plus doux, moins agressif, tout en nuances, en particulier pour les loyers dans le bassin parisien. La structure hiérarchique que cette carte dessine, avec une belle séparation de l’avant-plan et de l’arrière-plan, s’imprimera plus durablement dans mon esprit.

Comparons aussi avec cette version (je suppose par quantile), palette divergente, de Boris Mericskay, avec des données de même origine. L’opposition vert/violet a le mérite de simplifier fortement l’information, divisant la France en deux ou trois, autour d’une classe centrale, d’une moyenne supposée faire sens.

Mais quand la distribution est déséquilibrée comme celle des loyers, une représentation symétrique est moins pertinente. Par exemple, une très faible variation du 1er seuil, intervenant dans la pente abrupte du début de la distribution, fera basculer beaucoup de communes d’une classe verte à l’autre, avec un effet violent sur la répartition colorée des deux premières classes. Et le vert foncé n’est pas le symétrique du violet foncé, il ne traduit pas le même écart à la moyenne.

Distribution du loyer des appartements en France (en € par m²) en 2023

Distribution du loyer des appartements en France (en € par m²) en 2023

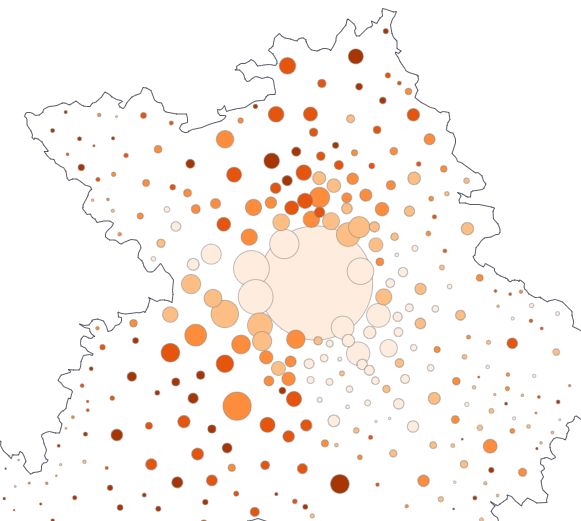

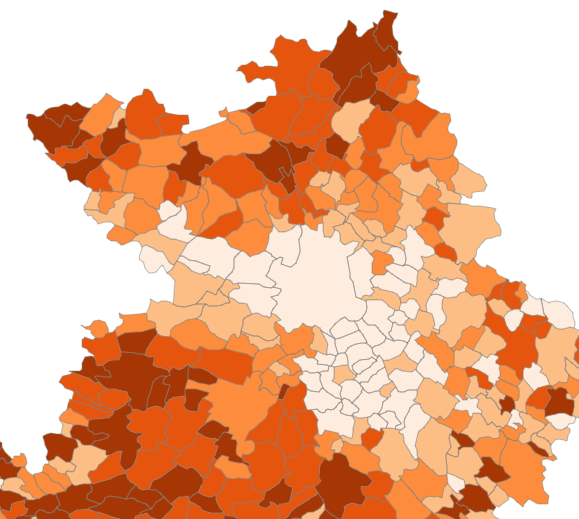

Voici 3 autres illustrations statistiques et cartographiques de l’intérêt de la méthode Head/tail, appliquée toujours à des distributions dissymétriques, avec beaucoup de petites valeurs et peu de grandes valeurs.

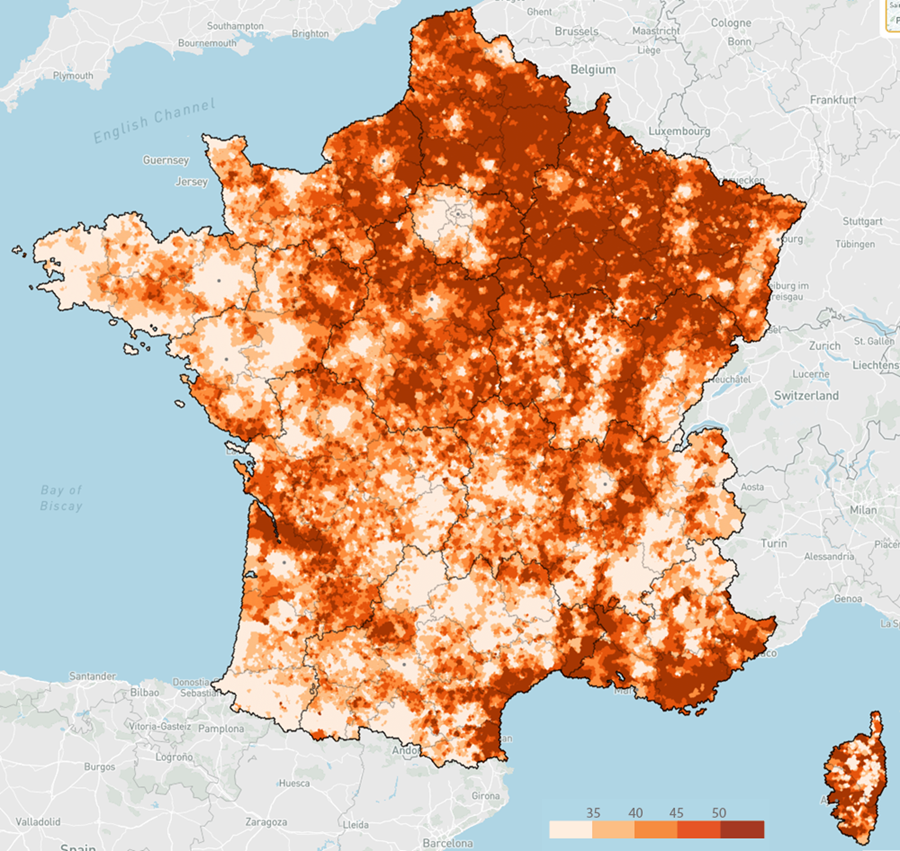

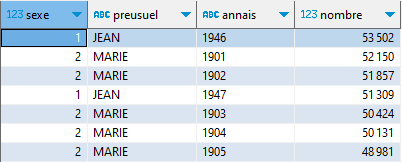

1 – La densité de population (2021) – source Insee

Avec Head/tail, Paris, puis Lyon, sont distinguées du groupe des autres villes moyennes (Toulouse, Bordeaux, Nantes, Nice, etc.).

2 – La médiane du niveau de vie (2021) – source Insee

La frontière suisse, une partie de la frontière luxembourgeoise, l’ouest de l’Île-de-France et le sud de l’Oise sautent davantage aux yeux, du fait d’un meilleur contraste.

3 – La part des diplômés d’un BAC+5 ou plus dans la pop. non scolarisée de 15 ans ou plus (2021)

Pour un plus large usage de Head/tail

– source InseeBin Jiang rappelle que dans la nature, le monde du vivant, les organisations humaines, les phénomènes observés se présentent rarement sous forme d’une distribution symétrique autour d’une « moyenne ». Il y a en général plus de petites valeurs que de grandes.

Mais la hiérarchie déroulée à partir des grandes valeurs est ce qui frappe tout d’abord l’esprit, ce qui donne une première idée d’une structure d’ensemble : hiérarchie des villes, des longueurs de rues dans une ville, des entreprises dans un secteur donné, des intensités de tremblements de terre, de répartition des richesses, de popularité des sites web, de fréquence des mots dans un texte, etc.

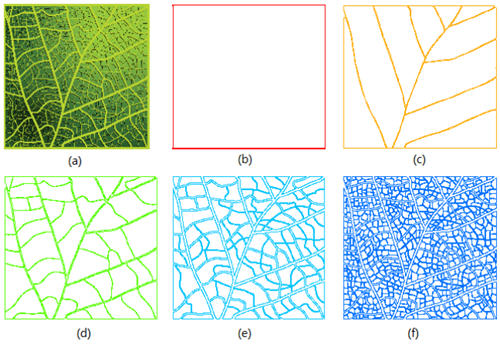

Ou les niveaux successifs d’organisation d’une feuille, de ses nervures :

Une feuille (a) décomposée en 5 niveaux d'organisation, jusqu'au réseau le plus fin de ses nervures - Source : Jiang, 2020

Une feuille (a) décomposée en 5 niveaux d'organisation, jusqu'au réseau le plus fin de ses nervures - Source : Jiang, 2020

Pour employer un langage plus technique, les phénomènes naturels ou géographiques sont peu souvent gaussiens (symétriques), plus souvent « paretiens » (de Pareto et sa fameuse loi des 80/20 – 20 % des causes expliquent 80 % des effets), ou « log-normaux » (leur logarithme est gaussien).

Pour Jiang, le nombre de seuils calculés par la méthode Head/tail (dénommé ht index) est un indicateur de la profondeur organisationnelle du phénomène étudié (il le rapproche même du concept de dimension fractale, posé par Benoît Mandelbrot).

Pour une distribution symétrique, idéale, quasi-gaussienne, le ht index sera souvent faible, 2 par exemple. À l’inverse, un ht-index > 5 caractérisera un phénomène étagé, où parfois même, d’un niveau à l’autre, l’on retrouve les mêmes rapports d’échelle.

Description de l'algorithme Head/TailPour découvrir l’algorithme en action (JavaScript et SQL/DuckDB), rendez-vous sur ce classeur Observable.

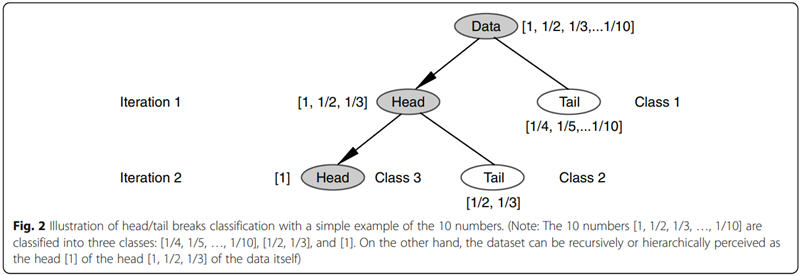

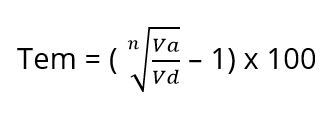

Considérons par exemple 10 nombres [1, 1/2, 1/3…1/10] (ou [1, 0.5, 0.333…0.1]) qui suivent cette règle de proposer plus de petites valeurs que de grandes.

La somme de cette série fait 2,93, la moyenne 0,293. 1, 1/2 et 1/3 lui sont supérieurs.

Si l’on divise la série en deux morceaux autour de la moyenne (« Head » au-dessus, « Tail » en dessous), on obtient donc l’itération 1 de cette figure :

Source : Bin Jiang - A new approach to detecting and designing living structure of urban environments

Source : Bin Jiang - A new approach to detecting and designing living structure of urban environments

L’algorithme Head/tail itère jusqu’à ce que cette division par la moyenne s’arrête, par exemple parce que le dernier « head » n’a plus qu’un élément ; ou que le dernier « head » a un effectif supérieur à son « tail », signe que la division n’est plus pertinente.

Head/tail fournit une alternative à la méthode de discrétisation de Jenks, bien plus rapide à calculer et, pour son concepteur, mieux apte à rendre compte d’une hiérarchie, d’une structure fractale, caractéristique fréquemment rencontrée dans la nature et le « vivant ».

Pour rappel, la méthode de Jenks – dite aussi des « seuils naturels » – conduit à délimiter x groupes les plus homogènes possibles, et en même temps les plus distincts les uns des autres. x est un paramètre fourni à l’algorithme de Jenks. Cet algorithme est de complexité O(n2), c’est-à-dire que son coût est proportionnel au carré de l’effectif de la distribution à classifier ; il devient difficile à calculer en JavaScript quand n dépasse 10 000 observations.

À l’inverse, la méthode Head/tail est de complexité O(n), et s’exécute en moins d’une seconde avec plusieurs millions d’observations. De plus, elle détermine – intelligemment – son propre nombre de classes, indicateur de la profondeur de la hiérarchie détectée (nombre que l’on peut toutefois réduire en ne retenant que les x premiers seuils).

Pour aller plus loin- Page Wikipedia avec une liste d’implémentations dans divers langages (R, Python…)

- Jiang, B. (2013). « Head/tail breaks: A new classification scheme for data with a heavy-tailed distribution », The Professional Geographer, 65 (3), 482 – 494.

- Jiang, B. (2019). « A recursive definition of goodness of space for bridging the concepts of space and place for sustainability ». Sustainability, 11(15), 4091.

- Jiang, B. (2013) Geospatial Analysis Requires a Different Way of Thinking: The Problem of Spatial Heterogeneity

- Denise Pumain, Hierarchy in Natural and Social Sciences, Springer, 2006

- Thomas Ansart, Atelier de cartographie de Sciences-Po. Head/Tail breaks

- Éric Mauvière, classeur Observable Head/tail breaks

- L’outil Magrit et la librairie JS statsbreaks supportent Head/Tail

- Jean de La Fontaine, La tête et la queue du Serpent

L’article La discrétisation « Head/tail » produit des cartes mieux hiérarchisées est apparu en premier sur Icem7.

-

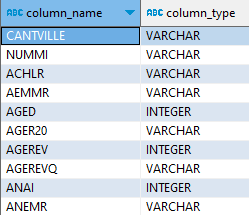

sur Barres empilées : comment s’en débarrasser ?

Publié: 1 September 2024, 1:10pm CEST par Éric Mauvière

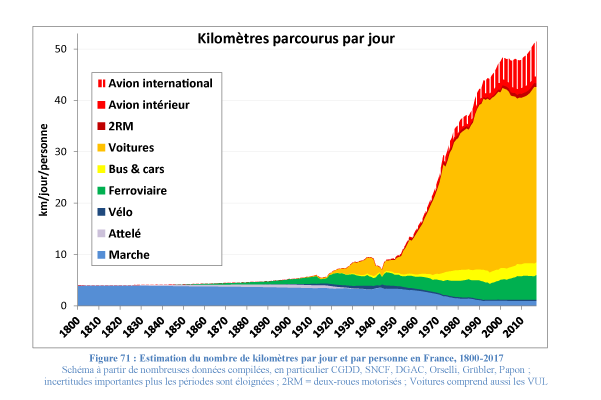

C’est l’un des graphiques les plus utilisés dans la production statistique française, mais aussi le plus paresseux et le moins efficace pour comprendre et surtout mémoriser. La plupart des responsables éditoriaux le savent, formés qu’ils/elles le sont à la sémiologie graphique. Pour autant, pas moyen de remiser ces empilements : ils collent aux publications statistiques comme le sparadrap au capitaine Haddock !

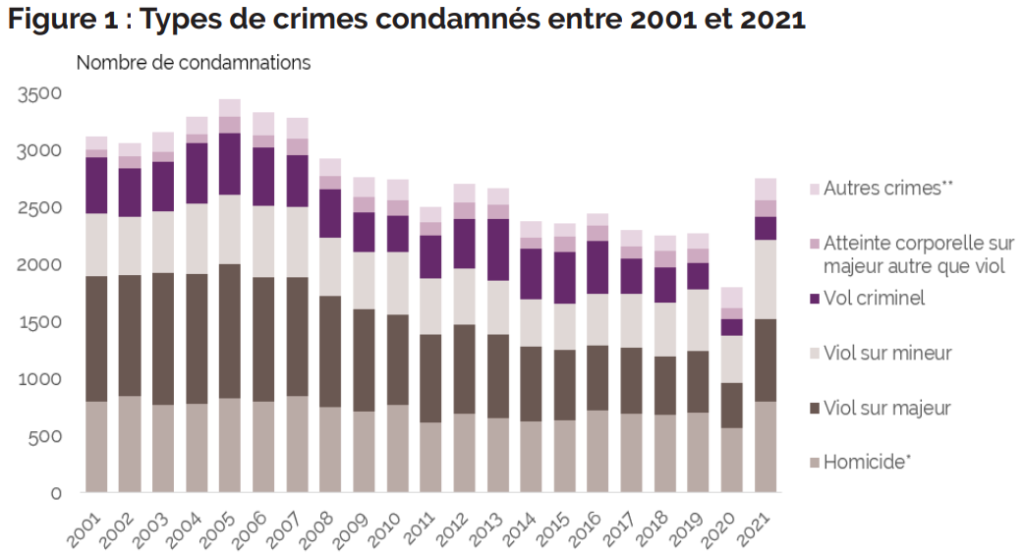

Prenons comme premier exemple ce graphique sur l’évolution des crimes en France, classés par type. Le diagramme en barres empilées traduit tel quel le tableau croisé des données, y intégrant un total. Et c’est la principale raison de son emploi : on voit en même temps l’évolution d’ensemble et le détail des catégories.

Source : ministère de la Justice/SG/SEM/SDSE, fichier statistique Casier judiciaire national

Source : ministère de la Justice/SG/SEM/SDSE, fichier statistique Casier judiciaire national

Si l’on voit bien le mouvement général, il est plus difficile d’apprécier les détails, d’analyser la morphologie de ces rectangles colorés. Quand la base d’une série est horizontale, par exemple celle des homicides en bas, il suffit d’en suivre visuellement les sommets. Mais quand les segments flottent, le lecteur doit mener deux opérations mentales exigeantes – extraire visuellement la série et la recaler sur une base commune. Cet effort à répéter fatigue et complique la mémorisation, faute d’images prêtes à photographier mentalement.

Comment ordonner les catégories, choisir les couleurs ? « Autres crimes » est la première catégorie que l’œil rencontre, c’est aussi la moins signifiante. Et la palette adoptée crée deux groupes artificiels, un en violet et l’autre en gris.

Que va-t-on retenir d’une telle image ? Au mieux, oubliant les catégories, une tendance globale à la baisse avant la crise du covid, et une reprise post-covid qui ressemble à un rattrapage – dont on ne sait s’il est réel ou purement administratif (du fait d’instructions retardées).

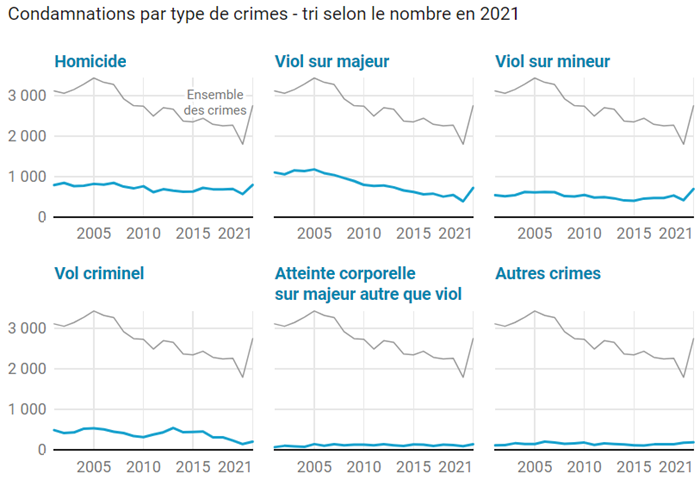

Distinguons chaque série dans une collection de petits graphiques triés et catégorisésAvec un outil soucieux de sémiologie comme Datawrapper (ou Flourish), testons une variante où chaque composante peut apparaitre séparément, la comparaison avec l’évolution d’ensemble restant possible.

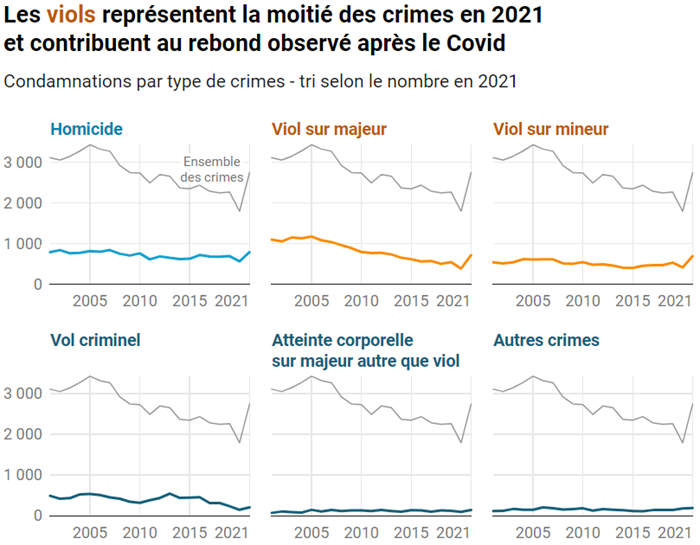

Retenons le même ordre de tri que le graphique d’origine, par effectifs finaux décroissants. Cette nouvelle construction graphique présente d’abord les trois catégories les plus importantes. Elles ont en commun de bien marquer l’effet de rattrapage précédemment évoqué. L’importance des viols est manifeste. Un rapide calcul visuel montre qu’ils représentent au total la moitié des crimes. Ce constat m’a particulièrement frappé.

Je le souligne donc, dans cet affinage prêt à diffuser, à l’aide d’une couleur différente et d’un titre qui reprend deux informations majeures.

Ces petits graphiques sont évidents et élégants, avec leurs axes épurés dont les étiquettes sont davantage conformes aux règles de lisibilité (écriture horizontale pour les années, séparateur des milliers pour les effectifs).

Un bon graphique présente toutes les données et dégage une ou quelques images simples (par exemple les trois graphiques de la première rangée), que le lecteur pourra relier à des enseignements verbalisés. Il les mémorisera ainsi durablement, grâce à la puissante association entre le visuel et le sémantique, quand ces deux canaux résonnent en cohérence.

C’est le mantra cher à Jacques Bertin, le grand sémiologue français : trier judicieusement ce qui peut l’être, puis catégoriser pour hiérarchiser les niveaux d’information.

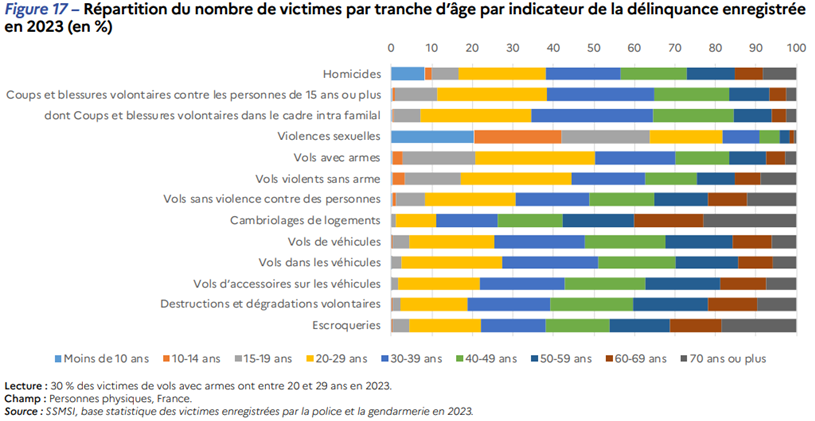

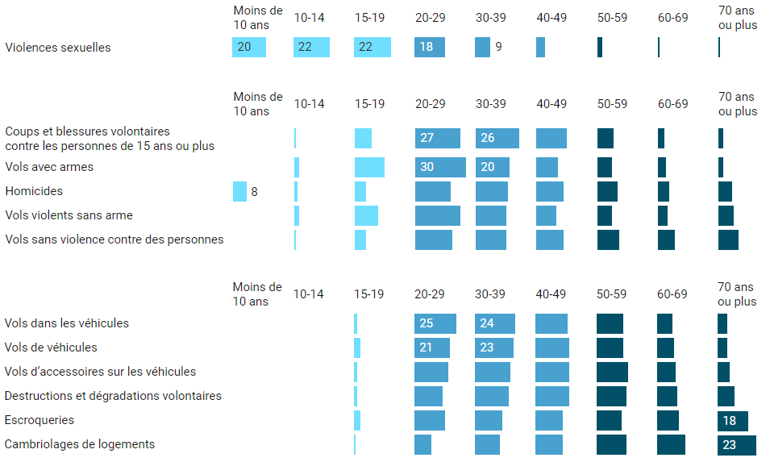

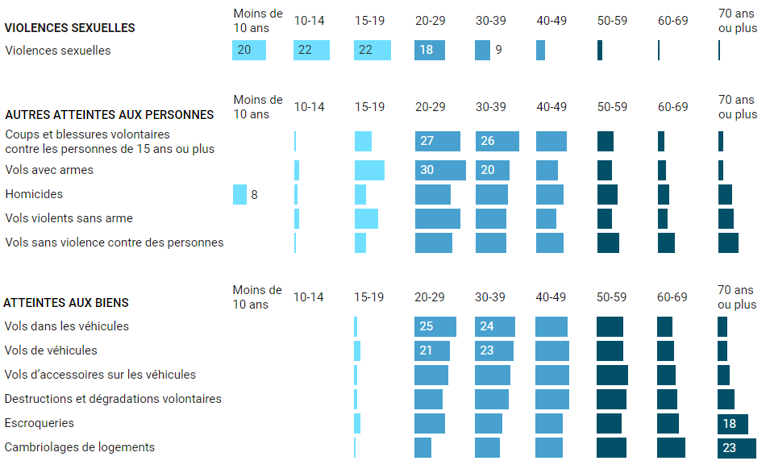

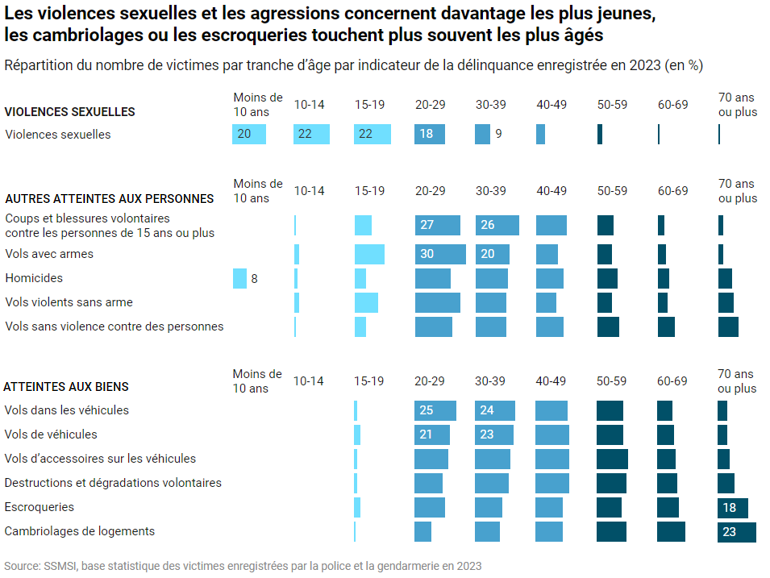

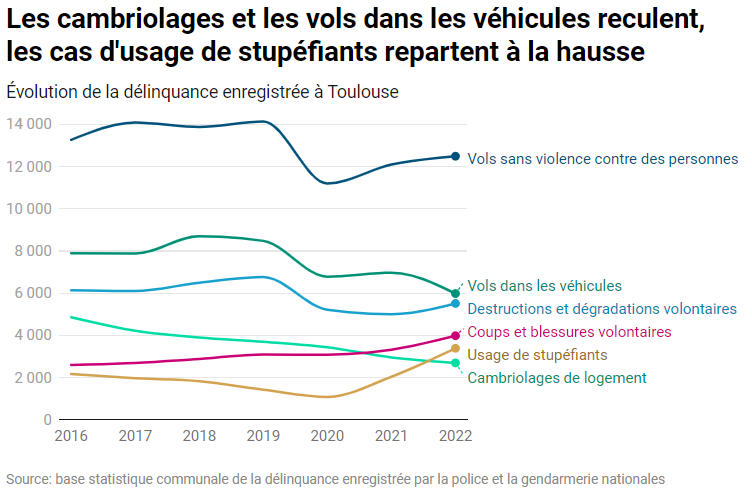

Étendons la démarche à un jeu de données plus fourniIssu d’une source différente, ce nouveau diagramme empilé traite d’un sujet voisin, les actes de délinquance, en regardant plutôt les victimes et ce à quoi elles sont sujettes selon leur âge. La dimension de l’âge, en X dans ce diagramme, est ordonnée de façon logique, croissante.

Mais qu’en est-il des indicateurs de délinquance ? L’auteur ne précise pas le critère de tri en Y et l’œil du lecteur n’en saisit pas la logique. Renforcée par les contrastes lumineux, l‘impression d’ensemble est bruitée et inconfortable.

Par ailleurs, la palette de couleur n’est pas ordonnée, elle n’exprime pas la progression des âges. Le lecteur peinera à regrouper visuellement des tranches voisines.

La construction suivante utilise une palette visuellement ordonnée, désempile les barres, et reclasse les faits de délinquance pour construire l’image la plus pure, la plus significative – perceptible dans l’instant minimal de vision, selon les vœux de Bertin. Une telle image, comme il l’exprime dans sa « Sémiologie graphique », tend vers deux critères topologiques : connexité (peu ou pas de trous, une forme ramassée) et convexité (enveloppe plutôt ronde). Idéalement, une belle diagonalisation !

Un bon outil graphique facilitera les reclassements. Après quelques essais, la tranche des 70 ans et plus fournit un bon critère de départ pour un tri. L’examen conjoint des tranches les plus jeunes m’amène à définir trois groupes. Ce nouveau graphique déroule une vague expressive.

Il faut se faire violence, parfois, pour chambouler l’ordre par défaut des nomenclatures. Bertin l’évoquait malicieusement, dans un dernier article, témoignant de sa longue – et fructueuse – expérience de collaboration avec la statistique publique : « À l’école de l’Insee, reclasser un tableau de données était une abomination ! ».

Le geste suivant, encore plus audacieux pour le statisticien, consiste à nommer ces groupes, dès lors qu’il saisit ce qui les caractérise.

Un titre informatif s’en déduit naturellement. C’est l’association entre messages de premier niveau clairs et une forme d’ensemble simple et significative qui va consolider l’inscription en mémoire de la hiérarchie des enseignements.

Pourquoi la plupart des graphiques statistiques sont-ils paresseux ?

Pourquoi la plupart des graphiques statistiques sont-ils paresseux ?

Certes, la puissance de la sémiologie graphique n’est pas suffisamment exprimée et enseignée, que ce soit à l’école ou en formation continue. Au pays de Bertin, c’est pour le moins étonnant, voire dissonant. À cela, les responsables d’enseignement ou de services statistiques peuvent facilement remédier, si ils/elles le souhaitent – et même si cela prend un peu de temps

.

. Mais ce déficit renvoie plus fondamentalement à la posture de l’analyste, au rôle qu’il/elle se donne ou qu’on lui donne : mettre à disposition des chiffres solides et laisser au lecteur le soin de les interpréter ?

Ou chercher en plus à transmettre, avec les outils de la sémiologie graphique, ce que soi-même, avec son expertise, sa curiosité, sa déontologie, on a fini par retirer de ses multiples explorations. C’est la voie que, pour ma part, j’approfondis comme rédacteur d’articles, et enseigne en formations sur mesure.

Pour en savoir plus- Près de 750 condamnations par an pour homicide homicide volontaire et coups mortels – Infostat Justice n° 191

- Insécurité et délinquance en 2023, une première photographie – Interstats Analyse n° 64

- Sémiologie graphique, Jacques Bertin, 1967

- Aux origines de la sémiologie graphique, Jacques Bertin, CFC 2004

L’article Barres empilées : comment s’en débarrasser ? est apparu en premier sur Icem7.

-

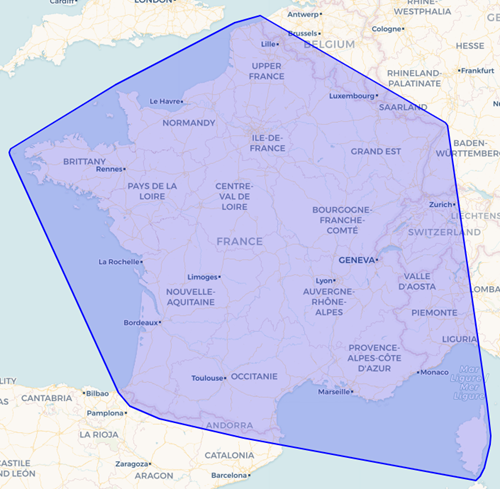

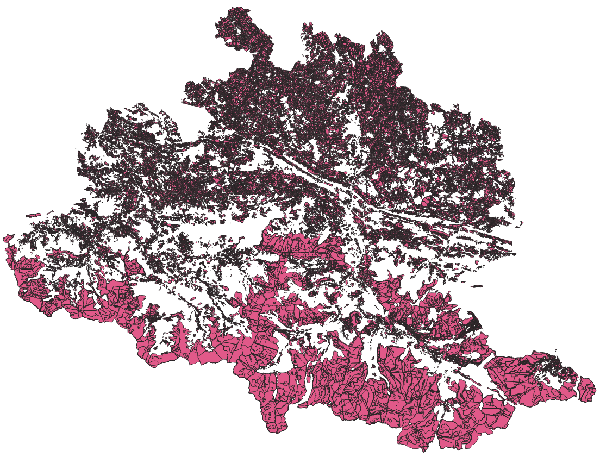

sur Les lignes de force du vote RN en 2024 : une cartographie lissée avec la grille H3

Publié: 11 July 2024, 3:44am CEST par Éric Mauvière

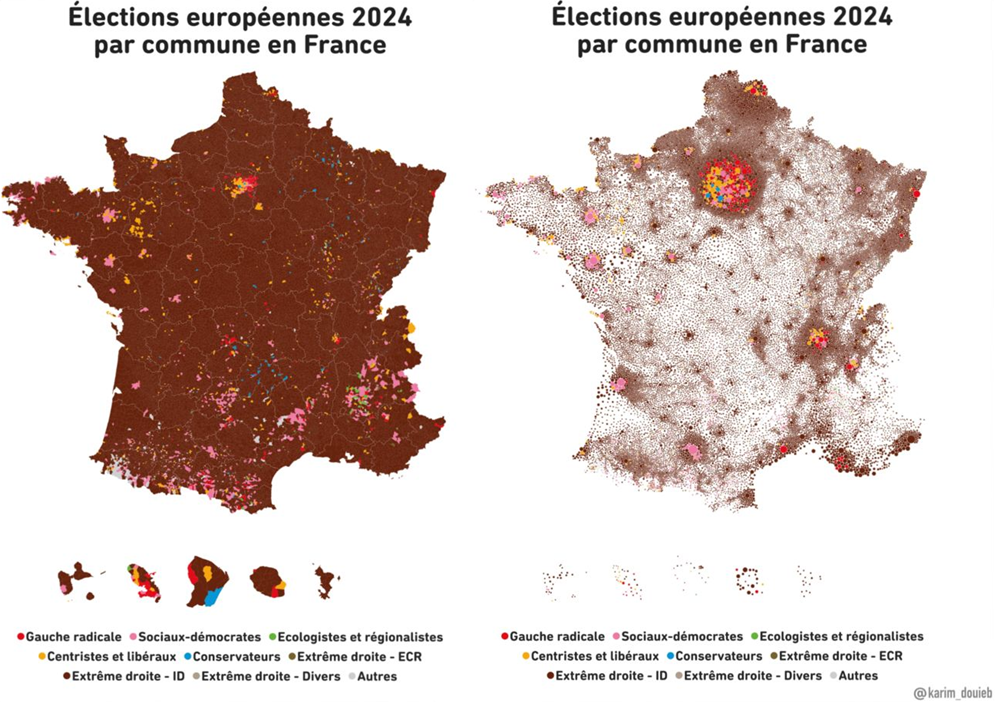

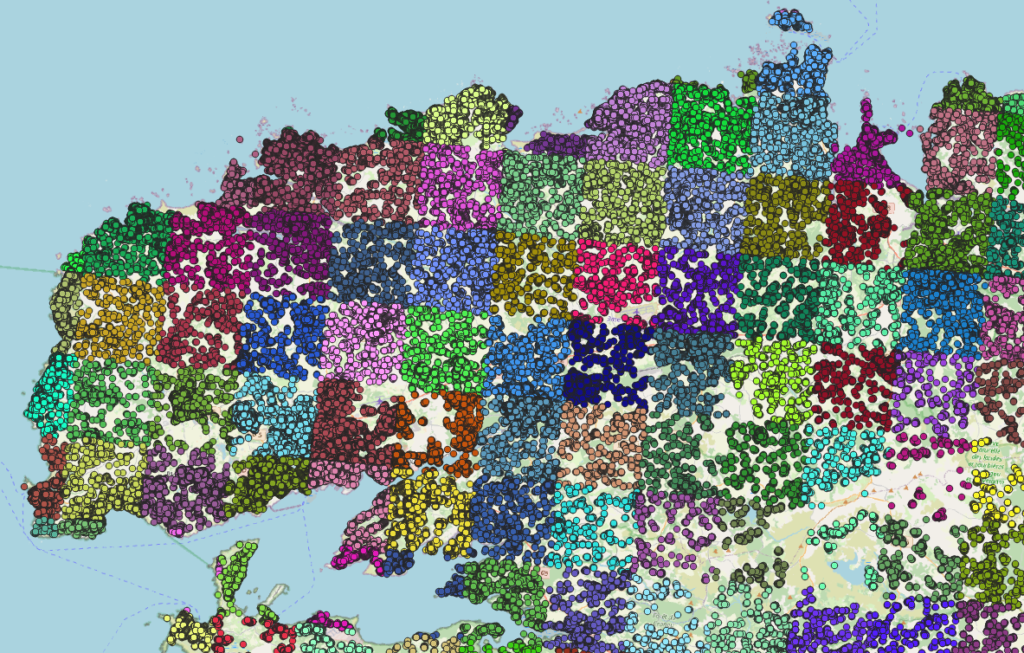

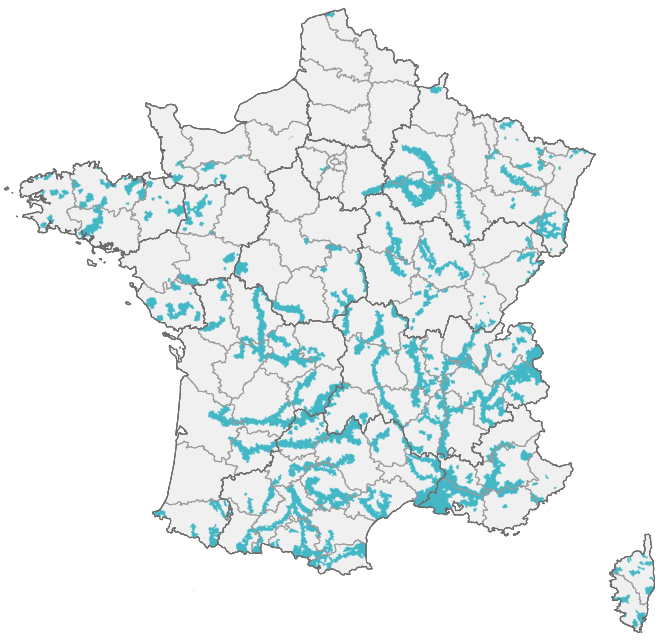

Les résultats des dernières élections françaises sont maintenant disponibles à un niveau fin, à la commune et même jusqu’au bureau de vote. Mais comment produire une cartographie lisible et synthétique à partir de données si détaillées ?

Ce travail récent de Karim Douïeb, largement repris, illustre bien le dilemme : il dénonce le caractère trompeur de la carte (choroplèthe) de gauche et propose à la place la variante (à symboles) de droite.

Les cartes choroplèthes sont faciles à lire avec leur coloration continue de tout le territoire. Mais l’œil voit seulement des surfaces, il ne peut faire le tri entre les territoires plus peuplés et les moins peuplés.

Les cartes à pastilles proportionnelles rendent mieux compte des populations en présence, mais les petits ronds se voient peu, ou alors coagulent en amas artificiels là où le maillage communal est très serré (par exemple dans les Hautes-Pyrénées, voisines des Landes où c’est l’inverse). Les cartogrammes qui distordent la géographie pour prévenir les superpositions accentuent souvent ces artefacts.

Une autre voie respecte la géographie, préserve la continuité de l’image et prend en compte les différences de population : celle où le résultat d’un candidat (part en %) est lissé par disques mobiles.

Les spécialistes des études locales la connaissent depuis longtemps – je la pratique depuis 35 ans. Certes, les calculs requis par le lissage en limitent l’usage, même avec des librairies spécialisées. Il est toutefois possible en 2024 de construire simplement de solides cartes lissées, sans logiciel lourd.

Voyons comment faire avec 3 petits bijoux d’efficacité : un moteur SQL autonome (DBeaver/DuckDB), une grille hexagonale (H3) et un outil de cartographie web (Mapshaper).

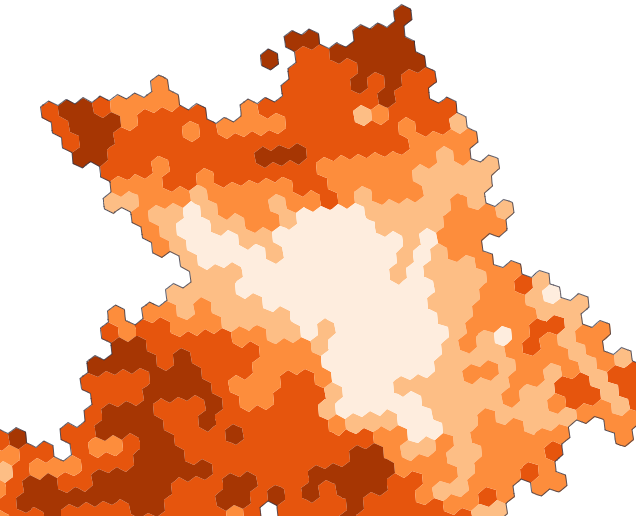

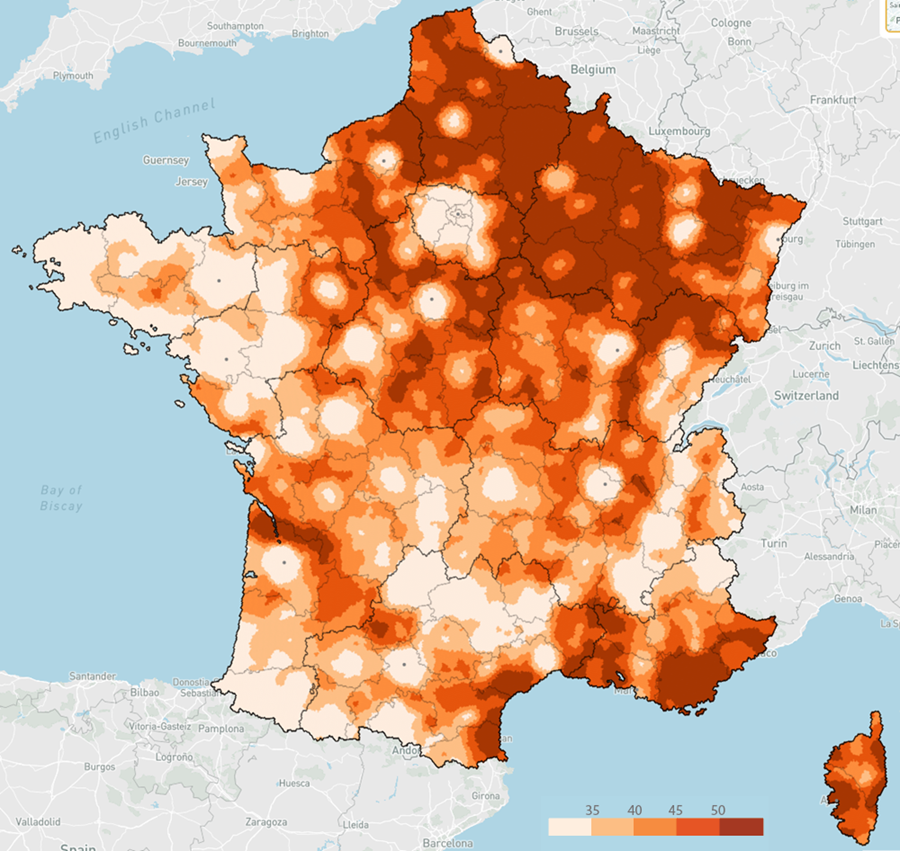

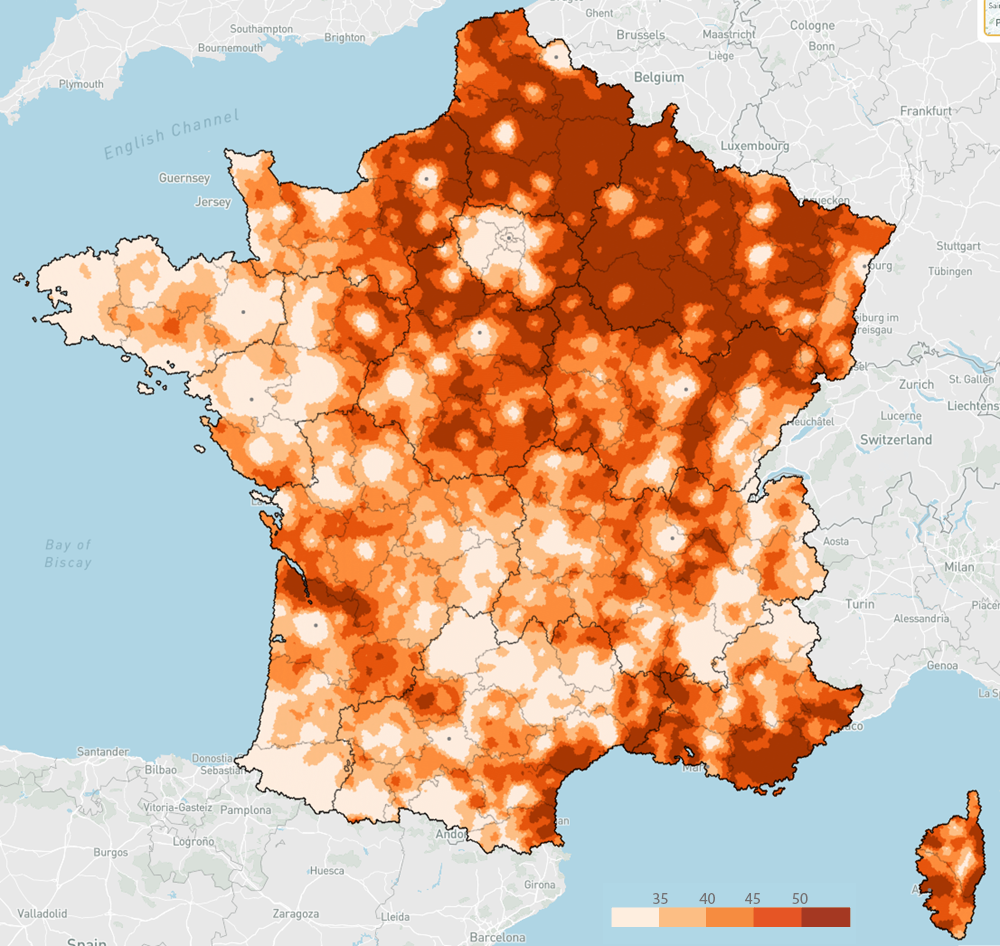

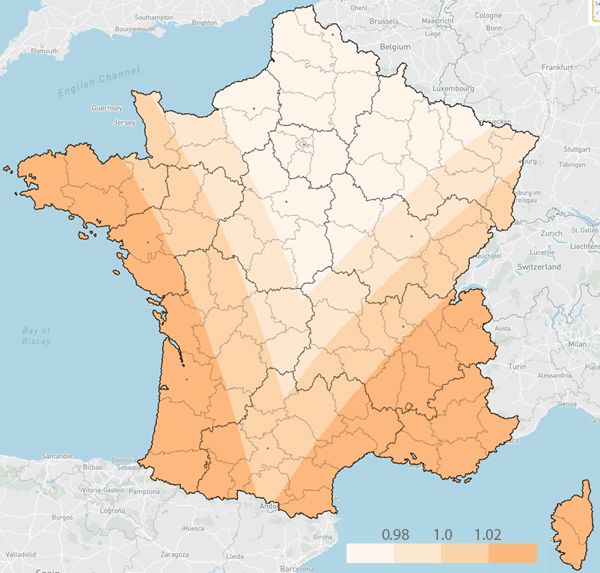

A - Lissage appliqué aux résultats communaux des européennes de 2024Comparons ci-dessous les résultats bruts des élections européennes et la représentation lissée par disque mobile. Le lissage améliore spectaculairement la lisibilité de l’image.

Européennes 2024 – Part des votes RN et Reconquête (%)

Lissé

Lissé

Brut

Brut

Les grandes agglomérations éloignent le vote RNR, mais cet effet est moins visible dans un grand Nord-Est ou sur le littoral méditerranéen. Quelques contrastes locaux sont frappants, par exemple entre le Lot et Tarn-et-Garonne, ou l’agglomération bordelaise et sa frange nord.

Note : les petits points gris signalent les capitales régionales.Comme le pinceau de l’archéologue dépoussière un bas-relief, ou la restauratrice révèle sous les vernis et les taches le tableau originel, le lissage dégage les lignes de force qui traversent les territoires – et bien souvent celles qui résistent au temps et aux soubresauts politiques.

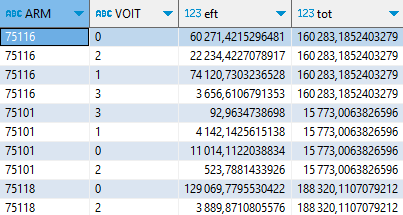

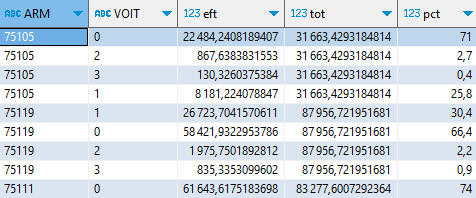

Je vais décrire la méthode, car en saisir le principe, c’est mieux comprendre les limites et les avantages de cette technique. Le lissage n’est pas une moyenne locale des valeurs communales (ici la part de telle liste). Il repose sur une agrégation de deux grandeurs que l’on va ensuite diviser pour recalculer le taux « ambiant ». Cette agrégation se fait sur une étendue plus ou moins large, le rayon du disque de lissage.

En un endroit donné, on additionne par exemple le nombre de votants RNR au sein d’un rayon de 20 km, et l’on procède de même pour l’ensemble des votants ; le nouveau taux se calcule sur ces deux grandeurs étendues. Ainsi, d’une commune à sa voisine, les taux ambiants vont faiblement varier. Les aléas locaux sont lissés, et les territoires localement plus peuplés contribuent davantage à la représentation.

B - La méthode en imagesConsidérons les deux cartographies traditionnelles du résultat d’une liste, dans notre exemple la part du vote RN et Reconquête (en abrégé, RNR). Sur une carte zoomée, la technique des ronds coloriés a bien des avantages, car les symboles sont tous visibles, leur couleur aussi. Ce mode présente à la fois une grandeur absolue (les votants), et la part du vote RNR.

Ronds

Ronds

Choro

Choro

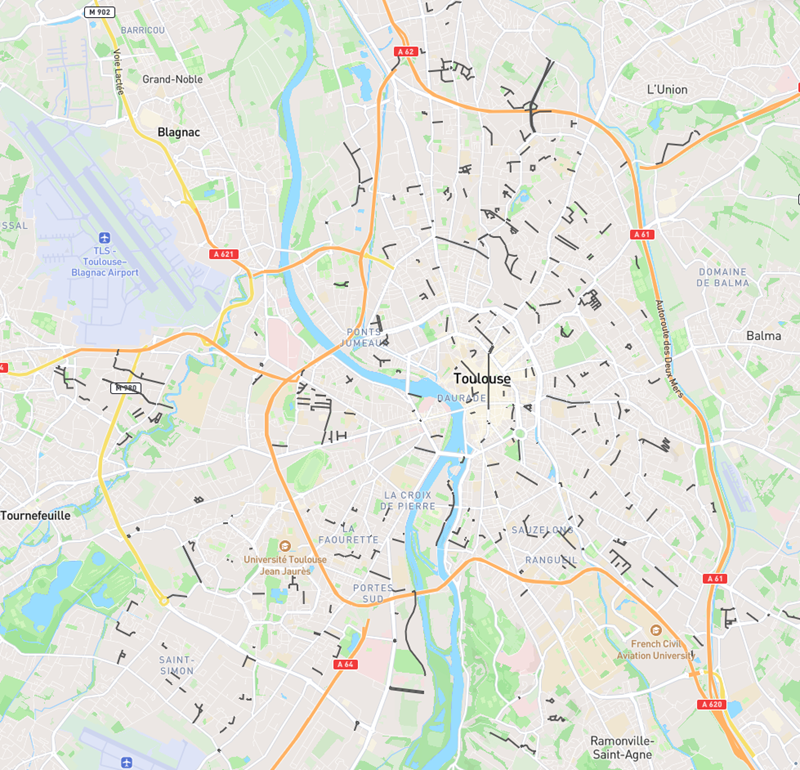

Comme on le constate dans cette vue de la périphérie toulousaine, les communes sont de taille fort variable. Le découpage communal influence fortement la morphologie de l’image. C’est la raison pour laquelle certains politiques s’échinent à redéfinir les maillages électoraux, pour tourner l’addition locale des votes à leur avantage.

Passer d’un maillage hétérogène à une grille régulière donnera une assise plus solide à la méthode de lissage.

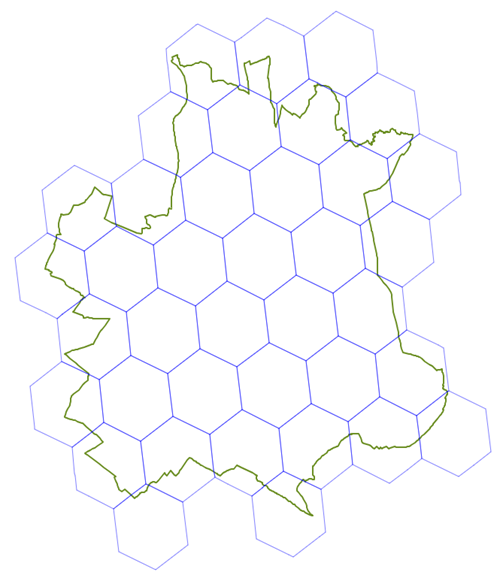

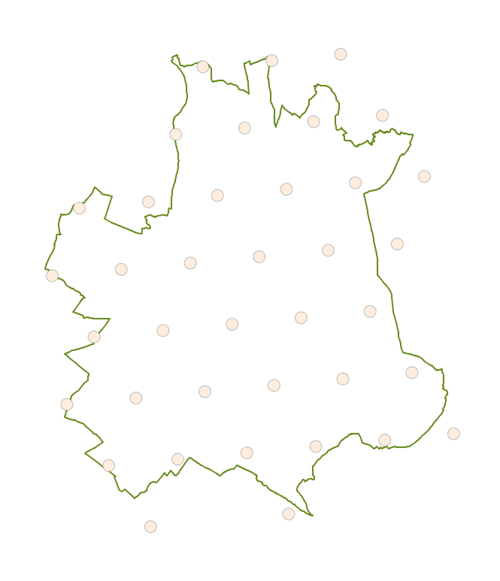

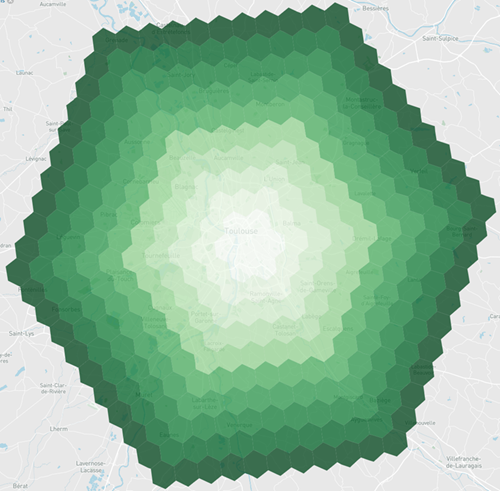

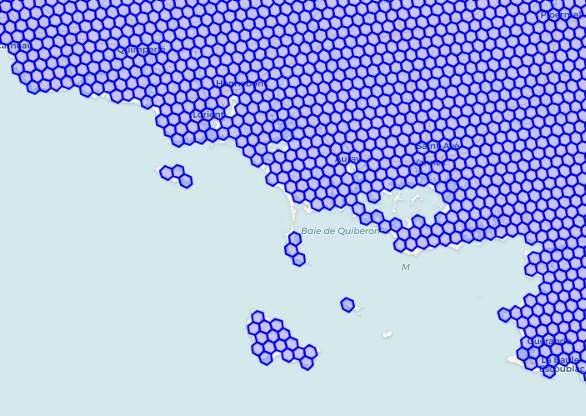

La grille H3, conçue d’abord pour les besoins d’Uber, maille l’ensemble de la planète avec des hexagones. En voici une représentation au niveau de précision 7 (sur une échelle allant de 0 à 15).

38 hexagones de niveau 7 recouvrent la commune de Toulouse. Une première idée consiste à répartir le total des votants à Toulouse de façon égale sur ces 38 hexagones. Je pourrais affiner cette répartition sur les hexagones frontières, par un prorata de la surface intersectée. Mais ce serait me compliquer la vie inutilement, car en définitive, je vais lisser !

Toulouse et les hexagones H3

Grille H3 de niveau 7, intersectant Toulouse

Grille H3 de niveau 7, intersectant Toulouse

Votants à Toulouse répartis fictivement en 38 points

Votants à Toulouse répartis fictivement en 38 points

Les hexagones sur les frontières communales vont ainsi recevoir des votants venus de deux, parfois trois communes limitrophes. Cela produit déjà, de fait, un premier microlissage.

En voici le résultat cartographié, après recalcul du taux pour chaque hexagone.

H3

H3

Brut

Brut

Le principe du lissage par fenêtre mobile est toutefois bien plus puissant. H3 permet très facilement (c’est aussi une librairie avec quantité de fonctions utilitaires) de lister les hexagones voisins, avec un pas variable – de 1 à 10 dans cet exemple :

Avec ce rayon de lissage de 10 (soit un peu plus de 20 km), je m’emploie à additionner, en un centre donné, les votants et les votants RNR sur l’ensemble de ce disque. Je prends garde à donner de moins en moins d’importance aux hexagones qui s’éloignent, par une pondération inverse de la distance au centre.

Mon lissage intègre ainsi deux paramètres d’ajustement : le rayon du disque mobile (en fait un grand hexagone mobile), et la fonction de pondération (quelle importance j’accorde aux hexagones les plus éloignés pour calculer le taux ambiant).

Voici deux cartes, avec des rayons de lissage différents : 5 (soit environ 12 km) et 10 (20-25 km).

++

++

+

C - Comment lisser, en pratique ?

+

C - Comment lisser, en pratique ?

Je conduis les calculs en SQL, avec le moteur DuckDB et son extension H3, dans l’interface DBeaver. DBeaver donne un premier aperçu du résultat des requêtes spatiales, ce qui s’avère très pratique.

Pour la cartographie thématique, Mapshaper, utilisable en ligne, dessine et colorie avec une vélocité remarquable.

Cette démarche procède d’un principe pédagogique auquel je suis attaché : ouvrir des portes pour le plus grand nombre, privilégier les outils les plus simples, les plus accessibles, les mieux conçus.

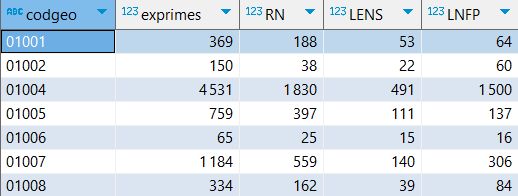

Commençons par récupérer les résultats des européennes 2024, à partir de la base électorale consolidée par l’équipe data.gouv au format parquet :

-- source : [https:] CREATE OR replace TABLE s_com_europ2024 as WITH t1 AS ( FROM 'candidats_results.parquet' SELECT "Code du département" || "Code de la commune" codgeo, nuance, sum(voix) tvoix, sum(tvoix) over(PARTITION BY "Code du département" || "Code de la commune") exprimes, WHERE id_election = '2024_euro_t1' GROUP BY codgeo, nuance ), t2 AS ( PIVOT t1 ON nuance USING(sum(tvoix)) ) FROM t2 SELECT codgeo,exprimes,LREC+LRN RN,LENS,LFI+LUG+LVEC+LCOM LNFP ORDER BY codgeo ;

J’utilise DuckDB dans sa version la plus récente (dev 1.0.1), qui simplifie davantage encore les écritures.

Deux extensions vont me servir, SPATIAL pour les requêtes géographiques, H3 pour créer et manipuler le maillage hexagonal.

INSTALL H3 FROM COMMUNITY ; LOAD H3 ; -- pour récupérer, si besoin, la version de dev : -- FORCE INSTALL spatial FROM 'http://nightly-extensions.duckdb.org'; LOAD SPATIAL ;À partir du contour de la France métropolitaine, je crée une enveloppe, et je peux la voir immédiatement dans DBeaver.

CREATE OR REPLACE VIEW e_fra AS FROM st_read('a_frametro.json') SELECT st_convexHull(geom).st_buffer(0.1) AS geom ;

Notre première fonction H3, l’une des plus puissantes, est en mesure de mailler ce polygone avec plein de petits hexagones de niveau 7. Ils sont 182 000. DBeaver ne m’en montre qu’un échantillon, mais c’est déjà impressionnant !

FROM e_fra SELECT h3_polygon_wkt_to_cells(geom, 7) -- ids .unnest() .h3_cell_to_boundary_wkt() .st_geomfromtext() ; -- géométries

h3_polygon_wkt_to_cells() renvoie une valeur qui est en fait une liste d’identifiants d’hexagones. unnest() permet de déplier cette valeur/liste en autant de lignes de la table résultante.

h3_cell_to_boundary_wkt(), autre fonction très utile, génère la géométrie hexagonale d’un identifiant.

On peut ainsi fabriquer un grillage spatial sans écrire soi-même aucun calcul mathématique.

Pour remplir une forme plus complexe que le simple POLYGON précédent, la France par exemple, il faut la décomposer en formes plus élémentaires, et assembler le résultat pour constituer une table homogène.

CREATE OR REPLACE TABLE fra_h3_res7 AS WITH france_polys AS ( FROM st_read('a_frametro.json') -- décomposition MULTIPOLYGON -> POLYGON SELECT st_dump(geom).unnest(recursive := true) AS geom ), h3_ids AS ( FROM france_polys SELECT list(h3_polygon_wkt_to_cells(geom, 7)) .flatten().unnest() AS id -- concaténation des ids d'hexagones ) FROM h3_ids SELECT id, -- conversion en géométries h3_cell_to_boundary_wkt(id).st_geomfromtext() AS geom ;Voici un aperçu des 115 000 hexagones du niveau 7 qui recouvrent la France métropolitaine.

Passons dans Mapshaper

Passons dans Mapshaper

Les fonctions cartographiques de DBeaver sont pratiques, mais limitées. L’outil Mapshaper affiche sans aucune difficulté l’ensemble de la couche.

Au préalable, on aura procédé, dans DBeaver, à un export Geojson.

COPY fra_h3_res7 TO 'fra_h3_res7.json' WITH (format GDAL, driver GeoJSON) ;Il suffit ensuite de faire glisser ce fichier dans l’interface de Mapshaper. La console de cet outil permet d’écrire de puissantes instructions de manipulation, dont je vais profiter.

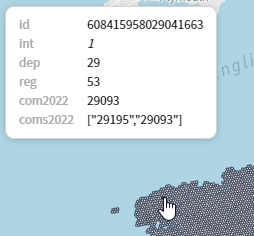

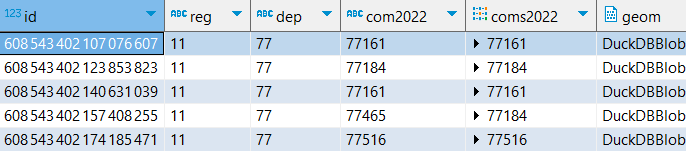

Je souhaite enrichir cette grille par jointure spatiale avec deux autres couches géographiques. Je vais ainsi relier chaque hexagone aux département, région et commune(s) qui le recouvrent ou l’intersectent.

target fra_h3_res7 \ join a-depmetro calc='reg=first(reg), dep=first(dep)' largest-overlap \ join a-com2022 calc='com2022=first(codgeo), coms2022=collect(codgeo)' largest-overlap \ join a-com2022 calc='coms2022=collect(codgeo)'Ces opérations complexes prennent moins de 10 secondes dans mon navigateur.

J’utilise ce fond de carte communal.

L’identifiant d’un hexagone est un entier de grande taille. Mapshaper l’interprète plutôt comme une string, on y sera attentif par la suite.

Je stocke ma couche hexagonale enrichie sous la forme d’un fichier geoparquet, ce que permet très simplement la version 1.0.1 de DuckDB. Le fichier produit pèse à peine 9 Mo.

COPY ( FROM st_read('fra_h3_res7_v2.json') SELECT * REPLACE(id::ubigint AS id), ORDER BY reg,id ) TO 'fra_h3_res7_v2.parquet' (compression ZSTD) ; Cartographie thématique avec Mapshaper

Cartographie thématique avec Mapshaper

Je ne les avais jamais utilisées, je découvre avec bonheur les fonctions de coloriage de Mapshaper !

La surface des hexagones n’est pas constante dans H3, car ces hexagones résultent de la projection sur la sphère terrestre d’une forme géométrique complexe, un icosaèdre. De plus, leur surface apparente dépendra de la projection cartographique finale.

Pour autant, cette surface projetée varie peu d’un hexagone à l’autre. Voici ce que donne le rapport à la surface moyenne :

classify field=coeff_area colors='#fff5eb,#fee7cf,#fdd4ab,#fdb97e' classes=4 \ style stroke='d.fill'

Conscient de ces petites variations, je considère tout de même que le lissage à venir s’appliquera de façon globalement homogène – en tous cas bien plus homogène que si j’en étais resté au maillage communal.

J’ai pu agrémenter ma carte de limites départementales et régionales précisément superposables, par fusion de la couche détaillée : Mapshaper excelle dans ces traitements topologiques, et je vais 10 fois plus vite qu’avec un logiciel spécialisé comme QGIS !

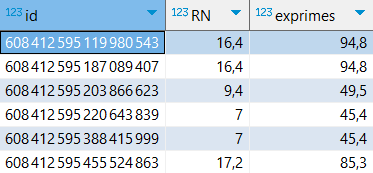

Projection des données communales du vote sur la grille H3target fra_h3_res7_v2 \ dissolve dep,regJe dispose donc d’un excellent référentiel cartographique, avec des hexagones enrichis d’informations communales : elles vont me permettre de faire le lien avec la table des résultats électoraux.

Dans une table intermédiaire, je stocke le nombre d’hexagones couvrant chaque commune.

CREATE OR replace VIEW n_com_h3_res7 as WITH t1 AS ( FROM 'fra_h3_res7_v2.parquet' SELECT UNNEST(coms2022) codgeo, id ) FROM t1 SELECT codgeo, count() AS nb_h3_res7 GROUP BY codgeo ORDER BY codgeo ; FROM n_com_h3_res7 WHERE codgeo = '31555'; -- 38 hexagones intersectent ToulouseGrâce à cela et par jointure, je ventile la table communale du vote à l’hexagone.

CREATE OR REPLACE table s_h3_res7_europ2024 AS FROM s_com_europ2024 p -- jointures sur le code commune JOIN n_com_h3_res7 n using(codgeo) JOIN (FROM 'fra_h3_res7_v2.parquet' SELECT UNNEST(coms2022) codgeo, id) h3 ON h3.codgeo = p.codgeo SELECT id, round(sum(RN/n.nb_h3_res7),1) RN, -- ventilation des votants sur chaque hexagone round(sum(exprimes/n.nb_h3_res7),1) exprimes GROUP BY id ORDER BY id ;

Il ne me reste plus qu’à injecter cette information dans la couche spatiale des hexagones, que j’exporte vers Mapshaper :

COPY ( FROM 'fra_h3_res7_v2.parquet' m JOIN s_h3_res7_europ2024 l USING(id) SELECT RN, exprimes, round(100*RN/exprimes, 1) part_rn, st_geomfromwkb(geom) geom ) TO 'a_h3_7_europ2024_fra_brut.json' WITH (format GDAL, driver GeoJSON) ;J’essaie deux variantes de coloration, en quantiles, et avec des seuils explicites (pour faciliter les comparaisons à venir entre carte brute et cartes lissées) :

classify field=part_rn quantile classes=5 colors=Oranges \ style stroke='d.fill' classify field=part_rn breaks=35,40,45,50 colors=Oranges \ style stroke='d.fill'Européennes 2024 – Part des votes RN et Reconquête (%) – par hexagone de niveau 7

Le lissage final

Le lissage final

Pour lisser les données par fenêtre spatiale mobile, il me faut faire le lien entre un hexagone donné, et l’ensemble des hexagones voisins, de premier niveau jusqu’au niveau 10.

h3_grid_disk_distances() me donne cette liste d’anneaux successifs en un seul appel. C’est un autre atout majeur du système H3.

CREATE OR replace VIEW corresp_h3_res7_dist10 AS WITH t1 AS ( FROM 'fra_h3_res7_v2.parquet' SELECT id, list_transform(h3_grid_disk_distances(id, 10), (c,i) -> {ids:c, distance:i}) .unnest(recursive := true) ) FROM t1 SELECT id, unnest(ids) id2, distance ;

L’opération de lissage résulte d’un appariement de cette table de correspondance et des données de vote à l’hexagone. Je définis une fonction de pondération inverse de la distance, et je me réserve la possibilité d’ajuster le rayon de lissage.

CREATE OR REPLACE VIEW s_h3_res7_europ2024_liss as FROM corresp_h3_res7_dist10 c JOIN s_h3_res7_europ2024 p ON c.id2 = p.id SELECT c.id, sum( RN /(1 + pow(distance-1,1.5)) ) RN, -- 1.5 (pondération) ajustable sum(exprimes/(1 + pow(distance-1,1.5)) ) exprimes WHERE distance

Pour rappel, la méthode commence par agréger séparément le numérateur et le dénominateur, le taux « ambiant » est calculé dans un second temps, avant export vers Mapshaper :

COPY ( FROM 'fra_h3_res7_v2.parquet' JOIN s_h3_res7_europ2024_liss USING(id) SELECT RN, exprimes, round(100*RN/exprimes,1) part_rn, geom ) TO 'a_h3_res7_europ2024_fra_liss_l5_p15.json' WITH (format GDAL, driver GeoJSON) ;classify field=part_rn breaks=35,40,45,50 colors=Oranges \ style stroke='d.fill'Voici le résultat, avec en prime une comparaison avec le vote le Pen lors de l’élection présidentielle de 2022.

Européennes 2024 – part des votes RN et Reconquête (%) et présidentielle 2022 – Part du vote le Pen (%)

2024

2024

2022

2022

Ces deux cartes présentent de grandes similitudes. Même si les seuils ne sont pas comparables (le vote RN était supérieur, en %, en 2002, mais il s’agissait du 2d tour, avec donc seulement 2 candidats en présence).

D - À vous de jouer !Ci-dessous figure l’accès à ce kit de lissage : la couverture H3 de la France au niveau 7, et la table de correspondance entre chaque hexagone et leurs voisins. Les préparer a demandé un peu de temps, comme on l’a vu ci-dessus.

Leur application à toute base de données communales est toutefois simple et rapide, deux requêtes suffisent, et tournent en moins de 10 secondes : ventilation des valeurs additives sur la grille H3, et lissage par fenêtre mobile. Avec Mapshaper, vous en voyez très rapidement le résultat. Lisser ne demande qu’un éditeur SQL (ou le client léger DuckDB) et le navigateur web.

Pour en savoir plus- H3 : Hexagonal hierarchical geospatial indexing system

- Manuel d’analyse spatiale – Insee Méthodes

- Prendre en compte l’hétérogénéité spatiale avec le lissage – diaporama Insee

- Lissages interactifs sur l’élection présidentielle 2022

- Kit de lissage H3 France sur data.gouv

- Installer la version de dév de DuckDB

- Bindings for H3 to DuckDB

L’article Les lignes de force du vote RN en 2024 : une cartographie lissée avec la grille H3 est apparu en premier sur Icem7.

-

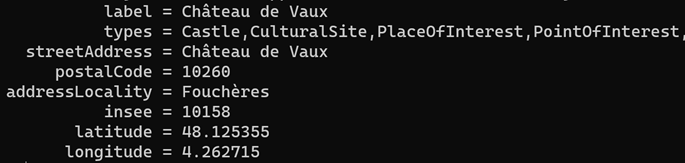

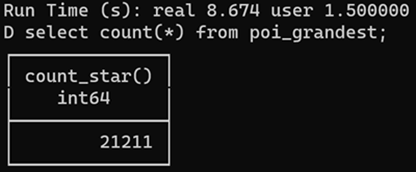

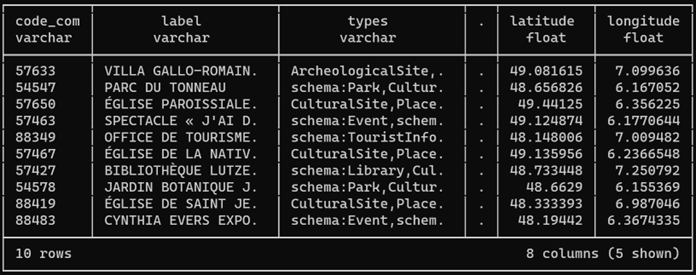

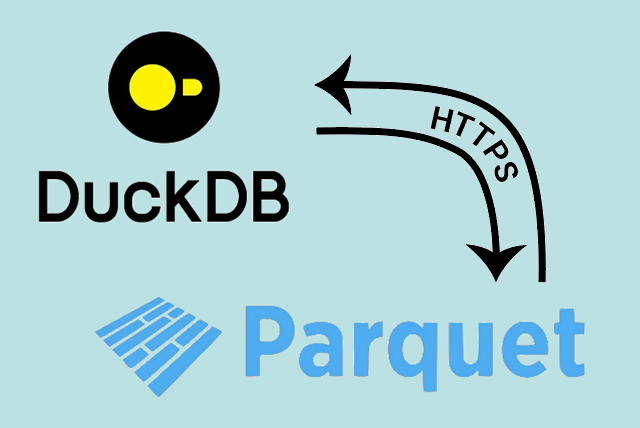

sur Comment bien préparer son Parquet

Publié: 16 May 2024, 5:14pm CEST par Éric Mauvière

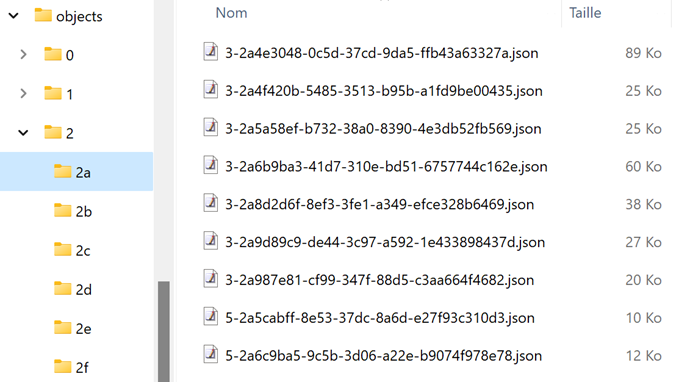

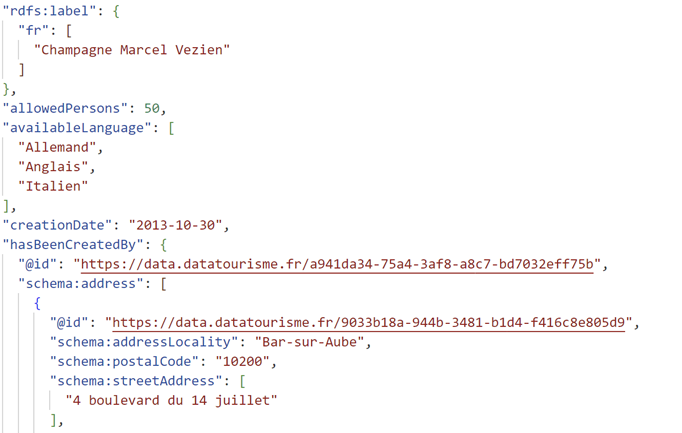

De plus en plus de bases sont désormais diffusées en parquet, ce format de données compact, maniable et spectaculairement rapide à interroger. Des outils simples le permettent.

J’observe pour autant ici ou là quelques défauts de préparation qui amoindrissent les avantages de ce nouveau format. Il est facile de les corriger avec un peu de vigilance, les bons outils, et le réflexe de tester ses fichiers avec quelques requêtes types.

7 points d'attention

7 points d'attention

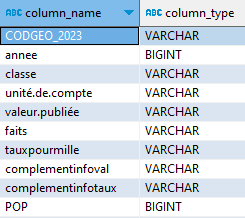

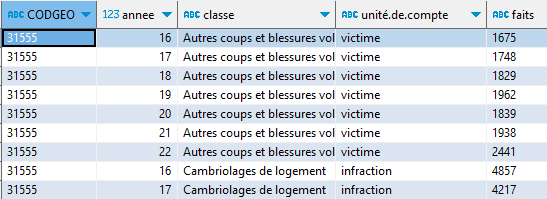

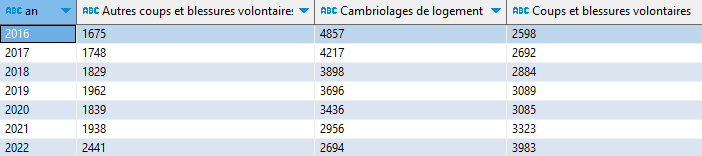

1 – Des colonnes facilitant l’écriture d’une requête

Cela commence par des noms de colonnes simples à comprendre et à écrire dans une requête : en minuscules, sans accents ni blancs, d’une longueur modérée, par exemple inférieure à 15 caractères. Plutôt que « Code du département », on choisira par exemple « code_dept ».

À l’inverse, l’obscur « nb_vp » peut être précisé en « nb_veh_part » (pour nombre de véhicules particuliers).

On peut aussi ajouter des colonnes qui serviront souvent à filtrer le jeu de données. Pour des données quotidiennes renseignées avec un champ date, n’hésitons pas à placer un champ annee. En parquet, il ne prendra pas beaucoup de place, grâce à la compression.

2 – Définir les bons types de colonne

Une colonne de nombres codés en caractères n’est pas utilisable en l’état. La pire situation : des nombres avec virgule stockés comme du texte. De même, une date doit être décrite selon le type date : on pourra ainsi plus facilement la trier, en extraire le mois ou le jour de la semaine.

Je vois encore fréquemment des codes commençant par 0, comme un code département, qui perdent leur 0 : 09 devient 9, ou 04126 devient 4126. Voilà qui va compromettre les jointures avec d’autres fichiers bien construits.

Quelques optimisations plus fines amélioreront les performances : stocker un champ complexe (json, liste, hiérarchie) non comme du texte mais comme json, map ou struct. Un entier gagnera à être typé comme tel, et non comme float ou double ; un logique comme booléen et non « True » ou « False ».

3 – Trier le fichier selon une ou deux colonnes clés

Le tri est un critère essentiel : une requête filtrée sur un champ trié sera jusqu’à 10 fois plus rapide. Les requêtes de plage sur un fichier parquet permettent dans ce cas de cibler et réduire les seules plages à lire dans le fichier.

Par ailleurs, un fichier trié sur un ou deux champs de faible cardinalité (peu de valeurs distinctes) sera bien plus léger, bénéficiant d’une compression plus efficace.

Cas typiques : trier par année, puis code géographique ; trier un répertoire par code Siren ; trier un fichier géographique (geoparquet) par geohash.

4 – Choisir la meilleure stratégie de compression

Réduire la taille d’un fichier parquet n’est pas une fin en soi. Ce qui importe est de trouver le meilleur compromis entre gain de transfert et vitesse de décompression.

Le contexte d’usage doit aussi être pris en considération : le fichier parquet sera-t-il souvent accédé en ligne (auquel cas la bande passante et donc la compression des données transmises comptent), ou plutôt sur disque local rapide (et là on se passera volontiers du temps de décompression, et donc de la compression).

En pratique, la compression ZStd est la plus intéressante (davantage que le défaut Snappy) : elle est efficace et rapide à décoder.

5 – Ajouter une colonne bbox à un fichier geoparquet

Un fichier geoparquet décrit des données localisées qu’on voudra souvent filtrer à partir d’une emprise, typiquement un rectangle d’extraction. Chaque entité du geoparquet bénéficiera de la présence d’une colonne bbox (de type struct) définissant son rectangle englobant, conformément à la spécification geoparquet 1.1 en préparation.

La géométrie dans un géoparquet peut être codée en WKB ou en GeoArrow. Ce second format est bien plus performant et sera intégré à la spec geoparquet 1.1. Mais il faudra attendre encore un peu pour qu’il soit suffisamment adopté, notamment en lecture.

6 – Servir un fichier parquet à partir d’un stockage physique et non à la volée en API

Certaines plateformes proposent des formats parquet générés à la volée. Le processus est toujours affreusement lent (parquet est un format subtil et complexe à fabriquer). Et il compromet le requêtage direct en ligne car les métadonnées principales d’un parquet sont stockées à la fin du fichier. On perd donc la formidable possibilité propre à Parquet de réduire les plages de données à lire.

Parquet est un format de diffusion qui doit être stocké physiquement pour pouvoir être scanné rapidement (et bénéficier de la mise en cache des requêtes de plage).

7 – Affiner si besoin le nombre de row groups

Un fichier Parquet se structure en groupes de lignes (row groups), puis en colonnes. La taille de ces groupes de lignes doit être optimisée selon les usages pressentis : plutôt large si le fichier doit souvent être lu en grande part, plus réduite si les requêtes sont plutôt très sélectives (ce sera par exemple plus fréquent avec un fichier géographique).

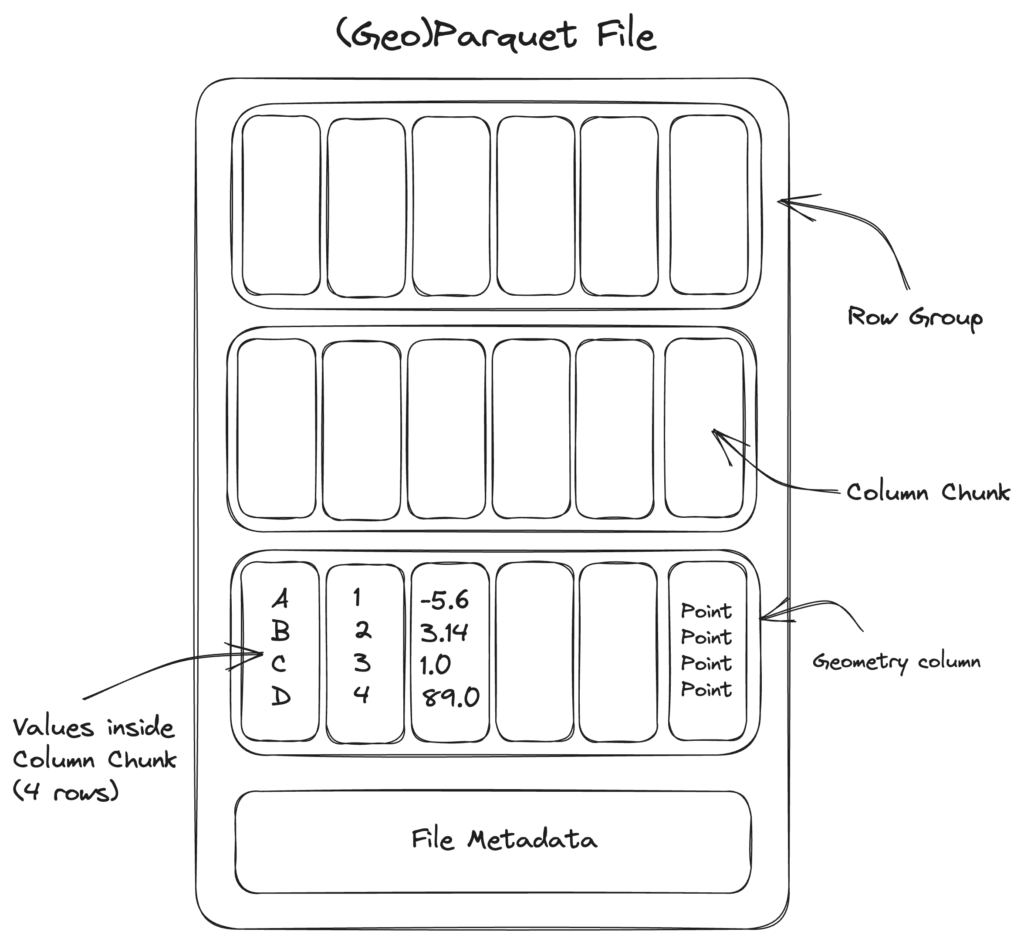

Rappels sur la structure d'un fichier parquetParquet est un format orienté colonne, mais il organise d’abord en groupes de lignes dans lesquels il dispose bout à bout les données des différentes colonnes. Ces « column chunks » ou morceaux de colonne sont compressibles et, comme chaque colonne présente un type homogène, cette compression est efficace.

Un fichier parquet est truffé de métadonnées : au niveau supérieur, décrivant la structure du fichier (nombre de lignes, liste des colonnes et leur type…) et au niveau de chaque row group : valeurs min et max de chaque column chunk, nombre de valeurs distinctes…

Un moteur de requête va prioritairement lire ces zones de métadonnées avant de décider quelles « plages de bits » extraire. Il lui est ainsi souvent possible de sauter plusieurs row groups dont il comprend qu’ils ne peuvent satisfaire la requête courante. Par ailleurs, seules les données des colonnes spécifiées dans la requête seront scannées. C’est tout l’intérêt d’un format orienté colonne.

[https:]

L'importance du tri

[https:]

L'importance du tri

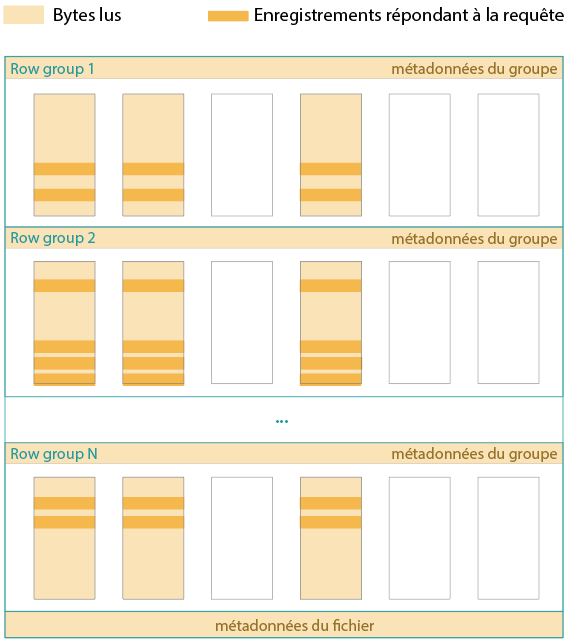

Prenons le cas d’un fichier non trié et d’une requête sélective, qui précise un critère de filtrage. Le schéma suivant matérialise en orange foncé les lignes à extraire des colonnes visées. Chaque row group en comprend, si bien qu’il va falloir extraire les données contenues dans tous les column chunks colorés.

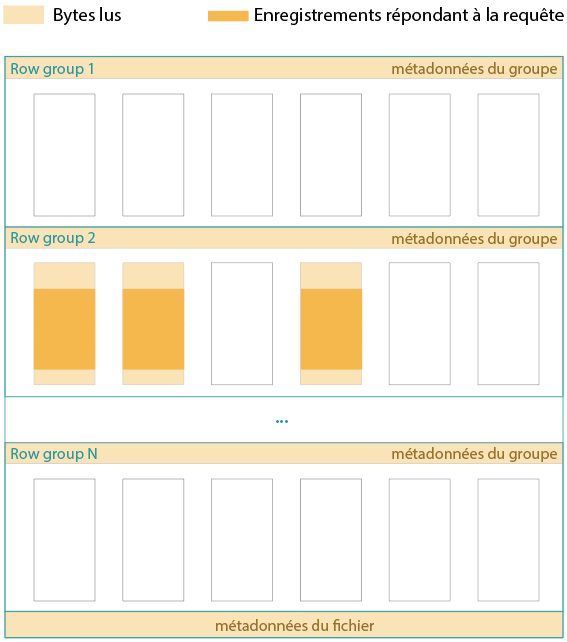

Quand le fichier est trié selon un ou deux champs clés, et que la requête filtre sur l’un de ces champs, notamment le premier, il y aura forcément un certain nombre de row groups « hors champ ». Par exemple, si j’extrais l’année 2018 d’un fichier comprenant des données quotidiennes entre 2010 et 2020, et que le fichier est d’abord trié par année.

Avec nettement moins de données à lire, la requête sera bien plus rapide. C’est ainsi que l’on peut requêter un fichier de 1 Go en ligne, en ne chargeant que quelques Mo de données.

Quels outils utiliser pour optimiser son Parquet ?

Quels outils utiliser pour optimiser son Parquet ?

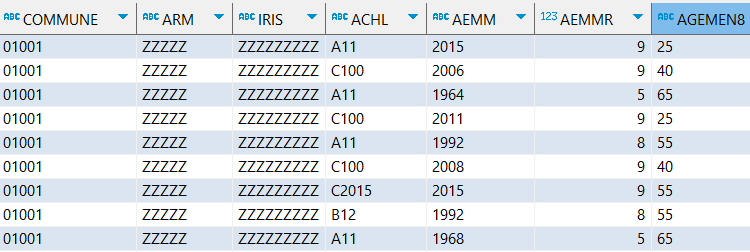

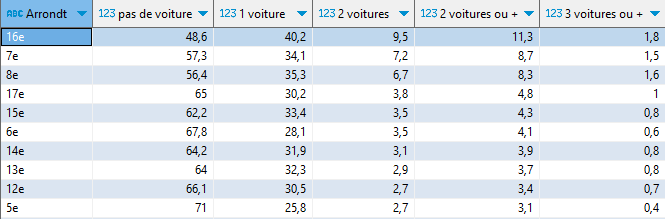

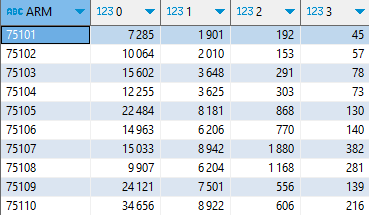

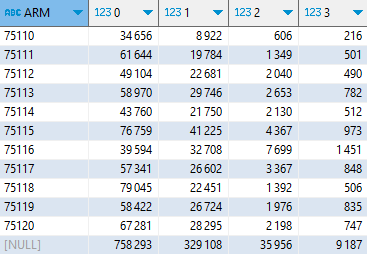

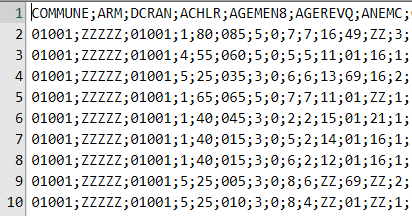

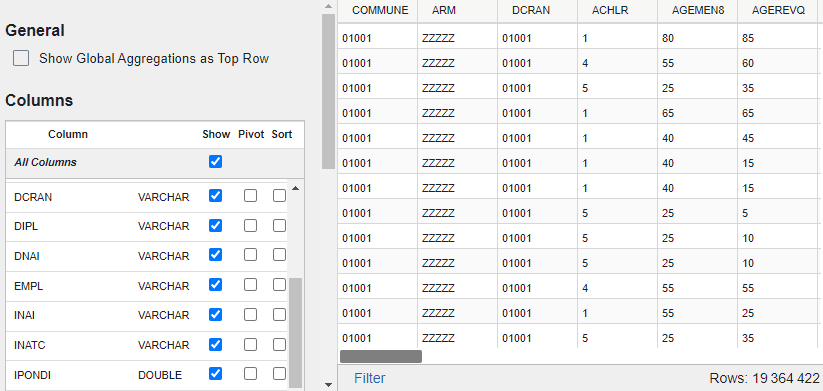

J’ai testé la conversion d’un fichier CSV de 5 Go et 25 millions de lignes (une base du recensement de l’Insee) en parquet, avec différents outils. Ce fichier est délimité par des ; et comprend entre autres une douzaine de codes pouvant commencer par 0.

DuckDB est l’outil plus maniable et le plus efficace : rapide, automatique, simple d’écriture.

Outil

Temps en minutes

Taille en Mo du parquet

Commentaires

Polars/Rust

1

500

Spécifier délim et types des codes avec 0 en 1er

DuckDB Cli threads 4

1

350

Trop facile DuckDB Cli

1,5

350

Trop facile R/Arrow

1,7

290

Spécifier délim et types des codes avec 0 en 1er

Python/Arrow

2

290

Spécifier délim et types des codes avec 0 en 1er

R/Parquetize

11

400

CATL et TYPL mal typés (ex : 1.0 à la place de 1)

Voici le meilleur compromis d’écriture avec DuckDB.

SET threads = 4 ; COPY 'data_recensement_2017.csv' TO 'data_recensement_2017.parquet' (compression zstd) ;DuckDB reconnait tout seul le délimiteur français (;) et prend soin des colonnes avec des codes commençant parfois par 0. Enfin, l’outil DuckDB est super léger (25 Mo), s’installe et se lance en un clin d’œil.

Contrôler le nombre de threads, dans le cas de processus lourds, est souvent utile. Par défaut ce nombre équivaut au nombre de cœurs de la machine (12 dans mon cas, et réduire les threads du plan d’exécution à 4 accélèrera le traitement).

Polars dans Python est une bonne alternative (si vous utilisez déjà Python) pour une rapidité (équivalente). Mais Polars impose de spécifier le bon délimiteur et va maltraiter les colonnes de codes commençant par 0 si on ne le surveille pas de près.

Il faut donc lui préciser explicitement toutes les colonnes à préserver, c’est dissuasif et source d’erreurs. Enfin, le fichier généré est sensiblement plus gros. L’optimiser demanderait probablement à Polars plus de temps d’exécution.

import polars as pl pl.read_csv("data_recensement_2017.csv", separator = ';', \ dtypes = {'COMMUNE': pl.String}) \ .write_parquet("data_recensement_2017.parquet", \ compression = 'zstd', use_pyarrow = False)Dans R, la librairie arrow semble la plus véloce pour assurer la conversion de csv vers parquet, bien qu’un peu moins que Polars. Et comme lui, elle exige de préciser le délimiteur et le type des colonnes avec des 0.

library(arrow) write_parquet(read_delim_arrow('data_recensement_2017.csv', delim = ';', as_data_frame = FALSE), 'data_recensement_2017.parquet', compression = 'zstd')Autrement dit, si vous voulez travailler dans R ou Python, n’hésitez pas à utiliser la librairie DuckDB : c’est possible, plus simple à écrire, et plus rapide.

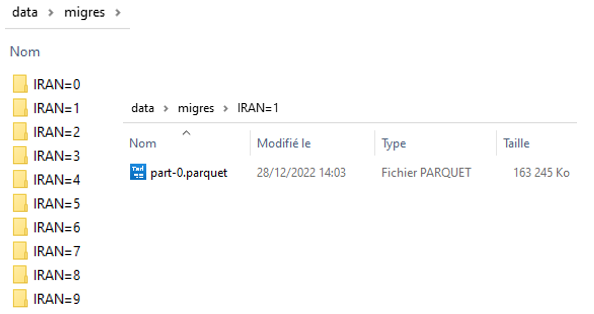

L'intérêt du partitionnement pour les très gros fichiersSi votre fichier parquet doit dépasser les 10 Go et qu’il est plutôt utilisé en local ou sur un cloud comme S3 ou GCS, il y a tout intérêt à le découper en plusieurs fichiers selon les modalités d’un ou plusieurs champs clés, ce que l’on appelle partitionner.

L’instruction suivante crée ainsi une série de sous-répertoires dans lequel figure un fichier parquet par région. Mais on peut partitionner sur 2 colonnes ou plus.

COPY 'data_recensement_2017.csv' TO 'export' (FORMAT PARQUET, PARTITION_BY (REGION), compression zstd)Dans cet exemple, si la requête ne concerne qu’une région, seul le fichier pertinent sera interrogé.

Quels outils utiliser pour optimiser son GeoParquet ?FROM read_parquet('export/*/*.parquet', hive_partitioning = true) WHERE REGION = '76' ;Le cas geoparquet est particulier. DuckDB sait lire ce format, mais pas encore le générer (NDR : annoncé pour juillet 2024). Il faut donc pour l’heure en passer par exemple par Python (geopandas) ou R (sfarrow), à partir d’un format SIG classique (geojson, shape, gpkg, etc.).

Plus simple, si vous disposez de QGIS : exporter/sauvegarder sous au format geoparquet. De plus QGIS (profitant en cela de GDAL) permet de choisir l’encodage WKB ou GeoArrow. GDAL devrait permettre prochainement de produire une colonne bbox servant d’index spatial.

Enfin, pour accélérer plus encore les requêtes filtrées par emprise, ce sera une excellente idée que de trier votre Geoparquet astucieusement selon un indice de grille comme Geohash, H3, S2 ou une « quadkey ».

Un tel « hash » géographique peut être calculé par exemple à partir du centroide de chaque entité géographique. Deux hashes voisins (grâce au tri par exemple) garantissent que les entités correspondantes sont spatialement voisines.

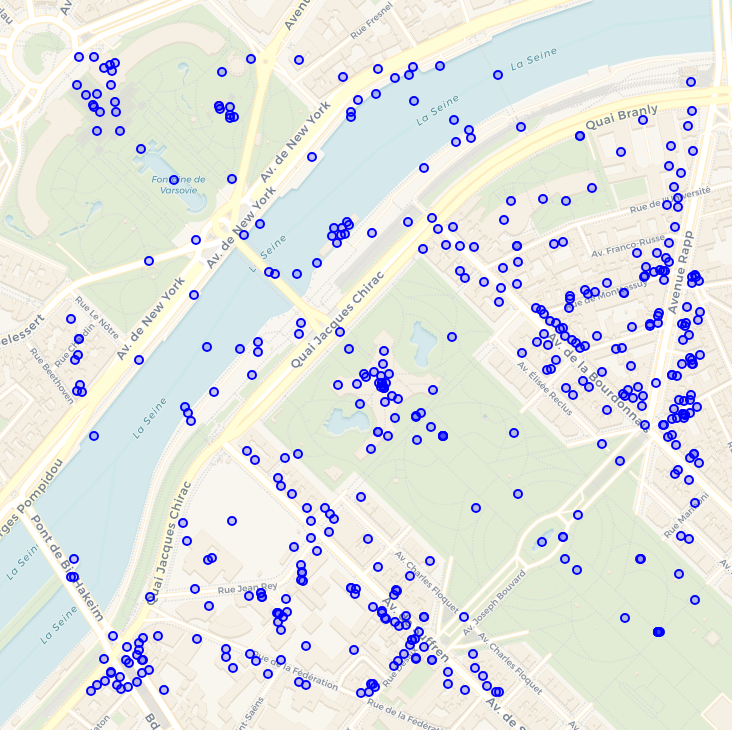

La gigantesque base en ligne OvertureMaps est organisée de cette façon, et de surcroit partitionnée, si bien que cette requête DuckDB d’extraction de 500 m autour de la tour Eiffel ne lit que 13 Mo de données :

LOAD spatial ; FROM read_parquet('s3://overturemaps-us-west-2/release/2024-05-16-beta.0/theme=places/type=*/*') SELECT ST_GeomFromWKB(geometry) AS geom, names, categories WHERE bbox.xmin > 2.2877 AND bbox.ymin > 48.8539 AND bbox.xmax

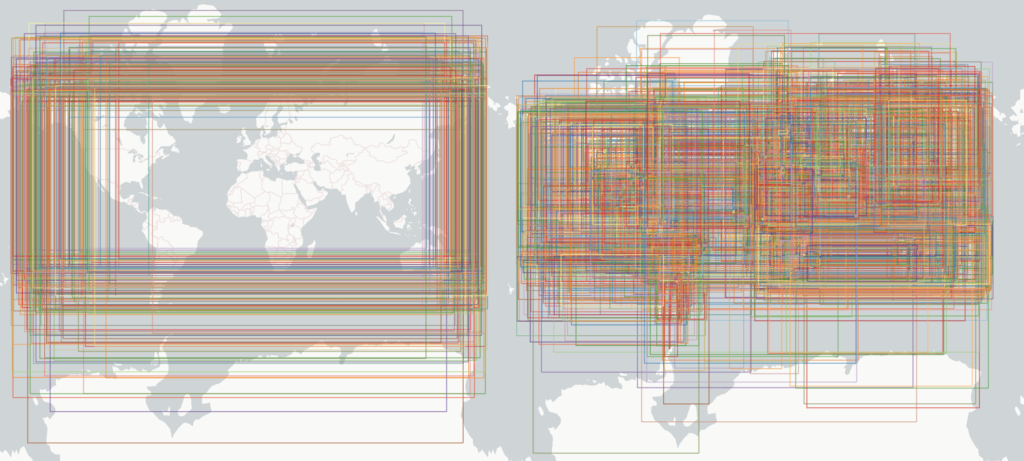

Jacob Wassemarman démontre par ces deux images la spectaculaire progression du partitionnement et du tri dans OvertureMaps.

Dans la version de janvier 2024, encore non optimisée, voici les rectangles englobants pour chaque fichier du partitionnement (à gauche) puis pour chaque row group (à droite) :

Depuis mars 2024, avec un partitionnement intelligent approchant les pays et un tri de chaque fichier par geohash, voici la différence, dont on comprend que l’impact sur l’efficacité des requêtes spatiales est radical :

Quelques instructions pour tester son fichier parquet

Quelques instructions pour tester son fichier parquet

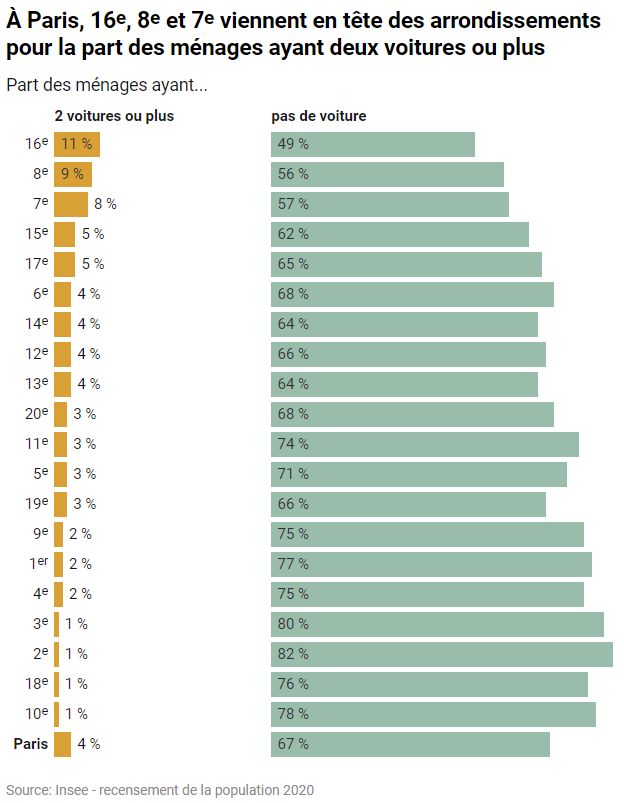

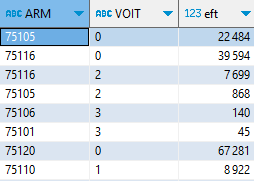

Un fichier parquet comprend de nombreuses métadonnées, qu’il est facile de lire dans DuckDB.

-- Métadonnées générales : nombre de lignes, nombre de row groups FROM parquet_file_metadata('https://object.files.data.gouv.fr/data-pipeline-open/prod/elections/candidats_results.parquet'); -- Liste des colonnes avec leur type FROM parquet_schema('https://object.files.data.gouv.fr/data-pipeline-open/prod/elections/candidats_results.parquet'); -- Liste des row groups, de leurs colonnes et statistiques pour chaque colonne (min, max, valeurs distinctes, valeurs nulles, compression...) FROM parquet_metadata('https://object.files.data.gouv.fr/data-pipeline-open/prod/elections/candidats_results.parquet'); -- Métadonnées spécifiques, par exemple pour un geoparquet : bbox, type de géométrie, projection... SELECT decode(key), decode(value) FROM parquet_kv_metadata('s3://overturemaps-us-west-2/release/2024-05-16-beta.0/theme=places/type=*/*') WHERE decode(KEY) = 'geo';Pour connaitre le plan d’exécution et en particulier la bande passante utilisée par une requête, EXPLAIN ANALYZE est incontournable et nous aide à déterminer, à partir d’un choix de requêtes types les plus probables, les meilleurs options de tri, voire de taille des row groups.

Pour en savoir plusEXPLAIN ANALYZE FROM read_parquet('s3://overturemaps-us-west-2/release/2024-05-16-beta.0/theme=places/type=*/*') SELECT ST_GeomFromWKB(geometry) AS geom, names, categories WHERE bbox.xmin > 2.2877 AND bbox.ymin > 48.8539 AND bbox.xmax- DuckDB – Parquet tips

- GeoParquet 1.1 coming soon! – Chris Holmes

- An Empirical Evaluation of Columnar Storage Formats – Xinyu Zeng & al.

- The Battle of the Compressors: Optimizing Spark Workloads with ZStd, Snappy and More for Parquet

- Sorting and Parquet – Pankaj Gupta

- GeoParquet Spatial Sorting/Indexing/Partitioning – Jacob Wasserman

- Completely In-fused ! Guillaume Sueur

- Parquet devrait remplacer le format CSV – icem7

- 3 explorations bluffantes avec DuckDB – Interroger des fichiers distants (1/3), icem7

L’article Comment bien préparer son Parquet est apparu en premier sur Icem7.

-

sur Transmettre un message percutant

Publié: 12 March 2024, 6:29pm CET par Isabelle Coulomb

Éric est régulièrement sollicité sur le thème de la sémiologie graphique, un de ses domaines d’expertise. Il intervient souvent pour des conférences, des exposés, des formations. Encore la semaine dernière, il était invité par SSPHub, le réseau des « datascientists » des services de la Statistique Publique, pour une visioconférence intitulée “La dataviz pour donner du sens aux données et communiquer un message”.

Les présentations d’Éric se basent toujours sur des exemples concrets et récents, qu’il va piocher dans les publications des organismes qui font appel à lui. Il se base sur ces exemples pour les décortiquer, puis examiner quels seraient les ajustements possibles, en vue de les rendre plus signifiants. Ce petit jeu du « avant / après » est très éloquent ; c’est un outil pédagogique toujours efficace.

Le jeu des différences avant / aprèsJ’ai le privilège d’être la première spectatrice des présentations qu’Éric prépare. C’est toujours un plaisir gourmand de découvrir quels nouveaux exemples il a réussi à dénicher. Pour la conférence en ligne pour SSPHub, Éric a puisé dans l’actualité de plusieurs services statistiques, l’Insee en premier lieu, évidemment, mais aussi les services statistiques des ministères de la Justice, de la Transition écologique, du Travail et de la Santé…

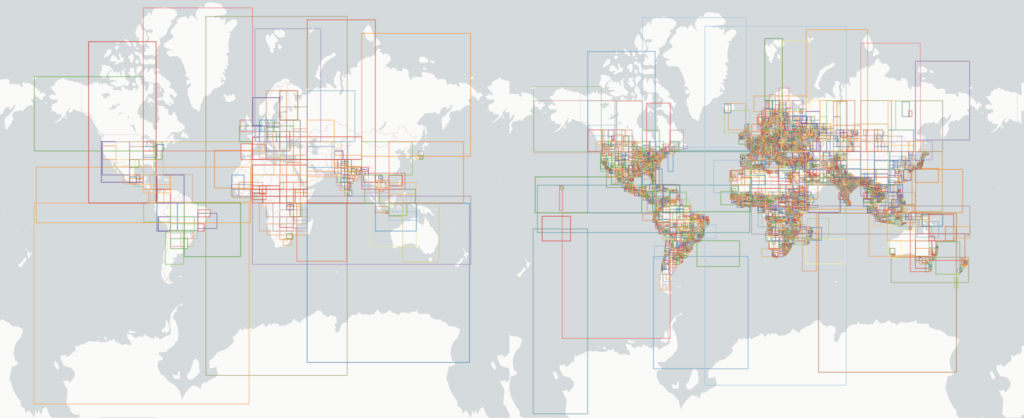

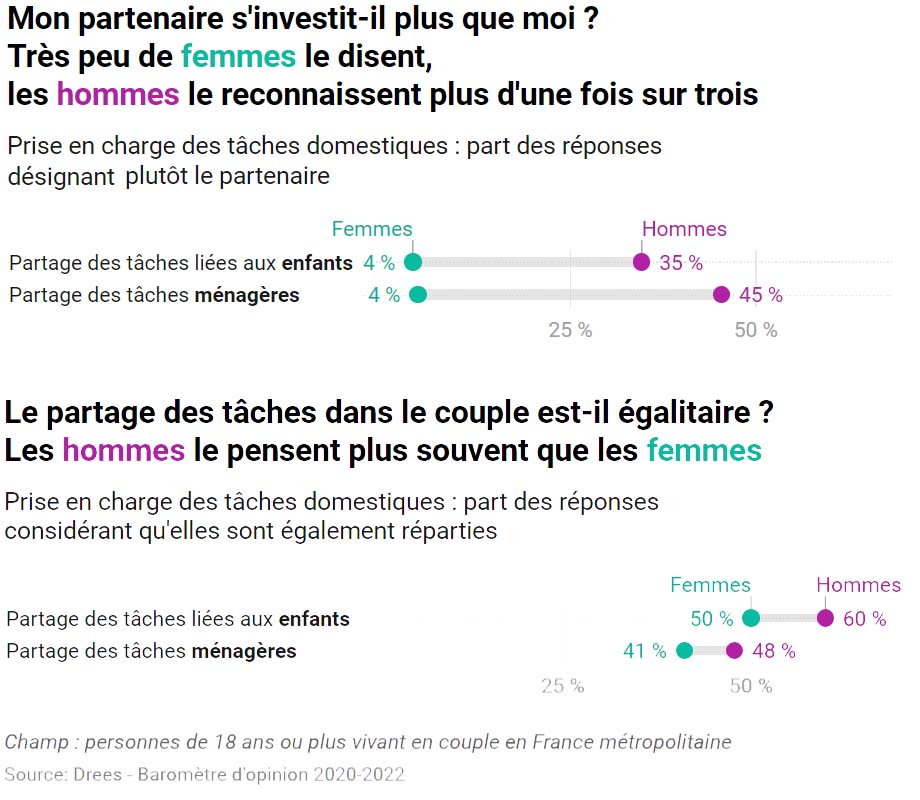

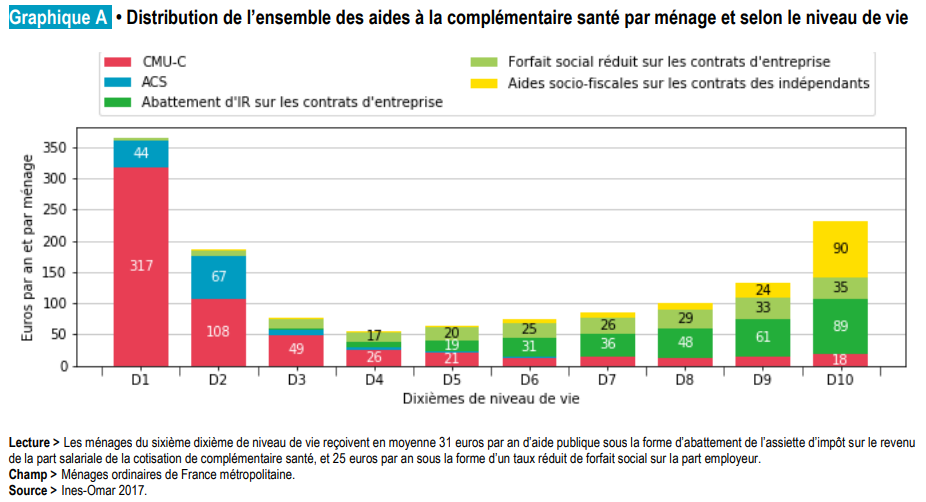

Parmi la quinzaine d’exemples analysés, quelques-uns ont particulièrement retenu mon attention : ceux qui non seulement sont les plus marquants sur le contraste entre « avant » et « après », mais surtout exposent des données originales et une information inédite. Mon préféré est un graphique publié dans une étude de la Drees, le service statistique du ministère en charge de la santé.

Cette étude, publiée le mois dernier, est intitulée Des stéréotypes de genre encore très ancrés, notamment chez les hommes. Il s’agit d’un document de 8 pages qui rapporte les résultats d’une enquête d’opinion à propos des croyances sur les comportements masculins et féminins. Voilà qui tranche nettement avec les sujets couramment abordés par la statistique publique. Le graphique retenu par Éric pour son exercice de dissection parle de partage des tâches domestiques.

Avant

Avant

Après

Après

Parmi les cibles privilégiées d’Éric, se trouvent les diagrammes en barres empilées. Ils sont très fréquents dans les publications des services statistiques ; ils sont pourtant rarement efficaces. Mieux vaut séparer les messages que tout mettre sur une même représentation. UN graphique correspond à UN message. Objectif : réduire l’effort du lecteur.

Ensuite, l’habillage compte aussi, jusque dans les détails : choisir un titre informatif, placer la légende au plus près des éléments graphiques, en utilisant astucieusement un code couleur, le tout sans surcharger inutilement. Au bout du compte, la note de lecture n’est plus indispensable : le graphique parle de lui-même.

L’étude dont il est question ici comporte plusieurs autres graphiques. J’ai demandé à Éric d’en passer un autre dans sa moulinette « avant / après ». Le résultat présenté ci-dessous montre que les barres empilées ne sont pas toutes à rejeter. Elles trouvent leur utilité quand elles représentent une répartition en pourcentage dont le total donne 100 %.

Les présentations et les formations animées par Éric sont appréciées pour leur caractère concret et vivant, avec des exemples toujours renouvelés, choisis pour leur intérêt au regard du thème de la datavisualisation et de la sémiologie graphique.

Des dataviz pour éclairer les débats de sociétéAu-delà de ces vertus pédagogiques, ils sont aussi instructifs par les messages qu’ils portent. Ils se rapportent souvent à la démographie ou à l’économie, domaines de prédilection de la statistique publique. Ils abordent aussi des thèmes plus sociaux, la justice, l’environnement ou… les inégalités hommes/femmes.

Il est largement établi que la répartition des tâches domestiques repose encore largement sur les femmes. Il est encore plus édifiant de constater l’écart de vision entre les hommes et les femmes. Les hommes croient davantage qu’ils font leur part. Un grand merci aux statisticien·nes qui apportent ces éléments objectifs de mesure.

La photo utilisée comme image mise en avant pour cet article provient d’une banque d’images libres de droit. Elle date de 1942.

Et pour vous, qu’est-ce que cela évoque, cette vieille photo en noir et blanc d’un couple faisant ensemble la vaisselle ?

L’article Transmettre un message percutant est apparu en premier sur Icem7.

-

sur Accrocher le regard

Publié: 28 December 2023, 12:01pm CET par Isabelle Coulomb

Qu’est-ce qui retient notre attention ? Dans le flot d’informations dans lequel nous baignons en permanence, il arrive que quelque chose accroche notre regard. C’est le eye catching content, le graal que recherche toute personne souhaitant communiquer.

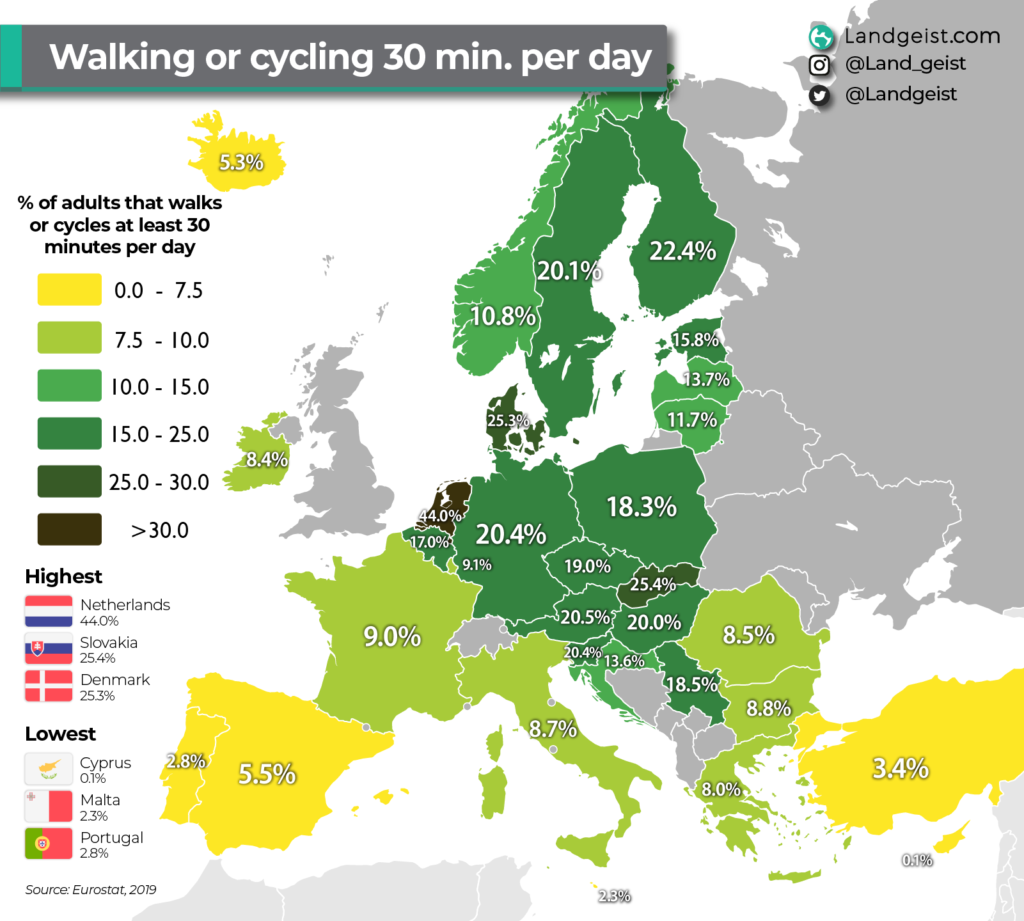

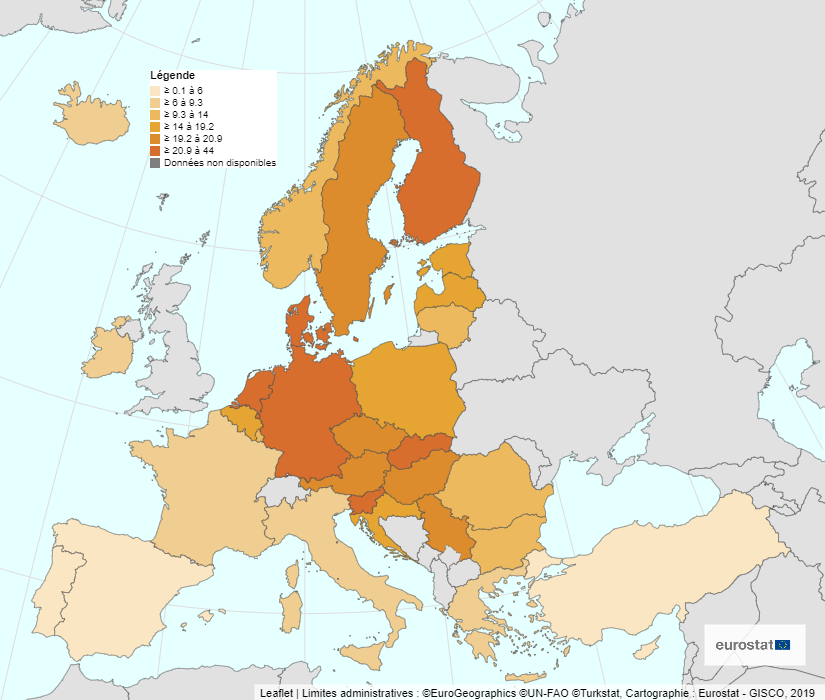

Je reçois chaque jour des dizaines de courriels, que je ne peux pas tous lire. Dans ce flot, un titre a capté mon attention, il y a quelques jours : walking or cycling 30 minutes per day. Dans mon filtre personnel, les mots-clés walk ou marche sont très réactifs. Cela m’a conduite à cette image :

Une carte statistique qui parle de marche, cela ne pouvait pas m’échapper ! Cette image, indéniablement accrocheuse, m’a sauté aux yeux, avec ses couleurs très brillantes, jaune radieux, vert éclatant, rouge lumineux.

Le message de cette carte est loin d’être aussi brillant que ses couleurs ! D’ailleurs, le commentaire qui accompagne la carte souligne : « si le pourcentage est très variable d’un pays à l’autre, dans aucun pays une majorité de personnes ne se déplace à pied ou à vélo au moins une demi-heure par jour ». Pour l’ensemble des 27 pays pris en compte, moins de 2 personnes sur 10 atteignent cette durée ! Et pendant ce temps-là, les maladies chroniques de tout type prolifèrent…

J’aurais imaginé trouver un autre contraste entre les pays du nord et du sud, ces derniers bénéficiant d’un climat plus clément. Les aléas de la météo ne sont apparemment pas un frein pour les piétons et les cyclistes. Les pays avec les pourcentages les moins bas sont aussi les pays de faible superficie.

Cela a éveillé ma curiosité : j’ai eu envie de creuser le sujet, d’abord pour trouver une représentation cartographique moins agressive pour mes yeux, ensuite pour remonter à la source des données.

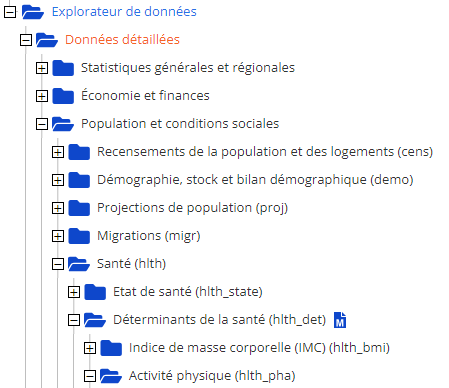

À la source des donnéesLa source des données, c’est évidemment Eurostat. Sa base de données contient des centaines d’indicateurs, rigoureusement classés dans une arborescence détaillée. Celui que je cherche se trouve logiquement dans Santé > Déterminants de santé > Activité physique.

L’explorateur de données d’Eurostat, Data Browser pour les intimes, permet de visualiser ces données sous plusieurs formes. La première est un tableau statistique de 27 lignes : une par pays, une de moins depuis que le Royaume-Uni vogue de son côté.Sa base

Le tableau comprend plus de colonnes que j’imaginais, puisque l’indicateur en question se décline selon 3 critères : sexe, âge et niveau de formation. Cela valait la peine de creuser le sujet ! L’explorateur de données offre aussi des possibilités de datavisualisations : diagrammes et cartes. Pas de courbes d’évolution possibles ici, car l’indicateur n’est disponible que pour l’année 2019. Voici la carte que j’obtiens pour l’indicateur global Marcher et faire du vélo au moins 30 minutes par jour :

La palette de couleurs est nettement moins agressive que pour la première : je préfère. L’adage dit « des gouts et des couleurs, on ne discute pas. » Il convient toutefois de trouver un équilibre : de la couleur oui, mais pas trop !

La carte est dépouillée de la surcharge des chiffres : plus reposant et plus lisible. Les valeurs se retrouvent indiquées au survol de chaque pays : une ébauche d’interactivité très utile. L’image est également allégée du palmarès illustré avec les drapeaux des pays cités : une surcharge visuelle qui détournait de l’essentiel.

La légende est curieusement positionnée, avec toujours un découpage en 6 classes, mais selon une discrétisation moins adaptée : elle ne met pas en évidence l’écart entre les Pays Bas (44 %) et les pays suivants (autour de 20 %). Dans cet export au format png, la carte ne comporte pas de titre, ni de rappel du nom de l’indicateur (ce dernier est présent en dessous de la carte dans l’export au format pdf).

Plus actifs (ou moins inactifs) :

les hommes ou les femmes ?Maintenant que j’ai découvert que l’indicateur auquel je m’intéresse se décline selon d’autres critères, je suis curieuse de voir quelles informations supplémentaires cela apporte. Par exemple, existe-t-il des différences notables entre les hommes et les femmes ?

L’explorateur de données d’Eurostat me permet d’obtenir une carte pour chaque colonne du tableau de données, en particulier, une pour les hommes et une pour les femmes. Sauf que, pour chaque carte, la discrétisation est recalculée automatiquement et elle est chaque fois différente. Les cartes ne sont donc pas comparables entre elles.

Il y a quelques années, j’aurais tout naturellement utilisé une application fonctionnant avec Géoclip pour créer les cartes de mon choix. Aujourd’hui, je m’en vais explorer d’autres outils de cartographie thématique en ligne. Voyons par exemple ce qu’il est possible de construire avec Khartis, l’outil de création de cartes thématiques proposé par l’Atelier cartographique de Sciences Po.

Dans le Data Browser d’Eurostat, j’exporte très simplement la table de données dont j’ai besoin. Après un petit détour par un tableur, j’importe cette table dans Khartis, d’un rapide copier-coller. La Tchéquie se convertit aisément en République tchèque pour établir la jointure avec les 27 pays du fond de carte.

Reste le paramétrage de la visualisation qui demande plus de soin. Je choisis le même découpage en tranches de valeurs pour les 2 cartes hommes et femmes, afin d’obtenir deux représentations cartographiques comparables.

Pour finir, l’export est possible dans plusieurs formats : png ou svg. Le format svg est très pratique, car plus facilement modifiable pour une personnalisation plus poussée.

Le résultat obtenu en png convient déjà très bien. Khartis propose un joli choix de palettes de couleurs pour les dégradés : bien contrastées, sans être trop agressives.

Il y a beaucoup d’éléments personnalisables : titre, position de la légende, dimensions, couleur des éléments d’habillage, ajout d’étiquettes…

Pour finir, il est possible de sauvegarder le projet, pour le conserver ou le transmettre à une autre personne. Je n’ai pas testé cette possibilité, mais c’est une bonne idée.

Voilà les 2 cartes que j’obtiens, avec les femmes à gauche et les hommes à droite :

Les pays les plus foncés et les plus clairs restent à peu près les mêmes. Les hommes sont (un peu) plus actifs que les femmes. Apparaissent toutefois quelques différences selon les pays. Cependant, les cartes thématiques ne sont pas les mieux à même de les faire ressortir.

Je fais donc appel à mon conseiller en datavisualisation préféré. Il me suggère un outil dont il est fan : Datawrapper. L’objectif annoncé dès la page d’accueil : No code or design skills required. Là encore, un copier-coller de la table de données, quelques réglages pour choisir les paramètres, dans un cadre bien guidé. Et hop, un graphique en barres horizontales, qui montre mieux les différences :

Ce graphique met en évidence que les pays où les femmes sont proportionnellement les plus nombreuses à se déplacer à pied ou à vélo sont aussi les pays où les femmes devancent les hommes dans cette pratique. Bravo et merci à ces 3 pays, Pays-Bas, Danemark, Finlande. Je n’ai jamais eu l’occasion d’y voyager. Je sais cependant qu’ils sont connus pour disposer d’aménagements confortables, qui encouragent et facilitent les modes actifs de déplacement.

Ce n’est pas une découverte, la cartographie thématique est un moyen puissant de « faire parler les données ». Pourtant, un graphique tout simple permet parfois une lecture plus directe et efficace. C’est ce qui ressort régulièrement des exemples que choisit Éric dans ses interventions, en formation, en conférence ou en accompagnement. Certes, il existe des outils pour créer facilement des cartes et des graphiques. Pour éviter de tomber dans le piège de produire des images aussi multicolores que des perroquets, mieux vaut connaître les fondamentaux de sémiologie graphique.

L’article Accrocher le regard est apparu en premier sur Icem7.

-

sur 3 explorations bluffantes avec DuckDB – Croiser les requêtes spatiales (3/3)

Publié: 19 December 2023, 10:33am CET par Éric Mauvière

Nous sommes entourés de données géolocalisées. La séparation données statistiques / données spatiales est bien souvent arbitraire. Mais si elle perdure, c’est parce que les outils SIG (systèmes d’information géographiques) sont lourds à installer et complexes à utiliser.

Avec son extension spatiale, DuckDB met enfin l’analyse géographique à la portée de tou·tes.

Comme dans les deux articles précédents, je vais présenter deux cas concrets, l’un avec les données GTFS de transports en commun dans la métropole toulousaine, l’autre avec la base adresse nationale (BAN).

A - Le standard GTFS pour analyser les transports en commun à ToulouseLe format GTFS (General Transit Feed Specification) permet aux gestionnaires de transports en commun de mettre à disposition, quotidiennement, des informations détaillées sur leur réseau, les horaires et emplacement des arrêts, le niveau de service. Mis au point par Google en 2005, il s’est imposé comme un standard mondial.

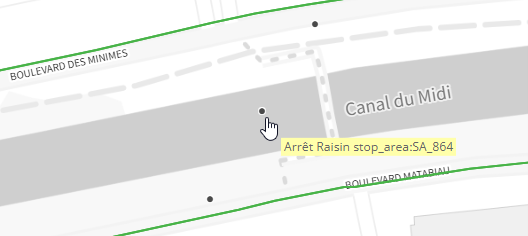

Comme bien d’autres en France et dans le monde, le gestionnaire toulousain Tisséo propose en téléchargement un fichier rafraichi tous les jours, dont la carte ci-dessous restitue l’information purement géographique. Si vous zoomez sur ce composant cliquable (l’IGN propose un fort bel outil web intitulé « Ma carte »), vous verrez apparaître aussi les points d’arrêt.

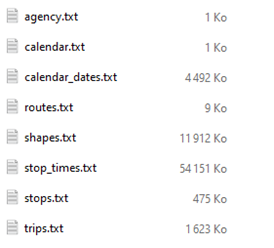

J’ai construit cette carte interactive avec DuckDB à partir de ce fichier GTFS, gtfs_v2.zip (11 Mo), qui contient sous forme d’archive zippée une collection de fichiers CSV, disposés et structurés selon la norme :

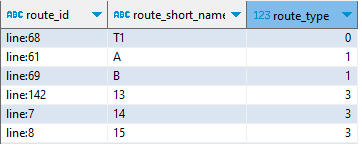

La table routes décrit en bon français des « lignes », de façon purement textuelle, par type (0 = tramway, 1 = métro, 3 = bus, 6 = téléphérique…) : un identifiant unique route_id se distingue du code usuel de la ligne (ex. : ligne A du métro).

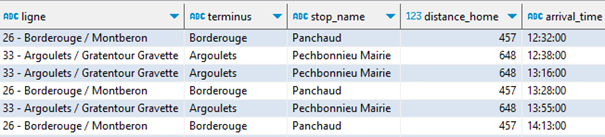

La table trips décrit des navettes. Par exemple le bus de la ligne 26 partant à 6 h 03, lundi 18 décembre 2023, de Montberon, terminus Borderouge correspond à une navette identifiée par un trip_id. Une navette a donc une caractéristique symbolique (la ligne), temporelle – horaire et jours – (elle ne circule pas forcément tous les jours à la même fréquence) et spatiale. Elle emprunte un itinéraire physique particulier définit par un shape_id.

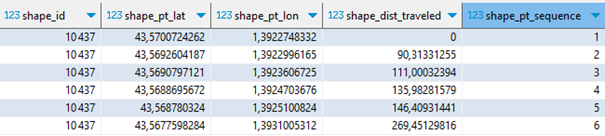

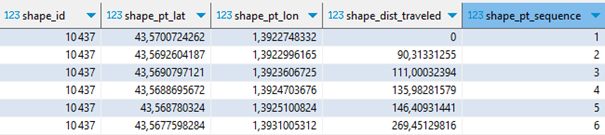

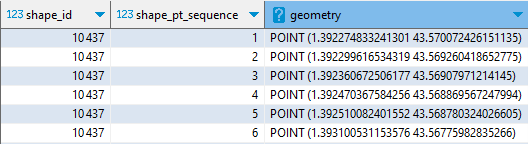

La table shapes décrit ces itinéraires et c’est la première table véritablement géographique.

Chaque itinéraire se définit par une suite ordonnée de points GPS (latitude, longitude). Ces points ne correspondent pas aux arrêts, ils sont plus nombreux et définissent les changements d’orientation de l’itinéraire, afin de pouvoir le tracer précisément. Pour une même ligne, il y a généralement un itinéraire aller et un itinéraire retour, qui peuvent légèrement différer.

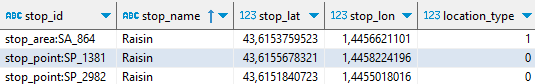

Les arrêts sont décrits dans la table stops, qui constitue la seconde table géographique. On distingue (via location_type) une zone d’arrêt globale des deux points physiques de l’arrêt, selon la direction désirée.

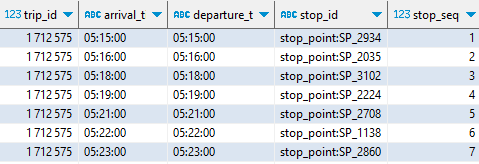

La table stop_times décrit chaque navette (identifiée par un trip_id) comme une suite d’arrêts situés spatialement et temporellement (stop_id, arrival_time…)

Voilà l’essentiel à retenir de ce riche format. Le site transit.land agrège les principales sources GTFS mondiales et en propose une élégante visualisation.

En avant avec DuckDB spatialVoyons comment la produire nous-même, avec DuckDB. Je l’utilise ici au sein de l’utilitaire gratuit DBeaver. DBeaver permet de gérer facilement ses scripts SQL (édition, sauvegarde) et de consulter de façon interactive (y compris cartographique) le résultat des requêtes adressées à DuckDB.

Note : depuis le 18 décembre 2023, l’extension SPATIAL de DuckDB est aussi utilisable dans le navigateur.

Chargeons d’abord les tables. Les fichiers du standard GTFS sont généralement mis à disposition sous forme d’une archive .zip. DuckDB ne sait pas lire directement un zip. Deux méthodes sont possibles :

1 – Télécharger et dézipper manuellement sur un disque local, puis, pour chaque table, écrire une instruction comme :

CREATE OR REPLACE TABLE routes AS FROM read_csv_auto('c:\...\routes.txt') ;2 – Utiliser un proxy capable de charger le zip et d’extraire à la volée la table désirée, le tout via une simple requête [https.] C’est possible avec un petit script PHP prenant comme paramètre le nom de la table à extraire et l’URL du zip :

https://icem7.fr/data/proxy_unzip.php?file=routes

&url=https://data.toulouse-metropole.fr/api/explore/v2.1/catalog/datasets/

tisseo-gtfs/files/fc1dda89077cf37e4f7521760e0ef4e9Utilisons une MACRO pour simplifier les écritures :

CREATE OR REPLACE MACRO get_gtfs(f, cache) AS 'https://icem7.fr/data/proxy_unzip.php?clear_cache=' || cache || '&file=' || f || '&url=https://data.toulouse-metropole.fr/api/explore/v2.1/catalog/datasets/ tisseo-gtfs/file/fc1dda89077cf37e4f7521760e0ef4e9';Le paramètre cache va indiquer au script de conserver le zip sur le serveur proxy le temps d’extraire successivement toutes les tables, ce qui prend 10 secondes.

-- 1er appel forçant le téléchargement du dernier gtfs CREATE OR REPLACE TABLE routes AS FROM read_csv_auto(get_gtfs('routes', 1)) ; CREATE OR REPLACE TABLE trips AS FROM read_csv_auto(get_gtfs('trips', 0)) ; CREATE OR REPLACE TABLE shapes AS FROM read_csv_auto(get_gtfs('shapes', 0)) ; CREATE OR REPLACE TABLE stops AS FROM read_csv_auto(get_gtfs('stops', 0)) ; CREATE OR REPLACE TABLE stop_times AS FROM read_csv_auto(get_gtfs('stop_times', 0)) ; CREATE OR REPLACE TABLE calendar_dates AS FROM read_csv_auto(get_gtfs('calendar_dates', FALSE), types=[VARCHAR,DATE,INT], dateformat='%Y%m%d') ;Pour cartographier le réseau, revenons donc à la table shapes :

Pour la traduire dans un format spatial, les x lignes décrivant un shape_id particulier doivent être condensées en une seule entité spatiale de type LINESTRING. Autrement dit, la table shapes doit être regroupée par shape_id, chaque enregistrement décrira in fine un itinéraire complet.

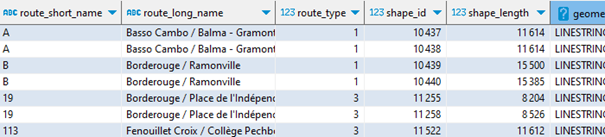

Commençons par créer des entités géométriques de type POINT. Conventionnellement, une telle colonne est dénommée geometry :

LOAD spatial ; SELECT shape_id, shape_pt_sequence, ST_Point(shape_pt_lon,shape_pt_lat) AS geometry FROM shapes ;

Rajoutons une agrégation pour rassembler tous les points d’un tracé (shape_id) en une seule ligne :

WITH shapes_pt_geo AS ( SELECT shape_id, shape_pt_sequence, ST_Point(shape_pt_lon,shape_pt_lat) AS geometry FROM shapes ORDER BY shape_id, shape_pt_sequence ) SELECT shape_id, ST_MakeLine(list(geometry)) AS geometry FROM shapes_pt_geo GROUP BY ALL ;

Je n’ai plus que 328 enregistrements (sur les 200 000 de la table shapes).

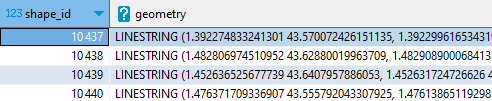

Et surtout, grâce à la petite manip expliquée ici, je peux visualiser chacun de ces itinéraires, directement dans DBeaver :

Pour obtenir une table agrémentée du nom des lignes, je vais devoir procéder à deux jointures, ce sont les charmes du format relationnel GTFS :

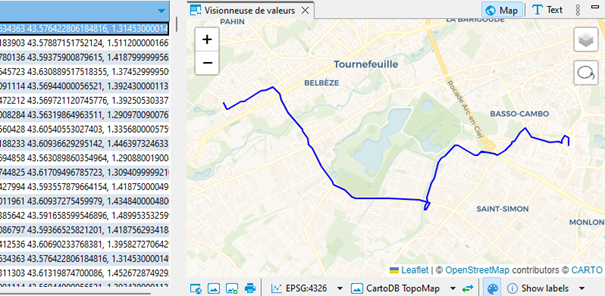

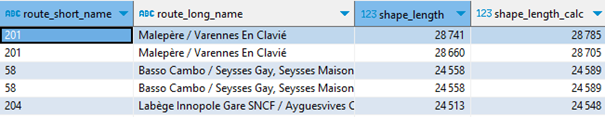

CREATE OR REPLACE TABLE reseau_gtfs_toulouse_met AS WITH shapes_pt_geo AS ( SELECT shape_id, shape_pt_sequence, shape_dist_traveled, ST_Point(shape_pt_lon,shape_pt_lat) AS geometry FROM shapes ORDER BY shape_id, shape_pt_sequence ), shapes_lines_geo AS ( SELECT shape_id, max(shape_dist_traveled)::int AS shape_length, ST_MakeLine(list(geometry)) AS geometry FROM shapes_pt_geo GROUP BY ALL ) SELECT r.route_id,r.route_short_name,r.route_long_name,r.route_type, s.shape_id,s.shape_length,s.geometry FROM shapes_lines_geo s LEFT JOIN (SELECT DISTINCT route_id, shape_id FROM trips) t ON s.shape_id = t.shape_id LEFT JOIN routes r ON r.route_id = t.route_id ORDER BY r.route_type, r.route_id ;Et voici dans cet aperçu les deux lignes de métro (A et B), sens aller et retour, deux lignes de bus :

Il ne me reste plus qu’à exporter en GeoJSON pour l’exploiter à ma guise dans une autre application, comme le bien pratique outil web IGN Ma carte.

COPY reseau_gtfs_toulouse_met TO 'C:/…/reseau_gtfs_toulouse_met.json' WITH (FORMAT GDAL, DRIVER 'GeoJSON');J’ai procédé de la même manière avec la table des arrêts, que vous pourrez voir apparaitre en zoomant suffisamment sur la carte.

Simplicité des calculs géométriquesÀ partir d’un tel fonds de carte et des informations associées, on peut calculer la longueur de chaque itinéraire, le temps de parcours, et donc la vitesse moyenne, pour déterminer les lignes les plus longues, les plus rapides, etc.

Pour chaque shape, nous pouvions lire dans la table shapes d’origine la distance totale parcourue, renseignée par Tisséo. Mais il est possible de la calculer à partir de sa géométrie.

Au préalable, pour obtenir une distance en mètres, il convient de projeter à la volée chaque géométrie vers un référentiel métrique, autrement dit de passer du référentiel « GPS » en longitude/latitude (codé conventionnellement EPSG:4326) au référentiel français Lambert 93 (codé EPSG:2154) :

SELECT route_short_name, route_long_name, shape_length, ST_length(ST_Transform(geometry,'EPSG:4326','EPSG:2154', true))::int AS shape_length_calc FROM reseau_gtfs_toulouse_met ORDER BY shape_length DESC ;

Comme on peut le constater, le calcul géométrique est très proche, à quelques mètres près, de l’information fournie par Tisséo.

Pour éviter l’empilement des parenthèses, je préfère la syntaxe alternative suivante, plus lisible, inspirée de la programmation fonctionnelle, que DuckDB implémente également :

Quels sont les arrêts Tisséo les plus proches de chez moi ?SELECT route_short_name, route_long_name, shape_length, geometry.ST_Transform('EPSG:4326','EPSG:2154', true) .ST_Length()::int AS shape_length_calc FROM reseau_gtfs_toulouse_met ORDER BY shape_length DESC ;Autre approche spatiale, et pratique : quels sont les arrêts Tisséo les plus proches de chez moi, et quand sont les prochains départs, et pour où ?

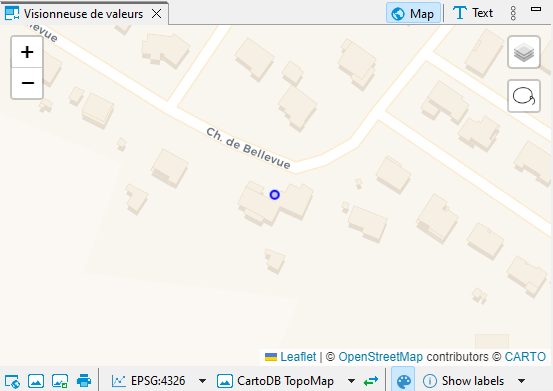

Voici d’abord chez moi :

SELECT ST_Point(1.46158, 43.69875) AS home_location ;

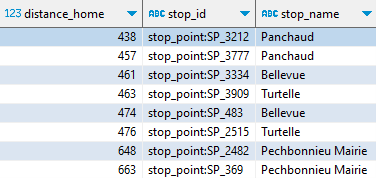

Les arrêts proches de mon domicile (à moins de 700 mètres) se déterminent ainsi :

CREATE OR REPLACE VIEW arrets_proches AS SELECT ST_Point(stop_lon, stop_lat) AS geometry, ST_Distance( ST_Point(stop_lon, stop_lat).ST_Transform('EPSG:4326','EPSG:2154', true), ST_Point(1.46158, 43.69875).ST_Transform('EPSG:4326','EPSG:2154', true) )::int AS distance_home, stop_id, stop_name FROM stops WHERE distance_home

Rappelez-vous, il y a généralement deux arrêts dans la même zone, selon la direction du bus.

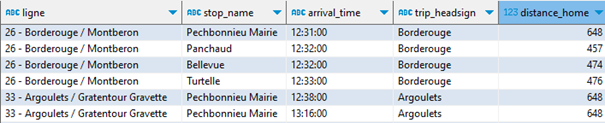

Pour faire le lien avec les horaires, le nom de la ligne, et s’en tenir aux horaires valides aujourd’hui à partir de maintenant, engageons une série de jointures et de filtres adaptés (vous n’êtes pas obligés de tout analyser, sauf si vous êtes passionnés par GTFS) :

SELECT route_short_name, route_long_name, stop_name, arrival_time, trip_headsign, distance_home, trips.trip_id FROM arrets_proches JOIN stop_times ON arrets_proches.stop_id = stop_times.stop_id JOIN trips ON stop_times.trip_id = trips.trip_id JOIN calendar_dates ON trips.service_id = calendar_dates.service_id JOIN routes ON routes.route_id = trips.route_id WHERE arrival_time > localtime AND calendar_dates.date = current_date ORDER BY arrival_time, distance_home ;

Il reste que la ligne 26 propose plusieurs arrêts près de chez moi ; je souhaite ne retenir que le plus proche.

Il suffira d’un QUALIFY avec une « window function » pour nettoyer le résultat :

WITH trips_proches AS ( SELECT route_short_name || ' - ' || route_long_name AS ligne, trip_headsign AS terminus, stop_name, distance_home, arrival_time, trips.trip_id, geometry FROM arrets_proches JOIN stop_times ON arrets_proches.stop_id = stop_times.stop_id JOIN trips ON stop_times.trip_id = trips.trip_id JOIN calendar_dates ON trips.service_id = calendar_dates.service_id JOIN routes ON routes.route_id = trips.route_id WHERE arrival_time > localtime AND calendar_dates.date = current_date ) SELECT * EXCLUDE(trip_id), FROM trips_proches WHERE terminus IN ('Borderouge', 'Argoulets') QUALIFY rank() over(PARTITION BY trip_id ORDER BY distance_home) = 1 ORDER BY arrival_time, distance_home ;Et le plus drôle, c’est que ma fille vient de passer me voir et se demandait quand était le prochain bus pour Argoulets. Elle n’en est pas revenue que je lui montre la réponse dans cette étrange interface ! Son appli Tisséo marche très bien aussi…

Note : vous pouvez déclencher une requête SQL GTFS via une simple URL.

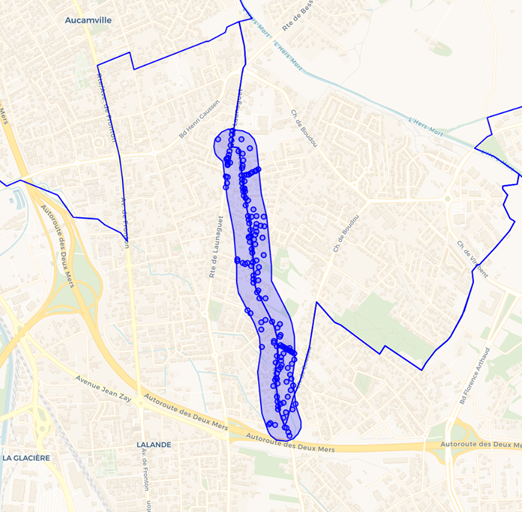

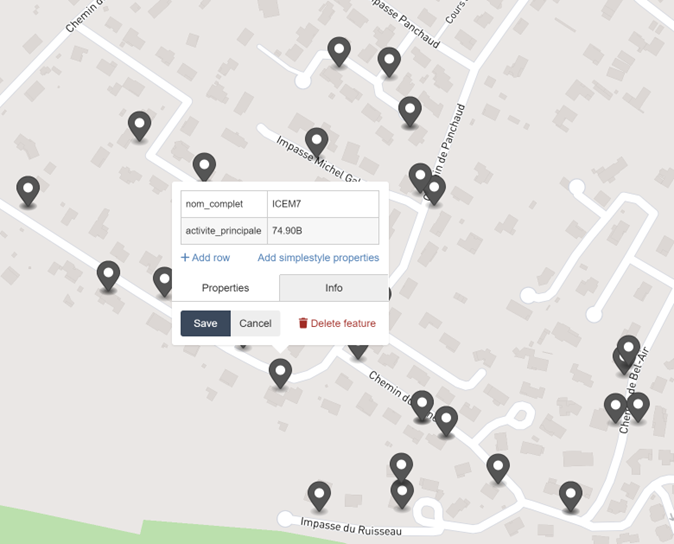

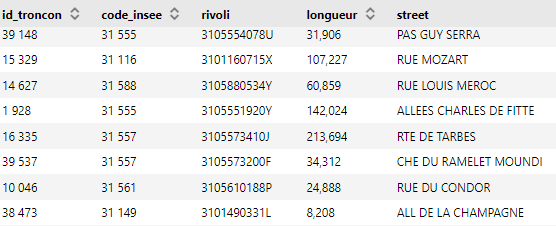

B – Base adresse nationale (BAN), filaire de voies et GeoParquetMon second cas d’étude porte sur des fichiers bien plus volumineux, et me permet d’introduire le format GeoParquet.

Mon précédent logement se trouvait dans une rue limitrophe des communes de Toulouse et de Launaguet. L’état déplorable de la voie s’expliquait, disait-on, par son statut hybride, aucune des deux communes ne voulant s’en occuper à la place de l’autre.

À l’époque, j’aurais pu vouloir rameuter tous les ménages concernés, habitant le long de cette voie limitrophe, ou à proximité immédiate, pour tancer les autorités (mais c’est juste une fable que j’élabore pour l’occasion).

Comment donc compter tous ces voisins ?

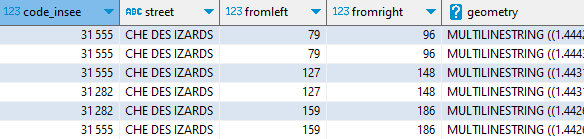

Cette voie s’appelle Chemin des Izards, dont une large portion sud commence dans Toulouse, et une autre délimite Toulouse (à gauche) et Launaguet (à droite).

À partir du filaire de voies de Toulouse métropole, je vais récupérer l’ensemble du tracé de la voie. Plutôt que lire un GeoJSON de 20 Mo, j’utilise la version GeoParquet du filaire, que j’ai ainsi réduite à 3 Mo. Comme d’habitude, je lis directement les données sur le web, ici sur data.gouv :

CREATE OR REPLACE TABLE troncons_izards_ as SELECT code_insee, street, fromleft, fromright, ST_GeomFromWKB(geometry) AS geometry FROM 'https://static.data.gouv.fr/resources/filaire-voiries-toulouse-metropole-format-geoparquet/20231219-050942/filaire-de-voirie-toulouse-met-geo.parquet' WHERE motdir LIKE 'IZARDS%' ORDER BY fromleft, fromright ;

Grace à la lecture ciblée du fichier, les seuls « row-groups » du fichier parquet qui contiennent les données seront chargés et scannés. Ainsi, 1 Mo seulement a transité par le réseau. Ceci est possible parce que j’ai constitué le fichier GeoParquet en le triant sur code_insee et motdir, champs de recherche les plus naturels.

Notez que le champ de géométrie d’un fichier GeoParquet est, selon cette spécification, encodé dans un format spécifique (le WKB). Pour le ramener au format géométrique de DuckDB spatial, il suffit de lui appliquer un ST_GeomFromWKB().

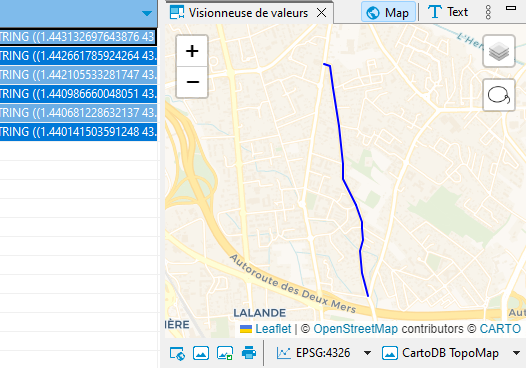

Pour isoler la partie du chemin des Izards qui est limitrophe de Toulouse et Launaguet, je cherche à identifier des doublons. En effet, ces tronçons limitrophes sont décrits deux fois dans le fichier, pour chaque commune qui gère son côté de voie.

CREATE OR REPLACE TABLE frontiere_izards AS SELECT DISTINCT a.geometry,a.fromleft,a.fromright FROM izards_troncons a CROSS JOIN izards_troncons b WHERE ST_Equals(a.geometry, b.geometry) AND a.code_insee b.code_insee ORDER BY a.fromleft, a.fromright ;Vérifions visuellement dans DBeaver : je retrouve bien la partie nord du chemin des Izards, celle qui sépare Toulouse et Launaguet :

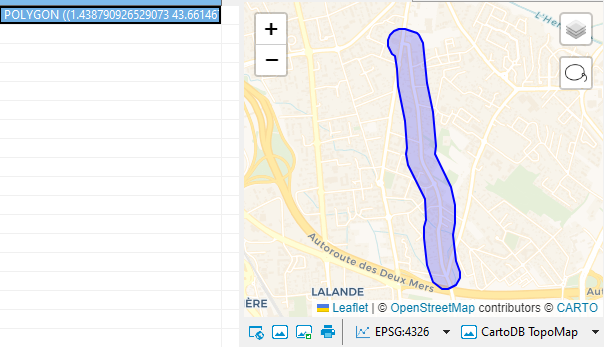

Ma deuxième entreprise consiste à élaborer un tampon de 100 mètres autour de cette voie.

Pour ce faire, je projette en coordonnées métriques avant de calculer le « buffer » :

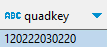

CREATE OR REPLACE TABLE buffer_izards AS SELECT ST_Union_Agg(geometry) .ST_Transform('EPSG:4326','EPSG:2154',true) .ST_Buffer(100) -- buffer de 100 mètres .ST_Transform('EPSG:2154','EPSG:4326',true) AS geom, quadkey_min_geo(geom) AS quadkey FROM frontiere_izards ;Vérifions l’allure de ce tampon, cela semble assez correct :

Indexation spatiale avec une quadkey

Indexation spatiale avec une quadkey

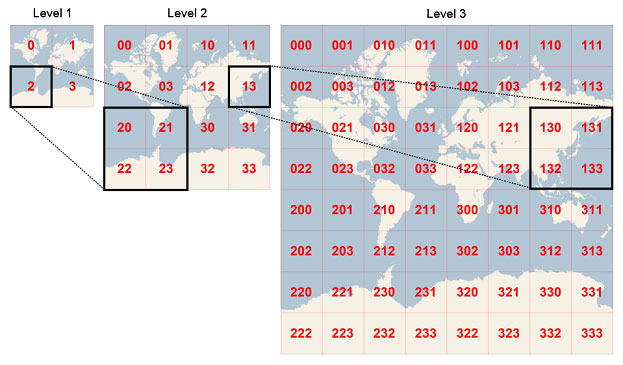

La dernière requête inclut le calcul d’une nouvelle information quadkey, qu’on appelle un index spatial. Ce quadkey suit le modèle de Microsoft avec Bing : la terre est découpée en une pyramide de quadrillages. On peut aller jusqu’au niveau 12 par exemple, et affecter à chaque petit carreau de ce niveau un code à 12 chiffres.

Bing Maps Tile System

Bing Maps Tile System