Planet GeoRezo

Agrégateur de flux RSS - Actualités et contenus géomatiques

Installer Geotrek : avec ou sans segmentation dynamique ?

hebdoOSM 789

28/08/2025-03/09/2025

Ensemble de donnĂ©es de revĂȘtement des routes, lâun des cinq outils open source prĂ©sentĂ©s par HeiGIT dans son article [1] | donnĂ©es cartographiques © NaturalEarth | donnĂ©es cartographiques © contributeurs et contributrices OpenStreetMap.

...

2025 OSMF Board Election â Online voting is open until 13 September at 16:00 UTC, when the Annual General Meeting will commence

Voting for the 2025 board election has started. You can read the board candidatesâ answers and manifestos here.

Emails were sent to eligible OSM Foundation members today, and link directly to the voting page â listing each candidate in random order and allowing you to rank the candidates in order of preference.

Eligibility to voteYou are eligible to vote in the election if

...

JournĂ©e dâĂ©tudes âLes expositions cartographiques (XIXe -XXIe siĂšcles)â, 14 novembre 2025 (Paris, INHA)

JournĂ©e dâĂ©tude de la commission « Histoire » du ComitĂ© français de Cartographie

14 novembre 2025

INHA (salle Vasari)

Galerie Colbert 2 rue Vivienne

75002 Paris

Entrée libre dans la limite des places disponibles

Â

La commission « Histoire » du CFC organise avec le soutien de la BnF, du CNRS  et lâEPHE-Histara, une journĂ©e dâĂ©tudes sur « Les expositions cartographiques » le 14 novembre 2025 Ă lâInstitut national dâhistoire de lâArt (INHA) Ă Paris.

...Correct The Map

Rentrée des cafés-géo au Flore

(Au premier étage du Café de Flore, 172 boulevard Saint-Germain, Paris 6e, Métro Saint-Germain-des-Prés, horaire : de 19h à 21h.)

Le mardi 30 septembre 2025, nous accueillerons Frédéric Encel, géopolitologue, pour réfléchir sur « Le nouveau désordre mondial).

OpenStreetMap at UN Open Source Week

by Minh Nguyá»

n

Core Software Development Facilitator, OpenStreetMap Foundation

In June, I had the privilege of representing OpenStreetMap as part of the Sovereign Tech Agencyâs delegation at UN Open Source Week in New York City. Joining me was Sarah Hoffmann, who maintains several well-known OSM software projects. This was a unique opportunity to raise OSMâs profile among global institutional supporters of open source projects and promote best practices for fostering and sustaining authentic open source communities.

...SynthĂšse dâexpert sur lâĂ©dition 2025 du geOcom

La communautĂ© geOrchestra, composĂ©e de dĂ©veloppeurs et dâutilisateurs (principalement les administrateurs de plateformes de donnĂ©es), sâest rĂ©unie en Bretagne du 23 au 25 juin lors de son Ă©vĂšnement annuel Ă Rennes, lĂ oĂč geOrchestra est nĂ© une quinzaine dâannĂ©es plus tĂŽt. Le comitĂ©Â de pilotage geOrchestra a bĂ©nĂ©ficiĂ© de lâaccueil de Rennes MĂ©tropole. Dans le [âŠ]

The post SynthĂšse dâexpert sur lâĂ©dition 2025 du geOcom first appeared on AfigĂ©o.

Vandoeuvre-lĂšs-Nancy: RĂ©union OpenStreetMap, Le mercredi 26 novembre 2025 de 18h00 Ă 20h00.

Le groupe local Nancy de lâassociation OpenStreetMap France vous propose de participer aux rĂ©unions mensuelles ouvertes Ă tou·te·s !

Avec OpenStreetMap, participez Ă la construction dâune carte en ligne libre et gratuite, partagĂ©e avec le monde entier!

Participation aux ateliers

Le lieu la Fabrique des possibles nous est librement accessible lors de nos réunions.

Si vous souhaitez participer à distance, cela est possible depuis ce lien. Toutefois merci de nous en avertir pour que nous nous organisions en nous équipant et installant le matériel nécessaire.

Mises Ă jour septembre 2025

AAC â JournĂ©e dâĂ©tude âPopCartographie : cartes et culture populaire (XIXe-XXIe siĂšcle)â â date butoir : 10 novembre 2025

Â

Â

Â

Â

La commission « Histoire » du ComitĂ© Français de Cartographie et la BibliothĂšque nationale de France sâassocient pour organiser une journĂ©e dâĂ©tudes Ă lâoccasion de lâexposition Cartes imaginaires, imaginaire des cartes (24 mars â 19 juillet 2026). La journĂ©e se tiendra le 10 avril 2026 sur le site François-Mitterrand de la BnF Ă Paris

Argumentaire

...Bonjour tout le monde !

Bienvenue sur WordPress. Ceci est votre premier article. Modifiez-le ou supprimez-le, puis commencez à écrire !

The post Bonjour tout le monde ! appeared first on DataGrandEst.

Collectif CICCLO â SynthĂšse des rĂ©unions et feuille de route 2025/2026

Le Collectif CICCLO a enchaĂźnĂ© plusieurs rĂ©unions stratĂ©giques (6 & 26 juin, 29 aoĂ»t 2025) qui marquent une nouvelle Ă©tape pour la valorisation et lâĂ©volution des plateformes de donnĂ©es rĂ©gionales. Ces Ă©changes, dans la continuitĂ© des projets FINDPE 2024, ont permis de dresser un bilan, dâidentifier de nouveaux axes de travail et de tracer une [âŠ]

The post Collectif CICCLO â SynthĂšse des rĂ©unions et feuille de route 2025/2026 first appeared on AfigĂ©o.

La base des dĂ©cĂšs : un symbole mĂ©connu de lâopen data

La base nationale des dĂ©cĂšs est un ovni statistique : câest une des rares bases open data France entiĂšre qui dĂ©crive des personnes avec leurs nom et prĂ©noms en clair. Aussi surprenant que cela puisse paraitre, les fichiers de lâInsee relatifs aux personnes dĂ©cĂ©dĂ©es ne constituent pas des donnĂ©es Ă caractĂšre personnel. Ils ne relĂšvent pas du secret de la vie privĂ©e, ce dernier ne protĂ©geant que les individus en vie. La loi Informatique et LibertĂ©s (loi n° 78-17 du 6 janvier 1978) sâapplique uniquement aux donnĂ©es concernant des personnes vivantes.

La base des dĂ©cĂšs comprend aujourdâhui prĂšs de 29 millions de dĂ©cĂšs survenus aprĂšs 1970. Câest lâannĂ©e Ă partir de laquelle les communes ont systĂ©matiquement transmis les mentions de dĂ©cĂšs Ă un rĂ©pertoire national gĂ©rĂ© par lâInsee.

...

Le fond Open Basemap et les styles associés sont disponibles dans ArcGIS

Lire la suite â

hebdoOSM 788

21/08/2025-27/08/2025

[1] Vue du globe avec les dalles vectorielles réalisées par SomeoneElse | © SomeoneElse | Données cartographiques © Contributeurs et contributrices OpenStreetMap.

...

Lyon: OpenStreetMap, rencontre mensuelle, Le mardi 16 décembre 2025 de 18h30 à 20h00.

Discussion entre contributeurs lyonnais du projet OSM et acteurs intéressés.

Toute personne intéressée par OpenStreetMap peut s'intégrer à cette rencontre, tout particuliÚrement les débutants qui souhaiteraient des conseils pour se lancer.

Ordre du jour à compléter: https://wiki.openstreetmap.org/wiki/FR:Lyon/Reunion-2025-12-16

Lieu de réunion: Tubà , 15 boulevard Vivier-Merle, Lyon 3e.

Lyon: OpenStreetMap, rencontre mensuelle, Le mardi 18 novembre 2025 de 18h30 Ă 20h00.

Discussion entre contributeurs lyonnais du projet OSM et acteurs intéressés.

Toute personne intéressée par OpenStreetMap peut s'intégrer à cette rencontre, tout particuliÚrement les débutants qui souhaiteraient des conseils pour se lancer.

Ordre du jour à compléter: https://wiki.openstreetmap.org/wiki/FR:Lyon/Reunion-2025-11-18

Lieu de réunion: Tubà , 15 boulevard Vivier-Merle, Lyon 3e.

Action requise pour les organisations ArcGIS Online utilisant SAML

Les administrateurs d'organisation ArcGIS Online qui ont activé les assertions signées et/ou chiffrées conformément aux bonnes pratiques d'ArcGIS Online pour la sécurité SAML doivent obtenir le nouveau fichier de métadonnées + certificat du fournisseur de services ArcGIS Online et l'associer à leur fournisseur d'identité SAML (par exemple, ...

Geodatadays à vélo

Conseils & Astuces ArcGIS Online - N°207

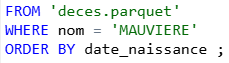

Dans ce précédent article, je vous présentais la notion trÚs puissante d'expression de données dans ArcGIS Dashboards ainsi que l'interface permettant de les créer. Dans cet article, je vous propose un exemple d'expression de données permettant de combiner (assembler) plusieurs jeux de données avant de les utiliser dans votre tableau de bord.

Exemple:

Je dispose de plusieurs jeux de donnĂ©es contenant l'inventaire des maternitĂ©s en France pour diffĂ©rentes annĂ©es de 2019 Ă 2023.Â

2019Â Â Â Â Â Â Â Â Â Â Â Â Â Â Â

Profils et indice de vulnĂ©rabilitĂ©s socio-sanitaires liĂ©es aux maladies diarrhĂ©iques en zone rurale par lâapproche des livelihoods (commune de Boussouma, Burkina Faso)

En 2021, les estimations de dĂ©cĂšs en Afrique liĂ©es aux maladies diarrhĂ©iques Ă©taient de 441 139. Cette situation est liĂ©e Ă la contamination fĂ©cale de lâeau, des aliments et des mains modulĂ©es selon des critĂšres relatifs aux vulnĂ©rabilitĂ©s socio-sanitaires. Or, malgrĂ© un consensus sur les principaux facteurs qui influencent ces vulnĂ©rabilitĂ©s (Ăąge, genre, accĂšs Ă lâeau potable, etc.), il nâexiste pas dâindice synthĂ©tique pour dĂ©finir leurs niveaux.

Pour y rĂ©pondre, le cadre des livelihoods et son approche par capitaux ont Ă©tĂ© adaptĂ©s et appliquĂ©s dans la rĂ©gion rurale de BagrĂ© (Burkina Faso). Des entretiens semi-directifs adossĂ©s Ă un SIG Ă dires dâacteurs ont Ă©tĂ© rĂ©alisĂ©s pour rĂ©vĂ©ler des profils et un indice de vulnĂ©rabilitĂ©s socio-sanitaires respectivement Ă lâĂ©chelle du mĂ©nage et de la localitĂ© a Ă©tĂ© gĂ©nĂ©rĂ©. Les cas de diarrhĂ©es hebdomadaires ont Ă©galement Ă©tĂ© colle...

Configuration dâun environnement dâannotation sous QGIS

Conseils & Astuces ArcGIS Online - N°206

N°206 - Expressions de données ArcGIS Dashboards - Faire pivoter les données de votre table

...Annotation GĂ©oIA

FOSS4G Belgium

FOSS4G Belgium organisĂ© par OSGeo.be a lieu jeudi 25 septembre 2025 Lieu : track.brussels â dans la gare mĂȘme de Bruxelles !

Oslandia a le grand plaisir de participer à cette édition trÚs spéciale, Foss4G célÚbre son 10Úme anniversaire ! avec deux conférences :

...

Conseils & Astuces ArcGIS Online - N°205

Dans ce précédent article, je vous présentais la notion trÚs puissante d'expression de données dans ArcGIS Dashboards ainsi que l'interface permettant de les créer. Dans cet article, je vous propose un exemple d'expression de données permettant de réaliser une jointure entre deux sources de données avant d'utiliser le résultat de cette jointure dans votre tableau de bord.

Exemple:

Je dispose d'une couche contenant les contours des ilots statistiques IRIS de l'INSEE. Ces derniers contiennent notamment le code et le nom de l'IRIS ai...

State of the Map 2025: Call for Posters

Did you miss the call for general and OSM Science presentations? Fret not! You can still present your project and initiatives at State of the Map 2025! The Call for Posters for SotM 2025 is now open!

Your poster could show how well your community is mapped. It could be a new beautiful style or a map. It could be a community project or statistics, or a poster explaining and inviting people to OpenStreetMap. The important thing is that it is about OSM. We also welcome academic posters on research around OpenStreetMap data.

For inspiration, you can check out the SotM 2024 posters â https://2024.stateofthemap.org/posters/

...

Changement de nom des flux du MNHN

Apply to be the OpenStreetMap Core Software Engineer

We are not accepting applications for this role at this point. Thank you to all who have applied.

OpenStreetMap powers maps and services used by millions of people around the world every day. To better support the community that makes this possible, the OpenStreetMap Foundation is seeking a dedicated mid- to senior-level software engineer with a passion for open data, collaborative software, and digital commons.

The ideal candidate is proficient in modern Web development (frontend and backend), experienced with open source collaboration, and comfortable working in public repositories with community feedback.

...

Mises à jour août 2025

LiDAR HD et végétation urbaine : enseignements du webinaire du 5 juin 2025

La création in situ sert-elle vraiment le rayonnement des espaces périphériques ?

Les projets dâart in situ dans les espaces pĂ©riphĂ©riques permettent dâanimer le territoire et de crĂ©er de nouvelles ressources territoriales faisant Ă©cho Ă plusieurs enjeux socio-environnementaux. Ă partir dâune base de donnĂ©es crĂ©Ă©e pour les recenser, cet article identifie 226 lieux artistiques localisĂ©s dans des espaces pĂ©riphĂ©riques (essentiellement en Europe et AmĂ©rique du Nord), sĂ©lectionnĂ©s au titre des pratiques in situ mises en Ćuvre par leurs 2 016 artistes associĂ©s. Un rĂ©fĂ©rencement de 2 646 Ćuvres/projets in situ originaux a Ă©tĂ© effectuĂ© sur un Ă©chantillon dâenviron un tiers des lieux artistiques, soit 65 entrĂ©es regroupant 80 % des artistes, soit 1 645 individus. Une enquĂȘte de terrain a Ă©tĂ© effectuĂ©e dans 25 de ces lieux. Plusieurs mĂ©thodes de traitements statistiques, notamment lâanalyse de rĂ©seau, ont permis dâexaminer les circulations artistiques et les rĂ©sea...

RĂ©inscrire les mobilitĂ©s quotidiennes dans leurs contextes. Une typologie des journĂ©es de travail des navetteurâ ses en France

Face Ă lâaugmentation des coĂ»ts de lâĂ©nergie et Ă lâurgence de la transition Ă©cologique, le sujet des dĂ©placements domicile-travail est dâune actualitĂ© nouvelle. Pour mieux saisir les enjeux de ces transformations en cours, cet article analyse les pratiques de mobilitĂ© quotidienne en les recontextualisant dans le cadre plus large de la journĂ©e de travail au cours de laquelle elles sâinscrivent. Sâappuyant sur un corpus important de recherches ayant examinĂ© les distances domicile-travail parcourues dans divers contextes, il met Ă©galement en lumiĂšre des dimensions souvent nĂ©gligĂ©es telles que les pĂ©riodes de prĂ©sence, les chaĂźnages dâactivitĂ©s ou les horaires de dĂ©placement.

Lâarticle sâappuie sur 67 enquĂȘtes de mobilitĂ©s conduites en France de 2008 Ă 2019 et propose Ă partir de ce large corpus une typologie construite Ă lâaide dâune analyse factorielle et dâune classification par k-moyennes. Tout en re...

Cartographie web, santĂ© publique et littoral : un partenariat durable entre Neogeo et lâARS Bretagne

Depuis plus de 6 ans, Neogeo a le privilĂšge dâaccompagner lâAgence RĂ©gionale de SantĂ© Bretagne dans la conception, la mise en Ćuvre et la maintenance dâun outil numĂ©rique innovant : PĂȘche Ă pied responsable, un portail cartographique dĂ©diĂ©e Ă la sensibilisation des pĂȘcheurs Ă pied sur les recommandations sanitaires liĂ©es Ă la qualitĂ© des zones littorales.

En mars 2025, lâARS Bretagne a renouvelĂ© sa confiance en Neogeo pour assurer la maintenance Ă©volutive de la plateforme, preuve dâune collaboration solide et durable au service de lâintĂ©rĂȘt gĂ©nĂ©ral.

...Ăvolutions de la suite OGS (Versions 1.4 et 1.5)

La plateforme Territoriale de lâInformation GĂ©ographique de Guyane continue dâĂ©voluer. Les versions OGS 1.4 (mars 2025) et OGS 1.5 (juillet 2025) apportent plusieurs nouveautĂ©s destinĂ©es Ă amĂ©liorer lâexpĂ©rience des utilisateurs, aussi bien cĂŽtĂ© consultation que publication des donnĂ©es.

NouveautĂ©s OGS 1.4Â

...

Vector Tiles are deployed on OpenStreetMap.org

We are happy to announce the deployment of Vector Tiles on OpenStreetMap Foundation servers and the publication of the layer on the OSM website! We have been working hard to bring you a fresh look to OSM data, paired with exciting technological upgrades.

...Land exchange, a lever for the agroecological transition of livestock farming?

Agriculture both contributes to and suffers from climate disruptions and biodiversity loss. To address these challenges, agricultural practices are evolving, particularly through the agroecological transition, which integrates agronomic and ecological knowledge. However, the land-use dimension â specifically parcel distribution â remains underexplored in research, despite its crucial role in this transition. This article examines the benefits and limitations of farmland exchanges in reducing greenhouse gas emissions, preserving biodiversity-friendly habitats, and improving farmers' working conditions. It is based on an analysis of dairy farming in the Zone Atelier Armorique, drawing on interviews with (para-)public agencies responsible for agricultural land management in Ille-et-Vilaine. Combining insights from ecology, geography, and law, the study first highlights how land exchanges support farmers, enhance carbon storage, and benefit species depe...

State of the Map 2026 â Call for Venues is now open

Weâre excited to invite bids for the next State of the Map conference, taking place in 2026. This is a unique opportunity to partner with us and host the conference in your city!

...

Dates de fauche en France

[Replay] Webinaire 3D open source : une nouvelle dimension !

Vous étiez nombreux à participer à notre webinaire « 3D : une nouvelle dimension ! »

ïžVincent Picavet Ă©tait au micro :

- les enjeux de la 3D en 2025 : jumeaux numériques, publier de la donnée sur le web, partager la donnée, gérer la volumétrie, mutualiser les outils en OpenSource

- des cas dâusages

- la présentation des composants OpenSource made in Oslandia : Giro3D, Piero, py3Dtiles, CityForge

Le replay est disponible aprĂšs avoir rĂ©pondu Ă un rapide questionnaire.Â

Vous souhaitez avancer sur ces sujets et Ă©changer sur vos projets 3D ?

ïžContactez-nous : infos+3d@oslandia.com

[Replay] Webinar « Security Project for QGIS »

Do you deal with sensitive geospatial data ? Are you concerned by cybersecurity threats ?

Oslandia and partners ( e.g. OPENGIS.ch) launched the « Security Project for QGIS » : a mutualized funding effort to increase QGIS cybersecurity.

ïžDuring this webinar, Vincent Picavet first presented the context of the project : new regulations are coming ( CRA, NIS2 ), cyberattacks increase, software see a growing complexity, and QGIS legacy makes it difficult to increase security ⊠and its benefits !

You can access the replay for free, after filling in a quick survey.Â

...Geotrek-Mobile, zones sensibles désormais accessibles

Publication du rapport annuel du CNIG 2024

![[Ăquipe Oslandia] Bertrand Parpoil, CEO](https://s.w.org/images/core/emoji/11/72x72/1f642.png)

[Ăquipe Oslandia] Bertrand Parpoil, CEO

AprĂšs une prĂ©pa en biologie, Bertrand devient IngĂ©nieur Agronome (Bordeaux Sciences Agro) oĂč il choisit de se spĂ©cialiser en troisiĂšme annĂ©e, dans la cartographie et les outils informatiques appliquĂ©s Ă lâagriculture.

« La maniĂšre dont on utilise les outils informatiques dans le secteur agricole ou lâenvironnement, mâintĂ©ressaient beaucoup ».

La pĂ©riode est par ailleurs favorable et Ă©volue vite. Nous sommes au dĂ©but des annĂ©es 2000, câest la gĂ©nĂ©ralisation des SIG dans les entreprises et administrations, et la naissance de QGIS et PostGIS !

DiplĂŽme en poche, Bertrand se tourne vers le journalisme et alimente un mĂ©dia sur les nouvelles technologies en agriculture. « Câest un mĂ©tier complĂštement diffĂ©rent de celui vers lequel je mâorientais avec mon diplĂŽme dâingĂ©nieur ».

...

La cartographie comme trace des parcours dâexil

Le billet ci-dessous est une retranscription de lâentretien rĂ©alisĂ© pour le centre Primo Levi. Le Centre Primo Levi a Ă©tĂ© crĂ©Ă© en 1995 par 5 associations engagĂ©es dans le domaine de la santĂ© et de la dĂ©fense des droits humains : Amnesty International France, MĂ©decins du Monde, lâAction des ChrĂ©tiens pour lâabolition de la torture (ACAT-France), Juristes sans frontiĂšres et TrĂȘve. Câest une association de rĂ©fĂ©rence spĂ©cifiquement dĂ©diĂ©e au soin et au soutien des personnes victimes de la torture et de la violence politique exilĂ©es en France. Cet entretien a Ă©tĂ© publiĂ© dans le numĂ©ro 91 de la revue MĂ©moires.Â

Climadiag Agriculture : nouvelles fonctionnalités

The 2025 OpenStreetMap EWG Microgrant Program

Have a bold, brilliant idea that could improve the OpenStreetMap (OSM) ecosystem? Got a vision for the future of OSM? Then weâve got good news for you: the OpenStreetMap Foundation is thrilled to launch the 2025 edition of our Engineering Microgrants program!

This program is designed to support community members working on software projects that strengthen the OSM platform and ecosystem. Weâre setting aside a total of ÂŁ30,000, which may be distributed across several innovative and impactful projects. The per-project limit is ÂŁ6,000, but if your idea goes beyond that, donât hold back! The Engineering Working Group (EWG) may explore other funding avenues through the Foundation to help bring ambitious proposals to life. As such, weâd still encourage you to apply.

Whatâs the Process?

Itâs simple and fair:

...Revue de presse du 11 juillet 2025

Mise Ă jour du TileMatrixSet pour la couche ORTHOIMAGERY.ORTHOPHOTOS

Geotrek-Mobile Ă©volue avec les contenus outdoor

Webinaire applications thématiques (09/07/2025)

Le mercredi 09 juillet 2025, un nouveau webinaire de formation aux applications thématiques de Guyane-SIG (https://guyane.monterritoire.fr/) a été organisé. Une trentaine de participants ont été formés à cet outil, représentant plus de 19 organismes partenaires durant l'évÚnement organisé exclusivement en distanciel. Ils ont pu découvrir ou redécouvrir les fonctionnalités et données proposées, ainsi que les quelques nouveautés ergonomiques de l'interface (cf. article : Mise à jour applications thématiques (07/2025)).

Si vous souhaitez participer Ă une prochaine session, nâhĂ©sitez pas Ă demander votre inscription Ă la liste de diffusion dĂ©diĂ©e en remplissant le formulaire en ligne : https://forms.gle/3b89ysi86T6etCb79Â

Pour toute question, lâĂ©quipe Guyane-SIG reste Ă votre disposition (guyane-sig@ctguyane.fr).

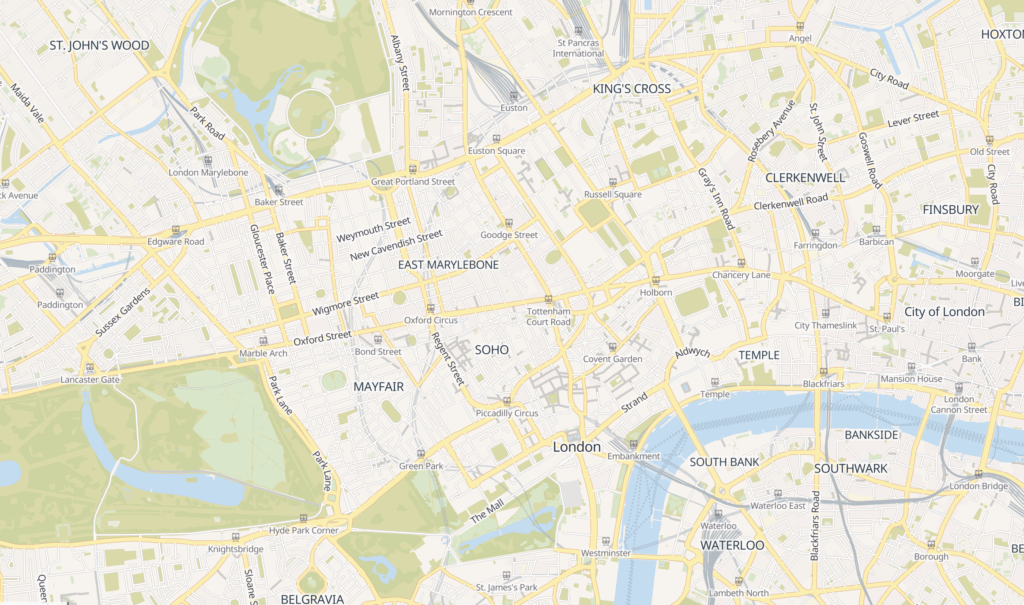

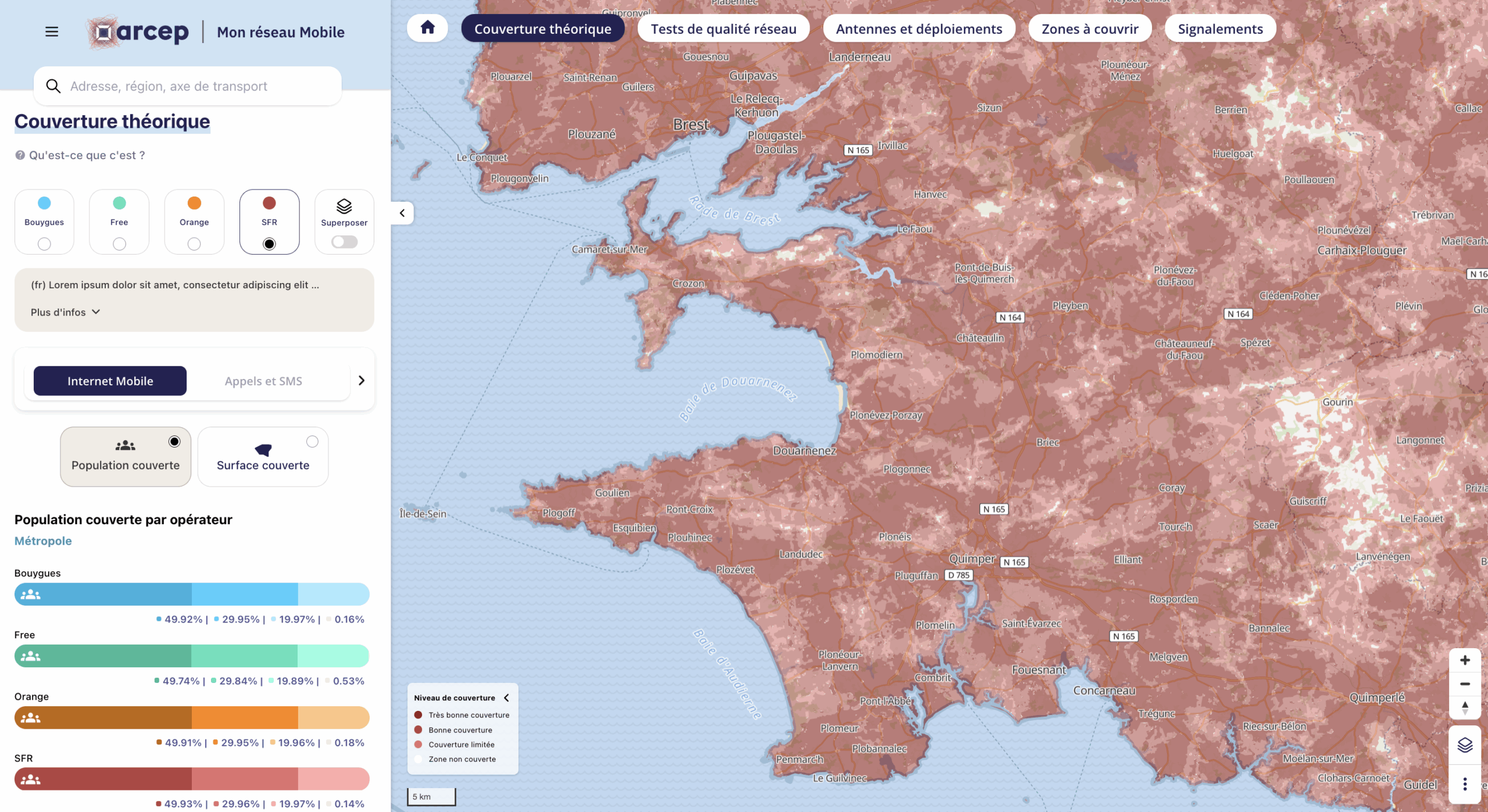

Refonte du site « monreseaumobile.fr » pour lâARCEP

Dans le cadre dâune dĂ©marche de transparence, de rĂ©gulation par la donnĂ©e et de meilleure comprĂ©hension des infrastructures numĂ©riques sur le territoire, NEOGEO a collaborĂ© avec lâArcep, le rĂ©gulateur des tĂ©lĂ©coms sur la refonte complĂšte du site https://monreseaumobile.arcep.fr/, mis en ligne le 9 juillet 2025. A noter « Mon rĂ©seau mobile » est le premier outil de « rĂ©gulation par la donnĂ©e » dĂ©veloppĂ© par lâArcep, au service de sa stratĂ©gie « Ambition 2030 ».

Une interface au service de lâintĂ©rĂȘt gĂ©nĂ©ral

...Webinaires sur le suivi de la déforestation en Guyane (27/06/2025)

Dans le cadre de lâanimation de la communautĂ© « Applisat â Utilisateurs du satellitaire » portĂ©e par Expertises-Territoires, le Commissariat GĂ©nĂ©ral au DĂ©veloppement Durable (CGDD) du MinistĂšre de la Transition Ă©cologique et le CEREMA, en partenariat avec la DGSRC Guyane, organisaient un cycle de deux webinaires les 27 juin et 8 juillet, dĂ©diĂ© au suivi de la dĂ©forestation tropicale depuis lâespace.

Le 27 juin 2025 a eu lieu le premier webinaire du cycle : « La Guyane sous surveillance : apport des données satellitaires pour la lutte contre l'orpaillage illégal et la déforestation ».

...

Ăvolution du jour de dĂ©neigement dans les Alpes françaises et les PyrĂ©nĂ©es

La majoritĂ© de la planĂšte reconnaĂźt dĂ©jĂ Â lâĂtat palestinien

En 2025, 158 pays dans le monde ont dâores et dĂ©jĂ officiellement reconnu lâĂtat de Palestine. Il sâagit principalement de pays du Sud, mais Ă©galement dâĂtats europĂ©ens dâEurope de lâEst, rejoints rĂ©cemment par lâEspagne, lâIrlande et la NorvĂšge. Cette reconnaissance massive reflĂšte une dynamique mondiale irrĂ©pressible en faveur du droit du peuple palestinien Ă lâautodĂ©termination.Â

https://observablehq.com/embed/@neocartocnrs/palestine@289?cells=viewof+year%2Cmap

Ce mouvement est irrĂ©sistible. Il sâinscrit dans une histoire longue de luttes contre la domination coloniale et pour le droit des peuples Ă disposer dâeux-mĂȘmes.Â

Â

La France ne peut plus rester Ă lâĂ©cart de ce mouvement, sauf Ă sâisoler sur la scĂšne internationale et Ă trahir les valeurs quâelle prĂ©tend incarner.Â

Les nouveautés Giro3D 0.43

AprÚs un long cycle de développement, Giro3D 0.43 est disponible !

LâentitĂ© GlobeNous vous en parlions prĂ©cĂ©demment dans un article approfondi, la principale nouveautĂ© de cette version est bien sĂ»r lâentitĂ© Globe, permettant de reprĂ©senter une planĂšte ou mĂȘme une Ă©toile ou tout astre de votre choix.

DotĂ© de la mĂȘme API que lâentitĂ© Map, elle peut contenir une couche dâĂ©lĂ©vation permettant de reprĂ©senter du terrain, ainsi quâun nombre illimitĂ© de couches de couleur (image satellite, carte, vecteurs, couche nuageuseâŠ).

Effets atmosphĂ©riquesEn complĂ©ment du Globe, vous pourrez Ă©galement habiller vos globes dâeffets atmosphĂ©riques avec 3 nouvelles entitĂ©s:

...

Manuel de cartographie, 2e Ă©dition

Camarades cartographes, jâai le plaisir de vous annoncer la parution de la seconde Ă©dition du Manuel de cartographie, coĂ©crit avec Christine Zanin. EntiĂšrement revue, corrigĂ©e et enrichie, cette nouvelle Ă©dition sâouvre sur une prĂ©face de Georg Gartner, prĂ©sident de lâAssociation cartographique internationale (ACI). Depuis sa premiĂšre publication en 2016, le manuel a Ă©tĂ© actualisĂ© pour intĂ©grer les Ă©volutions majeures de la discipline. Il comprend dĂ©sormais plus de 160 figures en couleurs â contre 120 dans lâĂ©dition prĂ©cĂ©dente. Toutes les illustrations ont Ă©tĂ© mises Ă jour, amĂ©liorĂ©es, et complĂ©tĂ©es par de nouvelles cartes et schĂ©mas. Cette richesse graphique â 160 figures rĂ©parties sur 250 pages â fait vraiment la force de cet ouvrage.

...

Spatialisation avec Arabesque dâun rĂ©seau de collaborations scientifiques sur les Ăźlots de chaleur urbains

Je dĂ©die ce court billet Ă Anne RUAS, en mĂ©moire de ses superbes confĂ©rences Ă©noncĂ©es lors de la semaine de lâinformation gĂ©ographique qui sâest tenue en mai 2025 Ă Avignon, et qui mâont fait prendre la mesure de ce phĂ©nomĂšne dâĂźlot de chaleur urbain.

Vous qui ĂȘtes actuellement en ville, comme moi, nâavez-vous pas trop chaud depuis quelques jours ?

Comment faire pour avancer dans la connaissance et la comprĂ©hension de cette Ă©lĂ©vation des tempĂ©ratures en ville, de ce phĂ©nomĂšne dâĂźlots de chaleur urbains qui nous terrasse actuellement ? Saviez-vous que câest lâobjectif de nombreuses collaborations scientifiques ?

Spatialisation des trajets de covoiturage avec Arabesque

En tous les cas, il semblerait que de multiples voyageurs covoiturent réguliÚrement, ce qui génÚre des centaines de milliers de trajets parcourus qui sont mis à disposition dans le registre de preuve du covoiturage.

Quelques 450 000 dâentre eux, observĂ©s en aoĂ»t 2022 entre 7800 localitĂ©s de France, avaient dâailleurs pu ĂȘtre cartographiĂ©s lors de la JournĂ©e dâĂ©tudes de lâaction de recherches (carto)graphies et (gĂ©o)visualisation (ar9MAGIS) organisĂ©e Ă Rennes en janvier 2023, en utilisant ⊠Arabesque.

Trajets de covoiturage effectuĂ©s en France en aoĂ»t 2022   Lire la suite â

Mises Ă jour juillet 2025

[Le blog SIG & URBA] "GeoPhotos"

- des clichés pris depuis la voie publique,

- sous forme de traces, de séquences de photos, à 360°, ou pas !

- ou sous forme de photos plus ponctuelles,

- et mises Ă disposition de tous.

Il faut juste une photo prise Ă ...

Mise Ă jour des sentiers PDIPR (06/2025)

Dans le cadre de la lĂ©gislation relative aux chemins de randonnĂ©e, la CollectivitĂ© Territoriale de Guyane (CTG), en charge de la mise en Ćuvre du Plan DĂ©partemental des ItinĂ©raires de Promenade et de RandonnĂ©e (PDIPR), amĂ©nage, valorise et entretient quatorze itinĂ©raires rĂ©partis sur le territoire.

Le PDIPR recense les chemins ruraux pouvant servir de support à divers circuits (randonnée pédestre, équestre, VTT ou trail).

Câest un outil Ă©volutif, mis Ă jour en fonction des dĂ©libĂ©rations de la CTG. Indispensable Ă la crĂ©ation, la protection et la valorisation des chemins de randonnĂ©e, le PDIPR poursuit plusieurs objectifs :

...Mise à jour applications thématiques (07/2025)

Au cours du deuxiÚme trimestre de 2025, de nouvelles données ont été actualisées et ajoutées sur les applications thématiques de Guyane-SIG :

Mises à jour de données précédentes :

- Le PLU de Saint-Laurent du Maroni : Dans la catégorie « Urbanisme (communes) », dont la derniÚre procédure a été approuvée le 12/11/2024.

- Les « ItinĂ©raires de randonnĂ©es » : Dans la catĂ©gorie « Patrimoine touristique et loisirs », elle recense les ItinĂ©raires de randonnĂ©es terrestres mais aussi quelques itinĂ©raires fluviaux, dont les sentiers classĂ©s PDIPR sur le territoire.Â

Nouvelles données :

...La Plateforme Digitale Collaborative (PDC) : un outil numérique au service de la gouvernance urbaine au Cameroun

Cette plateforme vise Ă renforcer la gouvernance urbaine au Cameroun en facilitant la mise en rĂ©seau, le partage dâinformations et la transparence entre les multiples acteurs du dĂ©veloppement des villes. La PDC reprĂ©sente la brique numĂ©rique du projet PUC, et constitue une avancĂ©e majeure dans la structuration des donnĂ©es et la collaboration entre institutions, collectivitĂ©sâŠ

GeoDataDays 2025

Oslandia est cette année encore sponsor des GéoDataDays qui se tiendront les 10 et 11 septembre 2025 à Marseille ! Cette 8Úme édition portera sur la thématique « Agir dans un monde en évolution : indispensables geodata ».

Certains de nos projets comme la GĂ©oplateforme de lâIGN, ou Terristory pour la transition Ă©nergĂ©tique, montrent que les geodata sont en effet nĂ©cessaire pour anticiper lâavenir.

De plus, dans un monde incertain, les logiciels pour exploiter ces données sont également critiques : notre vision SIG OpenSource permet la souveraineté, la mutualisation, la démocratisation des usages, la montée en compétences, la contribution aux communs et la responsabilité environnementale.

...[Ăquipe Oslandia] Christophe Damour, ingĂ©nieur senior

AttirĂ© par le concret, Christophe dĂ©cide de devenir IngĂ©nieur en GĂ©nie MĂ©canique. Il choisit pour cela lâuniversitĂ© de Technologie de CompiĂšgne, la seule universitĂ© (Ă lâĂ©poque ;)) qui dĂ©livre un diplĂŽme dâingĂ©nieur et qui propose par ailleurs une ouverture aux Sciences Humaines dans son cursus.

DiplĂŽme en poche, Christophe commence son parcours professionnel Ă Bordeaux dans une filiale du groupe EGIS, spĂ©cialisĂ©e dans lâingĂ©nierie des dĂ©placements oĂč il dĂ©veloppe des outils pour la gestion de la signalisation et de la sĂ©curitĂ© routiĂšre.

« Jâai dĂ©couvert les SIG en 1991 ! les technologies gĂ©ospatiales se rĂ©sumaient Ă de gros systĂšmes accessibles seulement aux plus grandes collectivitĂ©s, le systĂšme APIC pour ceux qui se souviennent ! »

...

De nouvelles bases de donnĂ©es au service de la dĂ©tection des forĂȘts subnaturelles

SĂ©minaire, juin 2025

Cette année, cap sur Bazas pour le séminaire NEOGEO 2025 !

Entre traditions du Sud-Ouest, dĂ©couvertes Ćnologiques et rĂ©flexions professionnelles, les Ă©quipes de Neogeo ont vĂ©cu un moment riche en couleurs et en saveurs.

Ces quelques jours ont Ă©tĂ© lâoccasion de partager des ateliers dynamiques, des Ă©changes nourris⊠et mĂȘme dâen apprendre un peu plus sur nous et lâart du vin (et pas seulement sa gĂ©ographie !).Â

Un grand merci Ă tous les participants pour leur implication, leur Ă©nergie, et leurs nuances â car chaque personnalitĂ© a su ajouter sa touche de couleur Ă ce moment collectif.Â

...RĂ©parer la ville aprĂšs le passage de la COVID. Cartographie comparative et collaborative Ă Mexico et ailleurs

Ă partir dâune reprĂ©sentation cartographique collaborative des expĂ©riences vĂ©cues durant la pandĂ©mie de COVID-19 Ă Mexico, HanoĂŻ, MontrĂ©al et Paris, ainsi que de deux ateliers de cartographie collaborative menĂ©s auprĂšs de groupes de femmes vivant Ă Mexico, cet article analyse la puissance que revĂȘt le langage cartographique pour transcender les diffĂ©rences de langues, de disciplines, de positionnalitĂ©s et de cultures. Il dĂ©montre lâimportance de la cartographie dans un processus de comparaison Ă lâĂ©chelle mondiale. Les cartes analysent les stratĂ©gies que les gens ont imaginĂ©es pour composer avec les bouleversements de leur vie au moyen de gestes de rĂ©paration qui, mĂȘme microscopiques, ont fait Ă©merger une ville bienveillante.

Cartographie des territorialitĂ©s de jeunes Autochtones de MontrĂ©al/TiohtĂ :ke : appropriation spatiale et transgression de lâordre colonial

Cet article prĂ©sente un processus de cartographie participative qui cherche Ă visibiliser les territorialitĂ©s de jeunes Autochtones de MontrĂ©al/TiohtĂ :ke. Ce projet de recherche se veut une rĂ©ponse critique Ă la colonialitĂ© des espaces urbains, de la ville de MontrĂ©al en particulier. Ce processus a impliquĂ© 18 jeunes de diffĂ©rentes nations autochtones vivant Ă MontrĂ©al. La cartographie a dâabord Ă©tĂ© utilisĂ©e par les cochercheur·euse·s pour exprimer individuellement leurs territorialitĂ©s, puis afin de rassembler leurs rĂ©cits en un rĂ©cit collectif, qui a permis une appropriation de la ville.

Le Projet Joshua, la cartographie au service de lâĂ©vangĂ©lisation de la planĂšte

Le Projet Joshua est une initiative de recherche visant Ă recenser les groupes ethniques du monde afin dâidentifier ceux qui comptent le moins de disciples du Christ. Il compte 17 429 « Groupes de peuples », dont 7 417 « Groupes non atteints » (42,6 %), qui totalisent 3,37 milliards dâhabitants (42,5 % de la population mondiale) et Ă©labore des bases de donnĂ©es (librement tĂ©lĂ©chargeables) Ă utiliser par les agences missionnaires pour y accĂ©lĂ©rer la progression de lâĂvangile. Il est paradoxal en ce quâil met des techniques gĂ©omatiques irrĂ©prochables au service dâun projet dâĂ©vangĂ©lisation dont les racines sont pour le moins anciennes.

Ătre jeunes au bon endroit ? Cartographie critique des espaces nĂ©gatifs pour les jeunes Ă Saint-LĂ©onard (MontrĂ©al)

Le changement socio-dĂ©mographique majeur caractĂ©risant lâarrondissement de Saint-LĂ©onard (Canada) affecte la relation des jeunes issus de lâimmigration Ă lâespace public. Ă partir dâobservations, de groupes de discussion par photovoix et dâentretiens semi-dirigĂ©s, nous avançons que les espaces publics dĂ©diĂ©s aux jeunes sont limitĂ©s et limitants. Nous proposons une cartographie critique des espaces dits nĂ©gatifs du quartier afin dâinformer et dâinfluencer la planification des espaces publics.

Atlas de la grotte Chauvet, ou Monographie de la grotte Chauvet-Pont dâArc

Nous pourrions ĂȘtre surpris par cet ouvrage colossal, publiĂ© en octobre 2020 aux Ăditions de la Maison des Sciences de lâHomme Ă lâissue de 6 ans de travail. Pesant cinq kilos et demi, dotĂ© de 400 pages au format 34 cm x 48 cm, avec 105 cartes et 600 illustrations, le livre nous affirme dĂšs sa couverture quâil nâest que le premier volume dâune longue aventure Ă©ditoriale. Sa lecture sollicite une certaine logistique : quel fauteuil, quelle table ou bureau choisir pour sây plonger sereinement ?

...

Les nouvelles passerelles parisiennes. Hétérotopie, imaginaire, ciné-tourisme

Paris possĂšde une notoriĂ©tĂ© internationale pour ses ponts (pont Bir Hakeim, pont de lâAlma, pont Neuf, pont Alexandre III, pont des Arts) et pour ses passerelles (Debilly, SĂ©dar Senghor), qui enjambent la Seine (figure 1). Les passerelles du canal Saint-Martin (Riva, Arletty, CasarĂšs), rĂ©cemment renommĂ©es par de nouveaux odonymes, sont Ă©galement trĂšs visitĂ©es.

Figure 1. Carte de localisation

...Introduction à la section thématique « Cartographies critiques de jeunesses urbaines : pratiques transgressives et appropriation des espaces publics »

Cette section thĂ©matique rassemble des articles issus des travaux du rĂ©seau TRYSPACES, un partenariat de recherche formĂ© de chercheur·e·s et dâĂ©tudiant·e·s de diffĂ©rentes disciplines, dâartistes multimĂ©dias, dâintervenant·e·s jeunesse, de professionnels de la ville et de jeunes des villes de Mexico, MontrĂ©al, Paris et HanoĂŻ. TRYSPACES a dĂ©veloppĂ© des Ă©tudes de cas dans ces quatre villes pour comparer la façon dont les adolescent·e·s et les jeunes adultes utilisent et sâapproprient les espaces publics, tant physiques que virtuels, afin de comprendre comment cela contribue Ă la constitution de leurs identitĂ©s et leur permet dâexprimer leur vision du monde et de se tailler une place dans ce monde de plus en plus urbain et interconnectĂ©. Lâaccent mis par TRYSPACES sur les pratiques transgressives dâappropriation spatiale des jeunes vise Ă comprendre les consĂ©quences de ces pratiques sur la transformation et la rĂ©gulati...

« Jâte parle du Nord ! » rĂ©flexions sur un processus de contre-cartographie collaborative

Cet article revient, a posteriori, sur le processus de cartographie avec cinq jeunes nord-montrĂ©alais. Le choix de travailler ensemble autour de cartes Ă©tait tout autant animĂ© par la volontĂ© de mieux comprendre les perceptions, rĂ©cits et pratiques du quartier, que par celle dâĂ©tablir une dĂ©marche collaborative autour de la cartographie permettant aux jeunes impliquĂ©s de collecter et produire leurs propres narrations et visuels sur les espaces quâils frĂ©quentent et habitent via la collecte de clichĂ©s sur Instagram et de marche commentĂ©e. Cet article a pour ambition, dans une dĂ©marche rĂ©flexive, dâinterroger la conception et la rĂ©ception des cartes produites pour comprendre oĂč la collaboration se situe dans le processus cartographique ? Lâarticle prĂ©sente dâabord le projet de recherche et son contexte, puis revient sur la notion de cartographie collaborative et sur les Ă©tapes de la carte jusquâĂ diffusion de « Jâ...

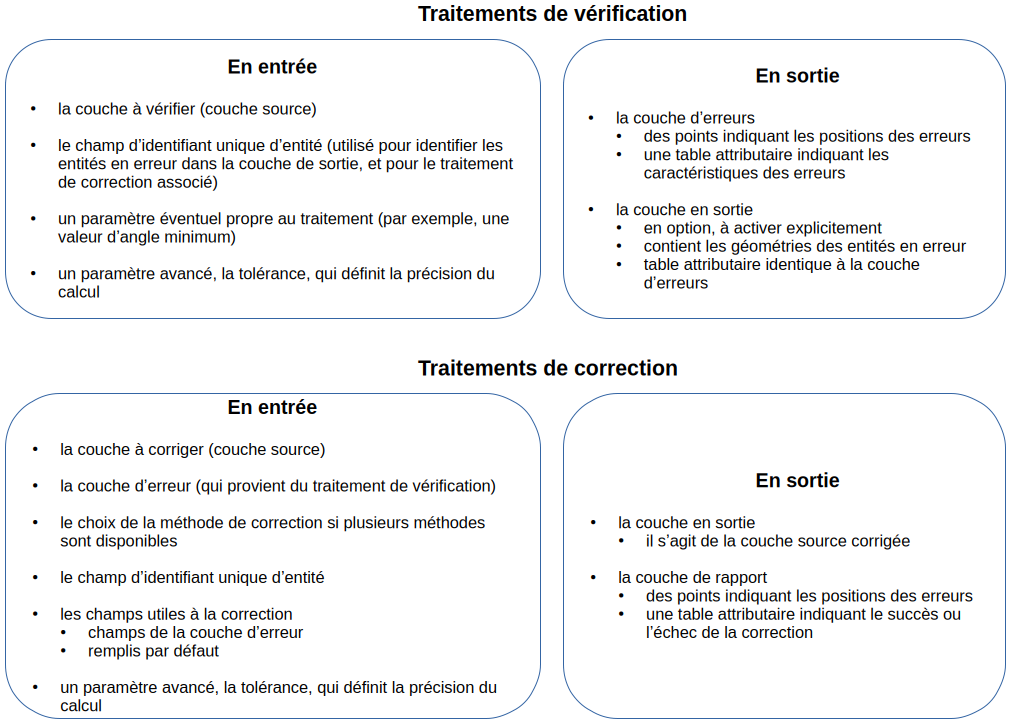

Vérifications et corrections géométriques et topologiques

Crédits : Pixabay (Pixabay Content License)

Lâimportance de la mise en conformitĂ©Une couche dâinformation gĂ©ographique doit respecter de nombreuses rĂšgles de conformitĂ©.

Par exemple :

GĂ©omĂ©triques Topologiques rĂšgles arbitraires â pas dâangle de moins de 15°â pas de polygone de moins de 0.3 mÂČ â pas de polygone Ă lâintĂ©rieur dâun autre

â pas de trou erreurs de dessin â polygone de moins de 3 points

â ligne unique dans une multi-ligne â nĆud en double

â auto-intersections

VĂ©rifier la conformitĂ© dâune couche gĂ©ographique est une Ă©tape indispensable dans la validation des donnĂ©es, pour dĂ©tecter des erreurs, ou pour sâassurer de ne pas corrompre le systĂšme dâinformation dans lequel elle sera intĂ©grĂ©e.

...Webinaire "La forĂȘt guyanaise" (17/06/2025)

Un nouveau webinaire thĂ©matique de Guyane-SIG a Ă©tĂ© organisĂ© le Mardi 17 juin 2025 sur le sujet de la forĂȘt guyanaise. PrĂšs de soixante participants de 28 organisations diffĂ©rentes ont cette fois assistĂ© Ă l'Ă©vĂšnement.

...Does ecological offsetting really allow to achieve no net loss of biodiversity?

Since 2016, the mitigation hierarchy in France, which requires projects with impacts on biodiversity to avoid, reduce and then offset these impacts, aims for no net loss of biodiversity. The offset measures taken in this framework must generate sufficient ecological gains, which implies that they are carried out on sites in bad ecological condition. In this article, we study the ecological context in which 1 153 offset measures were carried out between 2017 and 2021 in metropolitan France. To this end, using data on the "potential wilderness of metropolitan France", we compare the biophysical integrity scores of the selected sites on the one hand and the ecological quality scores, including an index of landscape connectivity around the sites, on the other hand, in relation to national scores. Our results show that 64% of the surface area of the offset sites is located in areas where the biophysical integrity score is higher than the French median, and t...

Revue de presse du 13 juin 2025

Propulsé par FreshRSS | 1309 articles au total